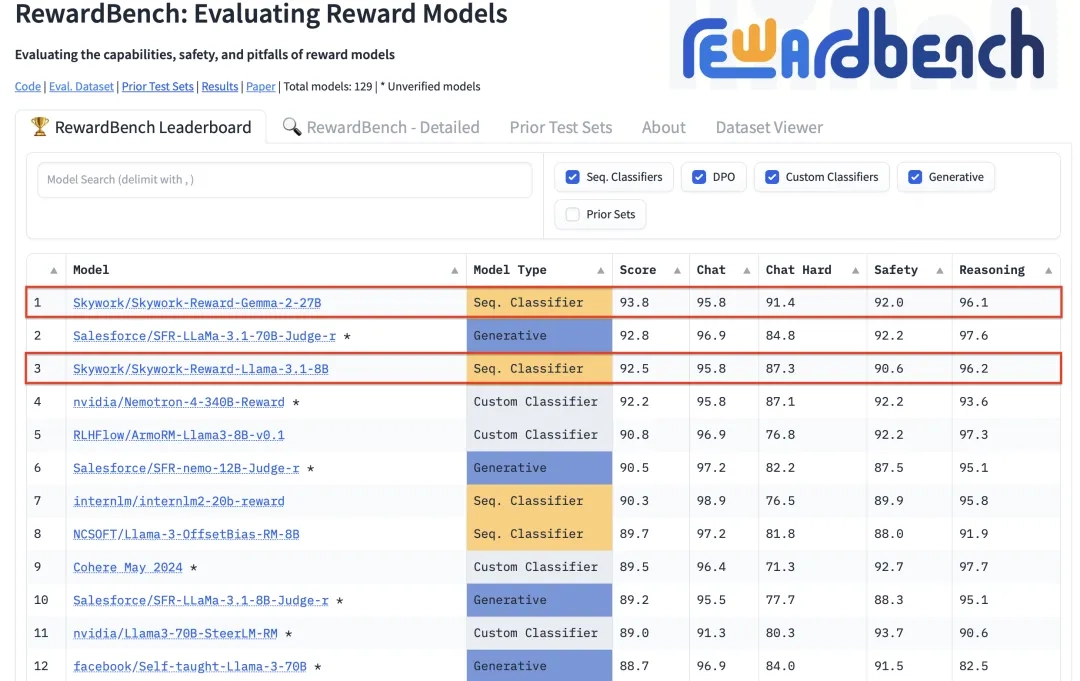

昆仑万维发布了两款全新的奖励模型 Skywork-Reward-Gemma-2-27B 和 Skywork-Reward-Llama-3.1-8B。在奖励模型评估基准 RewardBench 上,这两款模型分别位列排行榜上的第一和第三位。

奖励模型(Reward Model)是强化学习(Reinforcement Learning)中的核心概念和关键组成,它用于评估智能体在不同状态下的表现,并为智能体提供奖励信号以指导其学习过程,让智能体能够学习到在特定环境下如何做出最优选择。

奖励模型在大语言模型(Large Language Model,LLM)的训练中尤为重要,可以帮助模型更好地理解和生成符合人类偏好的内容。

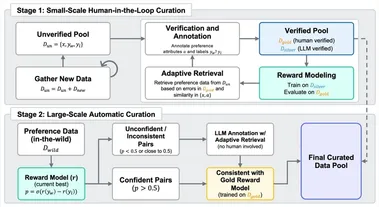

与现有奖励模型不同,Skywork-Reward 的偏序数据仅来自网络公开数据,采用特定的筛选策略,以获得针对特定能力和知识领域的高质量的偏好数据集。

Skywork-Reward 偏序训练数据集包含约 80,000 个样本,通过在这些样本上微调 Gemma-2-27B-it 和 Llama-3.1-8B-Instruct 基座模型,获得最终的 Skywork-Reward 奖励模型。

AI在线附相关链接如下:

RewardBench 排行榜:https://huggingface.co/spaces/allenai/reward-bench

27B 模型地址:https://huggingface.co/Skywork/Skywork-Reward-Gemma-2-27B

8B 模型地址:https://huggingface.co/Skywork/Skywork-Reward-Llama-3.1-8B

偏序数据地址:https://huggingface.co/collections/Skywork/skywork-reward-data-collection-66d7fda6a5098dc77035336d