H100

无需CUDA代码给H100加速33%-50%,Flash Attention作者新作火了

西风 发自 凹非寺. 量子位 | 公众号 QbitAI无需CUDA代码,给H100加速33%-50%! Flash Attention、Mamba作者之一Tri Dao的新作火了。

7/11/2025 2:59:36 PM

西风

探秘全球最大 AI 集群 xAI Colossus:122 天建成,10 万张英伟达 H100 构筑马斯克 AI 愿景

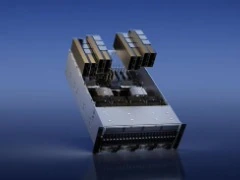

科技媒体 servethehome 昨日(10 月 28 日)发布博文,应 xAI 公司邀请,参观了 Colossus 全球最大 AI 训练集群。 AI在线曾于今年 9 月报道,xAI 在 Supermicro 的帮助下,在短短 122 天时间内搭建 10 万张英伟达 H100,而该公司计划未来将再翻倍增加 10 万张 GPU,其中 5 万张为更先进的 H200。 xAI Colossus 配备了英伟达 HGX H100 服务器,每台服务器内含 8 张 H100 GPU,所有服务器都在 Supermicro 的 4U 水冷系统中运行,确保高效散热。

10/29/2024 4:50:52 PM

故渊

Llama3.1 训练平均 3 小时故障一次,H100 万卡集群好脆弱,气温波动都会影响吞吐量

每 3 个小时 1 次、平均 1 天 8 次,Llama 3.1 405B 预训练老出故障,H100 是罪魁祸首?最近有人从 Meta 发布的 92 页超长 Llama 3.1 论文中发现了华点:Llama 3.1 在为期 54 天的预训练期间,经历了共 466 次任务中断。其中只有 47 次是计划内的,419 次纯属意外,意外中 78% 已确认或怀疑是硬件问题导致。而且 GPU 问题最严重,占了 58.7%。Llama 3.1 405 模型是在一个含 16384 块 Nvidia H100 80GB GPU 集群

7/29/2024 5:54:34 PM

清源

马斯克:xAI 训练 Grok-3 大模型用了 10 万块英伟达 H100 芯片

马斯克已经宣布其人工智能初创公司 xAI 的大语言模型 Grok-2 将于 8 月推出,将带来更先进的 AI 功能。虽然 Grok-2 还没亮相,但马斯克已经开始为其 Grok-3 进行造势。马斯克表示,训练 AI 聊天机器人需要数据集,而且从现有数据中清除大型语言模型 (LMM) 的工作量很大。他还谈到了 OpenAI 模型输出训练的几个问题。他透露 xAI 的 Grok-3 用了 10 万块英伟达 H100 芯片进行训练,预计将于年底发布,相信它会“非常特别”。H100 是英伟达开发的专门用于处理大语言模型(L

7/2/2024 2:24:31 PM

问舟

英伟达优先向 X 供应 AI 芯片,特斯拉“靠边”?马斯克称后者芯片多到“吃灰”

感谢据 CNBC 援引英伟达高级员工内部邮件消息称,马斯克向股东“夸大”了特斯拉的芯片采购情况,还将原本计划留给特斯拉的大量 AI 芯片转移给 X(推特)平台。报道称,马斯克命令英伟达允许 X 公司“插队”,使其拥有高于特斯拉的优先性,从而使特斯拉收到价值超 5 亿美元(IT之家备注:当前约 36.25 亿元人民币)处理器的时间推迟了数月,或将导致特斯拉建立超级计算机进度延误。报道还提到了一份去年 12 月的英伟达备忘录,里面写道:“相比特斯拉,埃隆优先考虑在 X 上部署 H100 GPU 集群,将原定用于特斯拉的

6/5/2024 7:48:52 AM

清源

英伟达 H100 AI GPU 短缺缓解,交货时间从 3-4 个月降至 2-3 个月

曾几何时,英伟达用于人工智能计算的 H100 GPU 供不应求。然而据 Digitimes 报道,台积电的台湾地区总经理 Terence Liao 表示,过去几个月英伟达 H100 的交货等待时间已经大幅缩短,从最初的 3-4 个月降至目前的 2-3 个月(8-12 周)。服务器代工厂商也透露,相比 2023 年几乎无法买到英伟达 H100 的情况,目前供应瓶颈正在逐步缓解。尽管交货等待时间有所缩短,Terence Liao 表示,对于人工智能硬件的需求仍然非常旺盛。即使价格昂贵,用于人工智能的服务器采购也正在取代

4/11/2024 9:32:44 AM

远洋

马斯克预测 AI 在两年内能超越最聪明的人类

感谢特斯拉 CEO 埃隆・马斯克(Elon Musk)周一预测,AI 在明年或 2026 年就能超越最聪明的人类。马斯克当地时间周一在社交媒体平台 X(以前称为推特)语音空间上接受了挪威主权财富基金首席执行官 Nicolai Tangen 的采访。当被问及 AGI(通用人工智能)的发展时间表时,马斯克表示,如果你将 AGI 定义为比最聪明的人更聪明,我想可能是明年,或者两年内。AGI 为 Artificial General Intelligence 的首字母缩写,意为人工通用智能。通用人工智能是一个人工智能理论研

4/9/2024 11:44:05 AM

沛霖(实习)

仅次于 Meta,马斯克透露特斯拉囤积的英伟达 H100 芯片数量

埃隆・马斯克麾下的特斯拉和其神秘的以人工智能为核心的公司 xAI,储备了大量的英伟达 H100 系列芯片。特斯拉意欲借此攻克自动驾驶的终极难题 ——L5 级自动驾驶,而 xAI 则肩负着实现马斯克的“终极真相人工智能”愿景。X 平台用户“The Technology Brother”最近发布消息称,Meta 公司已经囤积了全球最多的 H100 GPU,数量达到惊人的 35 万块。然而,马斯克对该排行榜将特斯拉和 xAI 的排名边缘化表示不满(1 万颗),并指出“如果计算正确,特斯拉应该是第二名,xAI 将是第三名”

4/9/2024 9:00:48 AM

远洋

英伟达 AI 芯片 H200 开始供货,性能相比 H100 提升 60%-90%

感谢据日本经济新闻今日报道,英伟达的尖端图像处理半导体(GPU)H200 现已开始供货。H200 为面向 AI 领域的半导体,性能超过当前主打的 H100。根据英伟达方面公布的性能评测结果,以 Meta 公司旗下大语言模型 Llama 2 处理速度为例,H200 相比于 H100,生成式 AI 导出答案的处理速度最高提高了 45%。市场调研机构 Omdia 曾表示,2022 年英伟达在 AI 半导体市场约占 8 成的份额,与此同时 AMD 等竞争对手也在开发对抗英伟达的产品,竞争愈演愈烈。英伟达当地时间 3 月 1

3/28/2024 6:19:52 PM

清源

机构预估 OpenAI 部署文生视频模型 Sora 需要 72 万片英伟达 H100:价值 216 亿美元

市场调查机构 Factorial Funds 近日发布报告,认为 OpenAI 部署文本转视频模型 Sora,在峰值期需要 72 万片英伟达 H100 AI 加速卡。如果按照每片英伟达 H100 AI 加速卡 3 万美元成本计算,72 万片需要 216 亿美元(IT之家备注:当前约 1561.68 亿元人民币)。而这仅仅只是 H100 加速卡的成本,想要运行必然消耗大量的电力,每片 H100 功耗为 700W,72 万片就是 504000000W。Factorial Funds 预估训练 Sora 1 个月,需要使

3/27/2024 2:13:58 PM

故渊

消息称 Meta 正积极开展 AI 人才战:候选人无需面试,小扎亲自“摇人”

据 The Information 北京时间今晚报道,为了在争夺人工智能研究人员方面取得更大优势,Meta 正在采取一系列“非常规举措”,进一步加大了这场 AI 人才战的火药味。图源 Pexels报道称,这一系列的举措包括在不面试候选人的情况下向他们提供工作机会等,更为此前威胁离职的员工增加薪资 —— 在此之前,Meta 的“长期做法”是不加薪。另据两位查看过 Meta 相关邮件的人士透露,公司首席执行官马克・扎克伯格亲自写信给谷歌 DeepMind 部门的研究人员,想要将其纳入麾下,表明这家社交媒体公司“非常重视

3/25/2024 10:27:52 PM

清源

Meta 发言人确认将率先使用英伟达旗舰 AI 芯片 B200,预估今年晚些时候收到

感谢Meta 发言人于美东时间 19 日告诉路透社,公司预计今年晚些时候收到英伟达最新旗舰 AI 芯片 ——B200,且为英伟达的首批出货。英伟达的首席财务官 Colette Kress 则告诉金融分析师,“我们认为(产品)将在今年晚些时候上市”,但他也表示,新 GPU 的出货量要到 2025 年才会增加。据悉,社媒巨头 Meta 是英伟达最大的客户之一,该公司曾购买了数十万块上一代加速卡(H100)。Meta 的 CEO 扎克伯格曾在今年 1 月宣布,公司计划在今年年底前储备大约 35 万块 H100。他补充说,

3/20/2024 8:46:29 PM

清源

调查:AMD AI 芯片 Instinct MI300X 吸引大量用户弃用英伟达

根据最近的一项调查,大量人工智能专业人士正计划从英伟达转向采用 AMD Instinct MI300X GPU。TensorWave 联合创始人 Jeff Tatarchuk 透露,他们进行了一项独立调查,涵盖 82 名工程师和人工智能专业人士。其中,约有 50% 的受访者表示他们对 AMD Instinct MI300X GPU 充满信心,因为相比于英伟达的 H100 系列产品,MI300X 不仅拥有更出色的性价比,而且供应充足,避免了遇到货源紧张的问题。Jeff 还提到,TensorWave 公司也将采用 MI

3/10/2024 5:17:03 PM

远洋

12nm战胜4nm|权威AI测试MLPerf放榜,单卡算力超H100!

2020年9月9日,全球权威AI基准评测MLPerf Inference v2.1榜单公布结果。MLPerf是业内公认的国际权威AI性能基准评测,由图灵奖得主大卫·帕特森(David Patterson)联合谷歌、英伟达 、英特尔、Facebook、浪潮等全球AI领军企业,以及来自哈佛大学、斯坦福大学等学术机构的研究人员创立。该测评以其标准严格、测评严谨而著称,英伟达、高通等国际AI芯片企业均携最强产品参加测评,竞争十分激烈,各赛道均有数百项产品提交成绩。中国AI芯片企业首次超越英伟达“史上最强GPU”、未来4nm

10/12/2022 4:13:00 PM

墨芯人工智能

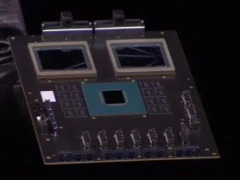

英伟达新架构发布,AI芯片上限提升了九倍,20块带宽就等于全球互联网

黄仁勋:芯片每代性能都翻倍,而且下个「TensorFlow」级 AI 工具可是我英伟达出的。

3/23/2022 7:39:00 AM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉