ACL 2025

ACL'25最佳论文独家解读:大模型有「抗改造」基因,现有后训练范式失灵预警

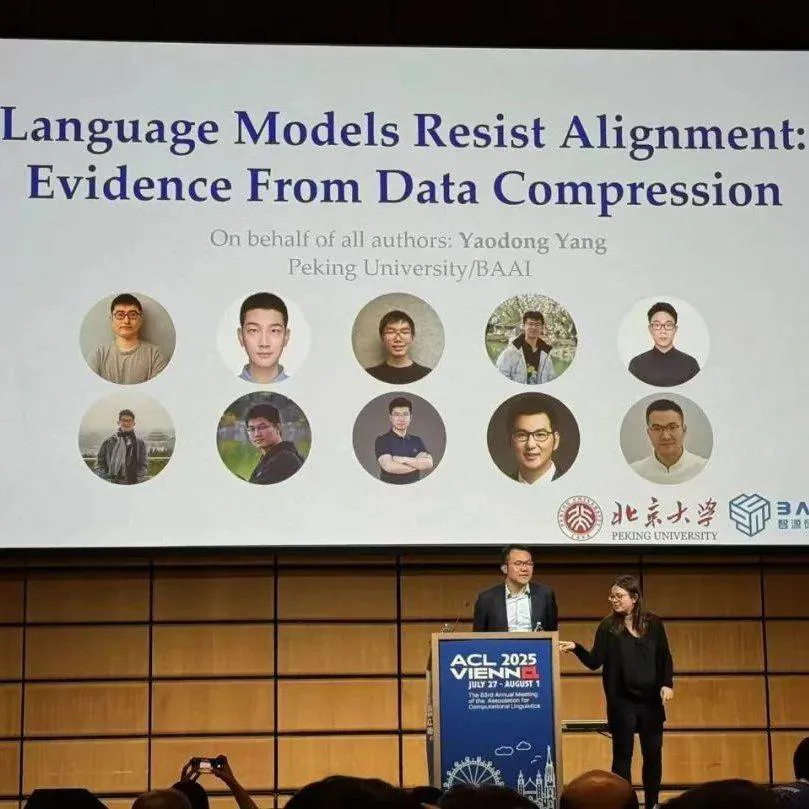

论文标题:Language Models Resist Alignment: Evidence From Data Compression论文链接:: GPT-4、DeepSeek 等大模型展现出的惊艳能力,但一个根本性问题仍未被真正解决:这些 AI 模型是否真正理解人类的指令与意图? 当前大模型研究的主流观点认为,仅通过「99% 的预训练 1% 的后训练」便可使得大模型(LLM、VLM、VLA)被对齐。 但,大模型真的能够被对齐吗?

7/31/2025 6:15:00 PM

机器之心

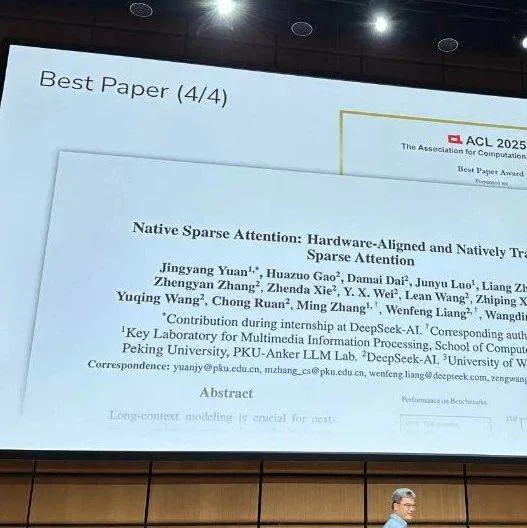

刚刚,DeepSeek梁文锋NSA论文、北大杨耀东团队摘得ACL 2025最佳论文

在这届 ACL 大会上,华人团队收获颇丰。 ACL 是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。 一直以来,ACL 在 NLP 领域的学术影响力都位列第一,它也是 CCF-A 类推荐会议。

7/31/2025 10:19:00 AM

机器之心

ACL首届博士论文奖公布,华人学者李曼玲获荣誉提名

昨晚,自然语言处理顶会 ACL 公布了今年的一个特别奖项 —— 计算语言学博士论文奖。 这个奖项是今年新增的,获奖者是来自美国华盛顿大学的 Sewon Min。 她的博士论文题为「Rethinking Data Use in Large Language Models(重新思考大型语言模型中的数据使用)」。

7/29/2025 8:50:00 PM

机器之心

ACL 2025|驱动LLM强大的过程级奖励模型(PRMs)正遭遇「信任危机」?

近年来,大型语言模型(LLMs)在复杂推理任务中展现出惊人的能力,这在很大程度上得益于过程级奖励模型(PRMs)的赋能。 PRMs 作为 LLMs 进行多步推理和决策的关键「幕后功臣」,负责评估推理过程的每一步,以引导模型的学习方向。 然而,它们真的足够可靠吗?

7/27/2025 7:45:00 PM

机器之心

维也纳免费约饭!ACL 2025期间这场晚宴不容错过!

转眼之间,时间已来到 7 月,AI 领域依旧保持着快速发展的趋势。 新的研究不断被推出,尤其是在视频生成、自主智能体等方向,多项成果相继刷新 SOTA,引发广泛关注。 在这一背景下,作为自然语言处理领域最具影响力的顶级会议之一,ACL 2025 如期而至,成为全球研究者和技术从业者分享最新成果、探讨未来趋势的重要舞台。

7/24/2025 1:09:00 PM

机器之心

明天,围观学习ACL2025论文分享会,最后报名了

2025 年,AI 领域依旧是让人兴奋的一年。 在这一年中,各大科技公司、机构发布了数不胜数的研究。 从年初的 DeepSeek,到最近的视频生成模型 Veo 3,我们见证了 AI 一轮又一轮的轰炸,AI 给我们带来了意想不到的惊喜。

7/18/2025 11:37:00 AM

机器之心

维也纳ACL 2025,相聚机器之心人才晚宴,免费约饭!

不知不觉,2025 年已经来到 7 月,AI 领域依旧保持高速发展的趋势。 从年初的 DeepSeek 横空出世,到 Gemini、 Claude 等模型的持续升级,大模型之间的「智力竞赛」仍在加速上演。 各家不仅在模型规模和能力上不断突破,更在推理深度、数据构造、多模态交互等方面展开全方位竞争。

7/16/2025 4:33:00 PM

机器之心

ACL 2025|自我怀疑还是自我纠正?清华团队揭示LLMs反思技术的暗面

本文第一作者是张清杰,清华大学博士生,研究方向是大语言模型异常行为和可解释性;本文通讯作者是清华大学邱寒副教授;其他合作者来自南洋理工大学和蚂蚁集团。 反思技术因其简单性和有效性受到了广泛的研究和应用,具体表现为在大语言模型遇到障碍或困难时,提示其“再想一下”,可以显著提升性能 [1]。 然而,2024 年谷歌 DeepMind 的研究人员在一项研究中指出,大模型其实分不清对与错,如果不是仅仅提示模型反思那些它回答错误的问题,这样的提示策略反而可能让模型更倾向于把回答正确的答案改错 [2]。

7/14/2025 1:19:00 PM

机器之心

7月19日,相聚北京!一起聊聊ACL 2025爆点研究

2025 年,AI 领域依旧是让人兴奋的一年。 在这一年中,各大科技公司、机构发布了数不胜数的研究。 从年初的 DeepSeek,到最近的视频生成模型 Veo 3,我们见证了 AI 一轮又一轮的轰炸,AI 给我们带来了意想不到的惊喜。

7/10/2025 5:11:00 PM

机器之心

给你一群顶尖AI,如何组队才能发挥最大战力?UIUC用一个新的多智能体协作基准寻找答案

朱昆仑是伊利诺伊大学香槟分校(UIUC)计算机科学系的研究生,现隶属于Ulab与Blender Lab,曾在斯坦福大学、卡内基梅隆大学(CMU)与蒙特利尔学习算法研究所(Mila)进行学术访问。 他的研究方向包括大语言模型(LLM)智能体、多智能体系统、AI科学家与工具学习等,在ICML、ICLR、ACL、TMLR等顶级会议与期刊发表论文10余篇,总引用超过1500次。 他积极参与多个广泛影响的开源项目,包括 OpenManus(RL)、ChatDev(MACNET)、ToolBench 等,累计在 GitHub 上获得超过 5万 stars。

7/9/2025 12:46:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

蛋白质

xAI

开发者

人形机器人

生成式

神经网络

机器学习

3D

AI视频

RAG

大语言模型

Sora

研究

百度

GPU

生成

字节跳动

工具

华为

AGI

计算

大型语言模型

AI设计

搜索

生成式AI

视频生成

亚马逊

DeepMind

AI模型

特斯拉

场景

深度学习

Transformer

架构

MCP

Copilot

编程

视觉