——如何让多模态智能体真正“看懂”世界并做出复杂决策

“把切好的苹果片冰一下再丢进垃圾桶”——这样一条看似普通的自然语言指令,若让一台具身智能体(Embodied Agent)执行,其背后实则隐藏了多步规划、常识应用、环境理解、工具使用等一系列交互复杂度极高的子任务。如何让 AI 理解任务的潜台词、合理分解步骤,并在真实视觉输入中找准对象并正确执行,正是当前具身智能与多模态学习面临的最大挑战之一。

具身智能与多模态规划的研究背景

具身智能(Embodied Intelligence)可以被视为 AI 研究“从认知走向行为”的转折点。相比传统语言模型只需生成文本答案,具身智能体需要真正“扎根”在感知世界中,将自然语言指令转化为一连串具体、可执行的动作,并根据不断变化的视觉环境调整策略。

与此同时,大规模预训练模型不断推进了多模态理解的边界——视觉语言模型(LVLMs)成为桥接人类意图与感知世界的关键通道。它们接受图像与语言作为输入,生成合理的响应或推理路径,被广泛应用于问答、描述生成、交互导航等任务。然而,当这些 LVLM 被迁移到具身场景时,问题开始暴露:它们在真实复杂环境中的推理往往流于表面,尤其是缺乏对环境中语义结构和任务逻辑的深度建模。

LVLM 的机遇与挑战,在具身任务中“落地生根”

当前 LVLM 主要依赖大规模图文对进行训练,其强项在于处理“静态感知”任务,而非“动态交互”决策。它们在图像描述、多轮对话甚至考试问答中展现出惊人的语义掌控力,但在具身任务中却普遍表现出三大软肋。

第一,它们脱离环境上下文进行模仿学习,无法在执行过程中动态感知与反应;

第二,它们通常在“开放循环”(open-loop)设定中训练,未习得因果与时间依赖关系;

第三,在面对多步复杂任务、歧义语言指令、隐含语义要求时往往失误频频。

这引发了一个更深层的问题:如何让 LVLM 真正具备世界建模能力,从而在环境复杂多变、反馈有限的设定下进行稳健规划?而这,正是本文提出的“世界意识规划叙事增强”方法想要解决的核心挑战。

今天我们解读由复旦大学与上海人工智能创新研究院联合团队提出的这一创新框架。该方法不仅在技术路径上融合了叙事增强与认知分层,还在实验设计上实现了对闭环具身任务的性能飞跃,代表了多模态具身智能从“模仿”走向“理解”的一次突破。

这项研究由复旦大学自然语言处理实验室牵头,联合上海人工智能创新研究院与上海人工智能实验室共同完成。团队成员包括Junhao Shi, Zhaoye Fei, Siyin Wang, Qipeng Guo, Jingjing Gong, Xipeng QIu,该团队所代表的,不仅是中国 NLP 与 AI 研究界的一股骨干力量,也体现了产学研融合背景下,对“通用人工智能走向认知闭环”的前瞻性探索。

1.方法综述:WAP 世界意识叙事增强框架

——给智能体一个“世界观”,让它学会像人一样看、想、做

在这项研究中,研究团队并没有简单地对模型堆叠参数或扩大训练数据,而是借助一种更接近人类认知机制的做法:用结构化的“世界叙事”来培养智能体的感知–理解–行动闭环能力。这套方法被称为 WAP(World-aware Planning Narrative Enhancement),既是数据增强策略,也是一种认知重构框架,核心理念是:让语言不只是指令,而是携带环境语义的推理触发器。

图片

图片

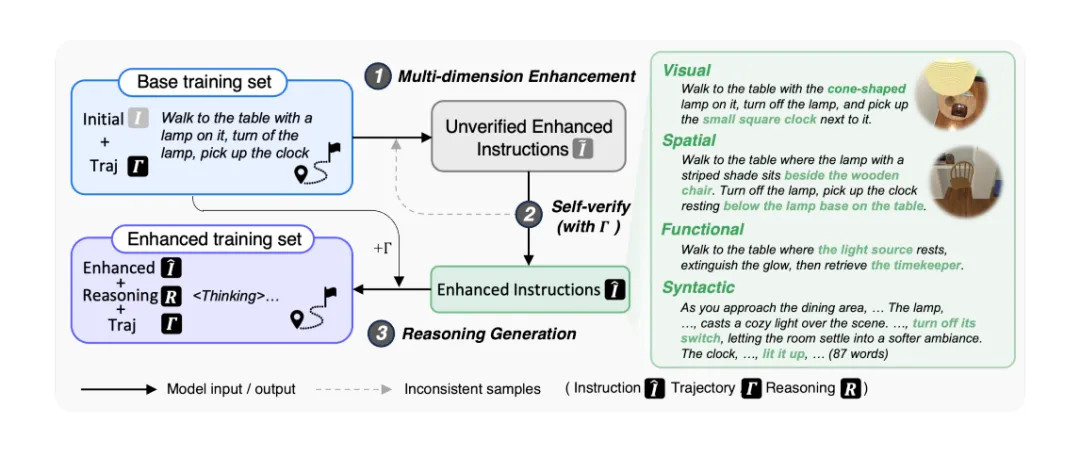

图1:叙事增强了管道。研究团队的框架通过四个主要阶段转换基础教学轨迹对:(1)多维教学增强,生成认知丰富的变体;(2)自我验证,确保与原始任务语义一致;(3)推理生成,为每个动作提供明确的认知痕迹;以及(4)构建增强训练集,在添加认知注释的同时保持轨迹信息。

框架的整体设计理念

与其说 WAP 是一种技术堆叠,不如说它像在模型内部构建了一个“认知成长路径”。

在传统做法中,模型对任务的理解基本停留在语言输入与静态观测之间的浅层映射。而 WAP 主张以观察历史与动态场景为基础,激发模型建立完整的感知—语义—动作桥接链。这条链路中的每一环都对应人类在执行任务时的心智加工流程。

- 我看到了什么?

- 我知道它在哪儿、有什么功能?

- 这和我的目标有什么关系?

- 我接下来该做什么?

换句话说,WAP 就是在教模型如何“思考”。

多维认知能力构建

WAP 的关键在于为模型输入的信息加上认知标签。通过将每条任务指令映射为四个认知维度下的“理解任务方式”,模型被迫练习从多个角度“看懂世界”。

视觉外观建模(Visual Appearance Modeling)

模型不再只是通过物体名称识别目标,而是通过增强指令中加入颜色、形状、材质 等视觉描述(如“小型圆形挂钟”、“锥形灯罩”),强化其对象判别能力。这不仅提升鲁棒性,也让模型在复杂场景中具备更精细的感知分辨率。

空间-关系推理(Spatial-Relational Reasoning)

为任务指令增添基于空间参照物与结构布局 的信息(如“在木制椅子旁”、“位于灯座下方”),使模型能够建立起类似于人类“空间地图”的理解机制。这一维度至关重要,因为具身任务往往涉及移动与定向操作,空间错误即是任务失败。

功能抽象学习(Functional Abstraction Learning)

此维度超越了物体外观,强调其操作性与因果作用,如“冰箱是制冷设备”、“刀是切割工具”、“钟是时间指示器”。这些抽象描述帮助模型在缺乏明确说明时依然能作出合理推断——比如理解“冷藏”这一隐性要求的含义。

句法语义联结(Syntactic Grounding)

这里的重点是提高模型处理复杂语言结构、歧义、指代 等高阶语言理解能力。例如,对“放入刚刚使用的容器”这样的间接表达进行消歧和上下文对齐。通过重构任务指令语言风格,引导模型在理解指令本身时进行更深层次的结构分析。

指令与轨迹的多维增强流程

研究团队构建了一套流程式的叙事增强系统,将每条原始轨迹转化为一组具备认知挑战性的“变体指令”。

- 以原始任务为核心,针对四大认知维度分别生成增强版本;

- 使用大型教师模型(如 Qwen2.5-VL)进行“多维视角重述”;

- 保留轨迹信息并附加语义标注,构建强化数据集。

最终,模型在训练中会面对形式多样、视角丰富的指令表达,这促使其在泛化到新场景时更具适应力。

语义一致性自检机制

但“创造力”不能以牺牲“准确性”为代价。为避免增强指令跑题或引入语义偏移,WAP 设计了一套语义一致性验证机制。

系统使用多个判别器从五个角度检查增强指令是否与原始指令意图保持一致,只有通过至少四项验证的才会被保留。否则,该增强版本将被舍弃或重写,确保整个训练集的认知目标不被“篡改”。

步进式认知推理生成

另一项令人印象深刻的机制是所谓的“行动-认知配对”:每一个动作都配有一条明确的“认知说明”。

这类似于在人类心理学中提到的“显式元认知路径”,模型不仅要执行动作,还要给出它为什么这么做的解释。这些推理语句成为模型学习时的重要监督信号,引导其逐步学会因果关系追踪、状态转移感知与目标保持机制。

这不仅提升了执行表现,更让模型具有可解释性。

课程式训练策略,从感知到推理的三阶段训练

好比一个孩子从学会识字、认识世界,再到能独立思考,WAP 的训练流程也遵循一种“认知阶梯式”路径。

第一阶段:基础模仿 模型学习语言与动作的基本映射,对接轨迹语料;

第二阶段:感知理解 引入视觉与空间增强,建立起环境建模与对象对齐能力;

第三阶段:高阶推理 接入功能与句法增强,攻克语言歧义与隐含任务结构问题。

这种循序渐进的训练方式,让模型不会在一开始就面对“全难度”挑战,而是按“认知发展曲线”逐步升级认知系统。最终,模型在面对现实具身场景时拥有了如人类般的多角度理解能力与推理韧性。

2.实验设计与主要结果

用数据说话,世界意识究竟改变了什么?

自建80K大规模叙事增强语料,构建认知爬坡赛道

与传统从小数据“抠细节”不同,作者在训练数据上开足马力。他们基于原始 ALFRED 数据集的 16,145 条人类演示轨迹,通过四维认知增强策略,一举扩展为多达80,875 条 instruction–trajectory 对。这些新样本不仅数量大,更在认知复杂性上形成有梯度的结构化挑战,例如:

- 描述物体材质与形状(视觉维度)

- 加入相对空间位置(空间维度)

- 强化功能与工具意图表达(功能维度)

- 引入歧义结构与间接指令(句法维度)

作为“教师模型”,研究者选择了能力强悍的Qwen2.5-VL-72B-Instruct,用以指导增强指令生成、认知推理生成等过程。换句话说,这不仅是训练数据的扩充,更是认知能力成长路径的人工编排。

EB-ALFRED基准:从任务成功率到认知均衡性的双重考验

为了全面评估模型在具身环境中的真实水平,作者使用了 EB-ALFRED 这一升级版基准。该平台相较原始 ALFRED 更具代表性:精简冗余动作空间;优化语言指令质量;明确任务场景类型划分(如视觉、空间、复杂、常识、长程等)

图片

图片

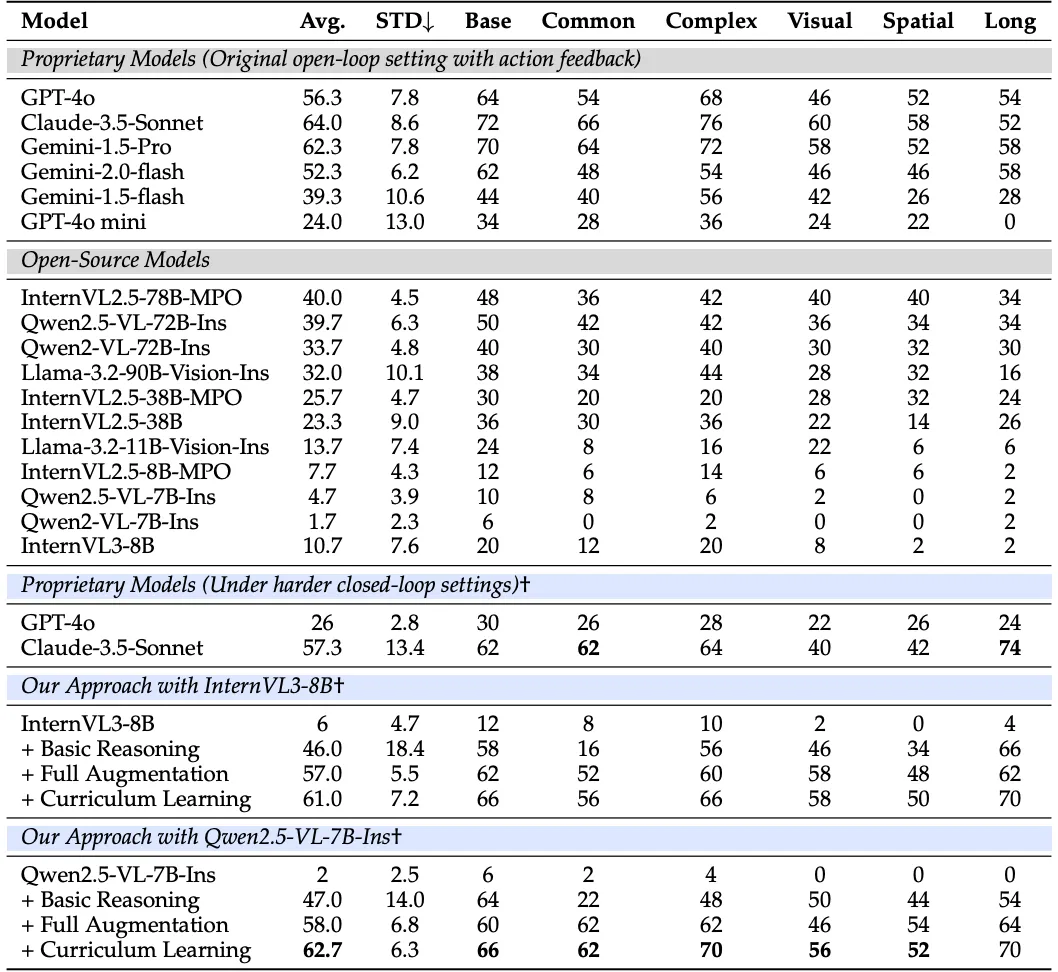

表1:EmbodiedBench(EB-ALFRED)的性能比较。结果显示了不同任务类别的成功率(SR)。

主要评估指标有两个。

任务成功率(Success Rate, SR):看任务是否达成目标

标准差(STD):衡量模型在不同任务类型之间的能力平衡性。STD 越小,表明模型越能适应多样任务而不偏科

这个指标组合其实很“人性化”:不仅看你做得好不好,还看你“偏科”没。

“吊打”闭源大模型:开源也能站上高地

成果如何?一句话总结:开源也能扳倒 GPT-4o。

以 Qwen2.5-VL-7B 为例,研究者从基础版本(SR 仅为 4.7)出发,通过叠加认知增强与课程训练,最终实现了 62.7 的平均成功率。这个成绩不仅远高于其自身的原始能力,还超过了 GPT-4o(56.3)和接近Gemini-1.5-Pro(62.3),而后者们可都是大模型家族中的“天花板”选手。

此外,WAP 训练出的模型在能力均衡性上也表现出色——STD 降至 6.3,显著优于如 Claude 3.5 Sonnet(8.6)等闭源大模型,说明它不会“视觉强但空间拉胯”或“常识懂但长程发懵”。

认知维度剖面图:模型真的“理解”环境了吗?

为了验证四大认知增强是否真正内化为智能体能力,研究团队在多个维度上做了定向评估。

视觉识别:InternVL3 的成功率从 46 提升到 58,表现出更细粒度的物体识别能力。

空间理解:在要求物体相对定位任务中,InternVL3 从 34 提升至 50,显示出空间语义获得。

常识推理:Qwen2.5-VL 的表现从 22 飙升到 62,表明模型能联想物体用途与语义逻辑。

指代歧义消解:在处理“那个容器”等模糊指令时,模型识别准确率从 48 提升到 70,展现出上下文语义追踪能力。

这不再是“技巧”,而是认知能力的显性成长痕迹。

长程任务的胜利,它终于不再“忘记过去”

长程规划任务是具身智能的真正试金石,它考验的不只是单步决策,而是整套认知链的连贯执行。

令人惊喜的是,WAP 训练出的模型在 15+ 步动作序列任务中取得了高达 70 的成功率,相较基础模型提升了 35 倍。而 GPT-4o 在闭环场景中则滑落至 24,可见其对“环境反馈”的依赖严重阻碍了泛化。

而 WAP 则通过两项创新克服了这一困境:

完整观察历史接入:模型不再只看当下图像,而是维护因果记忆

多维知识一体化建模:以视觉、空间、功能、语义为柱,支撑复杂决策链

这也间接证明了一点:真正的世界建模能力,是突破长程弱点的关键。

3.深度分析与洞见

当AI学会自我规划,它会走多远?

WAP 框架的一大亮点,是研究者不仅设计了精密的课程式认知增强流程,还进一步尝试了“放手一搏”的方法——让模型自己决定该怎么学。这就是所谓的自主增强(Self-Directed Enhancement):不再用人类预设规则,而是依赖模型自身理解任务,再选择要增强哪个维度的信息(视觉、空间、功能、句法等)。

结果如何?事实说明,自学虽好,但还不够精细。虽然自主增强在平均成功率上达到 56.7,已超过许多传统方法,表现可圈可点,但依然显著落后于显式课程增强(62.7)。尤其在需要高阶推理的任务中(如常识任务:48 vs. 62、长程任务:60 vs. 70),差距一目了然。

这似乎也呼应了现实教育场景:有天赋的学生固然能自学成才,但在面对复杂知识体系时,结构化引导仍是不可或缺的认知放大器。

哪些模块真正“值回票价”?一场精细的能力拆解

每一个系统性能的跃升背后,都隐藏着关键模块的协同增效。为了厘清“谁是功臣,谁是锦上添花”,研究者进行了一系列精巧的消融实验。

首先,仅使用“基础推理”模块,模型成功率为 47.0,且在不同任务类型上的波动极大(STD 高达 14.0)。这说明:没有认知增强,模型只是“懂一点皮毛”。

再试试只用“视觉+空间增强”?成功率竟然不升反降,维持在 46.7,但各任务类型之间差距极大(STD 达 17.1),也就是说——模型虽学会“看清”,却没学会“怎么做”,认知“偏科”严重。

而当作者逐步引入完整推理构造与课程学习后,模型能力整体拉升、各任务类型表现也趋于均衡(最终 STD 降至 6.3)。这意味着:WAP 的关键在于把每一项认知能力“串联成链”,只有通过阶段式建模才能让智能体拥有稳定、全局的推理模式,而不是“临场发挥式”行动者。

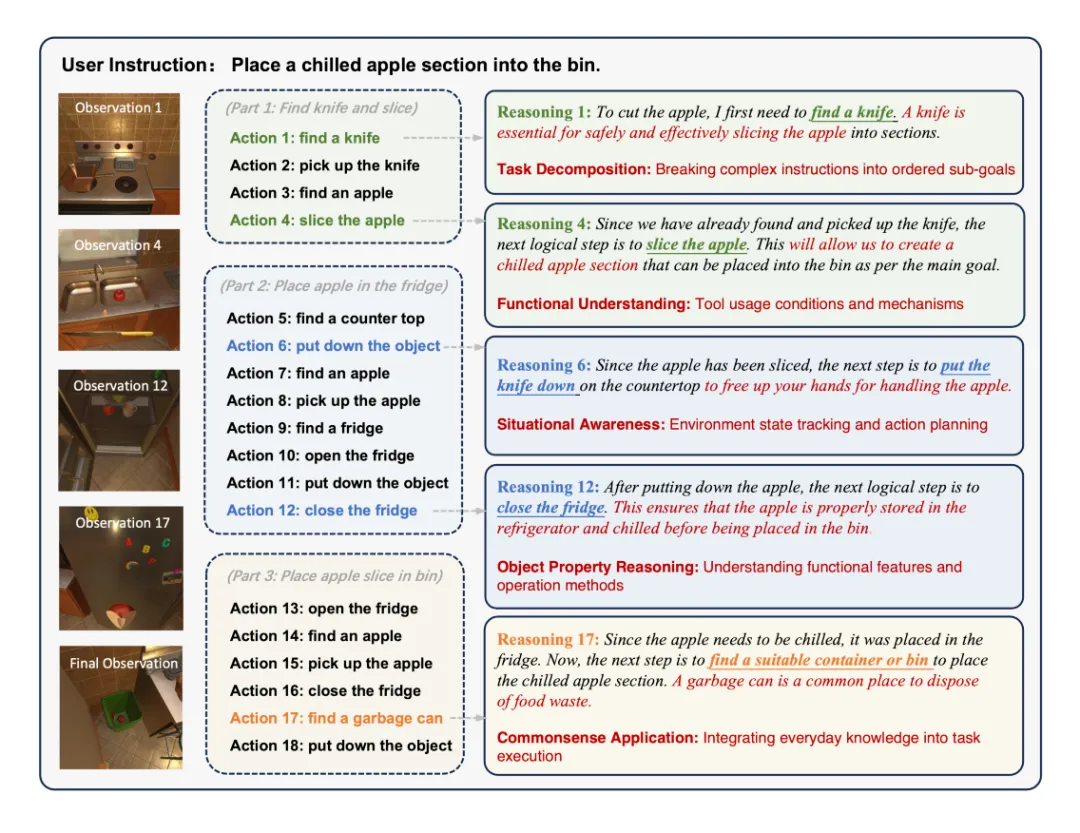

一个任务十八步:一颗冰镇苹果背后的认知华章

案例最能说明问题。论文中展示的任务是:“把一块冰镇的苹果片放进垃圾桶”。看起来非常简单?模型真正做到这件事,花了整整 18 个动作。

为什么这么多?原来,这条指令中潜藏着多个隐性要求——“苹果要先切片”,“切好后要放入冰箱冷藏”,“冰镇后才能丢弃”等。这些步骤都没有在语言中直接表达,但模型必须洞察其背后的因果链条。

更精彩的是,在第六步里,模型特地先把刀放回桌子再去拿苹果——表现出了工具使用中的安全意识。最终,它不仅完成了任务,还展示了清晰的推理链:

工具识别 → 状态推断(是否冰镇)→ 动作顺序计划 → 任务达成 → 清理现场

这不是单一模型输出的“伪规划”,而是具有显式认知链的结构性执行路径。从“看懂”到“做对”,模型正在向“思考为何如此做”靠近。

优势之外,也别忽视潜在盲点

正如每项工程的光辉背后都有待打磨的棱角,WAP 虽表现惊艳,但仍有可改进空间。

自监督尚未完全释放潜力:当前的自主增强能力较弱,表明模型尚未学会精准调度多维知识,还需更细粒度的激活机制;

大模型依赖偏重:目前的大规模预训练模型(如 Qwen2.5-VL)作为教师模型,对资源要求极高,限制了方法的普适可用性;

语境转移能力待验证:虽然在 EB-ALFRED 上表现优异,但是否能泛化到更异构的真实环境(如室外、杂乱办公区)仍需进一步实验;

模块组合的泛化策略:在不同任务条件下,是否能动态裁剪或组合认知模块以降低成本,也是未来需要解决的问题。

但瑕不掩瑜。整体来看,WAP 所代表的,是从数据效率、推理路径、决策可解释性三个维度上,对具身智能的一次系统性重构。

4.结语与展望

——当视觉语言模型具备“世界意识”,它会走向怎样的未来?

方法总结与核心贡献

这项研究的最核心贡献在于,为当前尚显“机械”的视觉语言模型打开了一扇通向“认知世界建模”的大门。

研究团队以一种结构化叙事增强框架为引擎,赋予了 LVLM 四项关键认知能力。

- 能看清(视觉外观)

- 能看懂(空间布局)

- 能想通(功能抽象)

- 能听明白(句法语义)

更关键的是,他们没有依赖特权反馈、辅助通道或任务提示,而是依靠纯粹的视觉输入与语言指令,训练出了在多步骤任务中展现连贯决策逻辑的模型。这使得 LVLM 首次在闭环环境中实现了“理解式行动规划”,而非模板匹配式反应。

实验数据佐证一切:在 EB-ALFRED 的所有任务子集上,WAP 都大幅提升了成功率与任务泛化稳定性,尤其在长程、多步骤、模糊语言与复杂因果任务中,表现出逼近甚至超越闭源模型的统合能力。可以说,这是一场模型范式与训练理念的“双重胜利”。

图片

图片

图2:复杂指令执行的推理过程可视化。该图显示了我们的模型执行“将冷藏苹果放入垃圾桶”的指令。该模型成功地将这个看似简单的指令分解为三个阶段的18个不同动作,展示了强大的规划能力。推理注释强调了五种关键的认知能力:任务分解、功能理解、情境意识、对象属性推理和常识知识应用。

这个例子说明了我们的模型如何在处理指令中未明确规定的隐含要求(例如,苹果在处置前必须冷藏)的同时,在很长一段时间内(18个步骤)保持连贯的规划。

对具身智能与多模态规划研究的启示

这一研究无疑为具身智能研究注入了三剂“强心针”。

它重新强调了“世界模型”的必要性,在纯视觉—语言对话系统中或许可以靠对齐数据完成任务,但在需要真实互动、状态追踪与目标保持的具身环境中,没有环境表征等于“盲人摸象”。

它印证了“认知结构化数据增强”的有效性。过去大家普遍认为大模型的泛化依赖大数据,但本研究展示了:有结构、有维度、有课程的认知引导式样本,更能塑造出有规划能力的智能体。这给了教育式 AI 训练范式更多信心。

它为“闭环智能”提供了现实突破路径。当前很多系统仍严重依赖任务成功信号、指令分段提示等“外挂”,WAP 的闭环机制,证明了单靠图像与语言,也能构建稳定的执行策略。这对机器人导航、家庭助理等不具备辅助感知通道的真实部署系统尤为关键。

走向更强、更稳、更可信赖的智能体

当然,研究本身仍留下了令人期待的余地。

首先是自我监督能力的增强。当前的自主增强机制虽然已初具成效,但相比显式课程机制仍有明显差距。未来可探索让模型主动识别自身知识盲区,并针对性生成认知维度挑战,以实现真正的“学习型体感智能”。

其次是跨环境与跨任务的鲁棒迁移。EB-ALFRED 是优秀的起点,但其结构相对规整。能否将 WAP 应用于更嘈杂、真实、多领域的环境中(如工厂、医院、交通空间等)是下阶段要迈出的关键一步。

最后不能忽视的,是伦理与安全议题。当模型具备了越来越强的“世界建模”能力,其误解、误判或偏见也可能带来“认知层面”的风险。例如,在判断任务目标时是否尊重隐私?在推理“常识”时是否体现文化中立?这些问题都值得伴随技术前进同步思考。

参考资料:https://arxiv.org/pdf/2506.21230