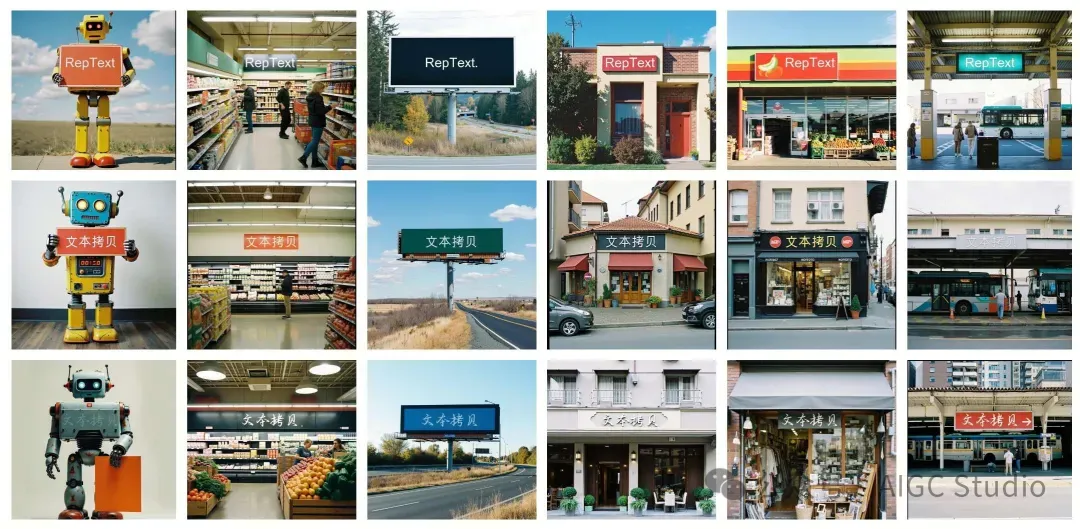

Liblib AI提出了 RepText,可以使预训练的单语文本转图像生成模型能够以用户指定的字体准确渲染,或者更准确地说,复制多语种视觉文本,而无需真正理解这些字体。这样不管是中文、日文、韩文还是其他语言都可以精准的生成!从某种意义上说也算是打破了AI图文生成语言的壁垒!

相关链接

- 文章:https://arxiv.org/abs/2504.19724

- 主页:https://reptext.github.io/

- 代码:https://github.com/Shakker-Labs/RepText

- 试用:https://huggingface.co/spaces/Shakker-Labs/RepText

论文介绍

尽管当代的文本到图像生成模型在生成视觉吸引力方面取得了显著突破,但它们生成精确灵活的排版元素(尤其是非拉丁字母)的能力仍然受到限制。这种固有限制主要源于文本编码器无法有效处理多语言输入或训练集中多语言数据分布的偏差。为了满足特定语言需求的文本渲染,一些研究采用专用文本编码器或多语言大型语言模型来替换现有的单语言编码器,并从头开始重新训练模型,以增强基础模型的原生渲染能力,但这不可避免地会造成高资源消耗。其他研究通常利用辅助模块对文本和字形进行编码,同时保持基础模型的完整性以实现可控的渲染。然而,现有研究大多基于 UNet 模型构建,而非近期基于 DiT 模型(SD3.5、FLUX),这限制了它们的整体生成质量。

尽管当代的文本到图像生成模型在生成视觉吸引力方面取得了显著突破,但它们生成精确灵活的排版元素(尤其是非拉丁字母)的能力仍然受到限制。这种固有限制主要源于文本编码器无法有效处理多语言输入或训练集中多语言数据分布的偏差。为了满足特定语言需求的文本渲染,一些研究采用专用文本编码器或多语言大型语言模型来替换现有的单语言编码器,并从头开始重新训练模型,以增强基础模型的原生渲染能力,但这不可避免地会造成高资源消耗。其他研究通常利用辅助模块对文本和字形进行编码,同时保持基础模型的完整性以实现可控的渲染。然而,现有研究大多基于 UNet 模型构建,而非近期基于 DiT 模型(SD3.5、FLUX),这限制了它们的整体生成质量。

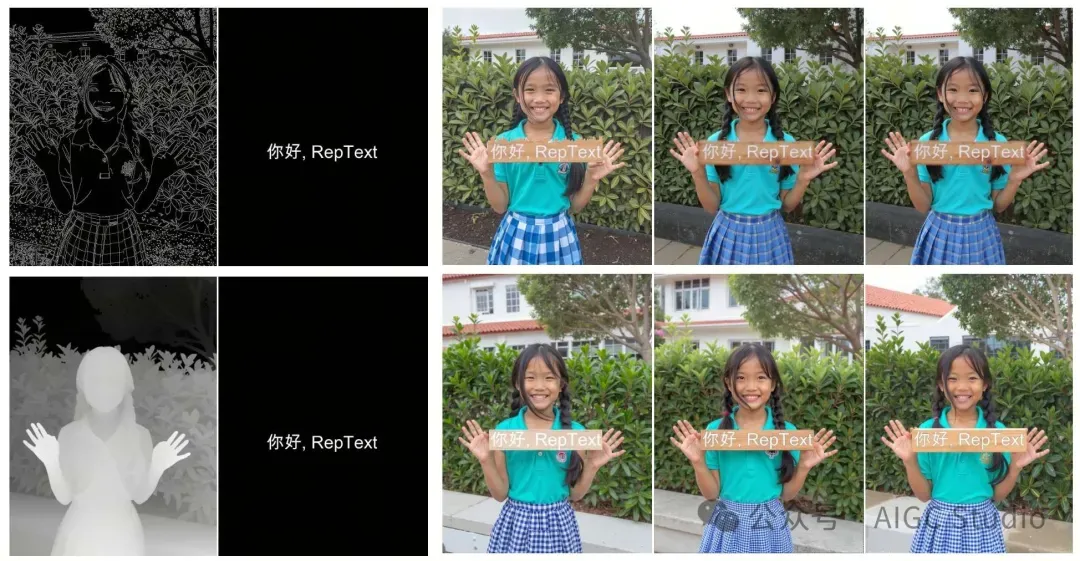

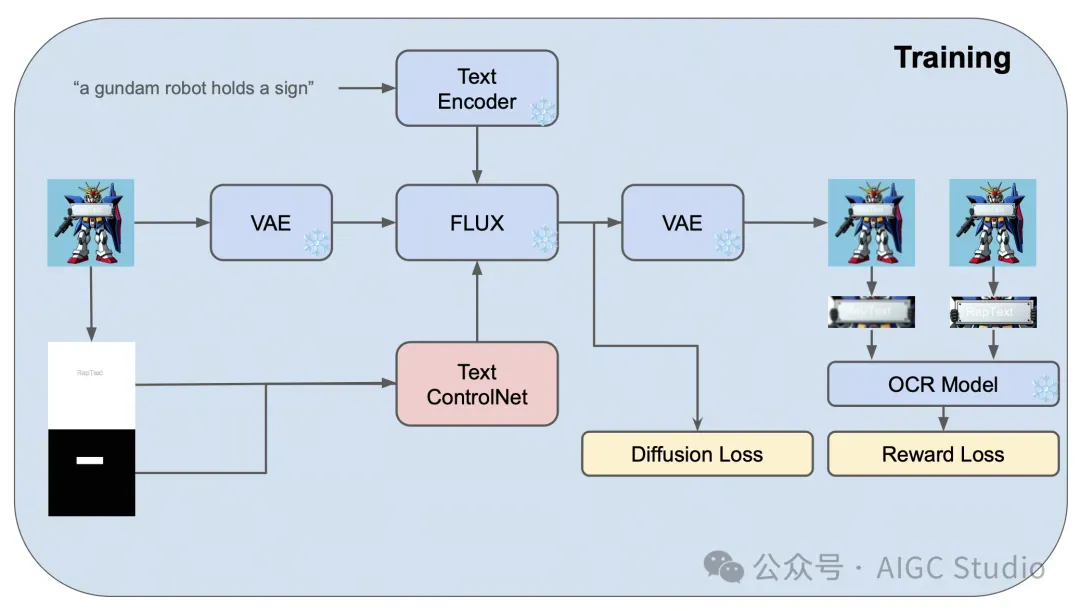

为了解决这些限制,论文从一个朴素的假设出发,即文本理解只是文本渲染的充分条件,而非必要条件。基于此提出了 RepText,旨在赋能预训练的单语文本转图像生成模型,使其能够以用户指定的字体精准渲染(更准确地说,是复制)多语种视觉文本,而无需真正理解这些字体。具体而言,作者借鉴了 ControlNet 的设置,并额外集成了语言无关的字形和渲染文本位置,从而能够生成协调一致的视觉文本,允许用户根据自身需求自定义文本内容、字体和位置。

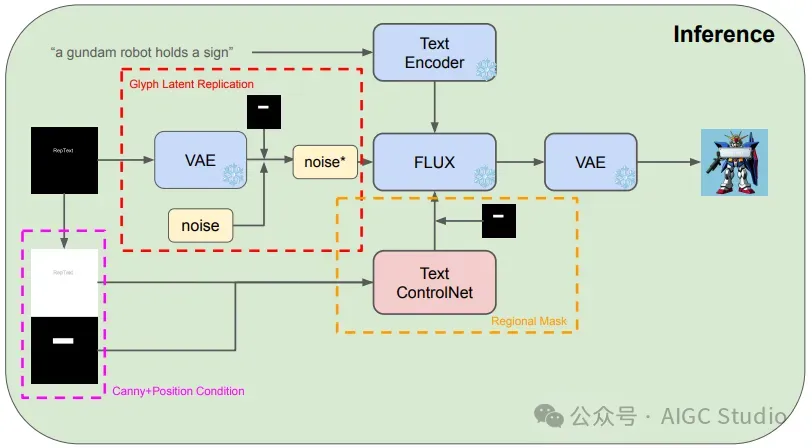

为了提高准确率,RepText结合了文本感知损失和扩散损失。此外,为了稳定渲染过程,在推理阶段直接使用带噪声的字形潜在向量进行初始化,而非随机初始化,并采用区域掩码将特征注入限制在文本区域,以避免其他区域的失真。大量的实验验证 RepText 相对于现有方法的有效性。

方法

RepText 旨在通过复制字形来实现基于最新单语基础模型的文本渲染。并未使用额外的图像或文本编码器来理解单词,而是通过使用以 Canny 和位置图像为条件的文本控制网络 (ControlNet) 来训练模型复制字形。此外,作者创新性地在初始化过程中引入了字形潜在复制,以提高文本准确性并支持色彩控制。最后采用区域遮罩方案来确保良好的生成质量并防止背景区域受到干扰。论文的贡献主要有三方面:

- 提出了 RepText,一个用于可控多语言可视化文本渲染的有效框架。

- 创新性地引入了字形潜在复制,以提高排版准确性并实现色彩控制。此外还采用了区域遮罩,以获得良好的视觉保真度且不受背景干扰。

- 定性实验表明,提出的方法优于现有的开源方法,并取得了与原生多语言闭源模型相当的结果。

RepText 的推理框架及其突出策略:(1)从无噪声字形潜在特征进行复制,提高文本准确率并实现色彩控制。(2)对文本区域采用区域遮罩,避免非文本区域的干扰,确保整体质量。

与之前方法比较

与其他作品的兼容性