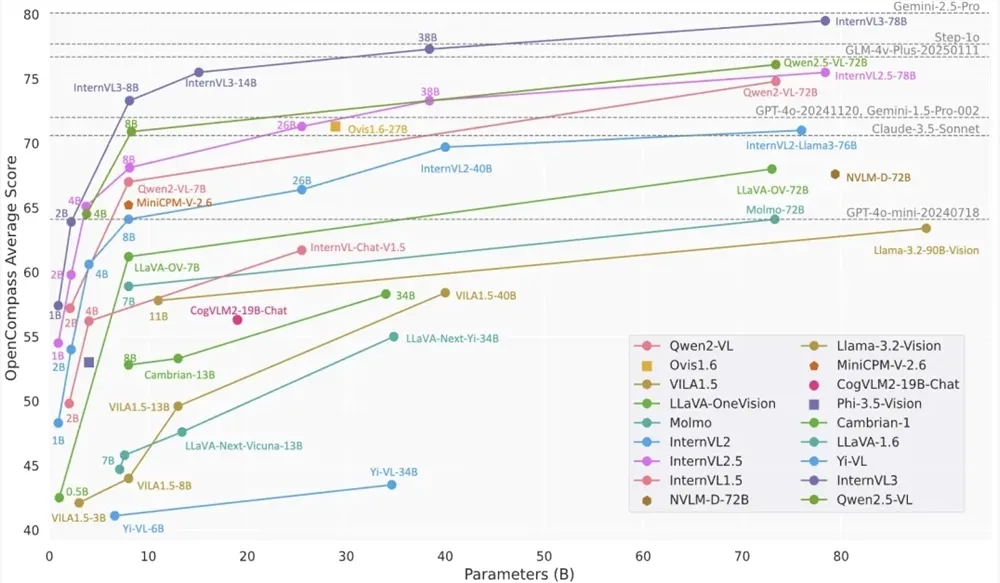

4月11日,OpenGVLab开源发布了InternVL3系列模型,这标志着多模态大型语言模型(MLLM)领域迎来了新的里程碑。InternVL3系列包含从1B到78B共7个尺寸的模型,能够同时处理文字、图片、视频等多种信息,展现出卓越的整体性能。

与前代产品InternVL2.5相比,InternVL3在多模态感知和推理能力上有了显著提升,其多模态能力进一步扩展至工具使用、GUI代理、工业图像分析、3D视觉感知等多个领域。此外,得益于原生多模态预训练,InternVL3系列的整体文本性能甚至优于Qwen2.5系列,后者是InternVL3中语言组件的初始化部分。

InternVL3系列模型的架构延续了“ViT-MLP-LLM”范式,用随机初始化的MLP projector将全新增量预训练的InternViT与各种预训练的LLM(包括InternLM3和Qwen2.5)集成。

在模型推理方面,InternVL3应用了像素反混洗操作,将视觉标记数量减少到原来的四分之一,并采用动态分辨率策略,将图像划分为448×448像素的图块。从InternVL2.0开始,关键区别在于额外引入了对多图像和视频数据的支持。InternVL3还集成了可变视觉位置编码(V2PE),为视觉标记提供了更小、更灵活的位置增量,从而展现出更出色的长上下文理解能力。

在模型部署方面,InternVL3可以通过LMDeploy的api_server部署成OpenAI兼容API,用户只需安装lmdeploy>=0.7.3,然后使用相关命令即可完成部署。模型调用时,用户可以通过OpenAI的API接口,指定模型名称、消息内容等参数,获取模型的响应。

体验地址:https://modelscope.cn/collections/InternVL3-5d0bdc54b7d84e