相信不少设计师朋友在学习AI做图和设计工作中都和我一样遇到过以下这些问题:

- 本地设备配置低,尤其是使用 Mac 或 AMD 显卡,运行缓慢

- 新模型(如 Flux Kontext、Krea 系列)频繁更新,难以及时体验

- 大模型占用存储空间大,硬盘容量告急

- 商业平台费用较高,不适合长期测试

- ……

为了解决这些问题,本文将分享一种通过 Google Colab 云端部署 ComfyUI 的方法,适合资源有限但希望体验主流 AI 绘图模型的用户。整个流程无需本地高性能设备,仅需浏览器即可完成部署与使用。

这个方法用到的工具是Google Colab:https://colab.research.google.com/

更多相关教程:

一、什么是Colab?

Google Colab 是由 Google 提供的基于云的 Jupyter Notebook 服务,支持运行 Python 代码,广泛用于数据分析与机器学习任务。

先说优点:

- 免费提供基础 GPU(如 T4)资源

- 下载速度极快,适合尝鲜测试最新模型

- 无需安装,直接在浏览器使用

再说缺点:

- 免费资源有限,分配方式不公开

- 退出后清空内容,需要重新部署

- 需要魔法上网且拥有Google账号(可用阿里天池、百度AI Studio等国内平台,使用方法同理)

简单来说,Colab就是让用户在云端构建的虚拟环境中运行他们的代码,而不需要用到本地电脑的配置。这一点十分契合需要高配置要求的ComfyUI,设计师可以仅仅通过浏览器在云端使用ComfyUI的所有功能,同时不影响自己电脑的运行速度,低配电脑也可以做到一边抽卡一边PS做图。

二、如何部署ComfyUI?

第一步:打开Notebook

可以直接使用预设的 Colab Notebook 模板(由 ComfyUI 官方版本优化):https://colab.research.google

注:如果访问不了需要申请。

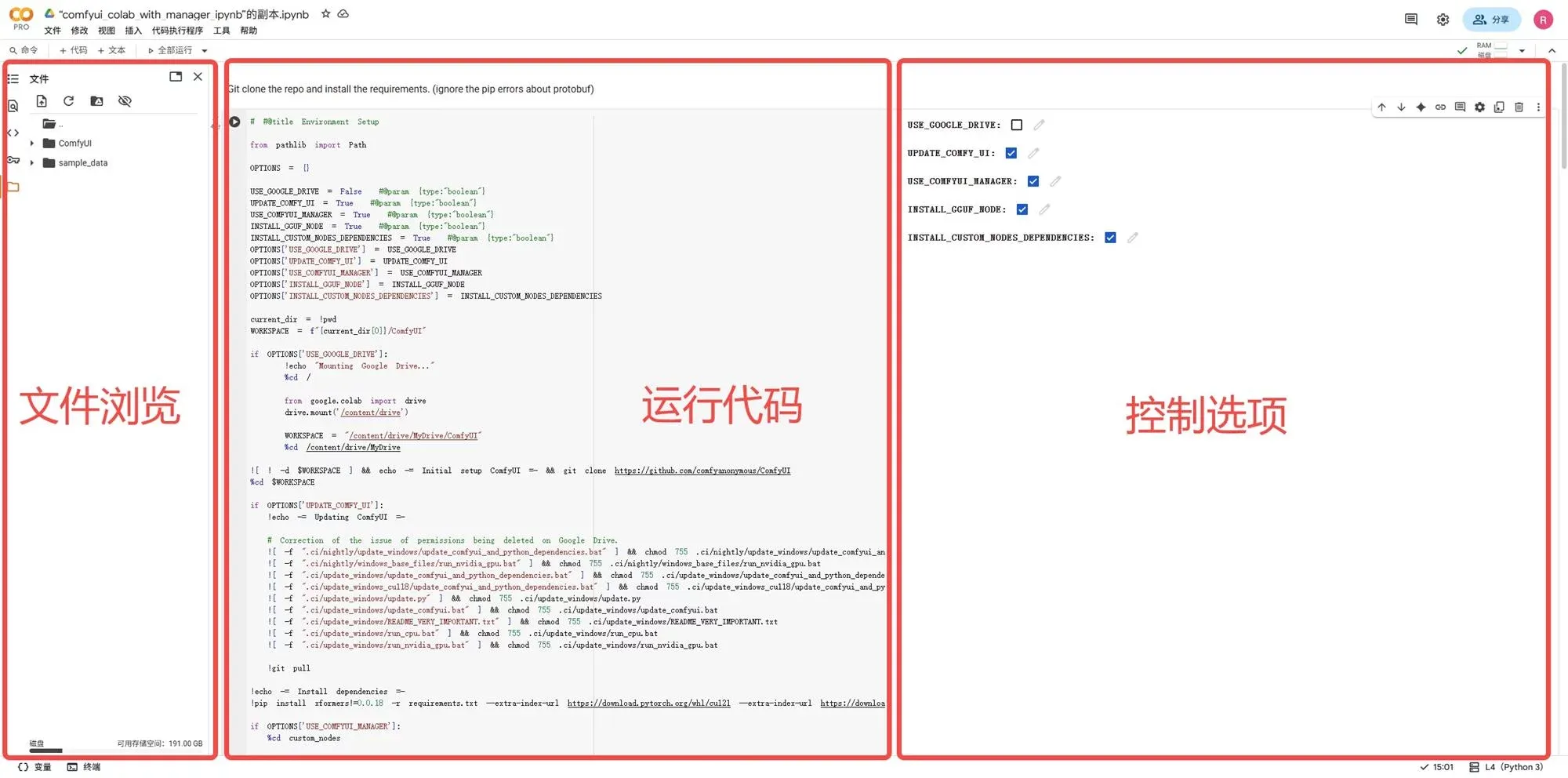

进入后页面如图所示:

最左边是文件管理区,类似于本地电脑的硬盘,用于查看和管理模型等文件。

中间区域是代码区,Notebook的主体代码会显示在这里。

右边区域是一个简易的控制面板,通过勾选开启或关闭一些代码中的功能:

USE_GOOGLE_DRIVE:

使用Google硬盘将下载的内容储存在云端,下次打开时不需要重新下载。可根据情况选择,但需考虑容量限制(免费版为 15GB)。通过Colab下载资源速度极快,无关本地网速,实测一个10GB的大模型文件下载不会超过1min,所以无需担心重复下载耗时过长。

UPDATE_COMFY_UI:

顾名思义,更新ComfyUI,方便使用ComfyUI最新的功能和模板。

USE_COMFYUI_MANAGER:

安装ComfyUI Manager,用于管理和下载自定义节点及模型。

INSTALL_GGUF_NODE:

安装GGUF节点。GGUF是大模型文件量化版本的一种格式,可以简单理解为低配版(低配置要求版)的大模型,安装这个节点才能够正常使用GGUF版本的模型。

INSTALL_CUSTOM_NODES_DEPENDENCIES:

安装自定义节点依赖项,安装后才能够正常使用下载的其他自定义节点。

这里的所有框框全部建议勾选。(如遇存储空间限制,可选择关闭Google Drive储存选项)

第二步:连接GPU

打开Notebook之后,点击页面右上角“连接”按钮旁边的小三角,选择“更改运行时类型”。

选择T4 GPU(默认选择,通常免费用户能够分配到的GPU,若需使用配置更高的L4 GPU和A100 GPU需升级Colab Pro)。然后点击“保存”,并点击“连接”按钮。如图所示即为连接成功:(使用完之后务必记得手动断开连接,不然可能会持续计算用时,若使用超过了Google分配的限额,可能会连接失败,需要隔一段时间重试)

第三步:启动ComfyUI

整个代码部分主要分为以下几个代码块:

- 部署 ComfyUI 环境:安装所需依赖并构建运行环境

- 下载模型资源:选择所需的绘图模型(默认列表可自定义)

- 启动服务并生成链接:访问部署后的 ComfyUI 界面

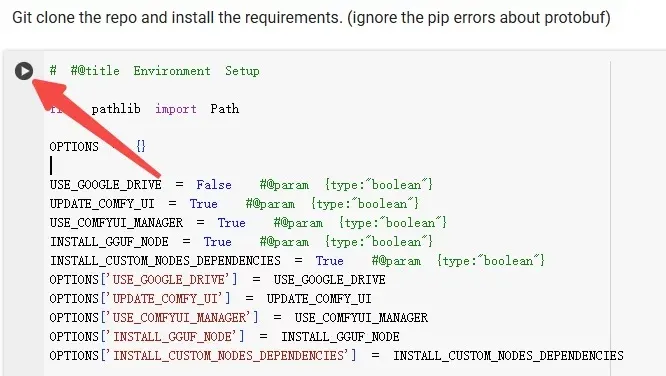

连接GPU成功后点击第一个代码块左上方的“运行”按钮(鼠标放在代码块上时才会显示)来下载并部署ComfyUI到云端。

当“运行”按钮转圈完成后会提示成功并显示运行所花费的时间。

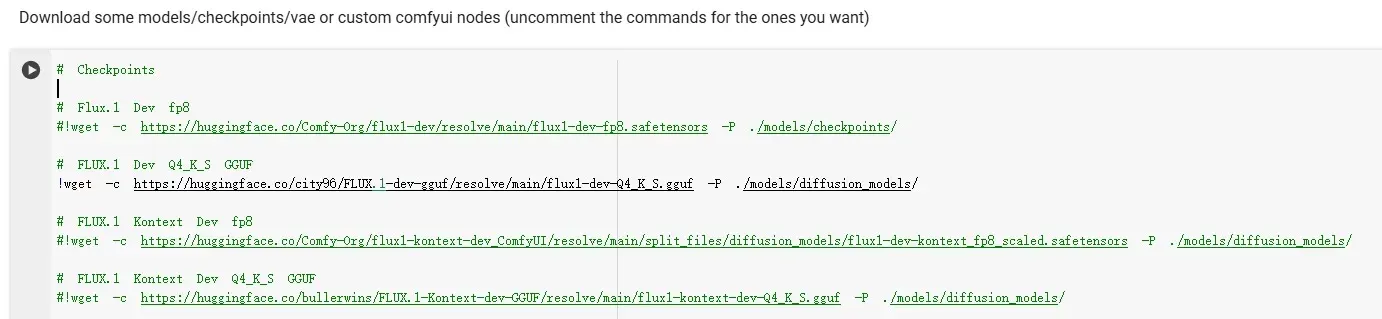

部署成功后,通过第二个代码块下载绘图所需的模型,代码中列出了许多常用的绘图模型下载链接。(若无所需模型,添加方法在后文中介绍。)

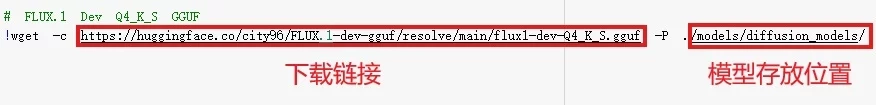

注:模型列表中的每个链接前通常带有注释符号 #,删除注释符号即可激活相应模型的下载;如需添加其他模型,只需按固定格式添加一行代码。

例:图中下载的模型为Flux.1 Kontext Dev Q4_K_S GGUF

模型下载固定格式

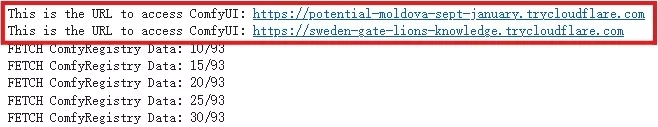

模型下载完成后,继续运行第三个代码块。运行片刻后代码块下方的输出项中出现如下链接:

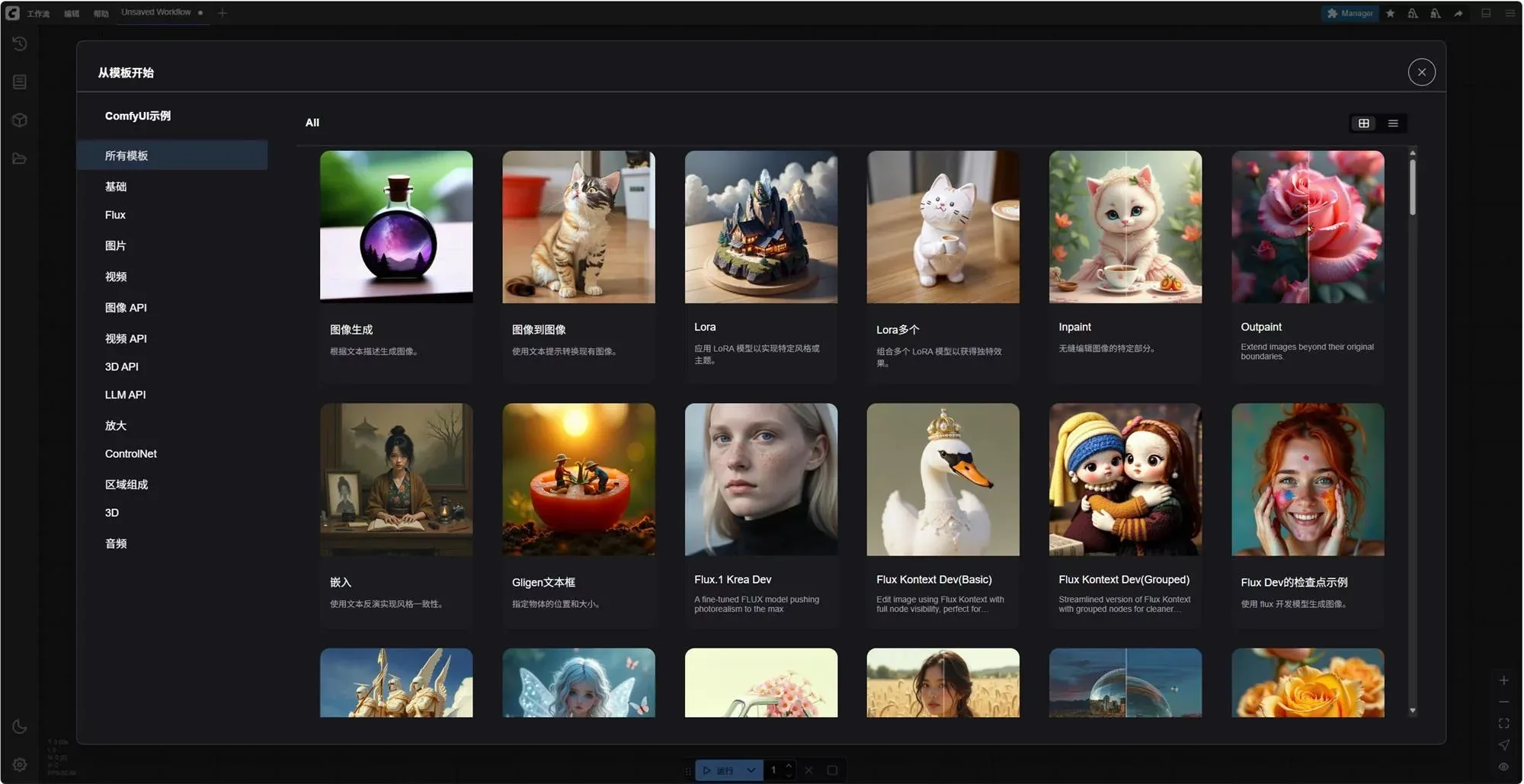

点击链接,稍等片刻。熟悉的ComfyUI界面就出现在眼前了!

三、实际使用测试

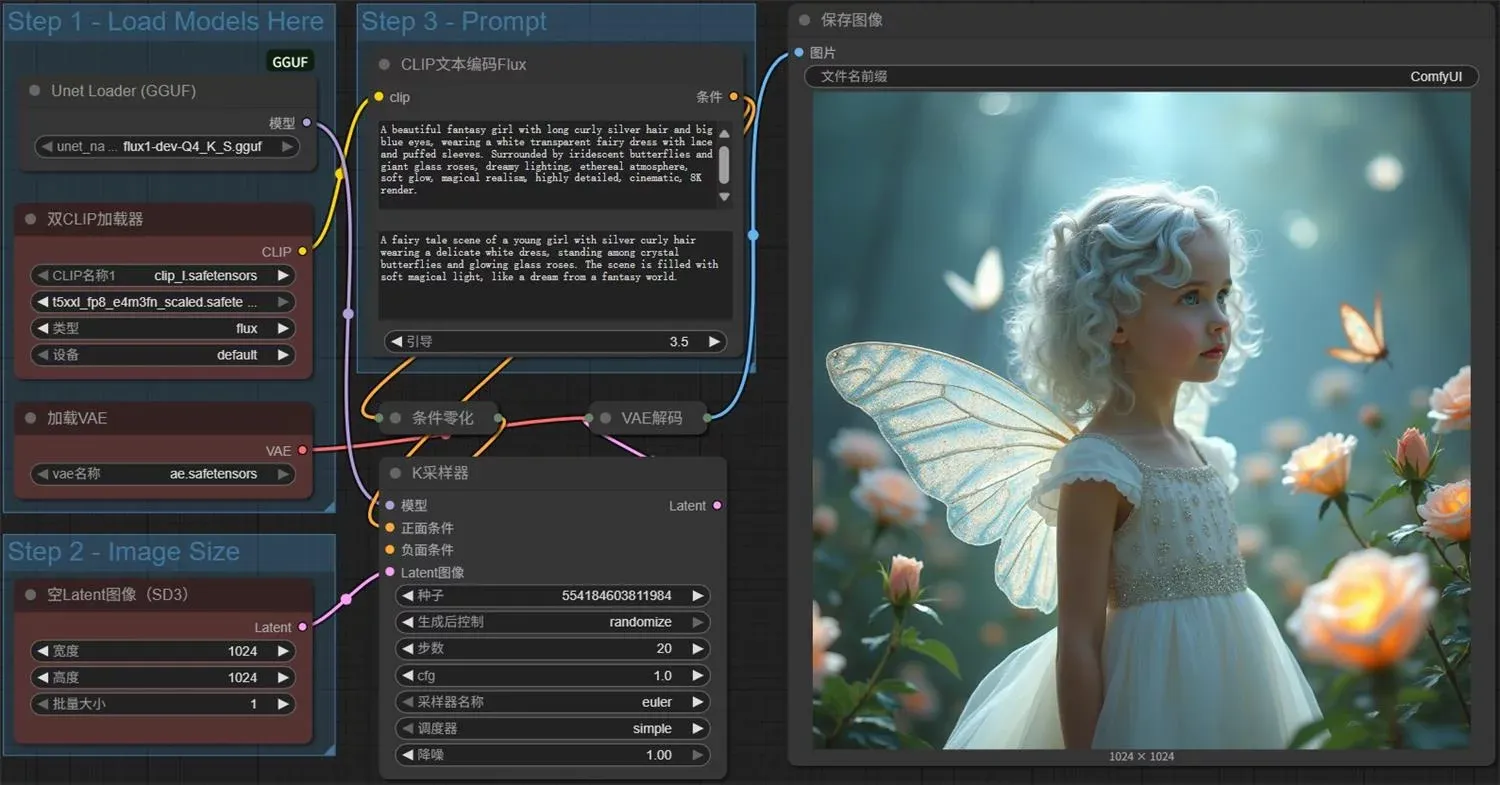

我们使用预设的FLUX Dev模板(由于使用的是GGUF模型,需要将模型加载节点换成Unet Loder(GGUF))尝试生成一张图,默认参数如图所示:

由于免费的T4 GPU性能有限,使用Flux.1 Dev Q4 GGUF模型生成一张图片耗时约为2分钟,生成质量和时长见仁见智。若使用L4 GPU,可将速度提高约2倍以上,提升生成效率和连接稳定性。

附上T4 GPU和L4 GPU生成同一张图片的时长对比: T4 GPU使用Flux.1 Dev Q4 GGUF生成 L4 GPU使用Flux.1 Dev Q4 GGUF生成

结语

以上就是通过 Google Colab 云端部署 ComfyUI的完整流程。希望这份教程能为低配设备的设计师朋友提供一个实用且低门槛的解决方案,让大家也能自由体验AI绘图的魅力。

需要注意的是,Colab 主要适用于轻量级、临时性计算任务,适合新手学习以及新模型尝鲜。如需大批量生成、高并发处理或长期部署,建议考虑本地部署或租用专用算力。

如在部署过程中遇到问题,欢迎在评论区交流与反馈。