近年来,基于流匹配的 VLA 模型,特别是 Physical Intelligence 发布的 π0 和 π0.5,已经成为机器人领域备受关注的前沿技术路线。流匹配以极简方式建模多峰分布,能够生成高维且平滑的连续动作序列,在应对复杂操控任务时展现出显著优势。

尽管如此,VLA 模型在训练过程中严重依赖于大规模、高质量的人类演示数据,而收集和标注这些数据的成本高昂且周期漫长。强化学习允许智能体通过与环境的真实交互自行探索和迭代改进,可以减少 VLA 模型对大量数据的依赖,并进一步提升 SFT 的性能上限。

目前,针对流匹配 VLA 的 RL 研究仍较少,主流工作大多集中在 OpenVLA 和 OpenVLA-OFT 等自回归 VLA 上。其核心挑战在于:流匹配 VLA 通过迭代去噪生成动作,导致难以直接计算输出动作的对数似然——而这是 PPO、GRPO 等策略梯度方法更新的关键。

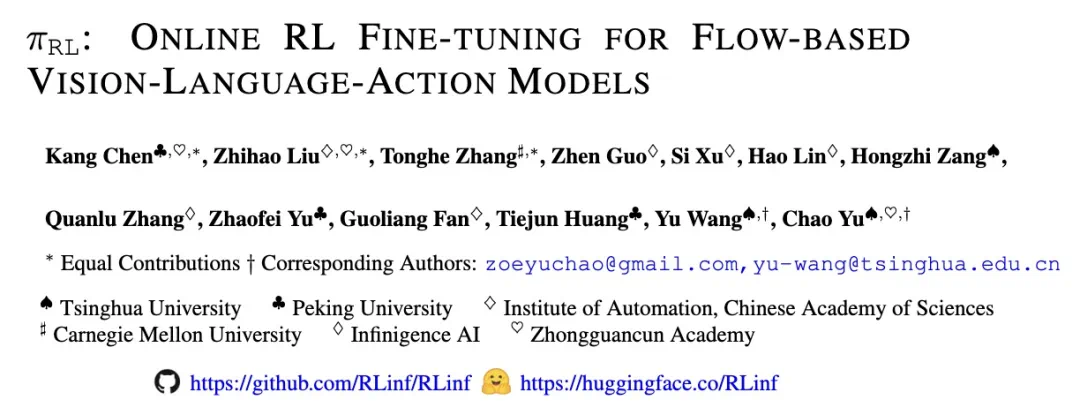

清华、北大、CMU 等机构联合推出了一套面向流匹配 VLA(π0, π0.5)的在线强化学习(PPO 和 GRPO)微调框架 πRL。该框架基于 RLinf(首个面向具身智能的大规模强化学习系统)实现,提出 Flow-Noise 和 Flow-SDE 两种微调方案,在公开测试平台 LIBERO 达到平均 97.6% (π0) 和 98.3% (π0.5),验证了微调方案的有效性。

进一步,πRL 在涵盖 4,352 种抓取-放置任务组合中进行训练,成功率涨幅 40% 以上,最终成功率超 80%,验证了框架支持大规模任务训练的能力。目前,全部代码、模型和文档示例已完全开源。

论文链接: https://arxiv.org/pdf/2510.25889

开源代码: https://github.com/RLinf/RLinf

模型仓库: https://huggingface.co/RLinf

复现文档:https://rlinf.readthedocs.io/en/latest/rst_source/examples/pi0.html

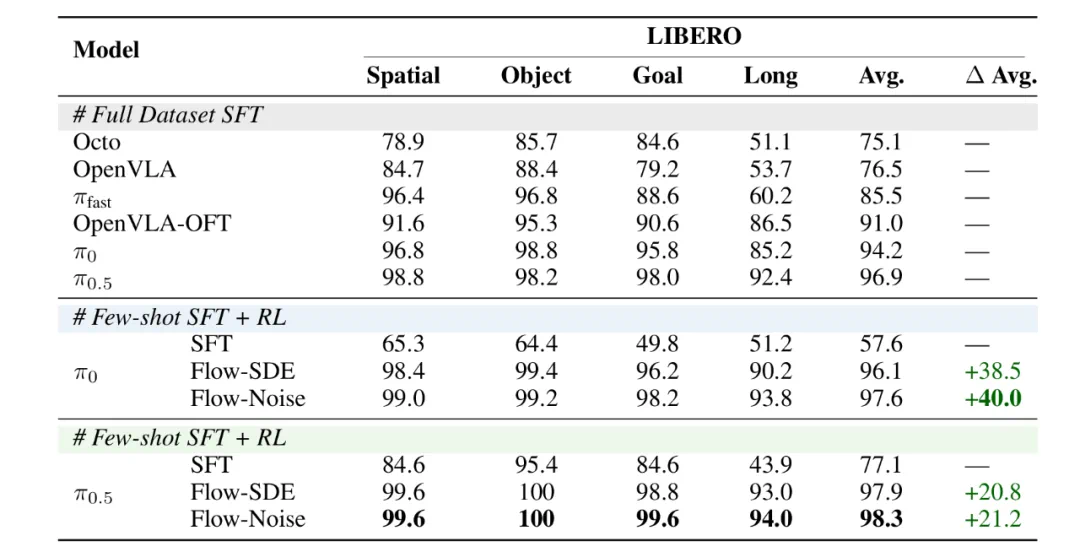

图 1: 本框架分别支持 π0 和 π0.5 两个模型,并提出了 Flow-Noise 和 Flow-SDE 两种技术方案,在 LIBERO 和 ManiSkill 测试平台上分别实现了最高 40.0% 和 44.7% 的增幅。

πRL 核心原理

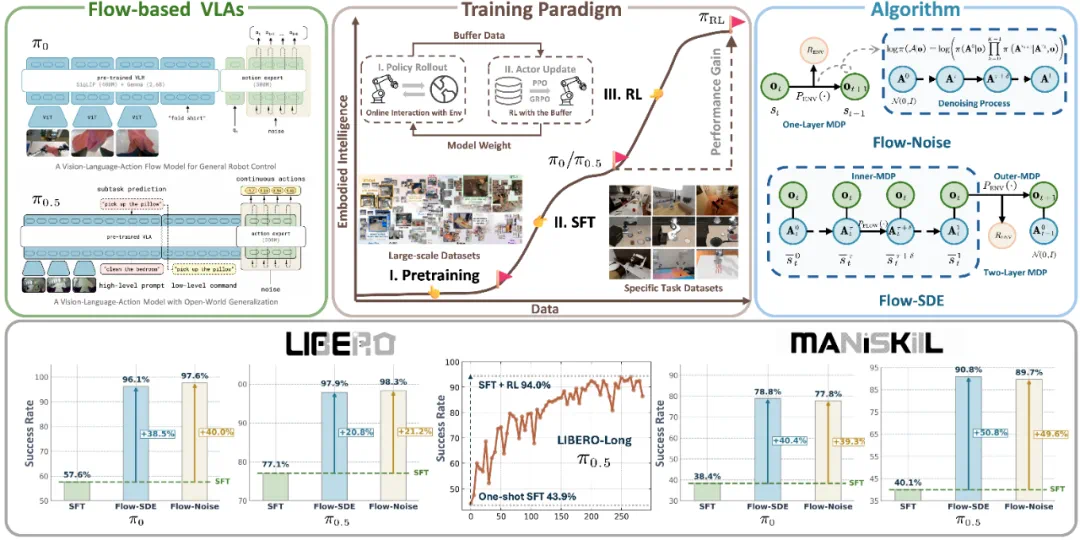

针对流匹配 VLA 难以直接计算输出动作对数似然问题,πRL 提出了两条技术路线:Flow-Noise 和 Flow-SDE。

图 2: Flow-Noise 通过将去噪过程建模为离散马尔可夫过程,能够直接计算去噪序列的联合概率密度;Flow-SDE 则将去噪与环境交互过程相结合,构建了双层 MDP。策略在 rollout 阶段收集完数据后,统一采用 PPO 进行策略梯度优化。

Flow-Noise

注入可学习噪声: 引入一个可学习的噪声网络,在去噪每一步均加入噪声,使去噪过程变为随机过程。

计算联合概率: 由于每一步噪声均可知(由噪声网络输出),整个去噪序列(从初始噪声至最终动作)的联合对数似然可精确计算。

策略梯度优化: 基于可精确计算的联合对数似然,可直接用标准策略梯度方法进行优化。

Flow-SDE

ODE-SDE 转化: 将原有确定性 ODE 去噪步骤,转化为等效 SDE,从而在策略中引入随机性。

构建两层 MDP: 把 SDE 去噪作为内层循环,与智能体-环境交互(外层循环)结合,构建双层 MDP 结构。

混合采样提速: 训练中大部分采用 ODE 确定性采样,小部分用 SDE 探索,以加速训练同时保证探索。

策略梯度优化: 在双层 MDP 中,策略输出由与环境交互的动作转为流匹配模型输出的速度场,可直接进行策略梯度优化。

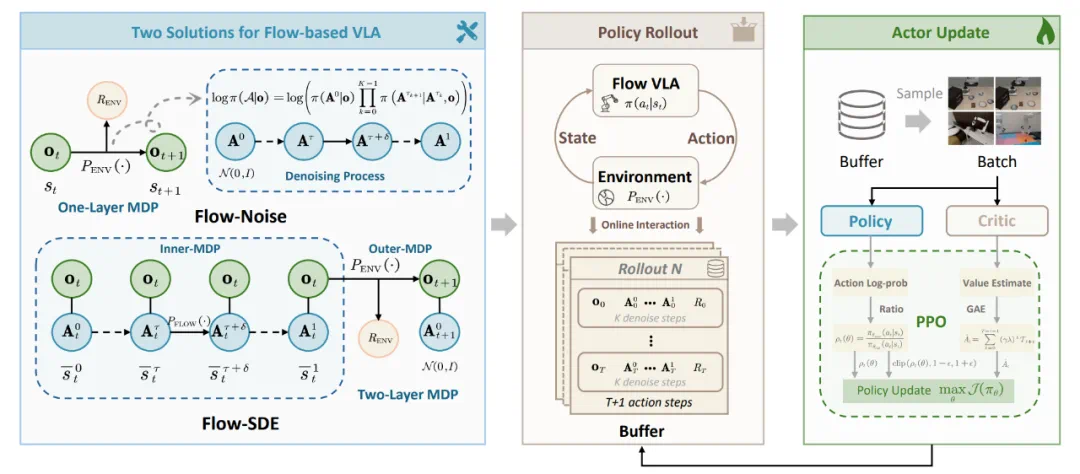

Critic 设计

针对 π0 和 π0.5 模型,πRL 在应用 PPO 算法微调时,探索了两种 Actor-Critic 架构:

Action Expert Critic(适用于 π0)

VLM 仅包含图像和语言信息,机器人状态与噪声动作一同送入 Action Expert。

Critic 接 Action Expert 隐藏层输出,并通过对全部噪声步取平均获得稳定的估计。

VLM Critic(适用于 π0.5)

VLM 融合全部输入(图像、语言、机器人状态)。

Critic 直接接 VLM 隐藏层输出。

图 3: 我们系统性地探索了两种 Critic 设计思路:一种将 Critic 部署在动作模型(Action Expert)之后,另一种则将 Critic 直接接入视觉语言模型(VLM)后。

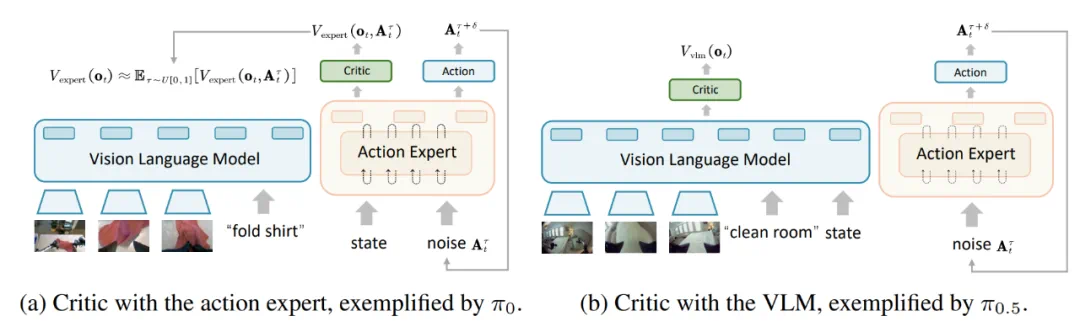

实验结果

πRL 在常用 VLA 评测集 LIBERO 及 ManiSkill 自建多任务集上验证了其有效性。

LIBERO:少样本 SFT+RL 范式超越全数据 SFT!

πRL 让 π0(few-shot)平均成功率从 57.6% 提高到 97.6%,π0.5(few-shot)从 77.1% 提高到 98.3%,超越全数据 SFT 训练的流匹配 VLA 表现。

图 4:LIBERO 测试平台下的性能对比

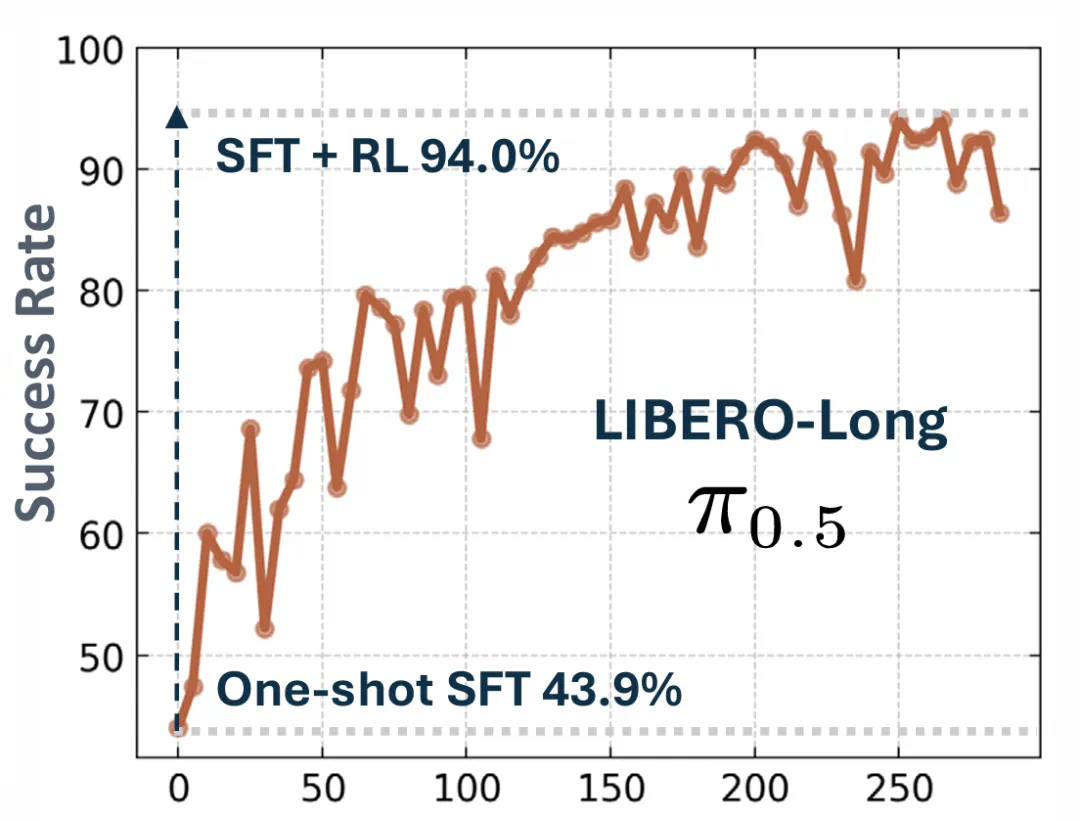

与此同时,在 LIBERO-Long 长时序任务上,πRL 使 π0.5 单样本 (one-shot) SFT 性能从 43.9% 提升到 94.0%!

图 5: LIBERO-Long 任务 one-shot SFT 的 RL 收敛曲线

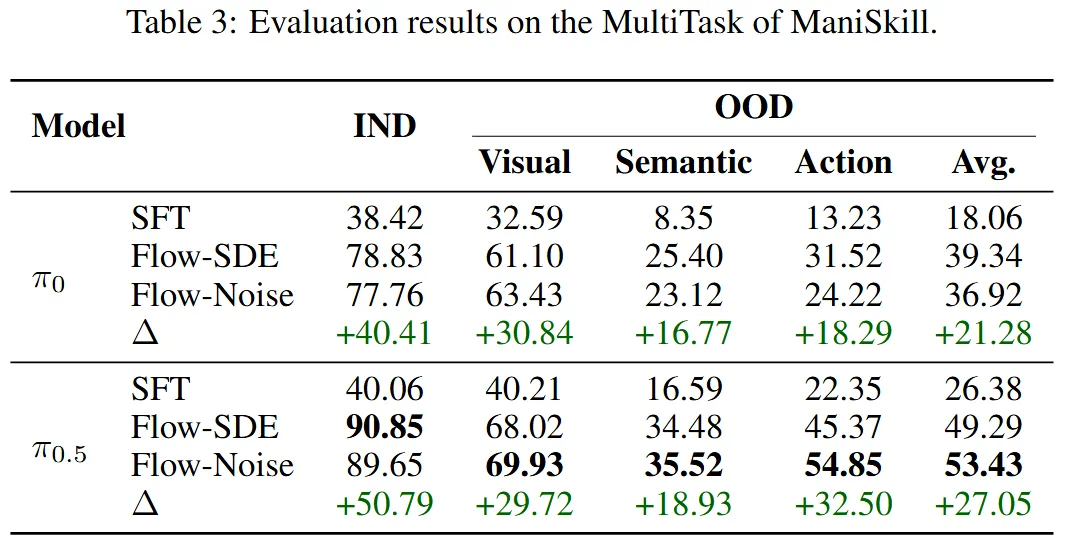

ManiSkill:验证大规模多任务 RL 能力!

为了验证 πRL 对大规模多任务的支持能力,我们在 Maniskill 中构造了涵盖 4,352 种抓取-放置任务组合。结果表明,通过在320个并行环境中进行训练,πRL(Flow-Noise)将 π0 成功率从 38.42% 提升到 78.83%,π0.5 成功率从 40.06% 提升到 90.85%。

图 6:ManiSkill Main任务中Pi05的RL收敛曲线

此外,我们还设计了 12 个与训练环境不同的域随机化测试环境,用于考察模型的泛化能力。在这些环境中,我们改变语言指令、物体类型、桌面纹理,或者在执行过程中移动物体、添加多个物体,来考察模型的泛化能力,并在每个环境中进行了 256 次测试来排除统计涨落的结果的影响。结果表明,πRL 算法能够显著提升两类模型在新环境下的泛化性能。

图 7:ManiSkill环境中对泛化能力的测试

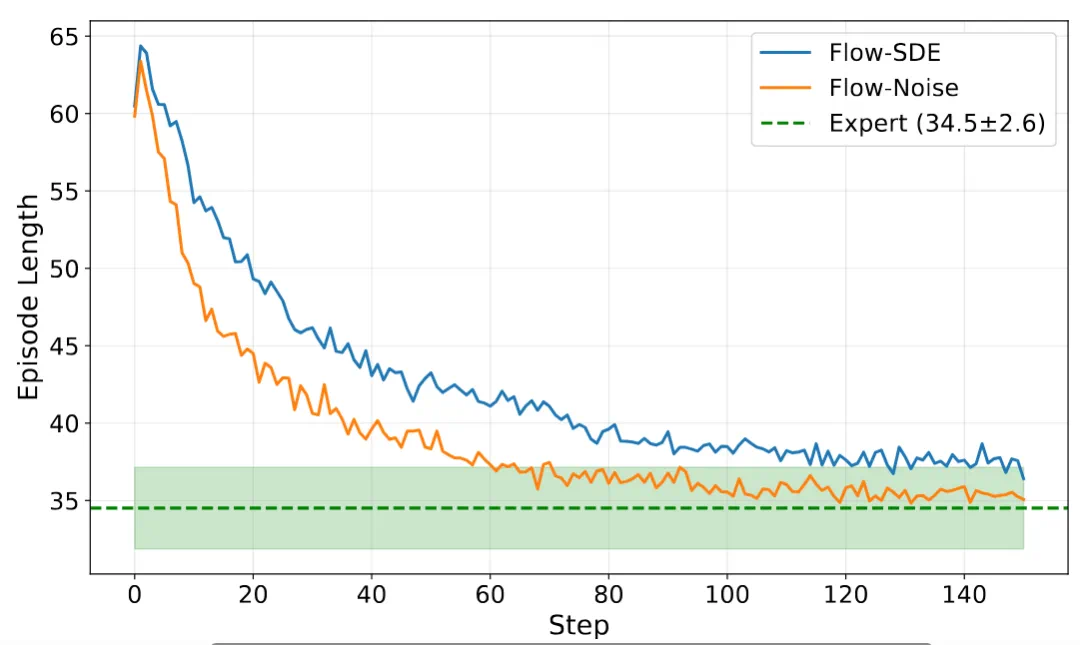

我们还在实验中观测到,相比监督微调,强化学习可以使得模型更少犯错,模型完成操作任务的平均步数可以显著减少,直到逼近专家数据水平:

图 8:强化学习提高完成任务的效率

消融研究

除上述对比试验外,论文还包含大量消融实验,为后续基于流匹配 VLA 的 RL 研究积累了经验。

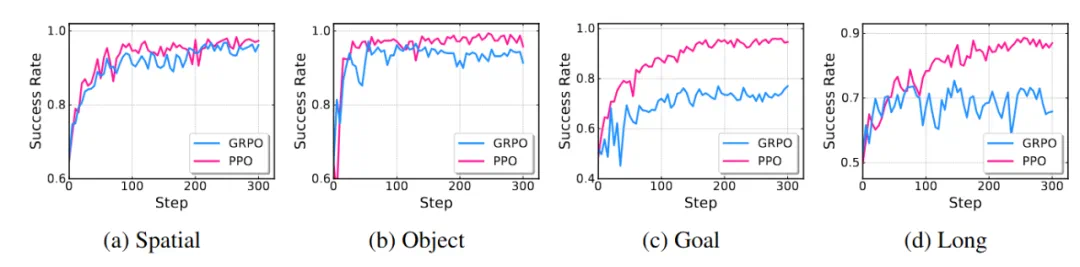

算法对比(PPO vs. GRPO): 使用流匹配 VLA,PPO 在最终性能和训练稳定性上均优于 GRPO。

图 9:PPO 和 GRPO 算法的收敛曲线对比

MDP 对比: Flow-Noise(单层 MDP)收敛略快,Flow-SDE(双层 MDP)单步更新更快(与去噪步数解耦),最终性能接近。

随机性注入对比: 可学习噪声(Flow-Noise)与固定噪声(Flow-SDE)两种策略,在相同 MDP 框架下性能类似,证明两类噪声注入均有效。

Critic 设计:Critic 接在 VLM 后略优于接在 Action Expert 后,且更稳定。

更多技术细节和消融结果详见论文。

未来展望

πRL 未来将继续发布更多结果,包括:

更多基准测试集: 接入更多仿真环境,进行更丰富的评测。

提升 OOD 泛化能力: 针对强化学习带来的泛化增益展开更深入分析。

真实机器人部署: 推动 πRL 框架从仿真走向真实物理机器人,验证其实际应用价值。