曾以为AI应用是程序员的专利?Dify 彻底颠覆了!它就像把复杂AI变成了乐高积木,人人都能动手搭建。告别代码焦虑,你的生成式AI创意,终于能亲手实现。

一起来看看Dify 是什么,能干嘛~

Dify 是一个开源人工智能应用开发平台,旨在简化和加速生成式人工智能应用的构建、测试和部署,适用于各种规模的团队。它通过集成 Backend-as-a-Service 和 LLMOps 来简化生成式人工智能的开发。

Dify 的定义、目标用户和解决的问题

- 定义: Dify 是一个开源平台,用于构建由大型语言模型 (LLM) 驱动的生成式 AI 应用程序。

- 目标用户: 产品经理、营销人员、业务分析师以及希望快速构建和部署生成式 AI 应用程序而无需大量编码经验的团队。

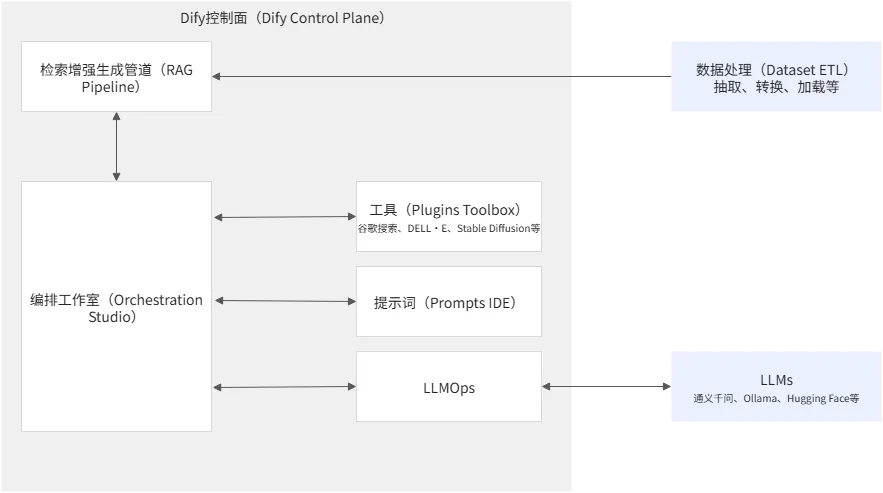

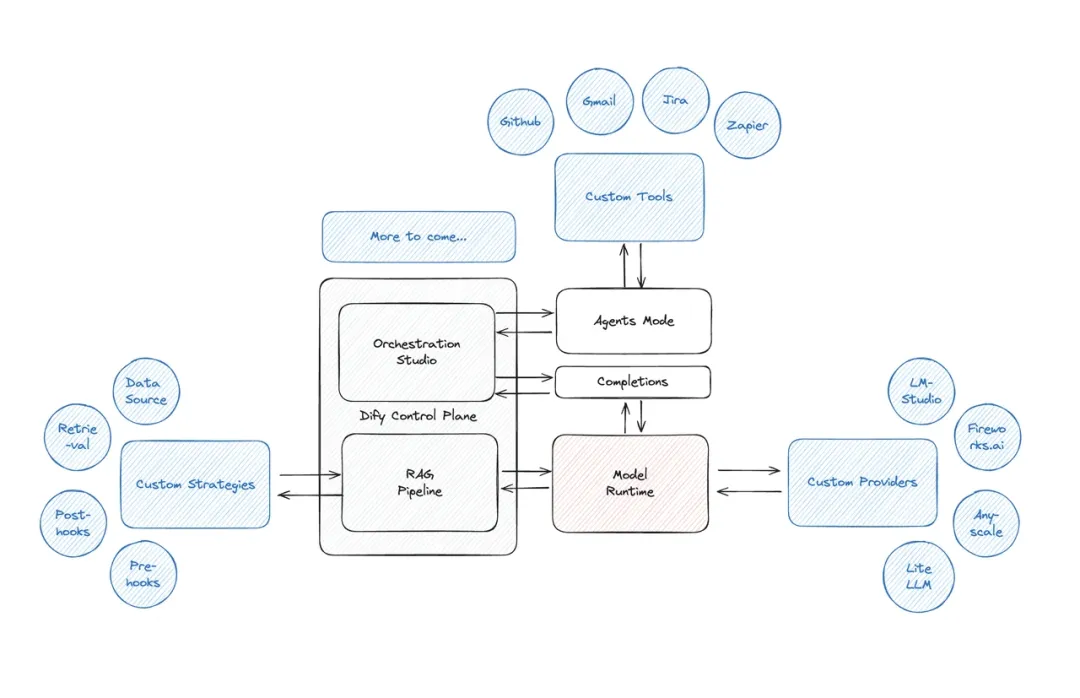

- 解决的问题: Dify 通过提供一个无需编码/低代码平台来简化 LLM 应用的开发,从而 democratizes 对高级 AI 功能的访问。它整合了 Retrieval-Augmented Generation (RAG) 管道、AI 工作流、可观察性工具和模型管理到一个直观的界面中。

Image

Image

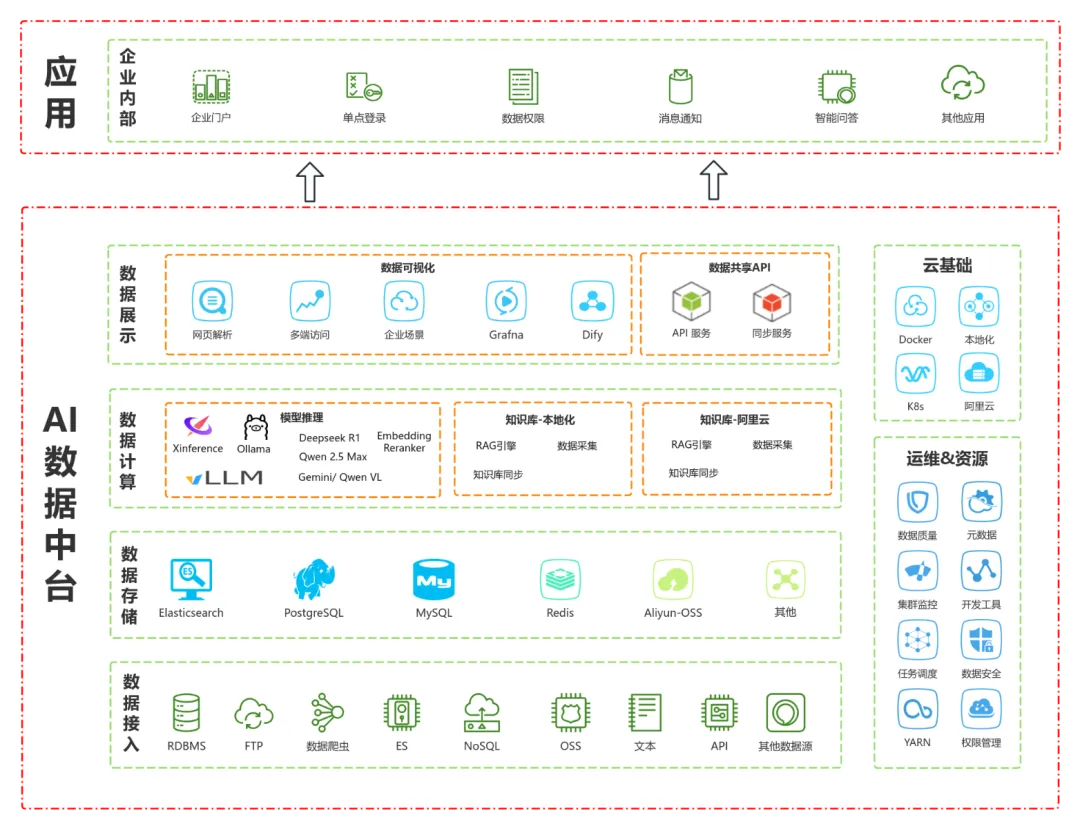

Dify 的核心功能和主要特点

- 可视化编排: Dify Workflow 提供了一个可视化的流水线构建器,用于创建和测试 AI 工作流,无需大量编码。

- 模型支持: Dify 支持各种流行的 LLM,包括 GPT、Llama2、Qwen 等。它还支持本地模型的使用。

- 数据集管理: Dify 允许从各种来源提取数据,对其进行转换,并将其索引到向量数据库中,以优化 LLM 的使用。它还具有 RAG 引擎,可通过集成来自文档、数据库或网络源的实时数据来增强 LLM 的输出。

- API 集成: Dify 允许将 AI 应用程序一键部署为 API、聊天机器人或内部业务工具。

Image

Image

- 后端服务: Dify 通过集成的 Backend-as-a-Service 和 LLMOps,提供可视化工作流构建器、prompt IDE 和 RAG 管道,使用户能够快速构建生产级生成式 AI 应用程序。

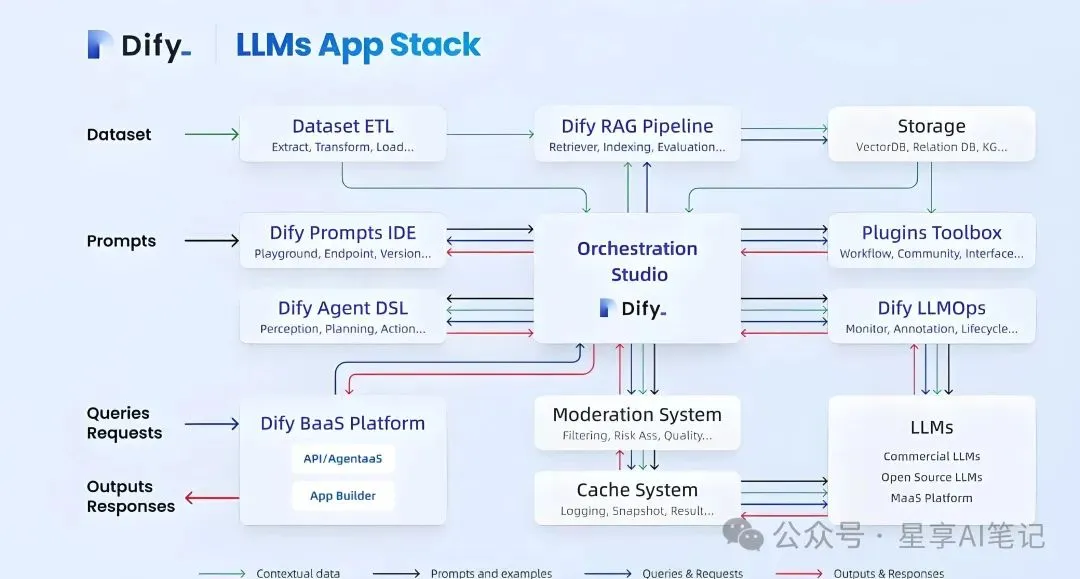

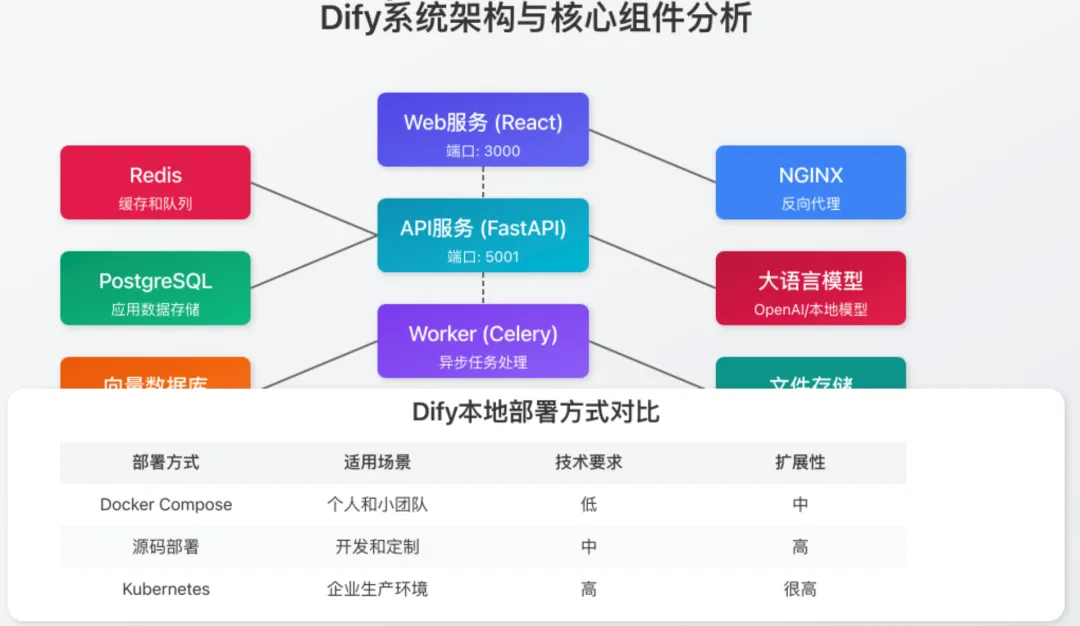

Dify 的技术架构或工作原理

Dify AI 运行在模块化架构上,包括三个核心组件:

- LLM Orchestration(LLM 编排): 无缝连接和切换领先的大型语言模型。

- Visual Studio(可视化工作室): 用于设计 AI 工作流、训练 AI 代理和配置 RAG 系统的拖放界面。

- Deployment Hub(部署中心): 一键将 AI 应用程序部署为 API、聊天机器人或内部业务工具。

Dify 的使用案例

- 构建聊天机器人: Dify Agents 使组织能够部署嵌入了领域特定知识的个性化 AI 聊天机器人和虚拟助手。

- 文本生成应用: Dify 可用于自动化常见问题解答,总结竞争对手的定价和市场研究,以及生成全面的业务报告。

- 工作流自动化: Dify Workflow 可用于快速自动化复杂的流程,例如客户支持路由、数据检索和任务自动化。例如,营销团队可以快速创建工作流来分析客户情绪、生成回复草稿以及将复杂案例升级给人工代理。

图片

图片

Dify 与其他类似 AI 应用开发平台的优势或不同之处

- Dify vs GPTBots: Dify 提供了更广泛的功能,包括工作流编排和 RAG。GPTBots 更适合需要高度定制的、具有专家指导和无缝多平台集成的企业级 AI 代理。

- Dify vs LangChain: Dify 提供了一个图形化的拖放和低代码界面,使得即使非技术人员也能快速轻松地开发应用程序。LangChain 是一个以开发者为中心的框架,需要编码专业知识来构建 LLM 应用程序。

- Dify vs Flowise: Dify 提供了一个更直观的体验,具有简洁和现代的界面,专为易用性而设计,即使对于非技术用户也是如此。Flowise 给人一种开发者游乐场的感觉,可以最大限度地控制您的工作流程。

Image

Image

Dify 不只是个工具,它是你AI创意的“秘密武器”!它证明了构建强大AI应用,根本无需深厚代码功底。如果你渴望迅速将想法变为现实,Dify 绝对值得你一试。