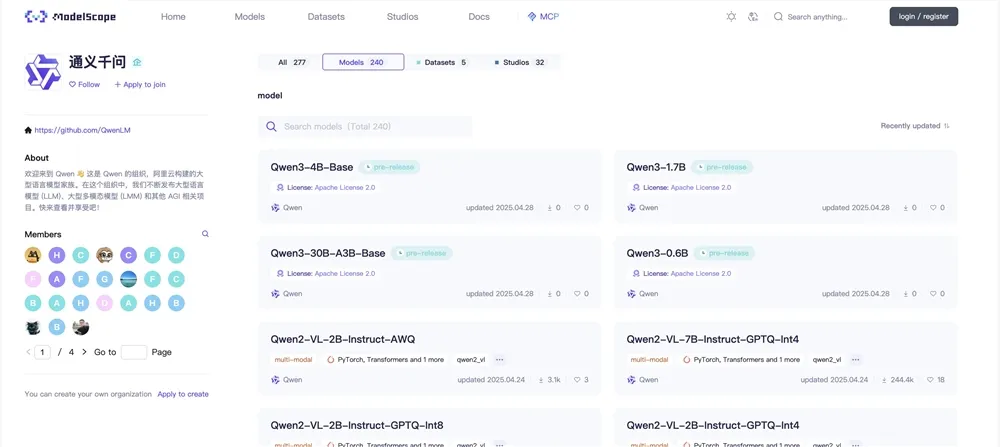

阿里云Qwen团队通过社交平台正式确认,Qwen3系列模型将于本周内发布,标志着其旗舰大语言模型(LLM)与多模态能力的又一次重大升级。据AIbase了解,Qwen3将推出包括0.6B、4B、8B、30B-A3B在内的多种模型规模,支持高达256K的上下文长度,涵盖推理与非推理任务。社交平台上的热烈讨论凸显了其全球影响力,相关细节已通过Hugging Face与Qwen官网逐步公开。

核心功能:多规模模型与超长上下文

Qwen3通过架构优化与多样化模型规模,为开发者与企业提供了灵活的AI解决方案。

AIbase梳理了其主要亮点:

多模型规模:提供0.6B、4B、8B与30B-A3B(MoE,3B活跃参数)等模型,适配从边缘设备到高性能服务器的多种场景。

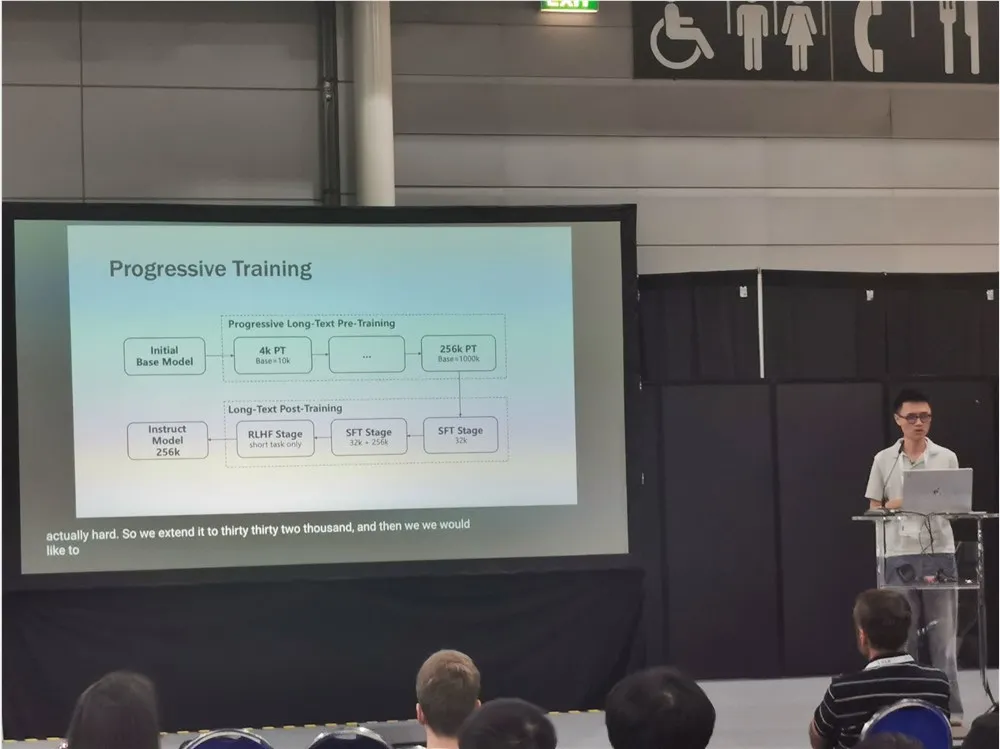

256K上下文长度:支持超长上下文处理,适合复杂任务如长文档分析、代码生成与多轮对话。

推理与非推理融合:集成Qwen3-math等专用模型,优化数学推理与问题解决,同时保持通用任务的强大性能,超越Qwen2.5在MATH与GSM8K基准的表现。

多模态扩展:延续Qwen2.5-Omni的进展,支持文本、图像、音频与视频处理,Qwen3-Audio进一步增强语音转录与跨模态任务能力。

开源与企业支持:遵循Apache2.0许可证,部分模型权重将开源,付费版支持企业级安全与定制化部署。

AIbase注意到,社区期待30B-A3B MoE模型在性能与效率上的突破,测试显示其在CPU上运行速度接近2B模型,同时输出质量接近15B密集模型,展现了MoE架构的优势。

技术架构:MoE创新与多模态融合

Qwen3基于阿里云的最新AI技术栈,结合混合专家(MoE)架构与多模态能力。AIbase分析,其核心技术包括:

MoE架构优化:30B-A3B模型采用128专家与3B活跃参数,通过精细化路由函数提升性能,较Qwen2.514B更高效,接近DeepSeek R1的推理能力。

多模态处理:集成Qwen3-Audio与视觉模块,支持音频转录、视频理解与跨模态生成,参考Hunyuan3D的3D建模技术。

长上下文优化:通过改进的Rotary Position Embedding(RoPE),支持256K token上下文,减少长序列推理的内存开销。

高效推理:兼容vLLM、SGLang与llama.cpp,新增Flash Attention2支持,推理速度在A100GPU上提升约20%。

开源生态:模型权重与llama.cpp支持已提交GitHub PR,预计发布后即支持本地运行,开发者可通过Hugging Face快速部署。

AIbase认为,Qwen3的MoE设计与多模态能力使其在成本与性能间取得了平衡,挑战了DeepSeek V3与Llama4的地位,尤其在边缘设备上的0.6B模型展现了轻量化潜力。

应用场景:从边缘设备到企业级部署

Qwen3的多样化模型与超长上下文支持为其开辟了广泛的应用场景。AIbase总结了其主要用途:

边缘计算:0.6B与4B模型可在手机与Raspberry Pi等设备运行,适合实时翻译、语音助手与轻量级RAG应用。

代码与数学:Qwen3-math在编程与数学推理任务中表现优异,适合教育平台、代码生成与金融分析。

多模态内容创作:支持生成视频、图像与音频的跨模态内容,适配TikTok营销、虚拟主播与AR/VR场景。

企业级AI代理:30B-A3B模型通过ADPPO+框架优化,支持复杂工作流如医疗诊断、法律文档分析与客服自动化。

开源社区:Apache2.0许可证鼓励开发者贡献,模型可集成至ComfyUI或DeepWiki,构建自动化工作流。

社区案例显示,一位开发者利用Qwen38B模型在16GB VRAM设备上实现了长文档总结,256K上下文支持一次性处理整本书籍,效率远超Qwen2.5。AIbase观察到,其与Qwen Chat App的结合将进一步降低非技术用户的接入门槛。

上手指南:快速部署与体验

AIbase了解到,Qwen3将于本周通过Hugging Face(huggingface.co/qwen)与Qwen官网(qwen3.org)发布,部分模型免费开源,企业版需订阅。用户可按以下步骤快速上手:

访问Hugging Face Qwen组织页面,下载0.6B、4B或8B模型权重;

安装最新Transformers库与llama.cpp,配置Flash Attention2以优化推理;

输入文本或多模态提示(如“生成赛博朋克风格视频”),运行推理生成内容;

使用Qwen Chat App(iOS/Android)体验预训练模型,适配非技术用户;

开发者可通过API或GitHub PR集成模型至本地工作流。

社区建议为MoE模型分配足够RAM(30B需约60GB),并测试不同量化级别(如Q4_K_M)以平衡性能与资源。AIbase提醒,发布初期可能因高需求导致下载拥堵,建议关注Qwen官方博客(qwen3.org)获取最新动态。

社区反响与改进方向

Qwen3确认发布后,社区对其多规模模型与256K上下文支持表达了高度期待。开发者称其“有望重新定义开源AI的性能标准”,尤其30B-A3B MoE模型被认为是Qwen2.5-Max的强力升级。 然而,部分用户对发布延迟表示失望,建议阿里云明确时间表并优化私有代码库支持。社区还期待Qwen3支持视频生成与更高效的推理框架。阿里云回应称,Qwen3已进入最终测试阶段,Qwen Max完整版(约200B MoE)将在稍后发布。 AIbase预测,Qwen3可能与DeepWiki或Step1X-Edit整合,构建从代码解析到多模态生成的生态。