阿里巴巴开源了超强AI Agent模型Qwen3-Coder-480B-A35B-Instruct。

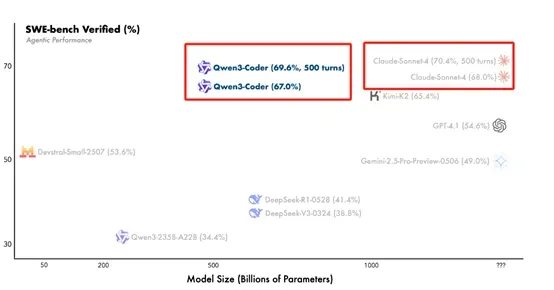

根据阿里公布的测试数据显示,Qwen3-Coder在OpenAI发布的Agent测试基准SWE-bench Verified中,500轮交互的测试分数达到了69.6%,常规分数为67%,可媲美最强闭源代码模型之一Claude Sonnet 4的70.4%和68%。

同时Qwen3-Coder也大幅度超越了DeepSeek R1-0528版本的41.4%和V3-0324版本的38.8%。

开源地址:https://huggingface.co/Qwen/Qwen3-Coder-480B-A35B-Instruct

https://github.com/QwenLM/Qwen3-Coder

Qwen3-Coder采用了混合专家架构,一共有4800亿参数,其中350亿处于活跃状态。原生支持256K上下文窗口,但可通过YaRN技术扩展至100万。这对于代码领域来说帮助非常大,例如,一些比较小的开发项目可以一次性全部解读。

Qwen3-Coder在预训练阶段使用了7.5T的高质量数据进行了训练,其中70%为代码数据,同时保留了通用和数学推理能力。还利用 Qwen2.5-Coder 来清理和重写嘈杂的数据,显著提高了整体数据质量。

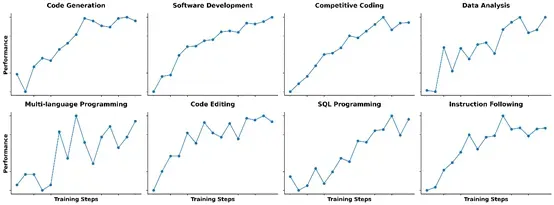

在后训练阶段,Qwen3-Coder 进行了代码强化学习的扩展训练。与社区中常见的专注于竞赛级代码生成不同,Qwen3-Coder 认为所有代码任务都适合执行驱动的大规模强化学习。

通过自动扩展多样化编码任务的测试用例,创建了高质量的训练实例,成功释放了强化学习的全部潜力,不仅显著提高了代码执行的成功率,还为其他任务带来了增益。

此外,Qwen3-Coder 引入了长视界强化学习(Agent RL),以鼓励模型通过多轮交互使用工具来解决现实世界中的任务。Agent RL 的关键挑战在于环境扩展,为此,Qwen3-Coder 构建了一个可扩展的系统,能够并行运行 20000 个独立环境,利用阿里云的基础设施提供必要的反馈,支持大规模强化学习和大规模评估。

为了方便使用Qwen3-Coder,还开源了一个命令行工具Qwen-Code,它是从 Gemini Code分叉而来的,经过定制提示和功能调用协议的调整,以充分发挥Qwen3-Coder在智能体编码任务中的能力。

Qwen Code支持OpenAI SDK,并且可以通过环境变量或 .env文件配置API密钥和基础URL。

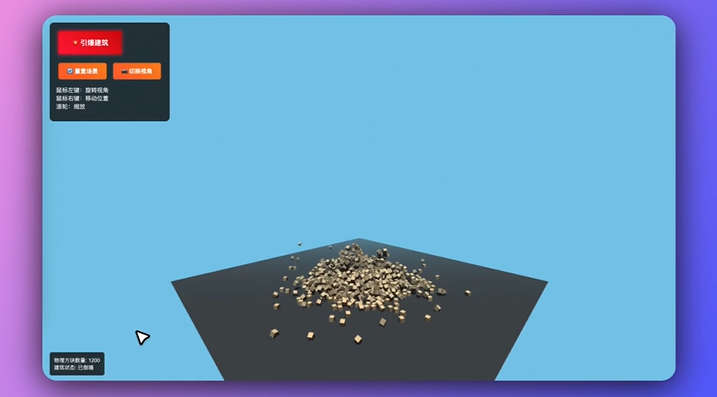

Qwen3-Coder在编程方面的能力非常出色,例如,开发一个基于物理定律的烟囱拆除控制爆炸模拟器。

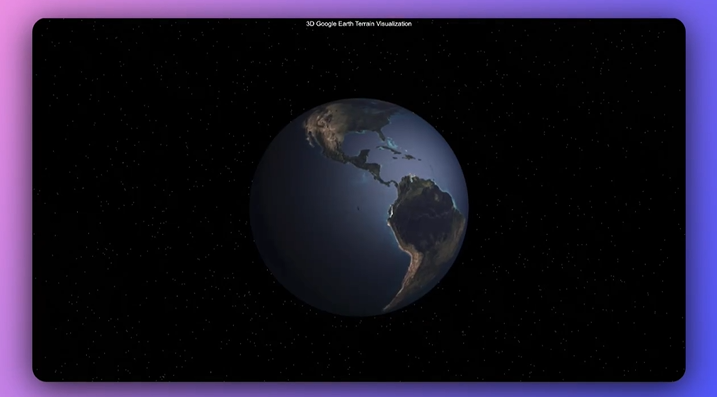

开发一个类似谷歌地图的3D模拟器。

用一句名言测试你的打字速度的应用。

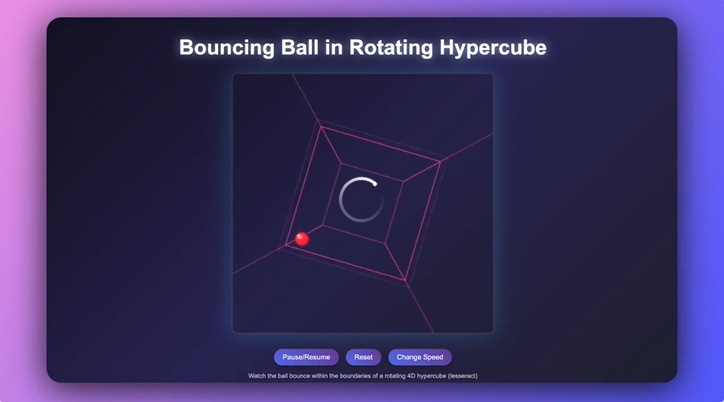

开发一个旋转超立方体中的弹跳球。

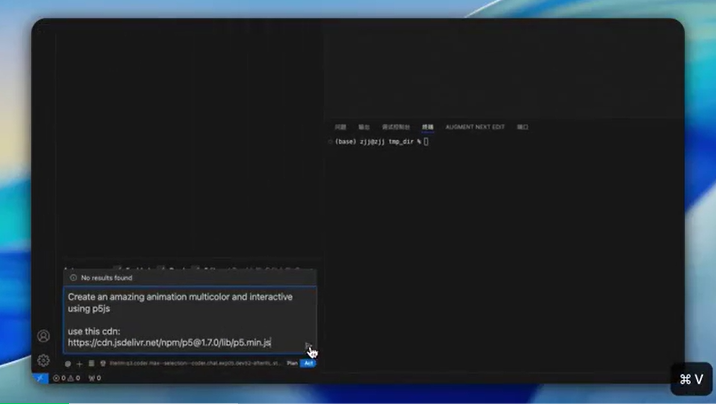

使用p5.js创建一个令人惊叹的多色和交互式动画。

值得一提的是,Qwen3-Coder还可以与Claude Code一起使用,用户只需要阿里云模型工作室平台上申请API密钥,并安装Claude Code 就能编码。还提供了claude-code-config npm 包,用于自定义Claude Code的后端模型。

申请地址:https://modelstudio.console.alibabacloud.com/