编辑 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

“OpenAI转向谷歌芯片”?这事恐怕真被大家误会了。

几天前,路透社爆出猛料——知情人士称,OpenAI 已经开始租用谷歌的 AI 芯片 TPU,用来支撑 ChatGPT 和其他产品的运行。这意味着 OpenAI 将首次在大规模业务中启用非英伟达的 AI 芯片。

这消息一出,立刻引发轰动——

OpenAI 不是英伟达 GPU 最大买家之一吗?现在突然“投奔”谷歌?

是不是意味着,AI 战争的芯片格局要变了?

图片

图片

但事情很快来了个急转弯——

仅仅过了三天,OpenAI 就跳出来澄清了:

目前没有任何计划部署谷歌芯片!

图片

图片

为什么会有这样的反转呢?

1.OpenAI回应:无计划,租用只是测试

先说结论:OpenAI 的确租了谷歌的 TPU 芯片,但并非“转向”。

OpenAI 发言人周日向媒体表示,当前确实在测试谷歌的张量处理单元(TPU),但强调“这只是早期尝试”,目前没有在大规模部署这些芯片的计划。

这一说法,等于直接否定了“全面转向谷歌芯片”的传闻。

事实上,在 AI 实验室中测试不同芯片是一种常规操作。但从测试到真正落地,距离可不小:这不仅涉及硬件本身的适配,还包括软件框架、编译链乃至整个部署架构的重建,动辄耗时数月甚至一年以上。

因此,OpenAI的算力主力,在很长一段时间仍然是英伟达的GPU。

2.OpenAI 的真实刚需:不是“转向”,而是“压价”

虽然这场“芯片风波”看起来像是一场乌龙,但仔细看就会发现:OpenAI 并不是在转向谷歌,而是在施压英伟达。

Sam Altman 领导的公司,当前最核心的需求其实很现实——降低推理成本、掌握算力议价权。

据《The Information》报道,OpenAI 正通过谷歌云租用 TPU,用于测试模型推理任务。这并非临时起意,而是为了寻找一个更具性价比的选项,作为 GPU 的潜在补充甚至是谈判筹码。

同样的,OpenAI 还在逐步减少对微软 Azure 数据中心的依赖。作为投资方,微软为 OpenAI 提供了训练基础设施,但在实际推理阶段,OpenAI 近年来已大量采购 CoreWeave 等第三方 GPU 云服务商的资源,显示出其“云平台去中心化”的趋势。

OpenAI用一场乌龙透露自己的底牌:英伟达和微软都不是自己的唯一选择。

3.谷歌“留一手”——最强满血版TPU并未租给 OpenAI

有趣的是,作为提供算力的一方,谷歌的生态位并不像英伟达那么单纯。

作为AI巨头之一,他们和OpenAI展开正面竞争——而且近来的势头非常凶猛:

旗舰模型 Gemini 2.5 Pro 表现出色,性价比拉满;刚刚推出的 Gemini CLI 更是直接和 OpenAI 家的编程工具 Codex打擂台。

正因为复杂的竞争局面,谷歌根本不敢拿最顶的算力租给OpenAI。

据《The Information》援引谷歌云内部员工的说法,谷歌虽然向 OpenAI 提供了部分 TPU 资源,但明确没有开放其最强性能的“满血版”TPU。

这一细节很关键:哪怕 OpenAI 真想转向谷歌,也无法获得最优解。而 Altman 也绝不会看不穿这点——

对 OpenAI 来说,真正的最优策略,永远是左右横跳、压价博弈,而不是彻底投向另一家巨头的怀抱。

当然了,还有一个最优解还有另一个答案,就是走向自研。

4.还有后招,OpenAI自研AI芯片将于年底前流片

除了测试谷歌的 TPU,OpenAI 也没停下自研芯片的脚步。

预计今年内,该公司将完成首款 AI 芯片的“流片(tape-out)”——即芯片设计定稿并送往台积电生产,目标是在 2026 年实现大规模制造。

这颗芯片将采用脉动阵列(systolic array)架构,适合处理大规模矩阵计算任务,并配备高带宽内存(HBM),但暂不确定是 HBM3E 还是更新一代的 HBM4。制程方面,OpenAI 将使用台积电成熟的 N3 系列(3nm)工艺。

该架构的技术原理,是由大量相同的处理单元(用于矩阵或向量运算)构成网格,它们以管道式传输方式进行高速数据处理。脉动阵列的优势在于定制化、低延迟、高吞吐、能效比高,非常适合 推理(inference) 阶段。

综上所述,OpenAI的这款芯片在结构思路上就是向 TPU 学习,而非模仿英伟达 GPU。

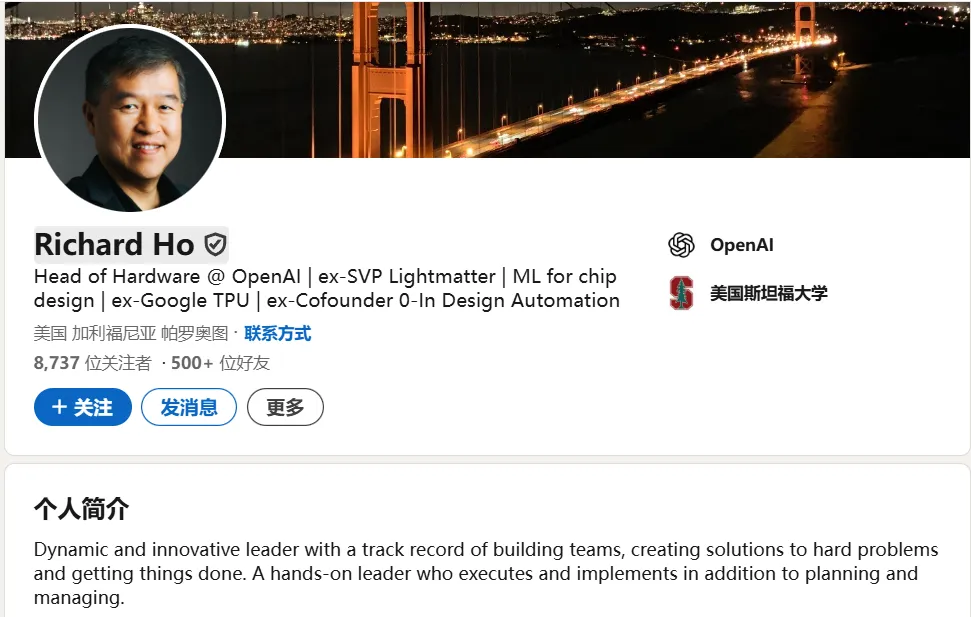

整个项目由前谷歌 TPU 核心工程师 Richard Ho 负责,目前团队规模大约为 40 人,虽然相比 AWS、谷歌那几百人的自研芯片团队还远远不够。

图片

图片

当然,造一颗高性能 AI 芯片远不止“画出图纸”这么简单。行业普遍估算,一个完整的芯片项目成本高达数亿美元,如果再加上配套的软件栈、编译器、测试平台,整体投入可能翻倍。

但一旦架构搭好,边际成本会随每一代产品迅速下降。

OpenAI 若能在今年内成功流片,最快将在 2026 年中小批量量产,并于明年年底前投入部署。

今天刚好是 2025 年下半年的第一天。

Altman 的芯片 KPI 能如期完成吗?

OpenAI 自研芯片,有可能撼动英伟达的霸主地位吗?