又是美团!

美团最近在AI领域的开源动作,真是令人刮目相看。

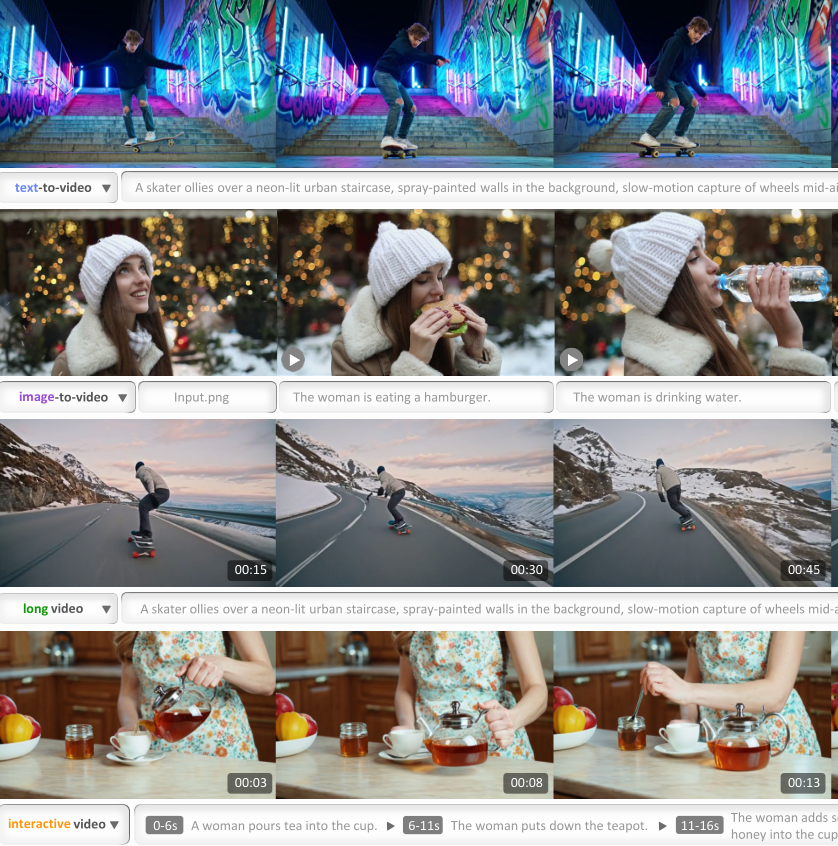

刚刚,美团LongCat团队发布了LongCat-Video的基础视频生成模型,它拥有136亿的参数量,能在数分钟内生成720p、30帧每秒的高质量视频,并且在文本转视频、图像转视频和长视频续写等多个任务上都表现出色。

从谷歌的Veo、OpenAI的Sora,到快手的可灵(Kling)和国内外的众多开源模型,视频生成的质量、对指令的理解能力以及运动的真实感都在飞速提升。

LongCat-Video这个时候杀出来,一定有它的亮点。

核心亮点在于其统一的多任务架构、卓越的长视频生成能力、高效的推理性能,以及通过多奖励强化学习人类反馈(RLHF)实现的强大效果。

它用一个模型就统一了文本到视频(Text-to-Video)、图像到视频(Image-to-Video)、视频续写(Video-Continuation)、交互式生成(interactive generation )几大任务。

通过在视频续写任务上的预训练,它能生成分钟级别的长视频,同时保持高质量和时间上的一致性。

为了解决生成效率问题,模型采用了一种从粗到细的生成策略,结合模型蒸馏和稀疏注意力机制,将推理效率提升了超过10倍。

最终,通过精细的多奖励强化学习训练,LongCat-Video的性能达到了与顶尖闭源模型及领先开源模型相媲美的水平。

数据是一切的基石

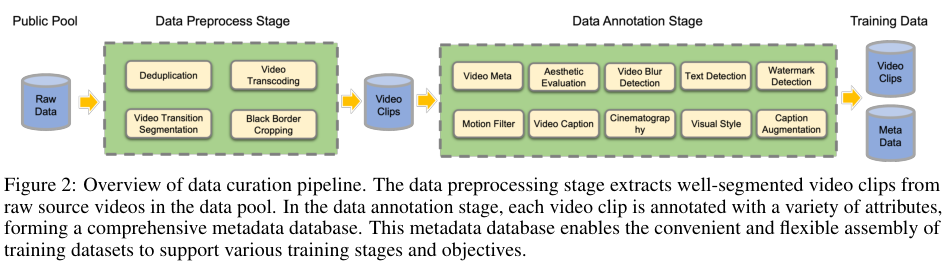

训练一个高质量的视频生成模型,离不开大规模、多样化且高品质的数据集。为此建立了一套全面的数据处理流水线。

一切从原始视频数据开始,从多个渠道收集海量视频。利用源视频的ID和MD5哈希值,确保了数据源的纯净,避免了冗余内容对训练效率和模型效果的干扰。

原始视频往往很长,内容庞杂,不适合直接用于训练。团队使用开源工具PySceneDetect和自研的TransNetV2模型,将长视频精准地分割成内容连贯的短片。

这就像剪辑师将一部电影拆解成一个个独立的场景,保证了每个训练样本在内容上的一致性,这是训练出优秀视频模型的关键。

数据处理好之后,为每个视频片段打上了一系列标签,并构建了一个全面的元数据库。

这些标签涵盖了视频的基本元数据,如时长、分辨率、帧率、比特率;也包括了更高维度的美学评分、模糊度评分、文本覆盖度以及水印检测。

为了评估视频的动态性,还通过提取视频的光流来计算运动信息,这样就可以过滤掉那些画面几乎静止、缺乏动态感的片段。

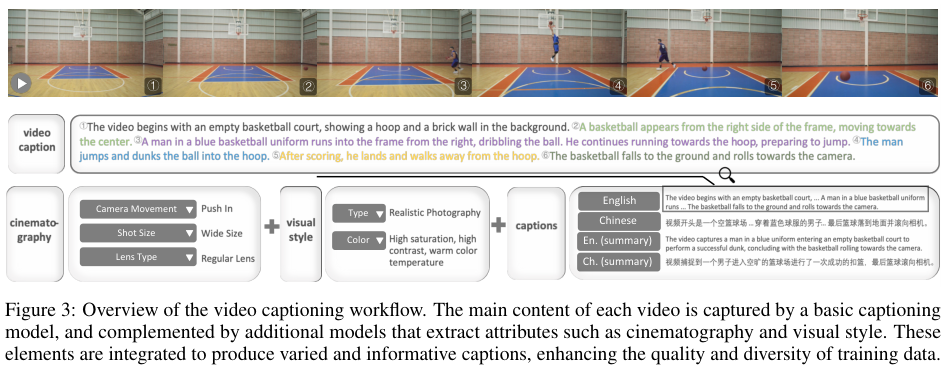

视频的字幕(Caption)必须与视频内容高度一致,才能让模型学会准确地听从指令。视频信息是复杂的,既包含静态的画面特征,也包含动作、事件等时间上的动态变化。许多模型擅长描述一张静态图片,却难以准确捕捉视频中的动作和时间关系。

为了解决这个问题,对视频信息进行了拆解,利用多个模型从不同维度为视频打标签。

一个基础的字幕模型负责捕捉视频的核心内容。在此基础上,使用内部构建的合成视频-文本数据对,对LLaVA-Video模型进行了微调,显著提升了它描述视觉和时间动态的能力。

数据集中时间动作相关标注的数量和质量,是提升模型时间理解能力的关键。为此收集了更多包含丰富时间事件的视频,并使用Tarsier2模型的标注数据进行微调,让模型更擅长描述和理解视频中的时间流变。

除了内容,视频的摄影手法和视觉风格也至关重要。摄影手法包括运镜(平移、倾斜、缩放等)、景别(远景、特写等)和镜头类型。

为了自动识别运镜,专门标注了一个数据集并训练了一个分类器。

景别和镜头类型的标注,采用了在图像分析上表现出色的Qwen2.5VL模型。视觉风格则涵盖了现实主义、2D动画、3D卡通等宏观类型,以及色彩基调等更细微的属性,同样利用Qwen2.5VL强大的图像理解能力来捕捉这些多样化的视觉特征。

为了让模型能处理各种各样的文本输入,还对视频字幕进行了丰富和增强。

他们将字幕在中英文之间互译,以支持双语生成;同时生成简洁的摘要,以实现字幕风格的多样化。最后通过从摄影和视觉风格库中随机抽取元素,与增强后的字幕进行组合,为每个视频片段都配上了风格多样的文本描述。

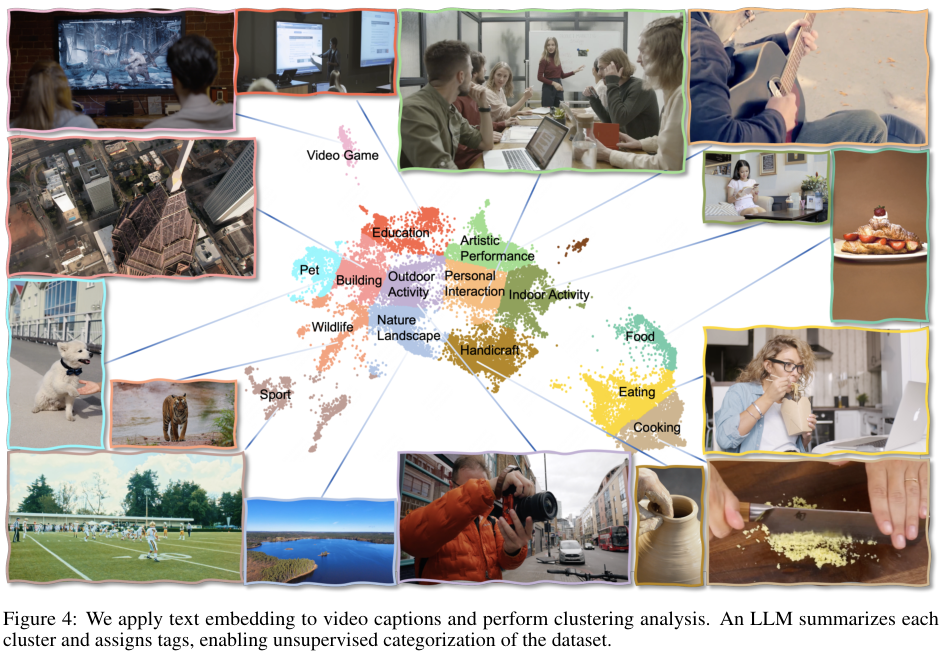

为了确保数据集的均衡性,团队将字幕文本转换为嵌入向量,并进行聚类分析,从而将视频片段无监督地划分为不同内容类别,如人际互动、艺术表演、自然景观等。

通过评估每个类别的数据量和分布密度,可以判断数据集是否均衡,并根据需要进行针对性的数据补充或重新平衡。

一个模型,三大任务

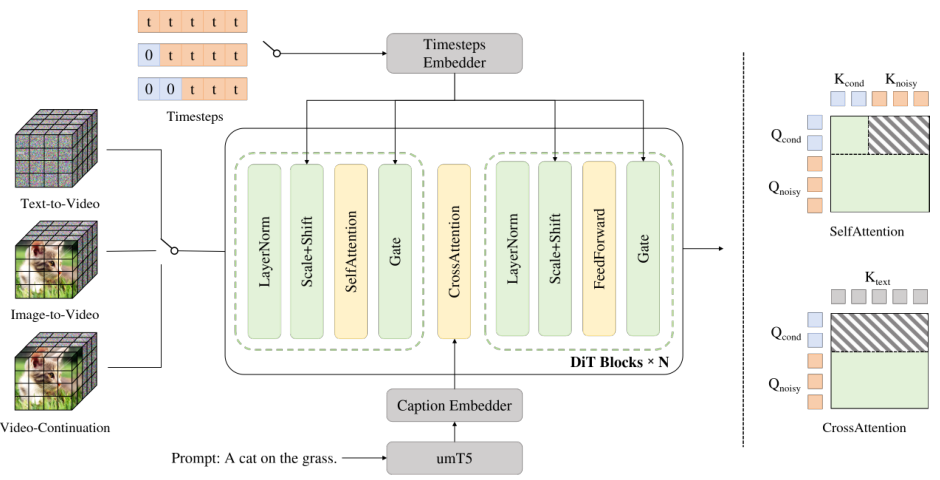

LongCat-Video采用了标准的扩散变换器(Diffusion Transformer, DiT)架构。

其核心是一个单流的变换器(Transformer)模块,每个模块都包含一个3D自注意力层、一个用于理解文本条件的交叉注意力层,以及一个前馈网络。

为了增强训练的稳定性,模型在自注意力和交叉注意力模块中都应用了RMSNorm进行归一化。

在处理视频数据时,模型首先使用WAN2.1 VAE(Variational Autoencoder, 变分自编码器)将视频像素压缩成更紧凑的潜在表示,压缩比在时间、高度和宽度维度上达到了4×8×8。

随后,DiT模型内部的patchify操作会进一步进行1×2×2的压缩。最终,从原始像素到模型处理的潜在表示,整体压缩比高达4×16×16。在文本理解方面,模型使用了umT5,这是一个支持中英双语的多语言文本编码器。

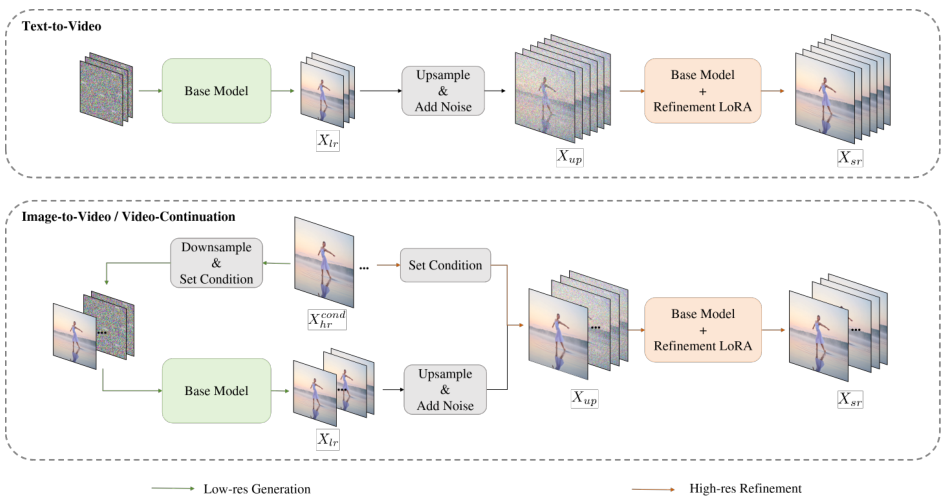

LongCat-Video最巧妙的设计之一,是用一个统一的框架来支持文本到视频、图像到视频和视频续写这三大任务。将所有这些任务都重新定义为视频续写:模型根据给定的、作为条件的初始帧,来预测未来的帧。

这三种任务的区别,仅仅在于提供的条件帧数量不同。

- 文本到视频:没有条件帧,模型从纯噪声开始生成。

- 图像到视频:提供一帧图像作为条件。

- 视频续写:提供多帧视频作为条件。

为了实现这种统一,模型的输入被设计成两个序列的拼接:一个是无噪声的条件帧序列Xcond,另一个是需要被去噪的噪声帧序列Xnoisy。

这两个序列在时间轴上连接起来,构成了模型的完整输入。

相应地,扩散过程中的时间步t也被分为两部分,条件帧的时间步tcond被固定为0,表示它们是清晰、无损的信息,而噪声帧的时间步tnoisy则在0到1之间采样。在计算损失时,模型只关心对噪声帧的去噪效果,条件帧的部分不参与计算。

为了配合这种输入表示,设计了一种特殊的块注意力机制。

在这种机制下,条件帧的更新只依赖于它们自身,不受噪声帧的影响。在交叉注意力计算中,条件帧也不参与。

这意味着,与条件帧相关的计算是固定的,可以将它们的键(Key)和值(Value)特征(即KV特征)缓存起来,在所有的采样步骤中重复使用,而无需重新计算。

这种KV缓存(KVCache)机制在保证训练和推理一致性的同时,极大地提升了长视频生成的效率。

用多奖励强化学习精雕细琢

基础模型训练完成后,还需要通过精加工来进一步提升其性能,使其输出更符合人类的偏好。LongCat-Video采用了一种名为组相对策略优化(Group Relative Policy Optimization, GRPO)的强化学习方法,并针对视频生成的特点进行了一系列创新。

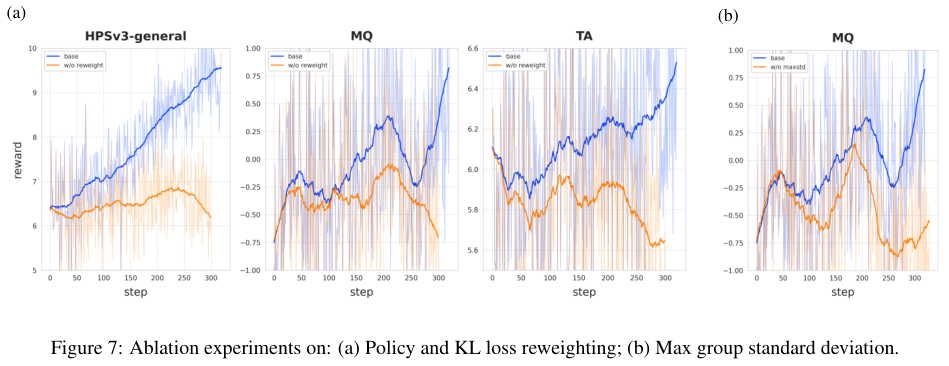

GRPO虽然在语言模型和图像生成中取得了成功,但应用到视频生成上却面临收敛慢、优化难的挑战。

在流匹配(Flow Matching)的框架下,GRPO本质上是在用随机噪声来模拟奖励函数对生成速度的梯度。基于这个发现,团队设计了多项改进策略。

为了解决奖励信号归因模糊的问题,修改了采样方案。

对于每个提示词,模型生成的一组样本会共享相同的初始噪声,并从前T'个时间步中随机选择一个关键时间步t。只有在这个关键时间步t,才使用带噪声注入的随机微分方程(SDE)采样,而其他时间步都使用确定性的常微分方程(ODE)采样。这就像在排查问题时进行控制变量实验,使得奖励的变化能够被精确地归因到某一个特定的步骤上。

视频生成模型通常在训练和推理中使用变化较大的时间步调度,这会导致梯度消失问题。为了解决这个问题,引入了一个重新加权的系数,有效地对梯度幅度进行了归一化。

在标准的GRPO中,每个提示词对应的一组样本会计算一个组内特定的标准差,用于归一化。用所有组中观察到的最大标准差来替换每个组自己的标准差。这种调整降低了那些优势估计可能不可靠的样本的梯度权重,保留了来自奖励分布更可靠的组的信号,使得训练过程对奖励模型的不准确性更加鲁棒。

利用了三个专门的奖励模型,分别从视觉质量(Visual Quality, VQ)、运动质量(Motion Quality, MQ)和文生视频对齐度(Text-Video Alignment, TA)三个维度进行优化。

- 视觉质量评估:使用HPSv3模型。结合了两种基于它的奖励,一种使用通用提示高质量图像来专门评估视觉质量,另一种使用视频字幕来评估图文一致性。

- 运动质量评估:使用基于VideoAlign的模型,并在内部标注的数据集上进行了微调。为了避免模型对特定颜色产生偏好,在训练和推理时都使用灰度视频,确保评估只专注于运动特征本身。

- 文生视频对齐评估:同样采用基于VideoAlign的模型,但在原始的彩色视频上进行微调,以保留模型评估文本和视频内容之间语义对应的能力。

在多奖励训练中,总的策略损失是各个奖励信号的加权和。

这种多奖励的组合为策略优化提供了全面的指导,更重要的是,多个奖励之间形成的相互约束,起到了一种自然的正则化效果,防止了模型为了迎合某一个单一指标而走火入魔(即奖励黑客攻击),比如过度追求视觉质量而牺牲了运动的自然性。

让高效生成成为可能

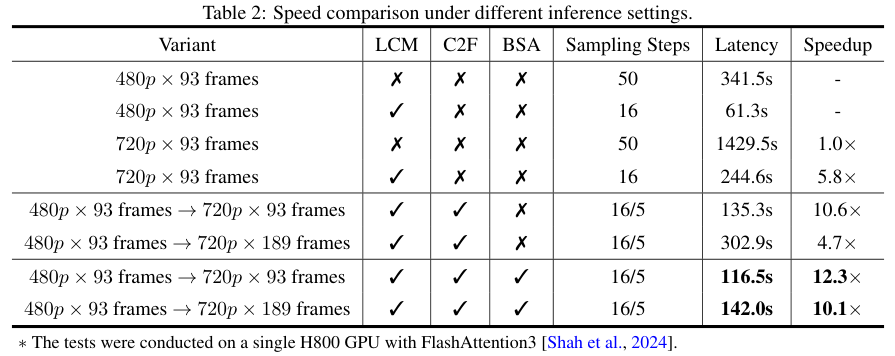

生成高分辨率、高帧率的视频,推理效率始终是一个巨大的挑战。LongCat-Video引入了多种优化策略,将生成效率提升了超过10倍,实现了在几分钟内生成720p、30帧每秒的视频。

核心策略是从粗到细(Coarse-to-Fine, C2F)的生成范式。

模型不再直接生成高分辨率视频,而是分两步走:首先,生成一个480p、15帧每秒的草稿视频;然后,使用三线性插值将这个视频上采样到720p、30帧每秒,再由一个专门的精炼专家模型对其进行细化。

这种方法不仅大幅提升了效率,还意外地增强了最终视频的图像质量和高频细节。

这个精炼专家是在基础模型之上,使用LoRA(Low-Rank Adaptation, 低秩适应)微调技术训练出来的。

由于精炼任务与基础模型的生成任务相似但去噪路径不同,LoRA允许模型在重用基础模型已有能力的同时,高效地适应新任务。这种方式与其他训练阶段解耦,收敛更快,也显著减少了内存占用。

在精炼阶段,同样利用了流匹配来建模从上采样的低分辨率视频到高清视频的转换过程。

精炼过程对上采样后的视频施加了中等水平的噪声,以此作为的起点。在实践中,精炼阶段只需要5个采样步骤,极大地提升了效率。

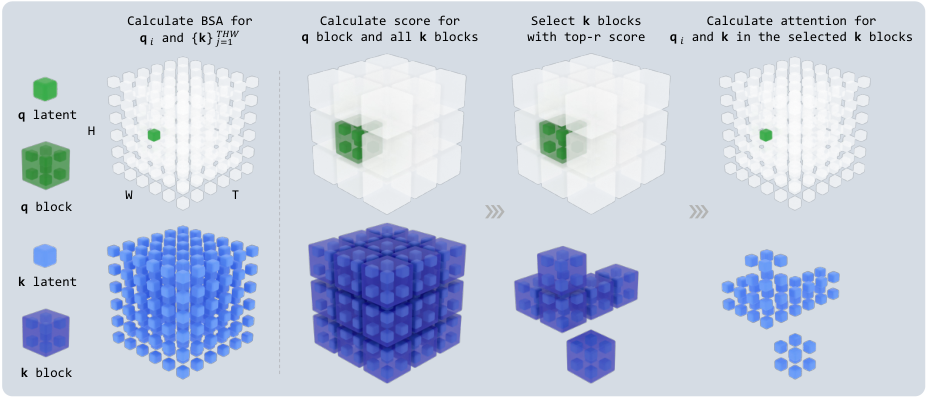

考虑到视频潜在表示中存在大量冗余信息,团队开发了一种可训练的块稀疏注意力(Block Sparse Attention, BSA)算子。

将查询(Query)和所有的键(Key)都划分成不重叠的3D块。

对于每个查询块,计算它与其他所有键块的相似度,然后只选择最相似的top-r个键块进行标准的注意力计算。这样,模型就无需关注视频中的所有细节,而只聚焦于最相关的部分。

通过只保留不到10%的原始计算负载,实现了近乎无损的生成质量。

团队还将这个3D块稀疏注意力的实现(包括前向和反向传播)与基础模型一起开源,方便社区在自己的项目中使用。

严谨的训练流程

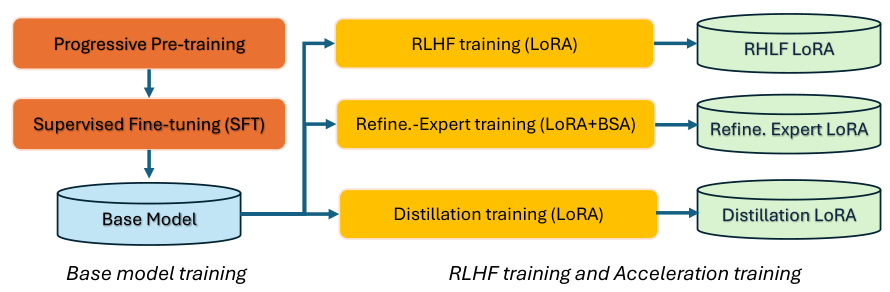

LongCat-Video的训练,包括基础模型训练、RLHF训练和加速训练三个主要部分。

训练从基础模型开始,采用了流匹配框架和渐进式预训练策略。模型首先在低分辨率的图像上进行预训练,高效地学习语义和视觉表示。

当图像训练收敛后,再过渡到视频训练,捕捉基本的运动动态。

随后,训练进入多任务阶段,联合优化文本到图像、文本到视频、图像到视频和视频续写等多个任务。

这些阶段从低分辨率逐步过渡到高分辨率。在每个阶段,训练样本被分配到不同尺寸的桶中,以最大化计算效率。

预训练之后是监督微调(Supervised Fine-Tuning, SFT)阶段。使用了一个经过精心筛选的高质量数据集,和专门的数据集来增强模型对运镜和视觉风格等指令的遵循能力。

RLHF训练阶段,使用前面介绍的GRPO方法和多个视频质量奖励,对基础模型进行精调。有趣的是,团队发现在GRPO训练中只使用文本到视频任务,其在指令遵循、视觉和运动质量上的提升,能够很好地泛化到图像到视频和视频续写任务上。

加速训练阶段,团队对模型进行了蒸馏,并训练了用于从粗到 fine生成的精炼专家模块。

蒸馏结合了无分类器指导(Classifier-Free Guidance, CFG)蒸馏和一致性模型(Consistency Model, CM)蒸馏,使得16步推理的质量就能媲美50步以上的效果。

LongCat-Video作为一个拥有136亿参数的基础视频生成模型,通过统一的架构、创新的多奖励RLHF训练,以及高效的生成策略,在多种视频生成任务上,尤其是在高质量长视频的生成方面,展现了卓越的性能和巨大的潜力。

开源视频生成目前几乎是wan2.2一统天下,美团的LongCat-Video能否打破格局?