我们都知道 LLM 中存在结构化稀疏性,但其底层机制一直缺乏统一的理论解释。为什么模型越深,稀疏性越明显?为什么会出现所谓的「检索头」和「检索层」?

我们非常荣幸地宣布,我们试图回答这些问题的论文 UNCOMP 已被 EMNLP 2025 主会接收!我们不仅提出了一个高效的推理框架,更重要的是,我们提供了一个全新的理论视角来理解 LLM 内部的信息动态。

论文标题:UNComp: Can Matrix Entropy Uncover Sparsity? -- A Compressor Design from an Uncertainty-Aware Perspective

论文地址:https://arxiv.org/abs/2410.03090

GitHub:https://github.com/menik1126/UNComp

🔬 核心洞察:一个关于熵的悖论与新解

传统的矩阵熵 (Matrix Entropy) 分析存在一个悖论:它显示信息熵随着层数加深是逐层增加的。这与我们观察到的「模型越深越稀疏」的现象相矛盾。如果信息在不断累积,又何来稀疏一说?🧐

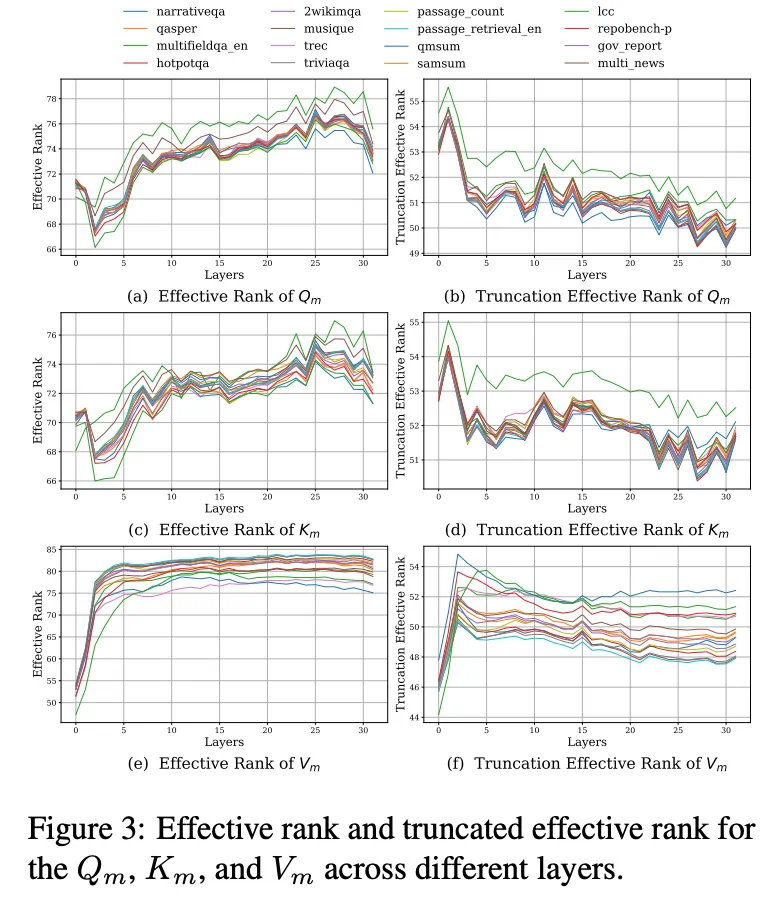

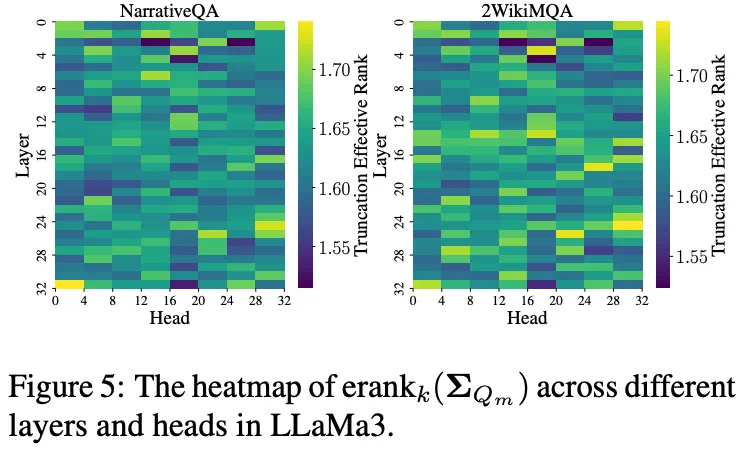

我们的关键突破在于引入了截断矩阵熵 (Truncated Matrix Entropy)。通过分析 Token 矩阵协方差奇异值分布的「拐点」,我们只关注最重要的主成分。惊人的发现是:

✨ 截断矩阵熵随着层数加深,呈现出明显的逐层递减趋势!

这不仅完美解释了深层网络的稀疏化现象,也为我们的压缩策略提供了坚实的理论基础。熵的减少意味着信息变得更加集中和稀疏,为压缩创造了空间。

🌊 从理论到实践:信息流的指引

这个理论工具让我们能「看透」模型的内部运作:

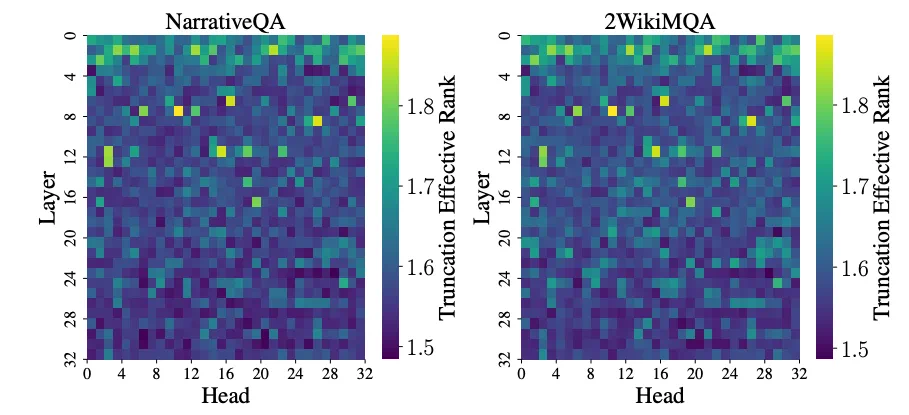

识别关键结构:中间层信息熵的异常波动点,精准地对应了负责信息聚合的检索层 (Retrieval Layers)和负责长程记忆的检索头 (Retrieval Heads)。我们不再是盲目压缩,而是有理论指导的结构化剪枝。

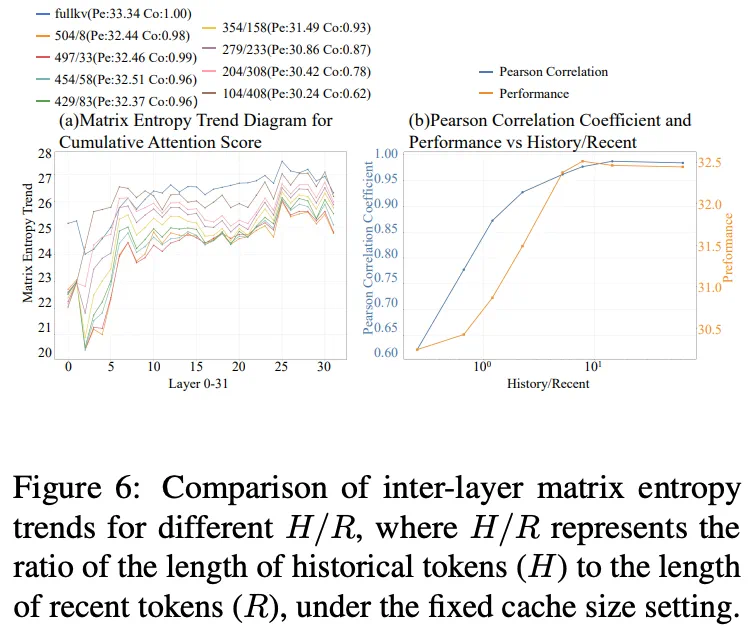

最优压缩的奥秘:我们进一步分析发现,最佳的压缩性能和最终的准确率的权衡并非来自于寻找最优的累计注意力分布,而是来自于对「信息流模式」的模仿。我们用皮尔逊相关系数证明:当压缩后 KV Cache 的逐层熵变趋势,与原始全尺寸 Cache 的趋势高度相似时,模型性能最好。 这意味着,我们的压缩策略成功地保留了模型原有的信息压缩模式。

Group Query Attention 结构中呈现出明显的头共享的稀疏模式。

🚀 首创:从隐藏状态压缩到 KV Cache 优化

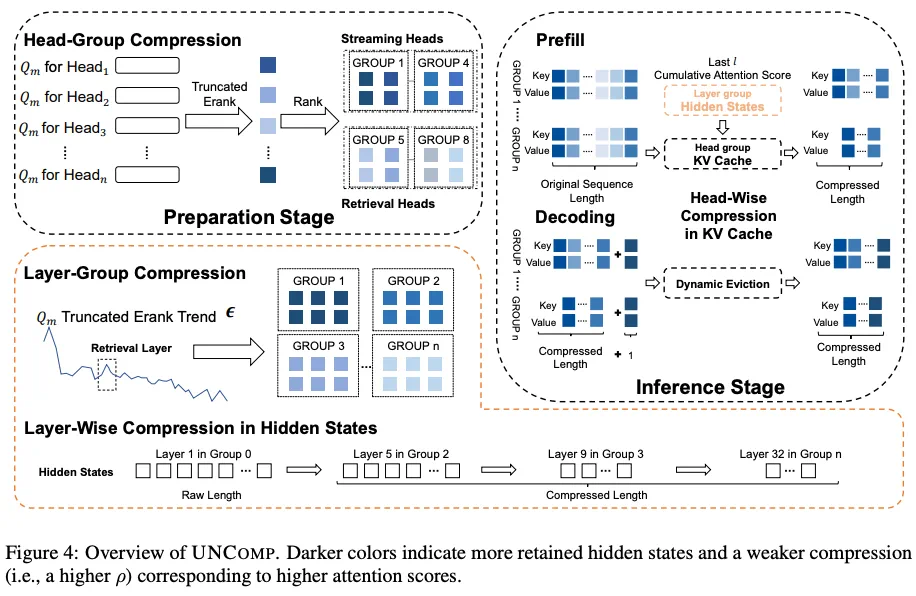

基于以上理论,我们设计了 UNCOMP 框架,并首次通过直接压缩 Prefill 阶段的隐藏状态,来间接优化 KV Cache,实现了计算与内存的联合优化。

层级压缩 (Layer-wise): 在 Prefill 阶段压缩隐藏状态,加速计算。

头级压缩 (Head-wise): 在 Decoding 阶段压缩流式头的 KV Cache,保留检索头,节省内存。

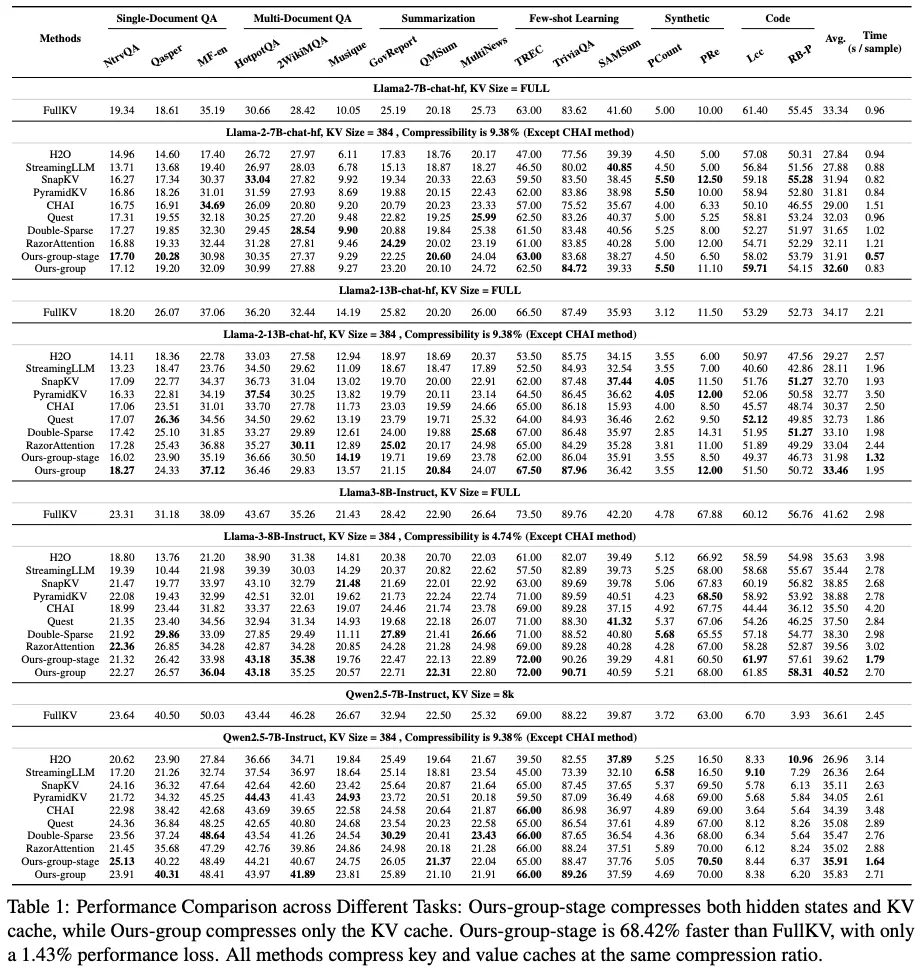

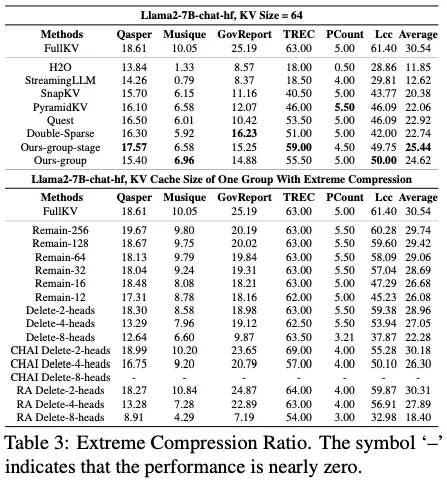

📊 实验结果亮点

Prefill 阶段加速60%

吞吐量提升6.4倍

KV Cache 压缩至4.74%

极端压缩率下依旧保证模型的性能

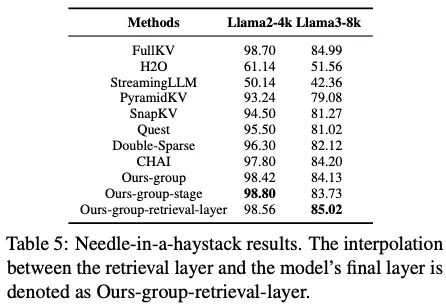

通过合并检索层和最后的层大海捞针性能几乎无损,在特定任务上超越全尺寸基线。

我们相信,UNCOMP 不仅是一个工具,更是一扇窗口,帮助我们理解 LLM 内部复杂的信息压缩行为。

欢迎大家深入探讨、引用和 star!