AIxiv专栏是AI在线发布学术、技术内容的栏目。过去数年,AI在线AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:[email protected];[email protected]

本文共同一作为葛俊岐 (清华大学本科生),陈子熠 (清华大学本科生),林锦涛 (香港大学博士生),祝金国 (上海 AI Lab 青年研究员)。本文的通讯作者是朱锡洲,他的研究方向是视觉基础模型和多模态基础模型,代表作有 Deformable DETR、DCN v2 等。

随着语言大模型的成功,视觉 - 语言多模态大模型 (Vision-Language Multimodal Models, 简写为 VLMs) 发展迅速,但在长上下文场景下表现却不尽如人意,这一问题严重制约了多模态模型在实际应用中的潜力。

为解决这一问题,清华大学,香港大学和上海 AI Lab 联合提出了一种新的用于多模态大模型的位置编码方法 ——Variable Vision Position Embedding (V2PE) ,取得多模态大模型在长上下文场景下的新突破。

论文地址:https://arxiv.org/abs/2412.09616

项目主页:https://zzdhybthu.github.io/V2PE.github.io/

开源代码:https://github.com/OpenGVLab/V2PE

位置编码是多模态大模型中的关键技术,用于让模型理解输入序列的相对位置关系。它使得 VLMs 能够理解词语在句子中的位置,并识别图像块在原图中的二维位置。然而,现有的多模态模型通常在图像 token 上沿用文本模型的位置编码方式,这并非最优方案。

V2PE 提出了一种为视觉 token 分配可变位置增量的新方法,有效解决了传统位置编码在处理超长上下文任务时的性能瓶颈问题。通过避免位置编码超出模型训练上下文窗口的限制,V2PE 显著提升了模型在 32K 至 1M 长度超长上下文任务中的表现。相比传统位置编码的模型,采用 V2PE 的模型在这些任务中实现了突破性改进,甚至超越了最先进的闭源大模型。

V2PE 工作有以下贡献:

构建了一个用于 VLMs 长上下文训练和评估的混合数据集。研究团队通过这一数据集发现,直接将 LLM 的位置编码机制应用于视觉 token 是次优选择。

提出了可变视觉位置信息编码 (V2PE),一种创新的位置编码策略,通过为视觉 token 分配可变且较小的增量,大幅提升了 VLMs 对长多模态上下文的理解和推理能力。

将 V2PE 方法和扩展训练数据应用于开源视觉模型 InternVL2-2B, 微调后的模型在统一多模态基准测试和长上下文多模态任务中表现优异,成功处理长达 1M token 的序列,展现了卓越的长上下文处理能力。

可变视觉位置编码

突破视觉 - 语言模型在长上下文场景中的新边界

在人工智能领域,视觉 - 语言模型 因其在多模态任务中的出色表现而备受关注。然而,在处理视频、高分辨率图像或长篇图文文档等长上下文场景时,其泛化能力却显著下降,这限制了它们在实际应用中的潜力,并影响了用户体验的进一步提升。

V2PE 旨在解决的核心问题在于:为什么 VLMs 在长上下文场景下表现不佳,以及如何提升它们在长序列多模态理解与推理上的能力?

为了研究 VLMs 为什么在长上下文场景表现不佳,研究团队通过构建大规模的长上下文多模态数据集,系统地评估和分析 VLMs 的能力,在这一过程中,他们意识到位置编码策略在 VLMs 的性能中起着至关重要的作用。

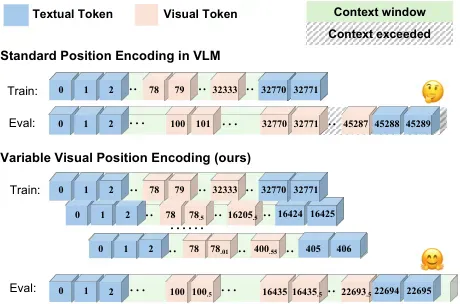

传统的 VLMs 位置编码通常不区分文本 token 和图像 token,并在训练中使用固定的编码规则。然而,文本 token 属于一维数据,位置编码仅需传达先后顺序;图像 token 则为二维数据,位置编码需传递图像块的空间位置信息,还要考虑多分辨率下缩略图与子图像块的对应关系。此外,当模型处理超出训练上下文窗口的长序列时,固定位置编码会超出模型已知范围,导致推理能力受限。

因此,作者提出了 Variable Visual Position Encoding (V2PE),这是一种新颖的位置编码方法,专门针对视觉 - 语言模型(VLMs)中的长上下文场景。V2PE 通过为视觉 token 分配更小的、可变的位置增量,有效地管理长多模态序列。

增强的长上下文多模态数据集

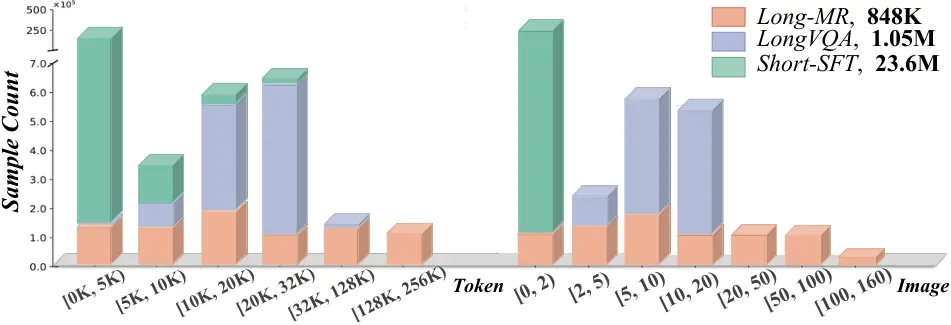

作者引入了两个增强的长上下文多模态数据集:Long Visual Question Answering (Long-VQA) 和 Long Multimodal Retrieval (Long-MR)。旨在提升 VLMs 的长上下文能力并建立评估框架。

Long-VQA 数据集扩展了 17 个被广泛采用的数据集,将内容从短序列扩展到包含高达 32K token 的序列。任务涵盖常识推理、事实知识和解释文本和视觉信息。

Long-MR 数据集受多模态大海捞针 benchamrk -- MM-NIAH 的启发,通过在交错的文本图像中检测目标图像或段落,评估 VLMs 处理超长上下文的能力。

可变视觉位置编码

位置编码在视觉 - 语言模型中的作用

位置编码是 Transformer 架构中的基本组成部分,它通过为 token 提供位置信息来捕获序列关系。位置编码通常涉及两个步骤:位置索引推导 和位置嵌入计算

和位置嵌入计算 。

。

位置索引推导:为每个 token

分配位置索引

分配位置索引 。

。位置嵌入计算:将这些索引转换为影响注意力机制的位置嵌入。

可变位置索引推导

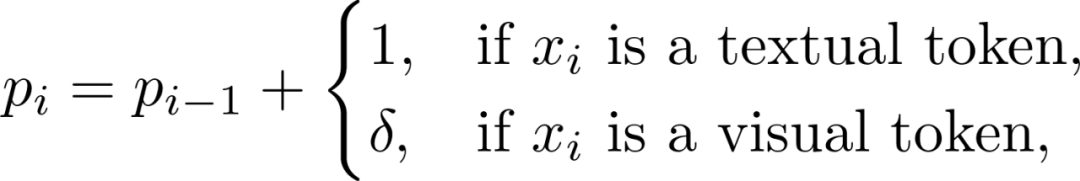

作者提出了一种针对模态特定的递归函数,为文本和视觉 token 分配不同的位置索引:

其中 是一个小于 1 的增量,用于减少视觉 token 的位置索引增加速率。在训练过程中,

是一个小于 1 的增量,用于减少视觉 token 的位置索引增加速率。在训练过程中, 可以从一组分数值中动态选择,以适应不同的输入长度和复杂性。

可以从一组分数值中动态选择,以适应不同的输入长度和复杂性。

这种方法与传统的长上下文方法相比具有几个优势:

1. V2PE 保留了 VLMs 中的所有视觉 token,保留了视觉内容的丰富性和细节。

2. V2PE 允许 VLMs 通过在训练期间动态选择 来适应任意间隔的位置索引,避免了位置编码外推引起的不准确。

来适应任意间隔的位置索引,避免了位置编码外推引起的不准确。

长上下文能力显著提升

经过一系列的实验和分析,研究团队取得了显著的成果。通过引入 Variable Visual Position Encoding (V2PE) 和增强的长上下文多模态数据集,研究团队得到了以下几个重要的发现:

对模型上下文能力的影响

对模型上下文能力的影响

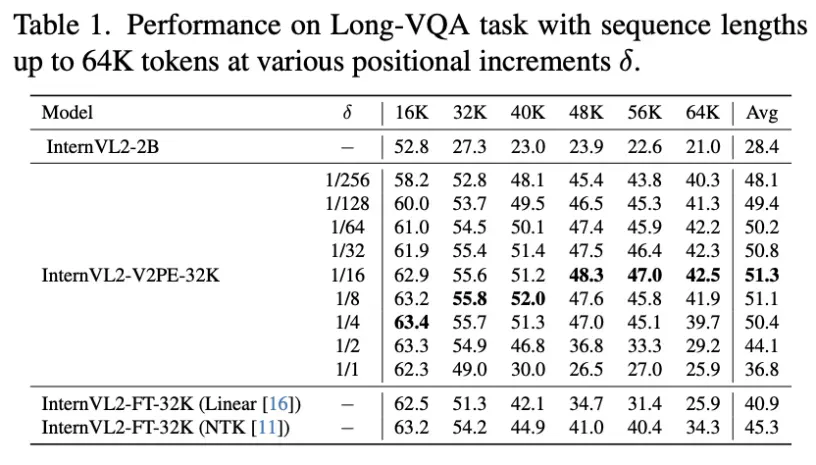

在上下文长度 32k 以内的数据上训练模型,在 64k 以内,多种长度的基准测试上进行测试。实验的结果表明,在测试长度超出训练的上下文长度时,模型效果会显著下降,但选用更小的增量 可以有效缓解这一现象。

可以有效缓解这一现象。

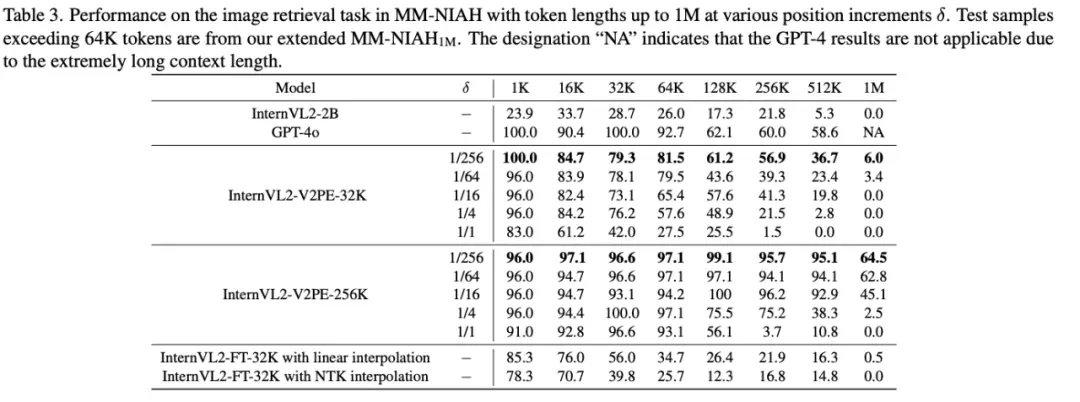

在 1M 上下文长度下的表现提升

作者分别在 32k 和 256k 的训练数据上微调模型,并在长达 1M 的多种上下文长度上进行测试。实验结果表明,V2PE 在长上下文场景下的表现明显优于不加 V2PE 的模型,也优于使用插值方法的模型,甚至能超越先进的闭源大模型。

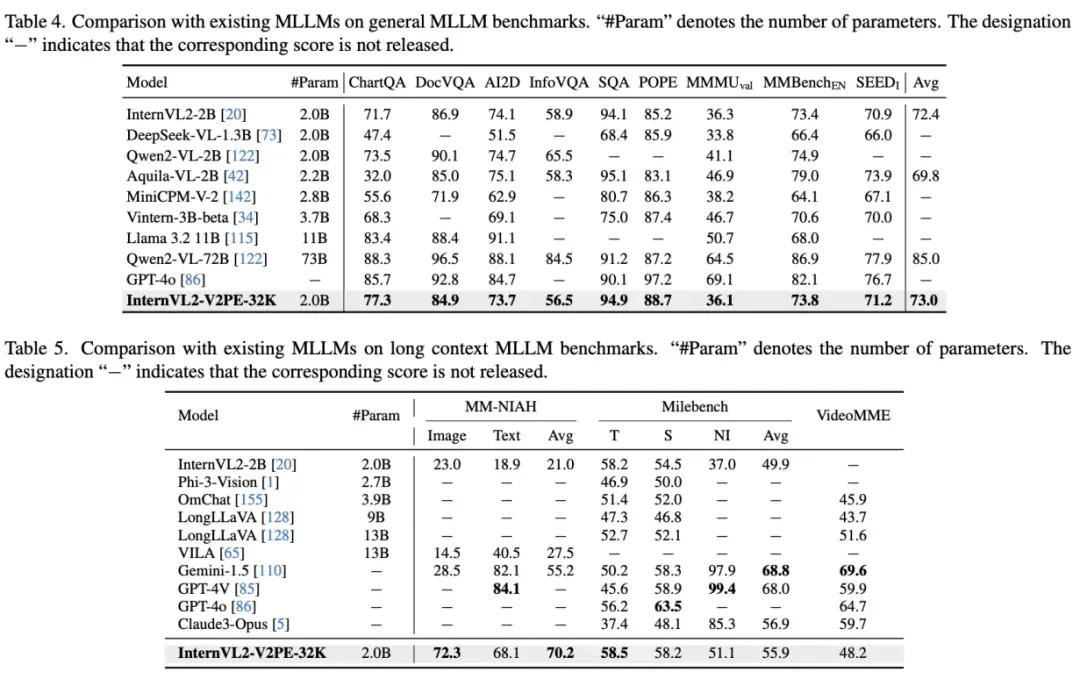

此外,作者将训练好的 V2PE 模型与其他视觉 - 语言模型在多种基准测试进行了对比,结果表明,V2PE 在长上下文多模态任务上的表现优于其他模型,证明了 V2PE 的有效性。

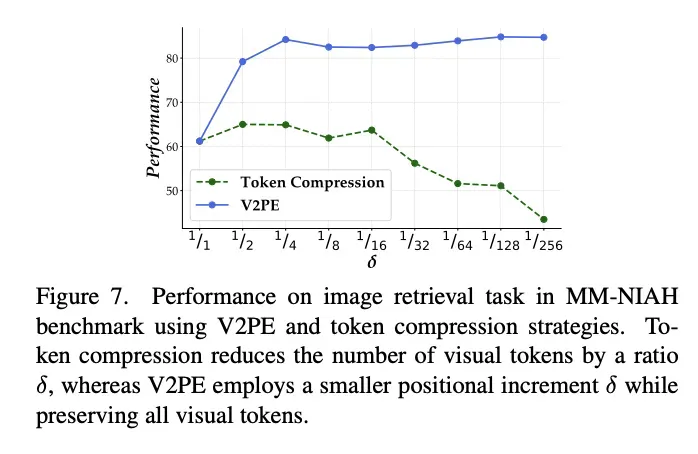

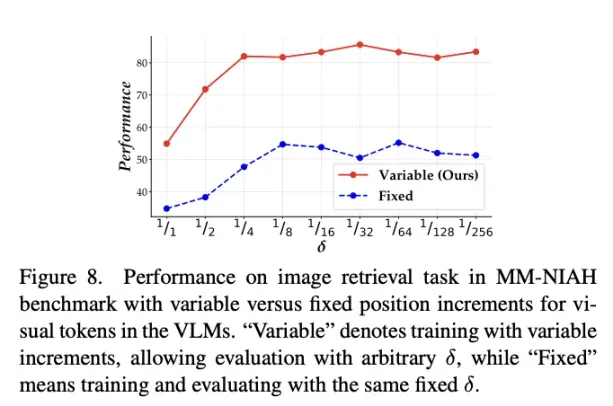

消融实验中,作者将 V2PE 方法与 token 压缩的方法以及在训练时固定视觉 token 的位置编码增量的方法进行了对比,证明了 V2PE 的优势。

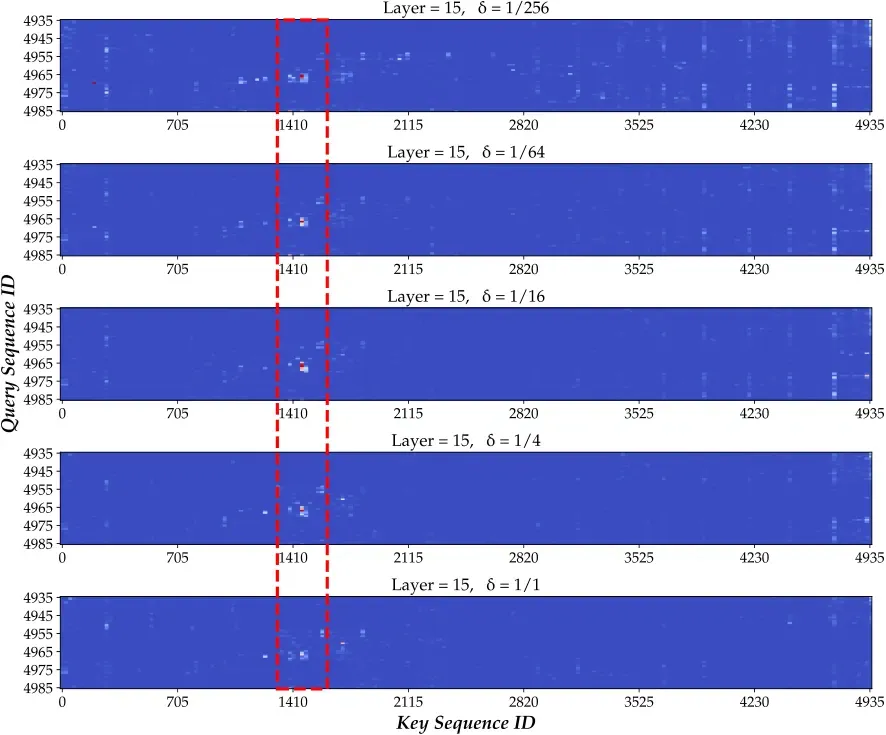

在对注意力图的分析中,作者关注注意力图的尾部,即对应序列末端的问题部分的注意力图。作者发现,随着 的减小,模型能更好地把注意力集中在问题对应的答案附近,证明了 V2PE 能够有效地提升模型将注意力对齐到输入序列中的关键部分的能力。

的减小,模型能更好地把注意力集中在问题对应的答案附近,证明了 V2PE 能够有效地提升模型将注意力对齐到输入序列中的关键部分的能力。

V2PE 的提出,为视觉 - 语言模型在长上下文场景下的表现提供了新的思路。通过为视觉 token 分配可变的位置增量,V2PE 有效地解决了位置编码超出模型训练上下文窗口的问题,提升了模型在长上下文场景下的表现。

作者相信,V2PE 的提出将为视觉 - 语言模型的发展带来新的机遇,为模型在长上下文多模态任务中的应用提供更多可能性。