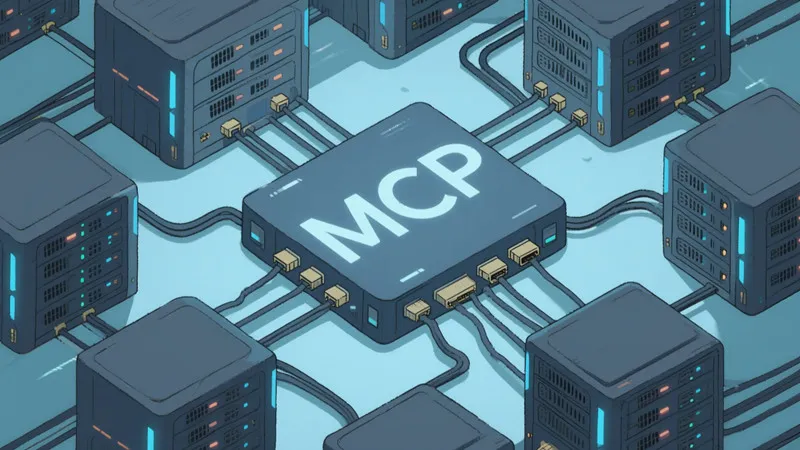

在微软 Build2025大会上,GitHub 及其母公司微软宣布加入 MCP(模型连接协议)指导委员会。MCP 是由人工智能公司 Anthropic 提出的标准,旨在更好地将 AI 模型与数据存储系统连接起来。这一消息标志着 MCP 在 AI 行业的影响力持续增长,早些时候,OpenAI 和谷歌也曾表示将支持这一标准。

图源备注:图片由AI生成,图片授权服务商Midjourney

MCP 的核心功能是允许 AI 模型从各种数据源中获取信息,以完成特定任务。这些数据源包括商业工具、软件、内容库以及应用开发环境等。通过 MCP 协议,开发者可以构建数据源与 AI 应用(例如聊天机器人)之间的双向连接。这意味着开发者可以通过 “MCP 服务器” 向外界提供数据,并创建 “MCP 客户端”,如应用程序和工作流程,以便在需要时与这些服务器进行连接。

微软和 GitHub 表示,将在他们的各个平台和服务中提供全面的 MCP 支持,包括 Microsoft Azure 和 Windows11。预计在未来几个月内,Windows 系统将会实现 MCP 集成,使开发者能够将应用的功能暴露给支持 MCP 的 AI 模型。微软在相关材料中指出,开发者将能够将所需的功能和能力封装在应用中,作为 MCP 服务器来提供服务,包括 Windows 系统功能,如文件系统、窗口管理以及 Windows 子系统等。

在安全性方面,微软表示其身份和安全团队与 Anthropic、MCP 指导委员会及更广泛的 MCP 社区合作,设计了一套更新的授权规范。这项规范允许 MCP 连接的应用更安全地访问 MCP 服务器,从而使用户可以使用 “可信的登录方式” 来授予 AI 应用访问数据和服务的权限,包括个人存储驱动器和订阅计划。

与此同时,GitHub 也与 MCP 指导委员会共同设计了一个注册服务,用于 MCP 服务器。该服务允许开发者实现公共或私有的 MCP 服务器条目集中式存储库,促进各种 MCP 实现及其配置的发现与管理。

划重点:

🌐 GitHub 与微软加入 MCP 标准的指导委员会,推动 AI 模型与数据源的连接。

🔗 MCP 协议使得开发者能构建双向连接,支持多种数据源与 AI 应用的交互。

🔒 微软更新授权规范,确保 MCP 连接的安全性,同时 GitHub 推出 MCP 服务器的注册服务。