在人工智能领域,视觉语言模型(VLM)近年来取得了显著进展,尤其是在二维视觉理解方面。随着这一领域的不断发展,研究人员们开始将目光投向3D 场景理解。然而,由于高质量空间数据的稀缺和静态视角假设的限制,现有的3D VLM 往往难以进行有效的推理和泛化。为了解决这些挑战,研究团队近日发布了名为3D-R1的新型基础模型。

3D-R1的核心创新在于通过高质量的合成数据集、强化学习以及动态视图选择的引入,显著提升了3D 场景理解的推理能力和泛化能力。研究人员利用现有的3D-VL 数据集及基于 Gemini2.5Pro 的数据引擎,构建了一个名为 Scene-30K 的高质量合成数据集。这一数据集为3D-R1提供了强有力的冷启动初始化数据。

在强化学习的训练过程中,3D-R1引入了多种奖励函数,包括感知奖励、语义相似性奖励和格式奖励,旨在提升模型的推理能力,同时确保检测的准确性和答案的语义精度。此外,3D-R1采用了一种动态视图选择策略,能够自适应选择对3D 场景理解最有参考价值的视角。

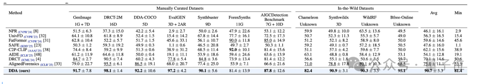

通过一系列实验,3D-R1在多项3D 场景基准测试中平均提升了10%,证明了其在增强3D 场景理解推理和泛化能力方面的有效性。研究团队表示,3D-R1的发布标志着3D 视觉语言模型研究的一个重要里程碑,为未来的相关研究和应用奠定了坚实的基础。

地址:https://huggingface.co/papers/2507.23478