上周在一个技术交流会上,听到两位技术总监争得面红耳赤。一位坚持说RAG就够了,简单高效还省钱;另一位则认为不微调根本做不出专业应用。

这场争论让我想起很多企业在落地AI项目时的迷茫:到底该选哪条路? 其实这个问题本身就暴露了一个认知误区。

RAG和微调从来不是二选一的单选题,而是要看你想解决什么问题。就像医生开药,头疼和胃疼用的方子能一样吗?

先搞清楚它们到底在干什么

有个做金融科技的朋友跟我抱怨,他们公司花了大价钱微调了一个模型,结果每次监管政策更新,就得重新训练一遍。

两个月后他们改用RAG方案,新政策直接扔进知识库,第二天就能用。

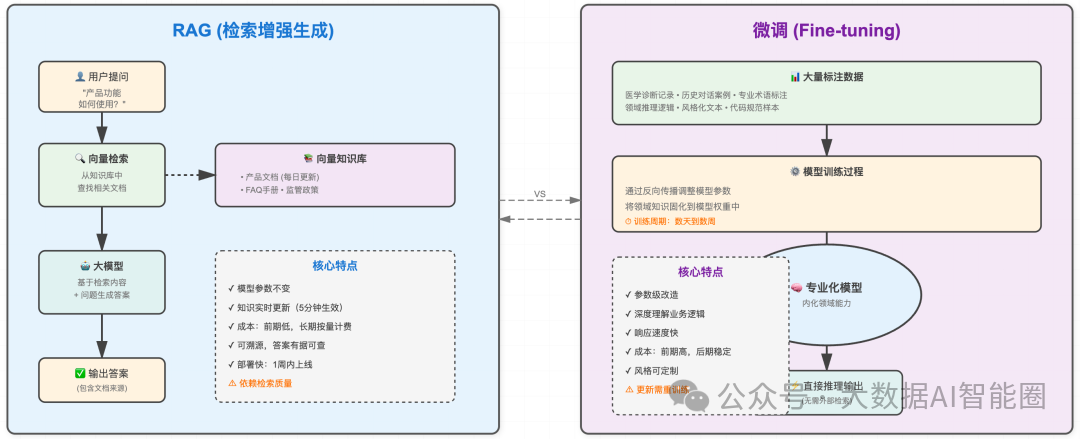

这个案例很典型。RAG的工作原理说白了就是给模型配了个外挂搜索引擎。用户问问题时,系统先去向量数据库里找相关文档,然后把找到的内容和问题一起给模型,让它基于这些材料回答。整个过程模型本身一个参数都没变。

这种方式最大的优势是灵活。

我见过一家电商公司,产品库每天更新几百个SKU,用RAG做的客服系统,新品上架五分钟后就能准确回答用户咨询。换成微调的话,这种频率根本扛不住。

再说微调。它是真的在改造模型的内在能力。通过大量标注数据训练,让模型把特定领域的知识和思维方式刻进参数里。这就像是让一个人真正学会一门手艺,而不是拿着说明书照着做。

我认识一位做医疗AI的架构师,他们给诊断助手做微调时,不只是灌医学知识,更重要的是训练模型学会医生的临床思维。

比如看到某几个症状组合,会自动往特定方向追问,这种推理模式是RAG做不到的。

成本上也有意思。RAG前期投入小,搭个系统可能一周就能跑起来。但它是个长期消耗品,每次查询都要调用检索和生成,访问量大了账单也不少。

微调恰好相反,前期需要GPU资源和数据标注的重投入,但训练完成后推理成本相对固定。有家做ToB产品的公司算过账,用户量超过五万后,微调方案反而更经济。

场景才是决定技术的关键

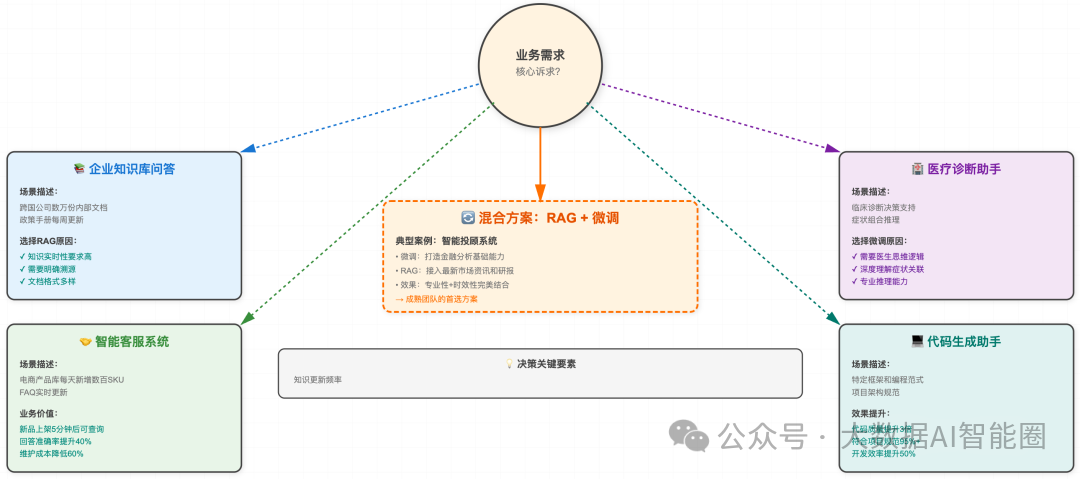

前段时间帮一家制造企业做技术选型咨询。

他们有两个需求:一是建立设备维修知识库,二是优化生产调度算法建议。

我直接建议第一个用RAG,第二个必须微调。

为什么?

维修知识库的特点是内容多、更新快、需要溯源。老师傅的维修笔记、设备厂商的最新手册、历史故障案例,这些资料每周都在增加。用RAG的话,技术人员上传文档后立刻就能被检索到。而且系统可以明确告诉维修工,这个方案来自哪份文档的第几页,增强可信度。

但生产调度就不一样了。它需要的不是查资料,而是理解生产线的复杂约束,学会平衡效率、成本、交期的权衡逻辑。这种深层次的业务理解,必须通过微调把历史调度数据的规律固化到模型里。

RAG只能告诉你文档里写了什么,微调才能让模型真正学会怎么做决策。

法律行业也有类似的分化。

智能检索用RAG没问题,输入案情关键词,系统从海量判例库里找出相关案件。但如果要做诉讼策略建议,就得微调。因为优秀律师的价值不在于记住多少法条,而在于理解案件的细微差别,预判法官的思路,这需要模型具备真正的专业判断力。

代码生成领域更明显。GitHub Copilot早期版本主要靠预训练模型,效果一般。后来针对各种编程语言和框架做了大量微调,生成代码的质量才有了质的飞跃。它学会了不同语言的惯用写法,理解了项目结构的最佳实践。这种能力是通过RAG检索代码片段拼凑不出来的。

我观察到一个趋势:很多成熟团队在走混合路线。

先微调一个具备领域基础能力的模型,再用RAG补充实时知识。有家做智能投顾的公司就是这么干的,用微调让模型学会金融分析的基本功,用RAG接入最新的市场资讯和研报。两者配合,既专业又及时。

落地时的真实挑战

理论说得再漂亮,落地时总会遇到各种坑。

一位做过多个项目的技术负责人跟我分享了他的踩坑经历:

RAG最大的问题是召回质量。

他们做企业知识库时发现,同一个问题换个问法,检索出来的文档可能完全不同。

后来花了大力气优化向量模型和切片策略,才把准确率提上去。

还有个容易忽视的点是知识库的维护成本,文档格式五花八门,清洗和结构化处理比想象中麻烦。

微调的坑更隐蔽。

数据质量直接决定效果,但高质量标注数据往往非常稀缺。

他们给客服机器人做微调时,发现真正有价值的对话案例可能只占总量的百分之十。而且微调容易过拟合,在训练集上表现完美,一到真实场景就翻车。需要反复调整数据配比和训练策略。

还有个现实问题是团队能力。

RAG对工程能力要求高,需要搞定向量数据库、检索优化、Prompt工程这一套。微调则需要懂算法调优、数据工程、模型评估的人。很多中小企业其实两方面的人才都缺,这时候可能先用商业化的RAG方案起步更靠谱。

结语

回到开头那个争论。两位技术总监其实都没错,只是站在各自业务场景的角度得出了不同结论。

RAG的灵活性和微调的专业性,本质上服务于不同层次的需求。

如果你的核心痛点是知识频繁更新、需要溯源、预算有限,RAG是更合理的选择。如果你要打造深度行业能力、追求极致性能、用户量足够支撑成本,微调值得投入。

更多时候,聪明的做法是混合使用,让两种技术各自发挥所长。

技术选型没有银弹。重要的是搞清楚业务本质需求,评估团队能力边界,算清楚长期账本。那些真正把AI用起来的企业,都是在这些务实维度上做对了决策。工具再好,用错了场景也是浪费。

用对了,才能真正释放价值。