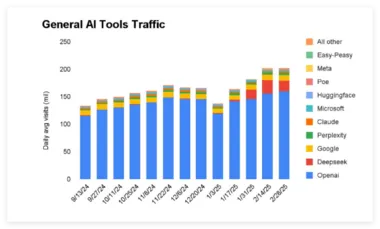

在人工智能领域,UCLA 和 Meta AI 的研究人员联合推出了一种名为 d1的新框架,该框架通过强化学习技术显著提升了扩散式大语言模型(dLLMs)的推理能力。虽然传统的自回归模型如 GPT 受到了广泛关注,但 dLLMs 凭借其独特的优势,若能加强推理能力,将为企业带来新的效率和应用前景。

扩散式语言模型与自回归模型的生成方式截然不同。自回归模型如 GPT-4o 是通过逐个预测后续词元生成文本。而扩散式语言模型最初应用于图像生成,例如 DALL-E2和 Midjourney,其核心思想是逐步向图像添加噪声,直到完全变为静态,然后训练模型从噪声中逐步重构出清晰的图像。将这一概念转化为语言模型并不容易,因为文本是离散的单位。研究人员通过开发遮蔽扩散语言模型,解决了这一难题。这种模型在输入文本中随机遮蔽掉部分词元,并训练模型预测原始词元,从而实现 “粗到细” 的生成过程,允许模型在每一步同时考虑整个上下文。

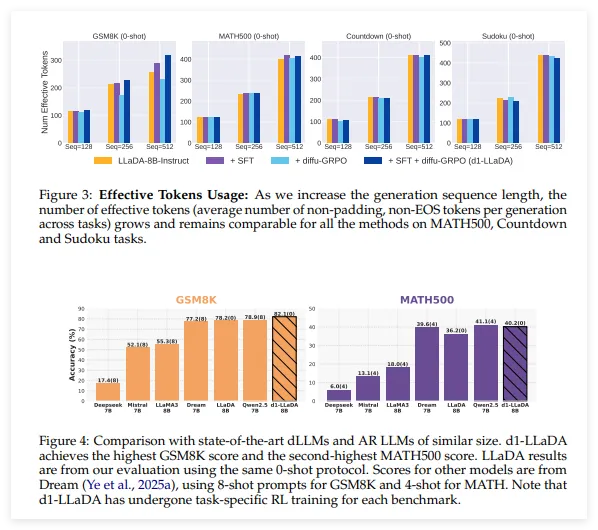

尽管 dLLMs 在计算效率上具备优势,但在推理能力方面仍落后于自回归模型。为此,强化学习成为教会大语言模型复杂推理技能的重要手段。研究人员提出的 d1框架包含两个阶段的后期训练过程:首先是监督微调(SFT),使用高质量推理示例的数据集对模型进行微调;其次是采用名为 diffu-GRPO 的新算法进行强化学习训练。这一算法为 dLLMs 估计对数概率提供了一种高效方法,并在每次更新步骤中随机遮蔽部分输入提示,从而增强模型的学习效果。

研究人员在 LLaDA-8B-Instruct 模型上应用了 d1框架,通过 s1k 推理数据集进行微调,并在多个推理基准上进行测试。结果显示,经过 d1处理的模型在各项任务中表现出色,尤其是在生成较长的响应时,模型显示出自我修正和回溯的能力,表明其具备更强的解决问题的策略。

在企业应用方面,d1框架的引入将为各种数字工作流程提供加速与自动化的可能性。企业在选择自回归模型与扩散式模型时,可以根据自身在延迟或成本上的限制来决定,而 d1风格的扩散式模型在质量、速度和成本等方面具备更大的优势。

论文:https://arxiv.org/abs/2504.12216

划重点:

🌟 d1框架结合强化学习技术,显著提升扩散式大语言模型的推理能力。

⚡ dLLMs 采用遮蔽生成方法,能更高效地处理上下文信息,降低延迟。

🚀 d1在多项推理基准测试中表现优异,展现出自我修正能力,适用于企业各种数字工作流程。