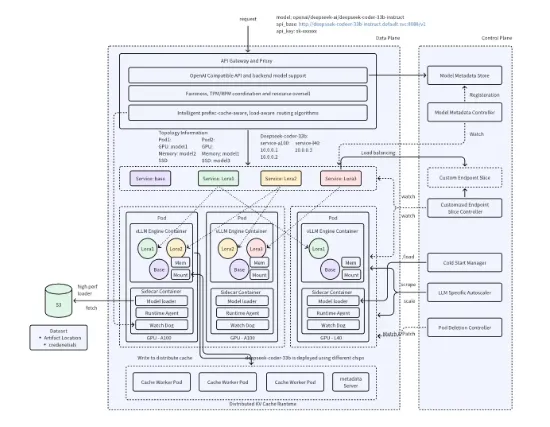

字节跳动近日宣布开源其最新研发的 AIBrix 推理系统。这一系统特别为 vLLM 推理引擎打造,目标是提供一个可扩展且高性价比的推理控制面,满足企业日益增长的 AI 需求。

AIBrix 的推出标志着一个新阶段的开始,项目团队希望通过这一开源项目为构建可扩展的推理基础设施奠定基础。该系统提供了一整套云原生解决方案,致力于优化大语言模型的部署、管理和扩展能力。特别是它对企业级需求进行了深度适配,确保用户在使用时能够享受到更高效的服务。

在功能方面,首版 AIBrix 聚焦于几个核心特点。首先是高密度的 LoRA(低秩适应)管理,这一功能旨在简化轻量级模型的适配支持,使得用户可以更便捷地管理模型。其次,AIBrix 提供了 LLM 网关和路由功能,能够高效管理和分配多个模型和副本的流量,从而确保请求能够迅速而准确地到达目标模型。此外,针对 LLM 应用的自动扩展器也能够根据实时需求动态调整推理资源,提高系统的灵活性和响应速度。

字节跳动的 AIBrix 团队表示,他们计划通过扩展分布式 KV 缓存、引入传统资源管理原则、以及基于性能分析提升计算效率等手段,继续推进系统的演进和优化。