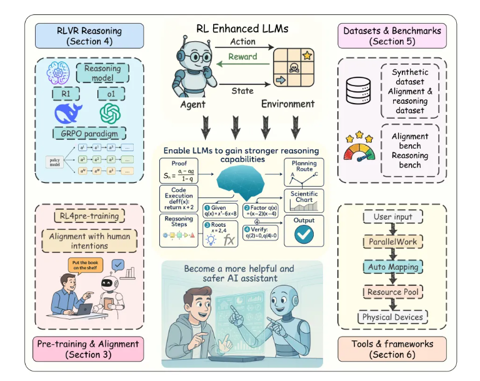

大家好,我是肆〇柒。今天看看由腾讯AI Lab Seattle联合马里兰大学、北卡罗来纳大学、香港城市大学和圣路易斯华盛顿大学共同研究的工作——Parallel-R1,它首次通过强化学习让大语言模型真正掌握了"并行思考"这一人类高级认知能力,而非仅依赖推理时策略的临时拼凑。这项研究不仅刷新了AIME25数学竞赛基准测试的准确率记录,更揭示了机器"思考"方式的演化规律。

在人工智能领域,"思考"一直是一个充满哲学意味的概念。当人类面对复杂问题时,我们自然地会同时考虑多种可能性,在合成结论前保持思维的发散性。认知科学研究早已指出,人类思维本质上是并行的,我们能在多个可能性之间灵活切换,而非严格遵循线性路径。这种能力帮助我们避免过早锁定次优解,并促进结构化、深思熟虑的推理。

这一认知科学洞见在AI领域迎来了重要转折:Google的Gemini最近将其在国际数学奥林匹克竞赛中的成功部分归功于一种名为"并行思考"的新能力。这标志着并行思考已从技术技巧上升为大模型的核心能力。AIME25(美国数学邀请赛2025)是极具挑战性的数学推理基准,其问题复杂度远超常规测试,要求模型具备多步骤推理、抽象思维和创造性解题能力。在该基准上取得突破性进展,意味着模型能够解决近四分之一的高难度数学问题,这在当前大语言模型(LLM)领域是一个显著突破。

然而,当前大多数LLM的思考本质上是线性、顺序的,缺乏真正的并行探索能力。能否让模型内在掌握这种能力,而非仅依靠推理时策略(test-time strategies)的临时拼凑?这正是Parallel-R1研究试图解决的关键问题。

Parallel-R1框架首次通过强化学习(Reinforcement Learning, RL)让LLM从零开始学会并行思考,其工作机制令人着迷:模型首先进行主推理链的自回归生成;当预测到<Parallel>token时,暂停主链并同时扩展多个独立的<Path>推理线程;完成所有路径后,自动生成<Summary>整合多视角见解;最后,将所有上下文用于继续并完成主推理路径。这种设计确保了并行思考的结构化和可控性。

为什么这很重要? 想象一位经验丰富的数学家面对难题:他不会机械地按步骤推导,而是会同时考虑多种解法,评估每条路径的可行性,最后综合得出最优解。这种能力不是通过死记硬背获得的,而是在长期实践中内化的思维方式。Parallel-R1的目标,正是让LLM获得这种"内化"的思考能力,而非仅在推理时表演并行思考。

下面我们将探讨这一突破性工作,揭示模型"思考"方式的演变历程,并解答:当机器学会"思考",我们对智能的理解是否需要重新定义?

关键发现1——冷启动问题的突破

当前激活并行思考的主要方法是监督微调(Supervised Fine-Tuning, SFT),但这种方法存在根本性局限。SFT本质上是一种行为克隆,模型只能模仿预生成的推理轨迹,而无法真正理解并泛化这种思考方式。

SFT的"学生困境":记忆与理解的鸿沟

想象你给学生一本写满解题步骤的习题集,他们可能背下答案,但无法解决变体问题。这正是SFT训练的并行思考模型面临的困境:

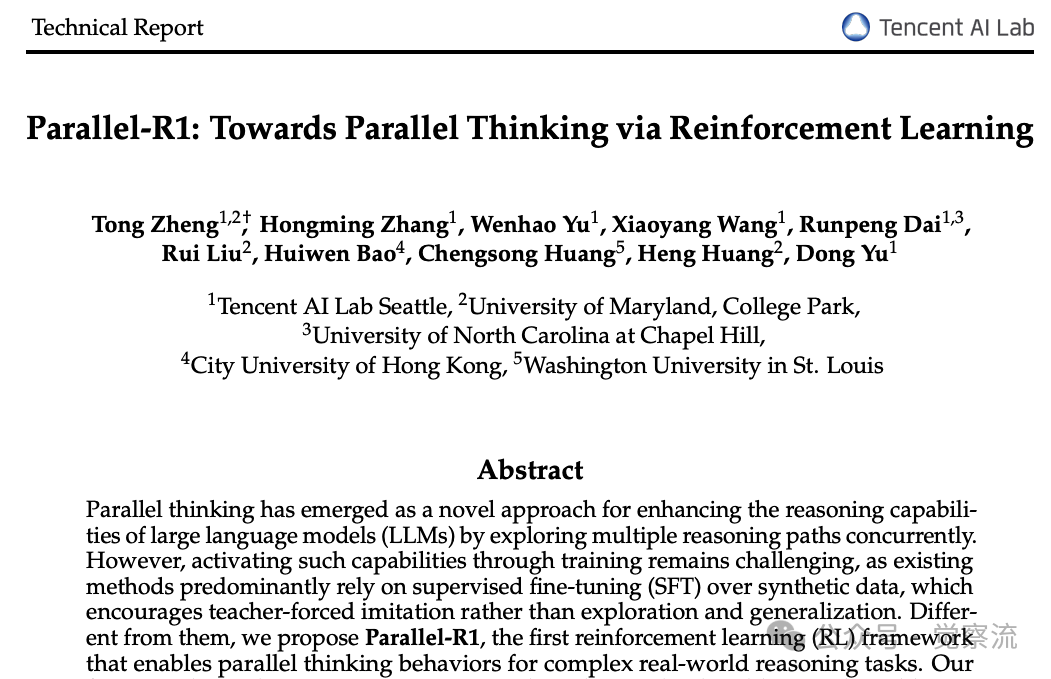

GSM8K与DAPO上并行思考数据质量对比

如上表所示,当使用相同提示词和采样设置时,强大模型在简单GSM8K问题上能生成83.7%有效的并行思考数据,但在更具挑战性的DAPO问题上成功率却为0.0%。这一数据鸿沟解释了为何直接在复杂问题上应用RL会导致"冷启动"问题。

关键收获:SFT训练的模型就像背下解题步骤的学生——能复制已知模式,但面对新问题时束手无策。这种"表演"与"理解"的鸿沟,使得SFT难以真正赋予模型自适应的并行思考能力。

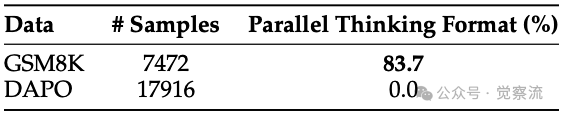

GRPO算法:Parallel-R1的训练引擎

GRPO的智慧:想象一位老师指导10个学生解题。他不是简单表扬"对的方法"或批评"错的方法",而是告诉学生:"你比其他同学更创新,但也要注意准确性"。GRPO通过比较所有尝试的相对表现来调整策略,这使模型能安全探索新行为——就像新手司机先在空旷场地练习特技,再上路行驶。

Parallel Thinking Format Check:确保数据质量的关键

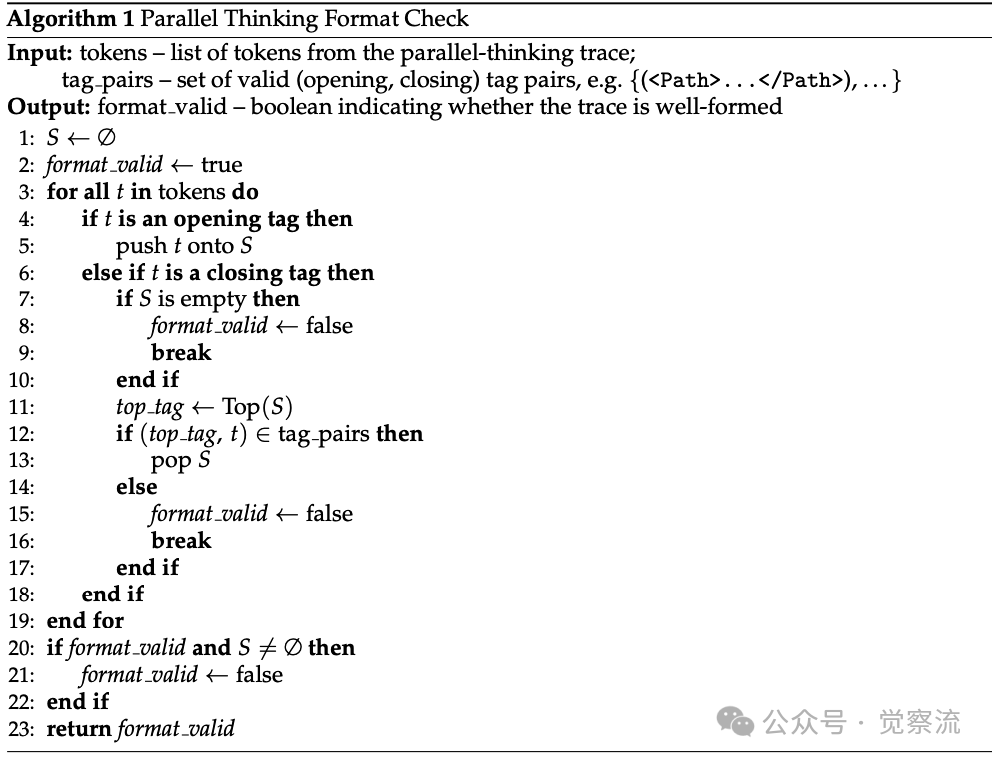

为确保并行思考数据的质量,研究者设计了Parallel Thinking Format Check算法(如下算法伪代码),通过栈结构验证标签的正确嵌套。

该算法遍历生成的token序列:当遇到开启标签时入栈,遇到关闭标签时检查是否与栈顶标签匹配。如果栈为空时遇到关闭标签,或关闭标签与栈顶标签不匹配,则判定格式无效。最后,算法检查栈是否为空,确保所有标签都已正确闭合。

认知桥梁:这就像教孩子写作文时的"段落结构检查"——开头要有主题句,中间要有支持论点,结尾要有总结。算法1确保模型掌握了并行思考的"写作规范",为后续RL训练提供了坚实基础。

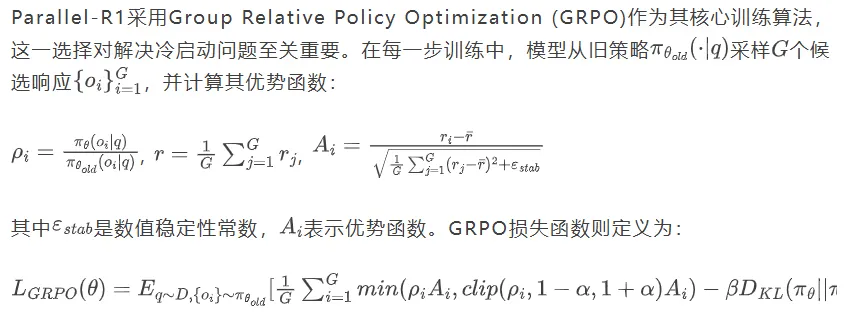

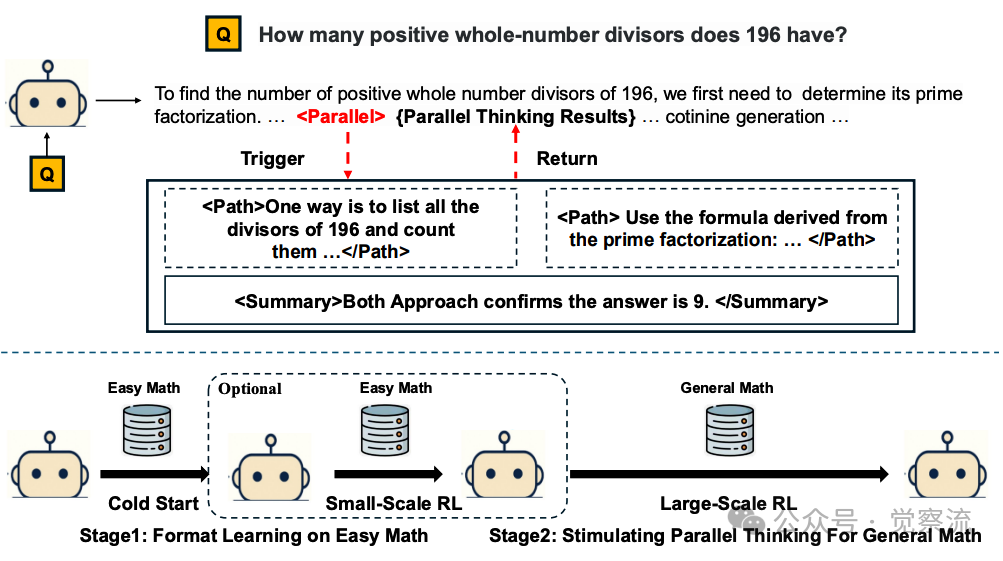

Parallel-R1训练框架示意图

如上图所示,这一冷启动阶段为后续RL训练奠定了基础。这一阶段的关键在于:不求模型解决难题,只教会它识别<Parallel>、<Path>和<Summary>标签的正确使用格式——就像先教学生"如何组织多角度论证",再教他们"如何写出有深度的论证"。

从零开始的冒险——Parallel-R1的"三步走"战略

冷启动的必要性

在复杂问题上直接应用RL面临一个关键挑战:由于模型在预训练和SFT中从未见过并行思考行为,它无法生成有效的并行思考轨迹供学习。这导致了典型的"冷启动"问题——模型不知道如何探索,也就无法学习。为解决这一问题,Parallel-R1提出了一个渐进式课程学习策略。

第一步:格式学习(冷启动)

Parallel-R1首先在简单GSM8K问题上,使用详细零样本提示词生成高质量并行思考数据,构建Parallel-GSM8K数据集。为确保数据质量,研究者设计了Parallel Thinking Format Check算法(算法1),通过栈结构验证标签的正确嵌套。

实践启示:这就像教孩子解题,先让他们在简单问题上练习"多角度思考",等掌握方法后再应用到复杂问题。研究者发现,简单问题上,强大模型能生成83.7%有效的并行思考数据,而复杂问题上为0.0%——这解释了为何需要"冷启动"阶段。

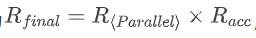

第二步:行为强化(RL on Easy Math)

在掌握基本格式后,Parallel-R1进入小规模RL阶段,继续在简单问题上训练。奖励结构设计为 ,这是一个严格二元奖励:仅当输出包含至少一个并行思考单元且答案正确时给予+1奖励,否则-1。这种设计迫使模型同时掌握格式正确性和问题解决能力,而非仅关注其中一个方面。

,这是一个严格二元奖励:仅当输出包含至少一个并行思考单元且答案正确时给予+1奖励,否则-1。这种设计迫使模型同时掌握格式正确性和问题解决能力,而非仅关注其中一个方面。

交替奖励的艺术:研究者尝试了多种奖励机制,发现交替奖励策略最为有效——就像教育孩子:80%时间奖励结果正确性,20%时间奖励思考过程。这种平衡既避免了"只重结果不重过程",也防止了"只重过程不重结果"。

研究者探索了两种架构变体:

Parallel-R1-Seen:无架构修改,允许路径间信息流动Parallel-R1-Unseen:修改注意力机制以隔离推理路径,通过路径窗口掩码和多宇宙位置编码确保各路径独立

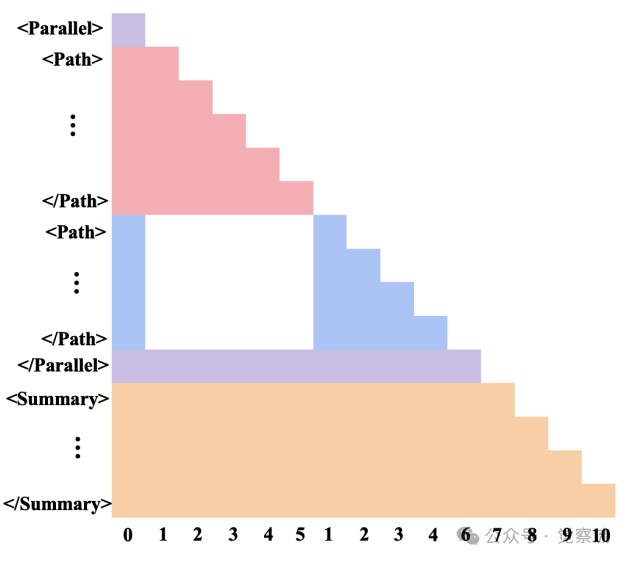

结构化注意力掩码和位置ID示意图

上图展示了如何通过路径窗口掩码和多宇宙位置编码实现推理路径的显式隔离。在路径窗口掩码中,每个<Path>块内的token只能关注同一路径和共享上下文的token,防止跨路径信息泄漏。多宇宙位置编码则为每条路径分配不相交的位置索引集,确保位置嵌入空间不重叠。

直观理解:图中空白区域表示无法相互关注的token,就像为每条推理路径设置独立的"思考隔间",确保它们不会互相干扰;而彩色区域表示可以相互关注的token,代表在总结阶段将所有"隔间"的洞见汇总到一个会议室。这种设计确保了各推理路径的独立性,同时保留了<Summary>块对所有路径的可见性,为整合多视角见解提供了基础。

消融研究:理解训练阶段的影响

为深入理解不同训练阶段的作用,研究者进行了系统的消融研究:

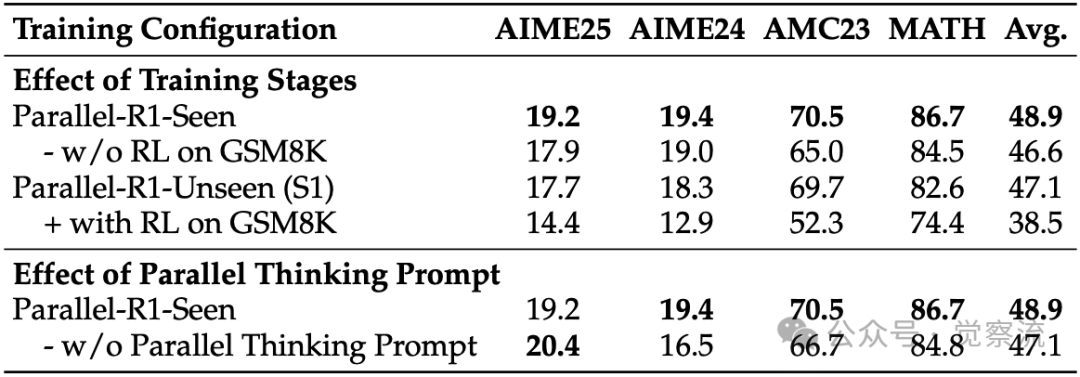

训练方法的消融研究

上表揭示了一个关键现象:对于因果变体(Causal variant),保留GSM8K上的RL训练阶段(Stage1)至关重要——移除该阶段导致平均性能下降2.3%。这验证了我们的假设:仅通过SFT学习格式不足以让模型自适应地触发并行思考,需要通过RL建立"使用并行思考→获得高分"的条件反射。

收获:这就像学习乐器——仅仅记住乐谱(SFT)不够,必须通过反复练习(RL)将技巧内化为肌肉记忆。模型需要通过试错,真正理解"何时"以及"如何"触发并行思考。

有趣的是,结构化变体表现出相反趋势:在GSM8K上添加RL阶段反而使性能下降8.6%。研究者推测,这是因为在简单数学任务上学习的结构化注意力掩码无法有效泛化到更具挑战性的问题分布上,导致模型过度拟合表面模式。这一对比揭示了一个关键洞见:虽然第一阶段RL对因果变体至关重要,以引导其自适应并行思考,但结构化变体需要不同的训练策略才能有效泛化。

第三步:能力泛化(RL on General Math)

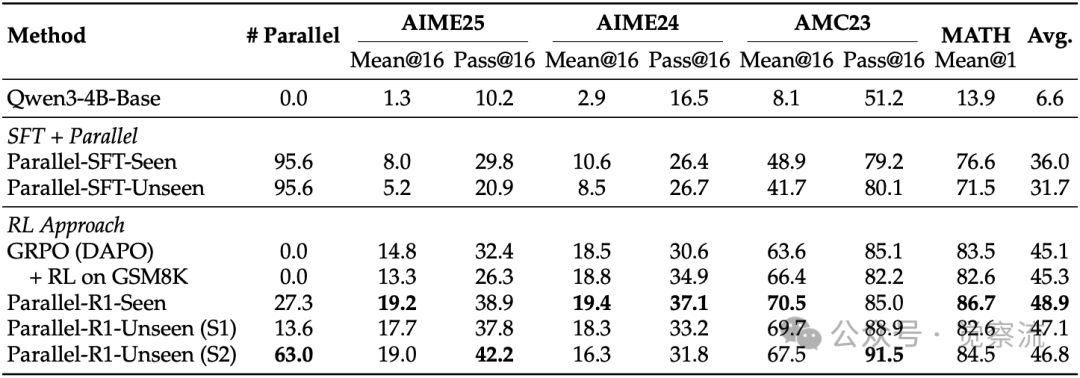

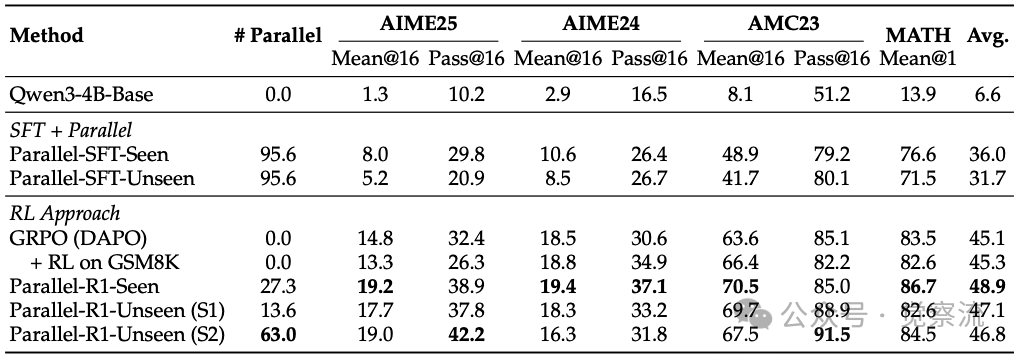

最后,Parallel-R1在复杂问题(DAPO)上应用大规模RL,仅使用准确率奖励。实验结果表明,Parallel-R1-Seen表现最佳:

数学推理基准测试上的性能比较

如上表所示,Parallel-R1-Seen在四个基准测试上的平均得分为48.9%,比基线提高3.8%;特别值得注意的是,在极具挑战性的AIME25上达到19.2%,比直接应用RL的基线提高30.1%。这些数据清晰展示了并行思考对复杂推理任务的实质性贡献。

实践价值:这表明,当模型足够强大时,它会自主决定何时需要并行思考——就像经验丰富的专家,不会在每个问题上都使用复杂方法,而是在关键时刻调用高级策略。这种自适应能力,才是真正的"思考"。

第三章:关键发现2——从探索到验证的策略演变

Parallel-R1最引人入胜的发现之一是模型策略在训练过程中的动态演变。通过分析<Parallel>标签的位置变化,研究者揭示了模型"思考"方式的深刻转变。

早期策略:计算探索者

在训练初期,模型倾向于在推理早期频繁触发<Parallel>,试图通过多路径"暴力破解"问题。下图展示了一个典型案例:

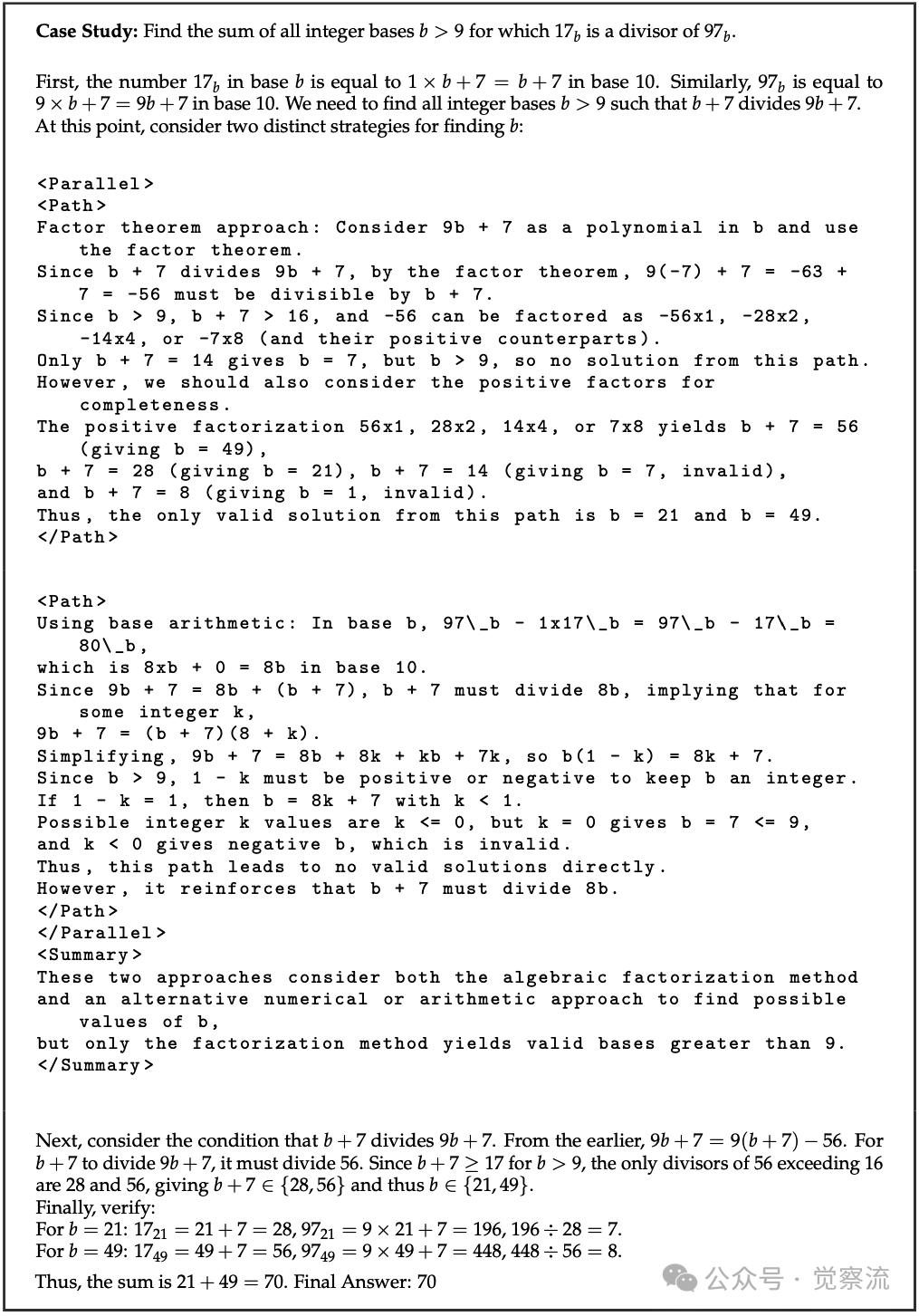

模型使用并行探索解决数论问题的案例

场景化解读:想象一个初学者面对数论问题时的慌乱:他同时尝试因子定理和基数算术两种方法(上图),就像学生在草稿纸上同时写两种解法,虽然每条路径都包含不完整的推理和潜在错误,但最终通过总结块整合出正确答案。这种高方差策略对能力较弱的模型是必要的——当核心推理能力不足时,通过并行探索可以增加找到解决方案的概率。

晚期策略:多视角验证者

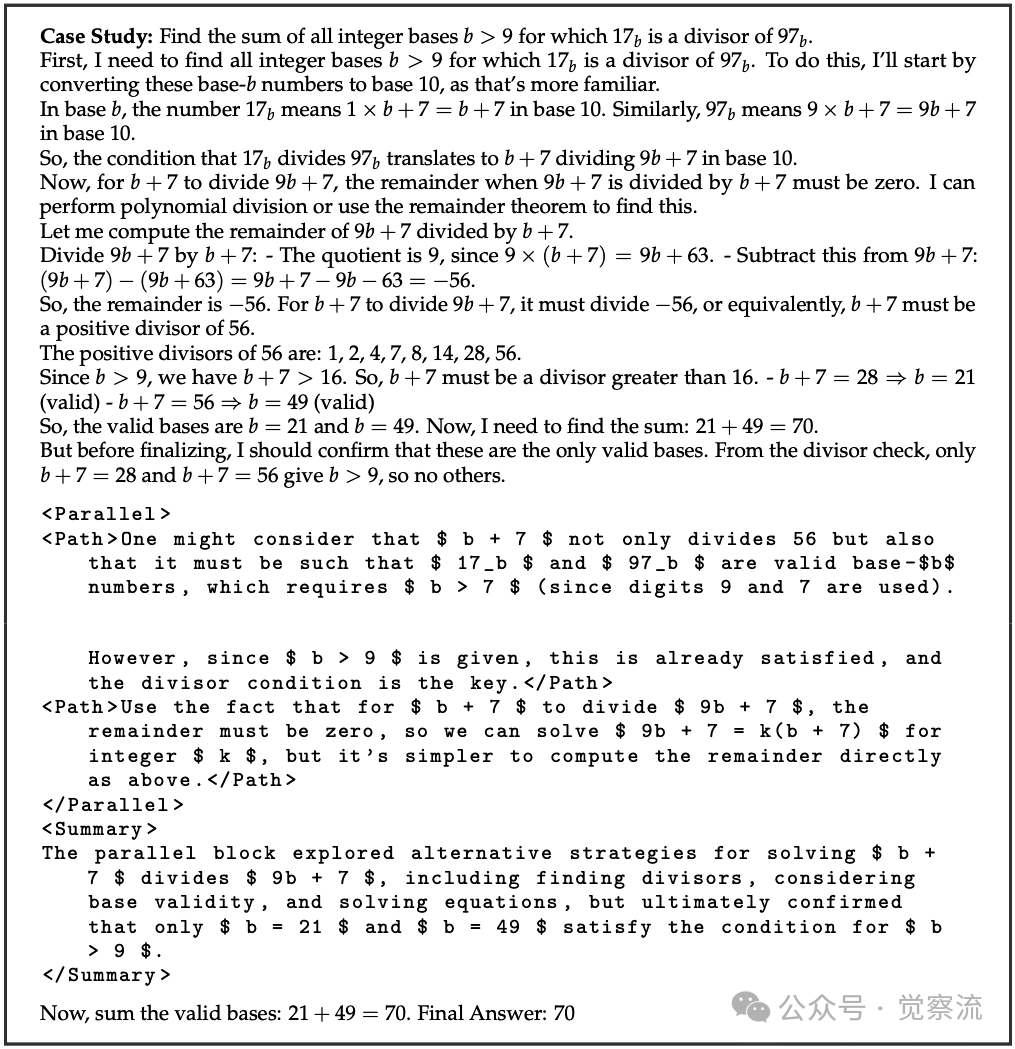

随着训练进行,模型的策略发生显著变化。它开始先用单条高置信度路径推导答案,仅在推理后期使用<Parallel>进行交叉验证。Figure 6展示了这一转变:

模型使用并行思考进行后期验证的案例

场景化解读:而一个熟练解题者会先沉着地推导出主答案(上图),然后才用并行思考验证:"让我再检查一下,这个答案是否符合所有条件?"模型首先通过主推理链完整推导出答案70,然后才触发并行思考进行验证。两条验证路径分别检查了"基数有效性"和"方程求解",但都旨在确认已得答案而非探索新解。

深入解析策略演变机制

对比Figure 5和Figure 6的案例可以清晰看到模型策略的演变。在Figure 5中,模型在推理初期就触发并行思考,一条路径使用因子定理方法,另一条使用基数算术方法。值得注意的是,这两条路径都包含不完整的推理和潜在错误,但最终通过总结块整合出正确答案。这反映了早期模型将并行思考作为"计算探索"工具的本质——通过多路径增加找到解决方案的概率,即使单条路径可能不完整或有误。

而在Figure 6中,模型首先通过主推理链完整推导出答案70,然后才触发并行思考进行验证。两条验证路径分别检查了"基数有效性"和"方程求解",但都旨在确认已得答案而非探索新解。这种从"探索"到"验证"的转变,体现了模型策略的成熟:当核心推理能力提升后,模型学会优先确保有一个可靠答案,再用并行思考作为风险最小化的验证工具。

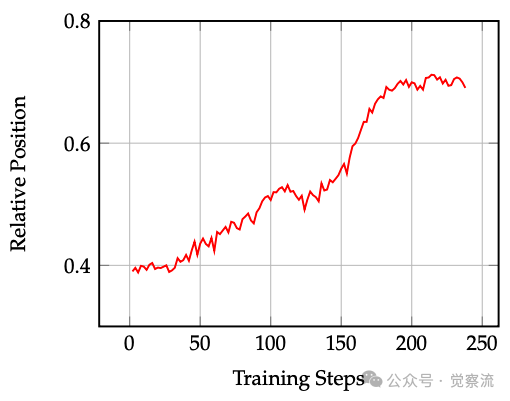

训练过程中块相对位置的动态变化

直观解读:上图像一张"思考成熟度"的生长曲线,清晰记录了模型策略的演变轨迹。随着RL训练进行,<Parallel>标签的平均相对位置从0.4稳步上升至接近0.8——这意味着模型从"推理初期就展开多路径探索",逐渐转变为"先得出主答案再进行后期验证"。

洞见:这一转变揭示了模型"思考方式"的成熟过程:当核心推理能力较弱时,模型需要通过早期并行探索增加找到解决方案的概率;随着能力提升,模型学会优先确保有一个可靠答案,再用并行思考作为风险最小化的验证工具。这种演变不仅是技术进步,更是向人类认知过程的靠拢——我们解题时也常经历从"广泛尝试"到"精准验证"的思维成熟过程。

奖励设计的深层影响

这一策略演变直接受到奖励设计的影响。研究者通过实验探索了不同奖励机制的效果:

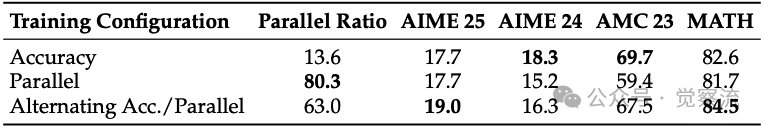

Parallel-R1-Unseen模型的奖励建模消融研究

如上表所示:

- 单纯奖励准确率(Accuracy)导致并行思考比例仅13.6%,模型倾向于走"捷径"

- 强制奖励并行思考(Parallel)达到80.3%比例,但性能显著下降,表明模型过度关注形式而忽视逻辑

- 交替奖励策略(Alternating Acc./Parallel)实现最佳平衡(63.0%并行比例),同时在AIME25上达到19.0%,优于纯准确率方法

关键发现:模型策略从探索到验证的演变不仅反映了模型能力的提升,更揭示了并行思考的动态价值——它不是一种固定模式,而是根据模型自信度自适应调整的推理工具。这就像教育孩子:只奖励考试成绩会导致死记硬背;只奖励思考过程可能忽视结果;而交替奖励则培养了既重过程又重结果的综合能力。

第四章:关键发现3——并行思考作为探索支架的价值

Parallel-R1最突破性的洞见是:并行思考不仅是一种最终能力,还可以作为训练过程中的探索机制,帮助模型发现更优策略空间。

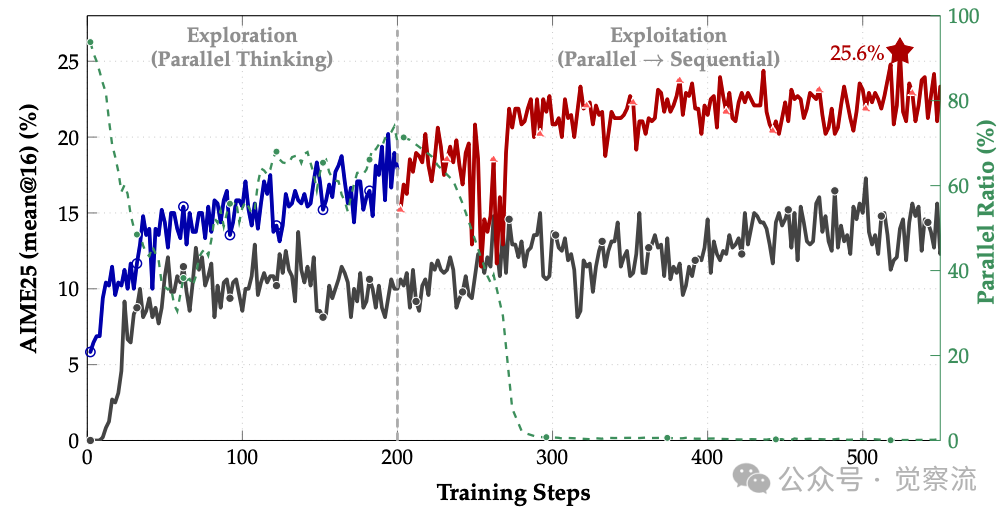

两阶段训练实验

研究者设计了创新的两阶段训练实验:

- 探索期(0-200步):交替奖励策略,80%步骤奖励准确率,20%步骤奖励并行思考+准确率

- 利用期(200步后):仅优化准确率,允许模型精炼有效策略

以并行思考作为中期训练探索支架的两阶段训练

场景化解读:上图展示了一个令人惊讶的现象:在"利用期",尽管模型并行思考使用率从80%下降至约40%,但AIME25准确率持续提升,最终达到25.6%,比直接应用RL的基线提高42.9%。

洞见:这就像教孩子解题,先鼓励"多角度思考",等掌握方法后再追求"快速解题"。并行思考作为"探索支架"的价值不仅在于结构本身,更在于它帮助模型发现的更优策略空间——即使后期减少使用,模型已内化了通过探索获得的更优策略。

奖励设计的艺术

实验结果表明,奖励设计需要精心平衡:

- 纯准确率奖励导致模型忽视并行思考

- 过度强调并行思考损害整体性能

- 交替奖励策略(如每10步中8步准确率奖励,2步并行思考奖励)实现最佳平衡

实践:如果你正在训练解决复杂问题的LLM,可以借鉴这一方法:

1. 探索期:交替使用"准确性奖励"和"结构奖励",引导模型发现更优策略空间

2. 利用期:仅优化准确性,让模型精炼已发现的有效策略

3. 关键点:即使在利用期减少并行思考使用,性能仍能持续提升——这表明探索阶段的价值已内化

案例:如何应用这一发现

假设你正在训练一个解决金融风险评估的LLM:

- 探索期(前200步):80%时间奖励准确预测风险,20%时间奖励多角度分析(如同时考虑宏观经济、行业趋势、公司财务等)

- 利用期(200步后):仅奖励预测准确性

- 预期效果:模型初期会频繁使用多角度分析,但随着能力提升,逐渐学会仅在关键节点使用,最终准确率显著提升

这一方法不仅适用于数学推理,还可迁移到代码生成、科学发现等其他复杂推理领域。

总结:通往通用推理的桥梁

Parallel-R1代表了LLM推理能力发展的重要研究。作为首个通过RL从零开始学习并行思考的框架,它成功解决了RL中的冷启动问题,并在AIME25、AIME24、AMC23和MATH等基准测试中取得一致提升。特别是,在极具挑战性的AIME25基准上达到25.6%的准确率,比基线提高42.9%,这一成就令人瞩目。

技术突破与认知

技术突破:

- 首次通过RL从零开始学习并行思考

- 渐进式课程设计成功解决RL中的冷启动问题

- 在多个基准测试中取得一致提升(下表:Parallel-R1-Seen平均48.9%,比基线提高3.8%)

认知:

- 模型策略从"探索"到"验证"的演变,与人类认知发展有深刻相似性

- 为理解LLM的"黑箱"思考过程提供了首个实证证据

- 证明了RL可以教会LLM复杂、自适应的推理行为

Parallel-R1不仅是一项技术突破,还是一次认知科学实验——它让我们第一次"看见"了LLM的"思考"如何演变。这种对"思考"本质的探索,或许比准确率提升更为重要。

实践启示:如何应用Parallel-R1的智慧

1. 渐进式课程设计:先在简单问题上训练目标能力,再迁移到复杂问题

- 行动指南:如果你的模型在复杂任务上表现不佳,尝试先在简化版任务上训练目标能力

2. 交替奖励机制:在训练早期交替使用"准确性奖励"和"结构奖励"

- 行动指南:设计奖励函数时,考虑周期性切换不同奖励目标,避免过早锁定次优策略

3. 探索支架思维:将目标能力视为临时探索工具,而非最终目标

行动指南:在训练中引入临时机制帮助模型发现更优策略空间,即使后期不再使用,性能仍能提升

思考的边界

这一框架的潜力远不止于数学推理。它提出的方法论——通过渐进式课程设计解决复杂能力的冷启动问题,通过奖励机制引导策略演变,将特定能力作为探索支架——可能适用于代码生成、科学发现等其他复杂推理领域。

关键问题:

- 如何平衡探索与利用,设计更有效的奖励机制?

- 并行思考能力能否成为通用推理模型的标准组件?

- 当机器学会"思考",我们对智能的理解是否需要重新定义?

思考:Parallel-R1提醒我们,真正的智能不仅在于得出正确答案,更在于如何思考——在不确定中探索,在多样性中整合,在风险与收益间权衡。这或许正是通往更强大、更可靠AI系统的必经之路。

如果有兴趣的伙伴阅读这些论文,请你阅读时注意这些论文的时间,这样你会有一个清晰理解的脉络,会洞察到模型发展的趋势:

模型是在向上吞噬可验证、可工程化、以及成熟的inference部分。

就如同,我们今天所探讨的这个话题,可以明显的看出:推理模型吞噬了CoT、React,并且人类并不满足单一的chain of thought 的 scale,所以在test-time scaling阶段实践了Parallel Scaling以后,出现有数据,可积累,能验证,有反馈的范式,那么下一步是什么?它就可以成为新范式被训练到模型中。