a-m-team 又发新论文了。

这个团队上周刚刚在 Hugging Face 低调开源了32B稠密模型,但在多项关键推理评测中击败了 DeepSeek-R1,并与超大规模的 MoE 模型Qwen3-235B-A22B、Seed1.5-Thinking 不相上下,因此赢得了海内外的不少关注。

今天,a-m-team 发布了一篇名为“Not All Correct Answers Are Equal: Why Your Distillation Source Matters”的论文,介绍了 R1 之后下一代推理模型的小进展。

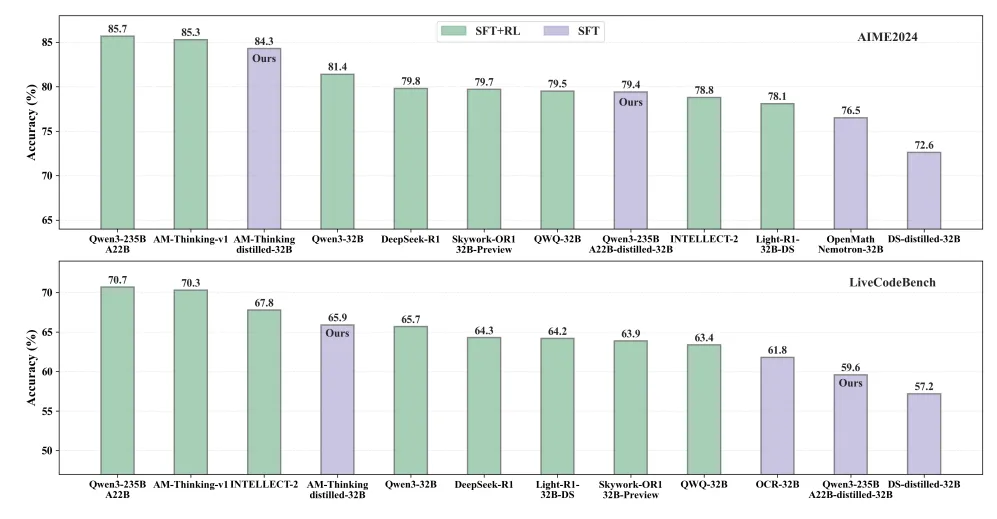

在这篇论文中,研究团队发现基于 AM-Thinking-v1 的问答数据“纯蒸馏”(即只用SFT)训练出的“学生模型”,竟然在多个高难推理任务上接近甚至达到当前最优水平(SOTA),不仅超过了Qwen3-32B,甚至接近了 Qwen3-235B 这样大一个数量级的模型表现。

论文链接:https://arxiv.org/pdf/2505.14464

在大模型能力竞赛持续推进的今天,如何以更低的训练成本获得更强的推理能力,成为开源社区面临的核心挑战之一。

相比于 SFT+RL 的训练方式,只用 SFT 意味着着数十倍的成本缩减——也就是说,没有强化学习能力的企业级玩家将 AM-Thinking-v1 蒸馏版拿去直接 SFT 后落地,能够大幅提升应用效率、降低落地成本。

这意味着开源社区未来能以更低的训练成本,获得更强的推理能力。而这项工作成立的前提条件是,需要能有良好的数据源。

换言之,假如数据源能驱动蒸馏模型的成长,那么蒸馏也将不只是一个简简单单的智能“压缩”动作,而是会有潜力成为在开源社区生态中螺旋生长的系统性工程。

什么样的数据源更有效?

蒸馏(Distillation)作为一种低成本、高效率的训练方式,已被广泛用于模型压缩与能力迁移。一般情况下,基于GRPO 或者 PPO 的 RL 训练,但一个被长期忽视的问题是:你的蒸馏源选对了吗?

a-m-team 近期开源了一套基于 AM-Thinking-v1 和 Qwen3-235B-A22B 两个顶尖大模型生成的推理蒸馏数据集。通过对 189 万条高质量推理任务的并行蒸馏对比分析发现:

基于 AM-Thinking-v1 蒸馏训练出的学生模型在多个高难推理任务上接近甚至达到当前最优水平(SOTA);

这份开源数据集为低成本构建强推理能力模型提供了扎实支撑;

用同样的学生模型、训练配置、benchmark 套件对比训练结果;

开源其中两份(AM-Thinking-v1 和 Qwen3-235B-A22B)的数据以供社区验证。

正如本篇论文一语双关的主标题,“Not All Correct Answers Are Equal”——不同的模型,如果生成相似正确的答案,但并不代表他们都有相同的价值。因为基于这个正确答案背后的数据源质量、结构存在差异,自然对后续训练的贡献可能存在显著差异。

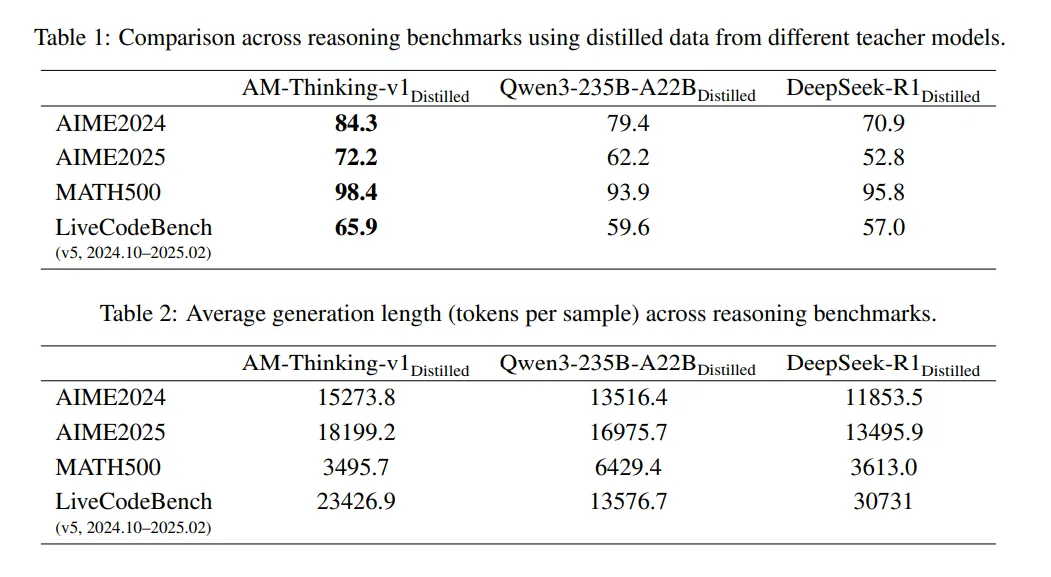

a-m-team研究以自家最新发布的AM-Thinking-v1为例,根据其团队研究,以AM-Thinking-v1为教师模型培训出来的纯蒸馏模型,相比于Qwen3-235B-A22和DeepSeek-R1的蒸馏模型在性能上有着显著的领先优势。

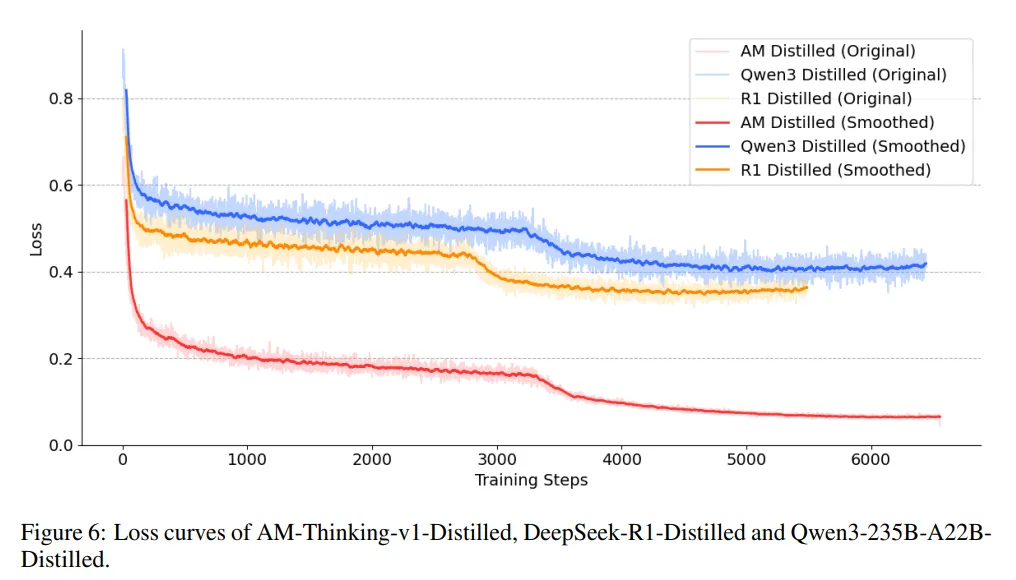

不仅如此,AM蒸馏过程中的损失曲线也是最低的,这点其实从图一的评分排列中也可见一斑。如下图所示,AM长期保持了远低于其他模型的基准损耗。

损耗低的背后是 AM 团队本身提供了更适合学习的高质量的数据。

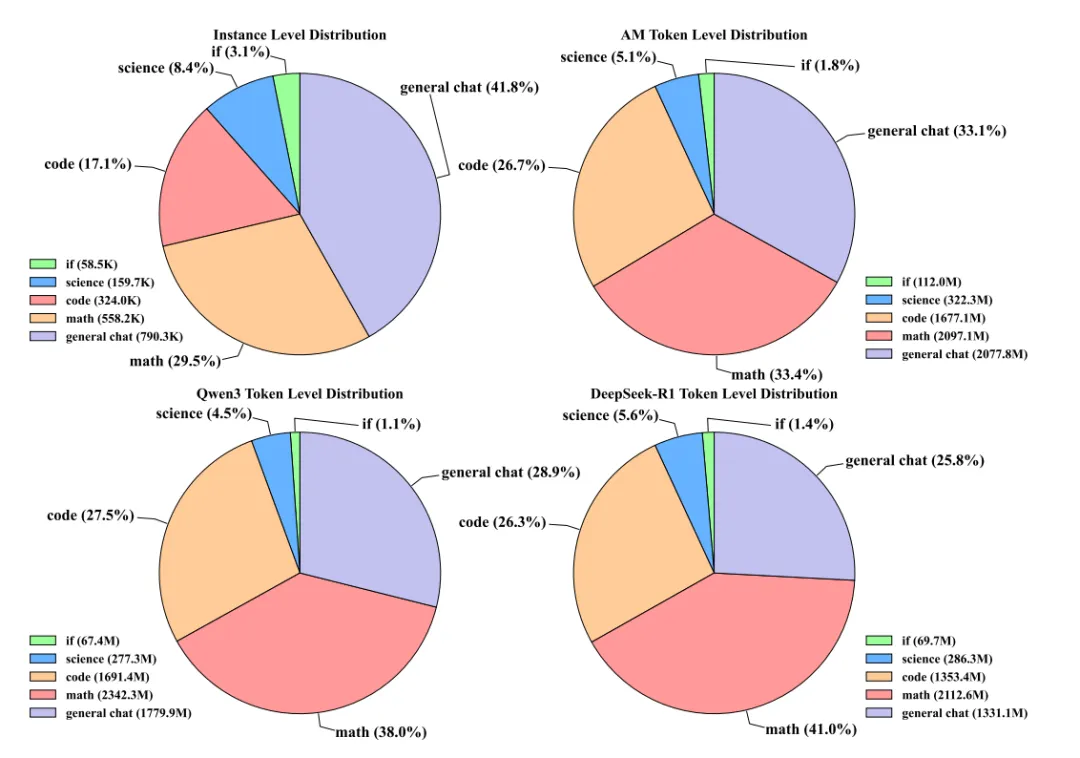

a-m-team 团队对从三个不同的大规模模型 AM-Thinking-v1、Qwen3-235B-A22B和 DeepSeek-R1的训练数据进行了详细分析后,认为这种分数差异来或许自于他们在数据结构上的优势。

首先,AM的token 长度分布更加多样。

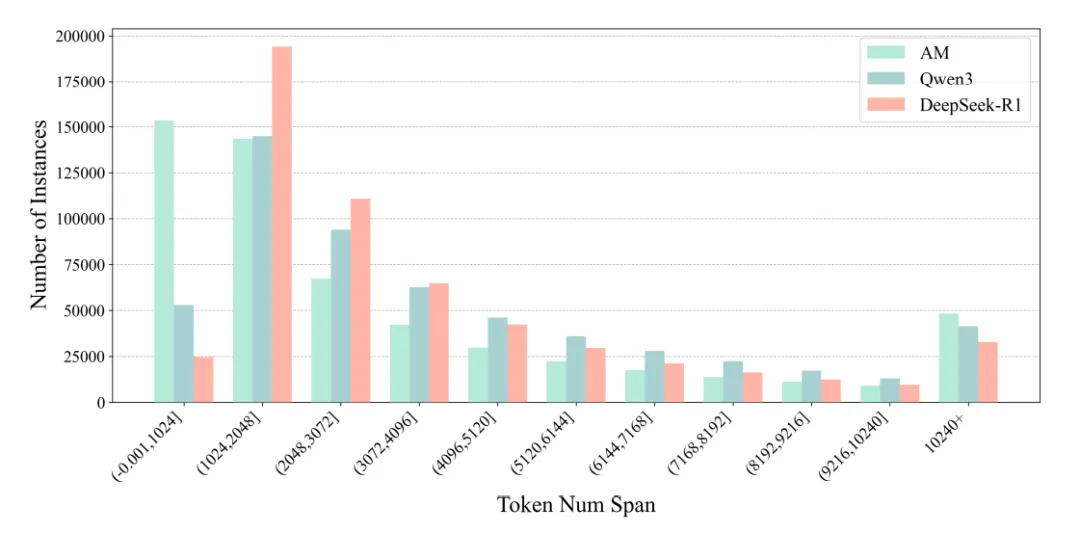

如下图专门展示了数学实例的词元跨度分布情况。结果表明,AM-Thinking-v1 的数学数据呈现出高度分散的分布状态,呈现了更多的短序列。

这意味着,AM的响应跨度广——它既能生成简洁的1024 token以内回复,也能输出超过 10240 token 的复杂推理链,这种“长短结合”的分布为模型的自适应能力提供了数据支撑。

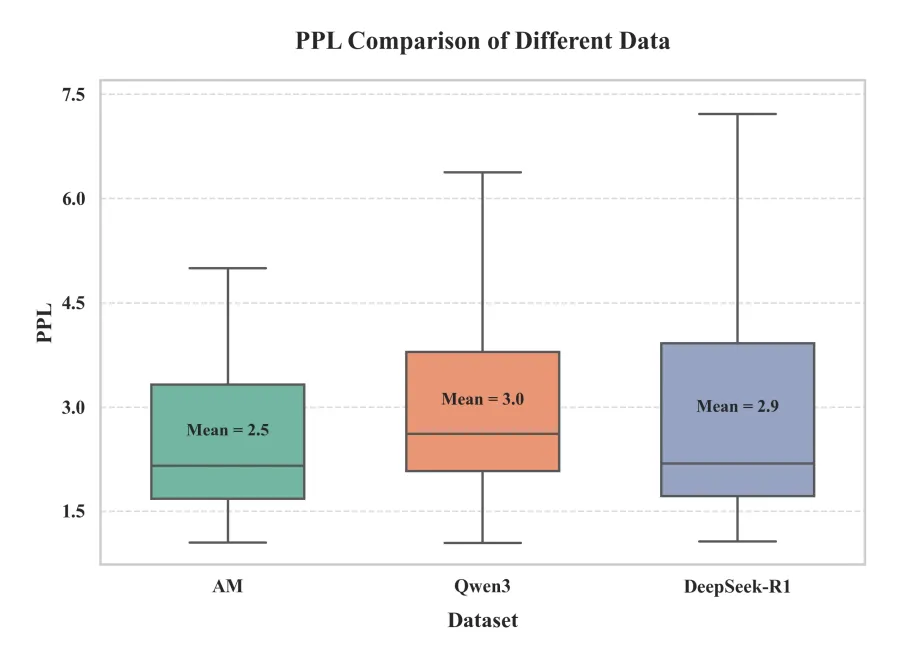

其次,AM 模型数据源的困惑度更低,数据质量更高。

研究称,AM 的平均Perplexity(PPL)数值为2.5,低于Qwen3.0和DeepSeek R1 2.9,表明 AM 的数据在语言流畅性、连贯性等方面更优,这或许代表其适合用于训练结构化 reasoning 过程。

而由于更好的数据结构,除了跑分领先外,生成行为也更符合“人类推理模式”。

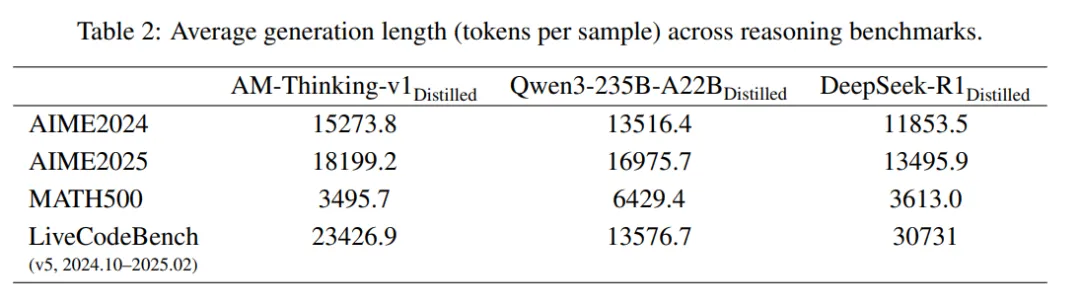

研究者声称,在较难的任务中(如下图AIME2024\2025),AM 蒸馏模型会自动生成更长 reasoning 过程,而在较简单任务(如下图中 MATH500)中则保持简明。

这意味着模型保持了一个较好的长调度能力。

从不服跑个分,到不服蒸个馏?

a-m-team宣布开源了它的蒸馏数据,主要包括AM-Thinking-v1 Distilled Dataset和Qwen3-235B-A22B Distilled Dataset。其中每条数据都包含:

标准化 prompt;

符合验证标准的 + 格式推理链;

精准分任务分类(数学、代码、科学、指令、多轮对话等);

验证分数(均高于 0.9)及自动评分信息。

研究者希望,这份数据集不仅能助力社区低成本达成强推理能力,更能够为后续 RLHF、CoT 微调、可控生成等高级能力构建提供基础。同时,AM团队也正在试水更广泛的模型改进和应用场景。

正如AM团队在一篇分析文章中指出,“蒸馏数据的选择不再是技术细节,而是决定性能上限的关键因素。”优质的蒸馏数据源未来或许将直接影响训练效率和性能上限。

而对于模型观察者来说,AM团队在本次论文中旗帜鲜明地提出了“Not All Correct Answers Are Equal”,其实也是对现阶段模型的一种全新反思框架:

尤其在评分差异与用户感知逐渐脱节,许多从业者对评分审美疲劳的今天,什么样的开源大模型才更可以被称作领先的?蒸馏背后体现的数据结构或许会是一个全新的视角。

近日,大家都在感叹:DeepSeek 的 R1 之后,大模型已经很久没有新的技术突破了。但实际证明,默默在认真研究技术的团队还在不断创新和取得贡献。