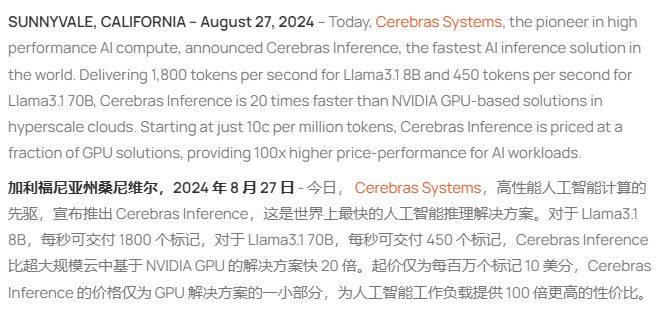

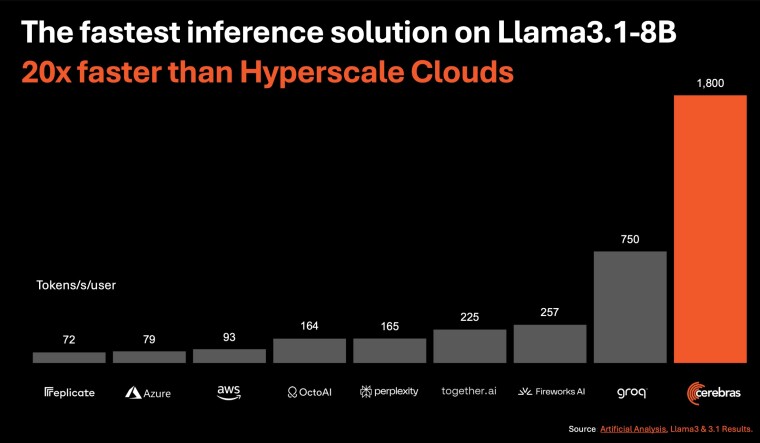

Cerebras Systems 今日宣布推出 Cerebras Inference,官方称这是全球最快的 AI 推理解决方案。该新解决方案为 Llama 3.1 8B 提供每秒 1800 个 token,为 Llama 3.1 70B 提供每秒 450 个 token,速度是微软 Azure 等超大规模云中提供的基于英伟达 GPU 的 AI 推理解决方案的 20 倍。

除了令人难以置信的性能之外,这款新型推理解决方案的定价也比流行的 GPU 云低得多,起价仅为每百万个 token 10 美分,从而为 AI 工作负载提供 100 倍更高的性价比。

该方案将允许 AI 应用程序开发人员构建下一代 AI 应用程序,而不会影响速度或成本。该方案使用了 Cerebras CS-3 系统及其 Wafer Scale Engine 3(WSE-3)AI 处理器,其中 CS-3 的内存带宽是 Nvidia H100 的 7000 倍,解决了生成式 AI 的内存带宽技术挑战。

据AI在线了解,Cerebras Inference 提供以下三个层级:

免费层为登录的任何人提供免费的 API 访问和慷慨的使用限制。

开发者层专为灵活的无服务器部署而设计,为用户提供一个 API 端点,其成本只是市场上替代方案的一小部分,Llama 3.1 8B 和 70B 模型的定价分别为每百万 token 10 美分和 60 美分。

企业层提供微调模型、定制服务级别协议和专门支持。企业可以通过 Cerebras 管理的私有云或客户场所访问 Cerebras Inference,非常适合持续的工作负载。

Cerebras 团队称:“凭借创纪录的性能、业界领先的定价和开放的 API 访问,Cerebras Inference 为开放的 LLM 开发和部署设定了新标准。作为唯一能够同时提供高速训练和推理的解决方案,Cerebras 为 AI 开辟了全新的可能性。”

AI 领域正在迅速发展,虽然英伟达目前在 AI 市场占据主导地位,但 Cerebras 和 Groq 等公司的出现预示着行业动态可能发生变化。随着对更快、更具成本效益的 AI 推理解决方案需求的不断增加,这些挑战者在颠覆英伟达的霸主地位,尤其是在推理领域方面。