工程

4K分辨率视觉预训练首次实现!伯克利&英伟达多模态新SOTA,更准且3倍加速处理

当前,所有主流的视觉基础模型(如 SigLIP、DINOv2 等)都仍然在低分辨率(如 384 * 384 分辨率)下进行预训练。 对比人类视觉系统可以轻松达到 10K 等效分辨率,这种低分辨率预训练极大地限制了视觉模型对于高清细节的理解能力。 然而,当前视觉模型预训练很难提升到更高的分辨率,核心原因在于计算代价过于高昂。

4/17/2025 12:12:00 PM

机器之心

从思考到行动:大模型自主工具调用能力的深度实现

本项目由复旦大学知识工场实验室肖仰华教授、梁家卿青年副研究员领导,博士生韩槿一,硕士生李廷云、熊程元、姜子上、王昕奕等同学共同参与完成。 GPT - 4o、Deepseek - R1 等高级模型已展现出令人惊叹的「深度思考」能力:理解上下文关联、拆解多步骤问题、甚至通过思维链(Chain - of - Thought)进行自我验证、自我反思等推理过程。 但是,多数主流模型仍在基础问题上犯错,复杂四则运算计算失误,简单「两个小数比大小」出错、甚至连数清楚 strawberry 里有几个「r」都能翻车……即使提示像 R1 这样具备深度思考能力的大模型也要消耗大量的 token 才能勉强答对。

4/17/2025 10:43:00 AM

机器之心

JHU提出最强ToM方法,AutoToM横扫五大基准

本文有三位共同第一作者,分别为 Zhining Zhang(张芷宁)、Chuanyang Jin(金川杨)、Mung Yao Jia。 他们在约翰霍普金斯大学 Social Cognitive AI Lab 共同完成这篇论文。 本文的指导老师为 Tianmin Shu(舒天民),是 JHU Social Cognitive AI Lab 的主任。

4/16/2025 5:31:00 PM

机器之心

ICLR 2025 | 一行代码!FreDF频域损失稳定提升时间序列预测精度

本文由浙江大学、中南大学、上海交通大学、Tiktok、北京大学、南洋理工大学联合完成。 第一作者王浩为浙江大学硕博连读生,发表NeurIPS、ICLR、KDD、WWW、TOIS等顶级会议和期刊十余篇。 通讯作者为北京大学李昊轩助理研究员和南洋理工大学陶大程教授。

4/15/2025 8:59:00 PM

机器之心

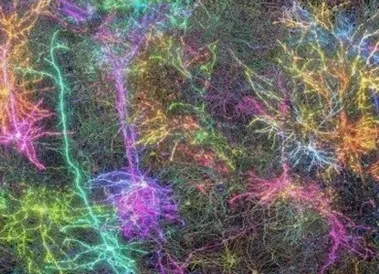

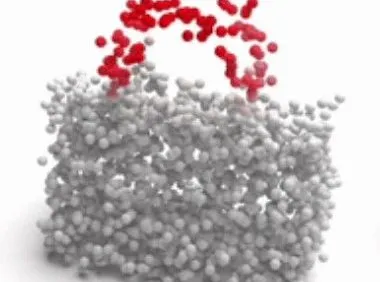

迄今为止最大、最详细的哺乳动物脑连接图,详细展现海量神经元活动

编辑 | 菠菜研究人员通过绘制小鼠脑组织中一立方毫米内的细胞图谱,绘制出了迄今为止最大、最详细的哺乳动物脑连接图。 这项里程碑式的成就还首次在神经科学领域展现了单个神经元的大规模活动。 这张高分辨率 3D 地图包含超过 20 万个脑细胞,其中包含约 8.2 万个神经元。

4/15/2025 2:51:00 PM

ScienceAI

合成数据助力视频生成提速8.5倍,上海AI Lab开源AccVideo

虽然扩散模型在视频生成领域展现出了卓越的性能,但是视频扩散模型通常需要大量的推理步骤对高斯噪声进行去噪才能生成一个视频。 这个过程既耗时又耗计算资源。 例如,HunyuanVideo [1] 需要 3234 秒才能在单张 A100 上生成 5 秒、720×1280、24fps 的视频。

4/14/2025 6:08:00 PM

机器之心

中科大、中兴提出新后训练范式:小尺寸多模态模型,成功复现R1推理

本文第一作者为邓慧琳,中国科学技术大学硕博连读四年级,研究方向为多模态模型视觉理解、推理增强(R1强化学习)、异常检测。 在TAI、TASE、ICCV等期刊和顶会发表论文。 近年来,随着大型语言模型(LLMs)的快速发展,多模态理解领域取得了前所未有的进步。

4/14/2025 1:37:00 PM

机器之心

3710亿数学tokens,全面开放!史上最大高质量开源数学预训练数据集MegaMath发布

在大模型迈向推理时代的当下,数学推理能力已成为衡量语言模型智能上限的关键指标。 近日,LLM360 推出了 MegaMath:全球目前最大的开源数学推理预训练数据集,共计 3710 亿(371B)tokens,覆盖网页、代码和高质量合成数据三大领域。 报告标题:MegaMath: Pushing the Limits of Open Math Corpora技术报告:: 代码: DeepSeek-Math Corpus(120B)的开源数据集,更代表从「只靠网页」到「面向推理」的重大跨越。

4/13/2025 3:05:00 PM

机器之心

扩散模型奖励微调新突破:Nabla-GFlowNet让多样性与效率兼得

本文作者刘圳是香港中文大学(深圳)数据科学学院的助理教授,肖镇中是德国马克思普朗克-智能系统研究所和图宾根大学的博士生,刘威杨是德国马克思普朗克-智能系统研究所的研究员,Yoshua Bengio 是蒙特利尔大学和加拿大 Mila 研究所的教授,张鼎怀是微软研究院的研究员。 此论文已收录于 ICLR 2025。 在视觉生成领域,扩散模型(Diffusion Models)已经成为生成高质量图像、视频甚至文本的利器。

4/13/2025 2:55:00 PM

机器之心

面对杂乱场景,灵巧手也能从容应对!NUS邵林团队发布DexSinGrasp基于强化学习实现物体分离与抓取统一策略

本文的作者均来自新加坡国立大学 LinS Lab。 本文的共同第一作者为新加坡国立大学实习生许立昕和博士生刘子轩,主要研究方向为机器人学习和灵巧操纵,其余作者分别为硕士生桂哲玮、实习生郭京翔、江泽宇以及博士生徐志轩、高崇凯。 本文的通讯作者为新加坡国立大学助理教授邵林。

4/12/2025 3:47:00 PM

机器之心

传统预训练正走向终结,推理优化与后训练提升有限,大模型今后如何突破发展瓶颈?

高质量数据枯竭,传统预训练走向终点,大模型如何突破瓶颈? 当前(多模态)大模型正深陷「数据饥渴」困境:其性能高度依赖预训练阶段大量高质量(图文对齐)数据的支撑。 然而,现实世界中这类高价值数据资源正在迅速耗尽,传统依赖真实数据驱动模型能力增长的路径已难以为继。

4/11/2025 10:49:00 PM

机器之心

IC-Light的视频版本来了,RelightVid:强光动态环境下的视频光照编辑神器

大家还记得那个 ICLR 2025 首次满分接收、彻底颠覆静态图像光照编辑的工作 IC-Light 吗? 今天,来自复旦大学、上海交通大学、浙江大学、斯坦福大学等机构的学者们正式宣布:IC-Light 的视频版本来了——RelightVid! 论文标题:RelightVid: Temporal-Consistent Diffusion Model for Video Relighting论文链接::: 、光影真实、支持强光动态场景的高质量视频光照编辑,彻底打开下一代视频重光照的新篇章!

4/11/2025 11:15:00 AM

机器之心

CVPR 2025 | 2D 大模型赋能3D Affordance 预测,GEAL助力可泛化的3D场景可交互区域识别

GEAL 由新加坡国立大学的研究团队开展,第一作者为博士生鲁东岳,通讯作者为该校副教授 Gim Hee Lee,团队其他成员还包括孔令东与黄田鑫博士。 主页:::,如何让智能体理解并挖掘 3D 场景中可交互的部位(Affordance)对于机器人操作与人机交互至关重要。 所谓 3D Affordance Learning,就是希望模型能够根据视觉和语言线索,自动推理出物体可供哪些操作、以及可交互区域的空间位置,从而为机器人或人工智能系统提供对物体潜在操作方式的理解。

4/10/2025 4:20:00 PM

机器之心

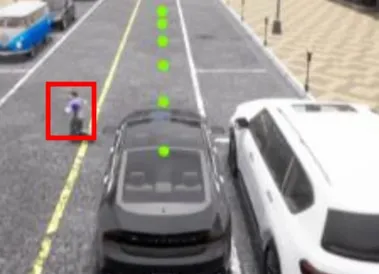

闭环端到端精度暴涨19.61%!华科&小米汽车联手打造自动驾驶框架ORION,代码将开源

近年来,端到端(End-to-End,E2E)自动驾驶技术不断进步,但在复杂的闭环交互环境中,由于其因果推理能力有限,仍然难以做出准确决策。 虽然视觉 - 语言大模型(Vision-Language Model,VLM)凭借其卓越的理解和推理能力,为端到端自动驾驶带来了新的希望,但现有方法在 VLM 的语义推理空间和纯数值轨迹的行动空间之间仍然存在巨大鸿沟。 除此之外,现有的方法常常通过叠加多帧的图像信息完成时序建模,这会受到 VLM 的 Token 长度限制,并且会增加额外的计算开销。

4/10/2025 4:08:00 PM

机器之心

大模型推理无损加速6.5倍!EAGLE-3碾压一切、延续Scaling Law能力

自回归解码已然成为大语言模型的推理标准。 大语言模型每次前向计算需要访问它全部的参数,但只能得到一个 token,导致其生成昂贵且缓慢。 近日,EAGLE 团队的新作《EAGLE-3: Scaling up Inference Acceleration of Large Language Models via Training-Time Test》通过一系列优化解锁了投机采样的 Scaling Law 能力,可以将大语言模型的推理速度提高 6.5 倍,同时不改变大语言模型的输出分布,确保无损。

4/10/2025 11:12:00 AM

机器之心

从零搭一套可复现、可教学、可观察的RL for VLM训练流程,我们试了试

自 Deepseek-R1 发布以来,研究社区迅速响应,纷纷在各自任务中复现 R1-moment。 在过去的几个月中,越来越多的研究尝试将 RL Scaling 的成功应用扩展到视觉语言模型(VLM)领域 —— 刷榜、追性能、制造 “Aha Moment”,整个社区正高速奔跑,RL for VLM 的边界也在不断被推远。 但在这样一个节奏飞快、聚焦结果的研究环境中,基础设施层面的透明性、评估的一致性,以及训练过程的可解释性,往往被忽视。

4/9/2025 11:24:00 AM

机器之心

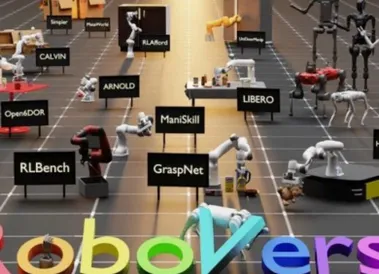

迈向机器人领域ImageNet,大牛Pieter Abbeel领衔国内外高校共建RoboVerse,统一仿真平台、数据集和基准

大规模数据集和标准化评估基准显著促进了自然语言处理和计算机视觉领域的发展。 然而,机器人领域在如何构建大规模数据集并建立可靠的评估体系方面仍面临巨大挑战。 一方面,采集真实世界的机器人数据需要消耗大量资源(如时间、硬件成本),且效率低下;另一方面,在现实场景中测试机器人性能面临复杂的环境配置,难以控制变量并标准化。

4/8/2025 6:38:00 PM

机器之心

UI-R1|仅136张截图,vivo开源DeepSeek R1式强化学习,提升GUI智能体动作预测

基于规则的强化学习(RL/RFT)已成为替代 SFT 的高效方案,仅需少量样本即可提升模型在特定任务中的表现。 该方法通过预定义奖励函数规避人工标注成本,如 DeepSeek-R1 在数学求解中的成功应用,以及多模态领域在图像定位等任务上的性能突破(通常使用 IOU 作为规则 reward)。 vivo 与香港中文大学的研究团队受到 DeepSeek-R1 的启发,首次将基于规则的强化学习(RL)应用到了 GUI 智能体领域。

4/8/2025 6:33:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

Midjourney

AI新词

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

马斯克

Gemini

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

AI for Science

Agent

苹果

Claude

芯片

腾讯

Stable Diffusion

蛋白质

开发者

xAI

具身智能

生成式

神经网络

机器学习

3D

人形机器人

RAG

AI视频

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

视频生成

生成式AI

场景

DeepMind

深度学习

特斯拉

AI模型

架构

MCP

Transformer

亚马逊

编程

视觉

预测