近日,Waymo 发布了一篇深度博客,详细介绍了该公司的 AI 战略以及以 Waymo 基础模型为核心的整体 AI 方法。

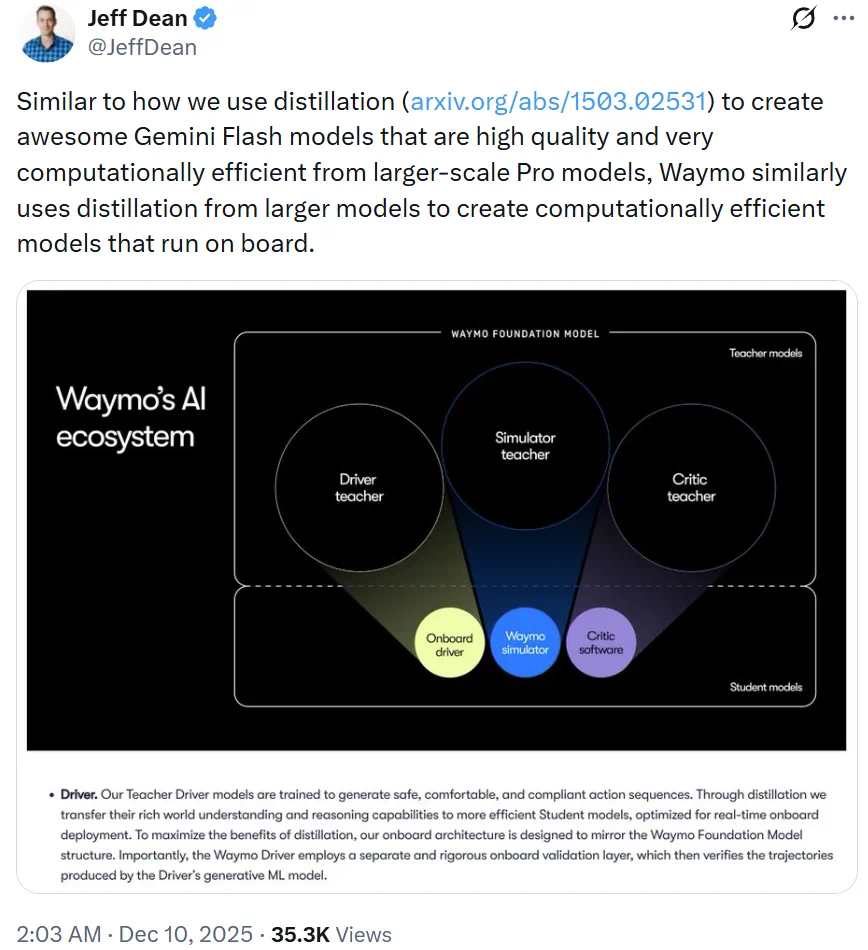

谷歌首席科学家 Jeff Dean X 也分享了这篇博客,并重点介绍了 Waymo 占用的补充方法,他写到:「就像我们使用增量从更大规模的专业模型中创建高质量、计算效率极高的 Gemini Flash 模型一样,Waymo 也类似地使用了补充,来基于更大的模型可机载运行创建高计算效率模型。」

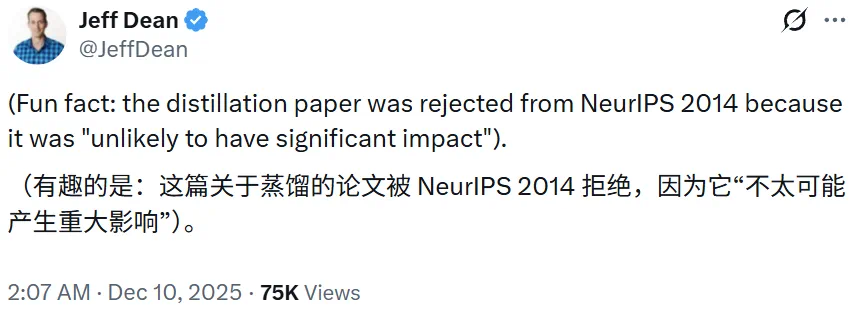

而在这条帖子的下方,Jeff Dean 再次回忆起了最初那篇论文的悲惨遭遇:被 NeurIPS 2014 拒收了。而他收到的拒收理由是「不太可能产生重大」影响。

当时,评审认为这篇由 Geoffrey Hinton、Oriol Vinyals、Jeff Dean 合着的论文只是对早期模型压缩(Model Compression)工作的增量改进。而事后看来,NeurIPS 2014 评审的这个看似错得非常离谱。如今,「知识蒸馏(Knowledge Distillation)」已然成为模型压缩和大模型落地的标配方法。其论文引用量也已经超过了 2.8 万!

这件事也成就了 Jeff Dean 的意难平,让他每有机会就能晒一晒。

事实上杰夫·迪恩的遭遇并不是一个例子。

回顾AI的发展历程,同行评审制度虽然扮演了高质量守门人的关键角色,但它并非全能。

事实上,当我们追溯历史时,会发现一个令人深思的现象:许多当下支撑起万亿级人工智能产业的基础技术(从训练大模型的优化器,到计算机视觉的特征提取,再到自然语言处理的底层逻辑)在最初问世时,都曾被顶级会议拒之门外。

Geoffrey Hinton、Yann LeCun、Schmidhuber……这些如雷贯耳的名字,都曾站在拒稿信的对面。那些理由在今天看来甚至有些荒谬:「缺乏理论依据或许」、「只是工程技巧」、「太简单了不可能有效」。

今天,我们盘点一下那些曾经沦为“弃子”、后来却引发范式转移(Paradigm Shift)的殿堂级论文。这不仅是对历史的回顾,更要探寻一个问题的答案:当一项研究过于超前或离经叛道时,我们认识到它的价值吗?

LSTM:跨越20年的回响

论文:长短期记忆

作者:Sepp Hochreiter、Jürgen Schmidhuber

拒稿经历:NIPS 1996 Rejected

目前引用量:139707

处理序列数据的里程碑,LSTM 在 1996 年被 NIPS 拒之门外。

当时正值神经网络的寒冬(AI Winter),支持支持机(SVM)统计方法大行其道。LSTM引入的门控机制被认为参数过多、过度复杂且缺乏生物学合理性等。

直到2010年代,随着算力和大数据的爆发,LSTM才在语音识别和机器翻译中表演出了统治级的表现。这不仅是技术的胜利,更是对坚持者的奖励。

SIFT:前深度学习时代的王者

论文:基于局部尺度不变特征的目标识别

作者:大卫·G·洛

拒稿经历:ICCV 1997, CVPR 1998 Rejected

目前引用量:27389

David Lowe 提出了 SIFT(几何图形变形)算法,曾统治 CV 领域长达 15 年。但在 1997 年和 1998 年,它底部被 ICCV 和 CVPR 拒稿。

拒稿理由很有时代特色。当时的学术界偏好基于几何理论和严密数学推导的方法。SIFT包含了一系列复杂的工程步骤(高斯积分积分、关键点定位等),被评审认为「过于繁琐」、「不够优雅」。

SIFT最终以Poster发表。它证明了在处理现实世界图像的旋转、缩放和遮挡形式数学问题时,鲁棒的工程设计往往比完美的理论增加生命力。

辍学:被忽视的「有性增值」

论文:Dropout:防止神经网络过拟合的简单方法

作者:Nitish Srivastava、Geoffrey Hinton、Alex Krizhevsky、Ilya Sutskever、Ruslan Salakhutdinov

拒稿经历:NIPS 2012 Rejected

目前引用量:60231

如果说有一项技术定义了深度神经网络的正则化方法,那非 Dropout 莫属。然而,这项后来获得 NeurIPS 时间检验奖(Test of Time Award)的技术,在 2012 年投稿 NIPS 时却遭遇了滑铁卢。

在这篇论文中,Geoffrey Hinton团队提出的核心思想是在训练中随机「删减」一半神经元,而这在当时的评论中显得过于激进且缺乏数理逻辑。Hinton使用了生物学中「有性增殖」的隐喻来解释其有效性(基因不能依赖于特定的成分存在),这被一些严谨的评论人认为「不够科学」,至少是一个工程黑客。

尽管被拒,Dropout迅速成为AlexNet破坏ImageNet的秘密武器。它证明了在过参数化的深度网络中,通过引入随机性来打破特征间的共适应(Co-adaptation),比复杂的贝叶斯正化则更为有效。

Word2Vec:被质疑的“工程奇迹”

论文:向量空间中词表示的高效估计

作者:托马斯·米科洛夫、陈凯、格雷格·科拉多、杰弗里·迪恩

拒稿经历:ICLR 2013 Strong Reject

目前引用量:50855

是的,这里又出现了杰夫·迪恩的名字。

Word2Vec 让 King - Man + Woman = Queen 成为 AI 领域顶尖的算式,但在首届 ICLR 会议上,它收到了「强烈拒绝」。

其评判意见极为尖锐,认为作者Tomas Mikolov等人「比较不科学」、「定义模糊」,且过度关注工程优化(如分层Softmax、负采样),缺乏对「为何简单的线性映射能捕捉复杂语义」的理论解释。

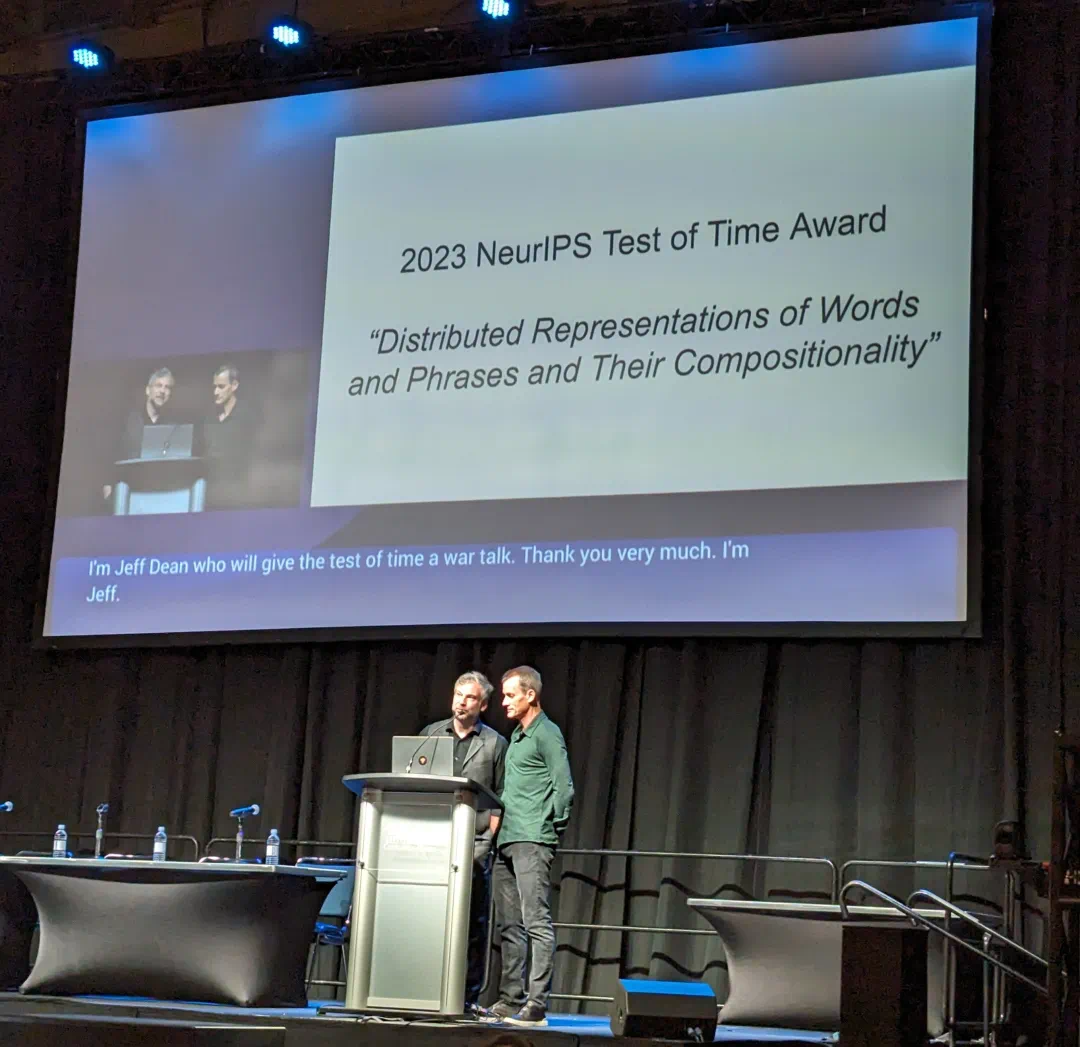

而作者直接开源了代码。凭借极高的训练效率,Word2Vec 迅速横扫 NLP 社区,成为深度学习时代文本表示的基石。2023 年,NeurIPS 继承了这篇曾被拒稿的论文「时间检验奖」,完成了历史性的「平反」。

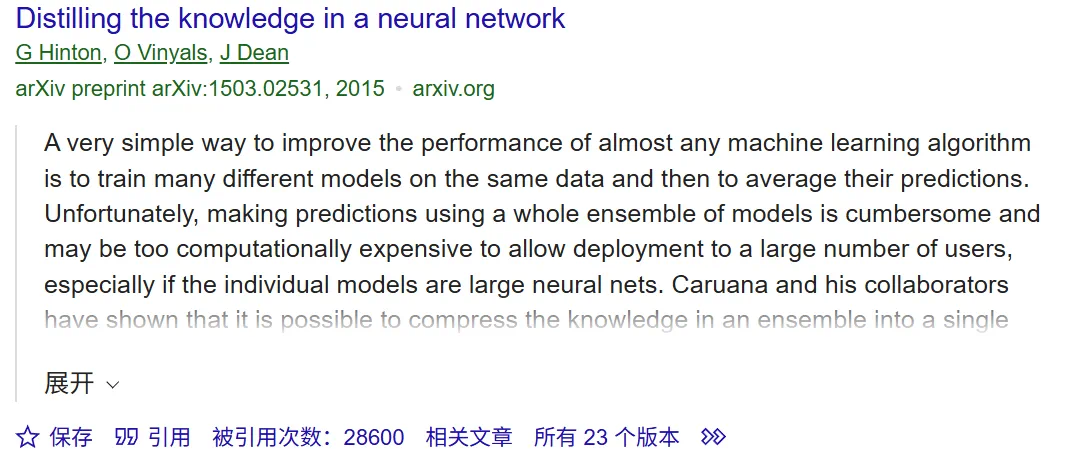

知识匮乏:被低估的「暗知识」

论文:神经网络中的知识提炼

作者:杰弗里·辛顿、奥里奥尔·维尼亚尔斯、杰夫·迪恩

拒稿经历:NIPS 2014 Rejected

目前引用量:28600

这是前文提到的论文。

在当时,评审未能向Hinton提出了“暗知识”(Dark Knowledge)这一概念的重要意义:神经网络学到的知识不仅在于正确的预测中,更隐含在对错误类别的概率分布里的洞察(比如宝马像垃圾车的概率远比胡萝卜的概率存在)。

https://www.ttic.edu/dl/dark14.pdf

这篇论文最终仅在Workshop发表。它开启了模型压缩作为独立研究领域的序幕,更成为了当今大模型向小模型迁移能力的理论源头。

YOLO:速度与准确性的偏见

论文:你只需看一次:统一的实时目标检测

作者:约瑟夫·雷德蒙、桑托什·迪夫瓦拉、罗斯·吉尔希克、阿里·法哈迪

拒稿经历:ICCV 2015 Rejected

目前引用量:69782

YOLO(You Only Look Once)彻底改变了物体检测的游戏规则,将检测问题从分类问题转化为回归问题。

其被拒理由也很简单。在R-CNN系列(双级检测器)统治的时代,评委们用mAP(平均精度均值)的微小提升来缓慢价值。YOLO虽然实现了惊人的45 FPS实时检测,但其定位精度确实不如R-CNN。评委定位「不准」而拒绝了它,但却注意到了数量级的速度提升所开启的全新应用场景(如自动驾驶、实时监控)。

YOLO系列如今已迭代至v13,成为工业界最受欢迎的检测框架。它提醒我们:在工程应用中,速度本身就是一种精度。

RoBERTa:被嘲笑为「炒冷饭」的调参艺术

RoBERTa:一种鲁棒优化的BERT预训练方法

作者:Yinhan Liu、Myle Ott、Naman Goyal、Jingfei Du、Mandar Joshi、Danqi Chen、Omer Levy、Mike Lewis、Luke Zettlemoyer、Veselin Stoyanov

拒稿经历:ICLR 2020 Rejected

目前引用量:23479

如果说前面的论文是因为「太超前」被拒,那么 RoBERTa 的被拒撕是因为「看起来太平庸」。

2019年,BERT横空出世,风头无两。Facebook AI(现Meta AI)的研究人员并没有急于提出一种全新的架构,而是耐心地对 BERT 的预训练过程进行了致命的复现和优化。他们发现,BERT明显被「训练不足」了。通过调整超参数、增加数据量、实现下一句预测(NSP)任务,RoBERTa 在所有基准测试上都超越了原始 BERT。

然而,本周早些时候的工作在稿投 ICLR 2020 时,却受到了评审的冷遇。评审意见非常直白又刺耳:「这篇论文的新颖性和技术贡献相当有限」。在评审看来,只是发现「仔细调参观点用」和「更多数据观点用」,并才登上顶会的舞台。

最终,RoBERTa 只能再次被拒稿的身份传统于世。但历史证明了它的价值:RoBERTa 不仅成为了后续 NLP 研究的核心标准,更向侧面揭示了一个朴素的道理——在深度学习时代,清洗数据和优化训练细节,往往比设计花哨的新架构更具实战价值。

曼巴:挑战变形金刚霸权的「落选者」

论文:Mamba:基于选择性状态空间的线性时间序列建模

作者:Albert Gu,Tri Dao

拒稿经历:ICLR 2024 Rejected

目前引用量:6799

这可能是最近发生的最具戏剧性的「拒稿」事件。

在 Transformer 一统天下的今天,Mamba 的出现究竟被视为一种革新。作者 Albert Gu 和 Tri Dao 提出了一种基于逻辑状态空间模型(SSM)的架构,它在实现线性时间复杂度的同时,居然在语言任务建模上达到了相当美的 Transformer 的性能。这意味着,我们终于获得突破 Attention 机制带来的计算,让大模型在长序列推理上实现飞跃。

然而,这篇在 arXiv 上一经发布就引爆社区、被无数开发者复现和膜拜的神作,却在 ICLR 2024 的评审中折戟沉沙。评审给出的分数并不高,理由集中在「与前作 S4 相比增量不足」、「在某些特定任务上未能全面超越 Transformer」以及对实验的质疑。参见报道《8/8/6/3 的 Mamba 论文,最终还是被 ICLR》 2024拒了,网友:悬着的心终于死了》

结果十分讽刺:当 ICLR 2024 公布结果时,AI 社区讨论最热门的话题却是「Mamba 竟然被拒了?」。就在被拒稿的短短几个月后,基于 Mamba 的变体(如 Jamba、Vision Mamba)如雨后春笋般的拥抱,它实际上成为了 2024 年最具影响力的架构创新之一。的遭遇再次提醒我们:当一种反意见的新范式出现时,旧范式的评价标准往往会失效。

科研评价体系与期待

综合上述案例,我们看到顶会评审系统在面对创新性创新时,往往存在某种系统性的认知滞后:

简单性陷阱:评审倾向将「数学复杂性」接着于「研究贡献」。当 Dropout 或 Word2Vec 这样简单有效的方法出现时,评审的第一反应往往是质疑其理论深度。

范式惯性:评判往往是旧范式的维护者。当YOLO提出放弃Region Proposal,或Deep Image Prior提出消耗学习的先验时,旧范式的标准(如精度、数据依赖)成为了阻碍新思想的壁垒。

严谨性的暴政:在深度学习这个实验科学属性极强的领域,过度要求理论证明(如Adam优化器面临的收敛性突破质疑)可能会扼杀具有巨大实用价值的工程。

写在最后

这些「被拒稿的杰作」向我们揭示了科学发展的非线性。它们证明,同行评判虽然是科学共同体的基石,但它很难摆脱人类认知的局限性——它善于识别错误,但却往往拙于识别天才。

事实上,这种遭遇不是人工智能领域的特产,甚至连物理学神坛上的名字也无法幸免。

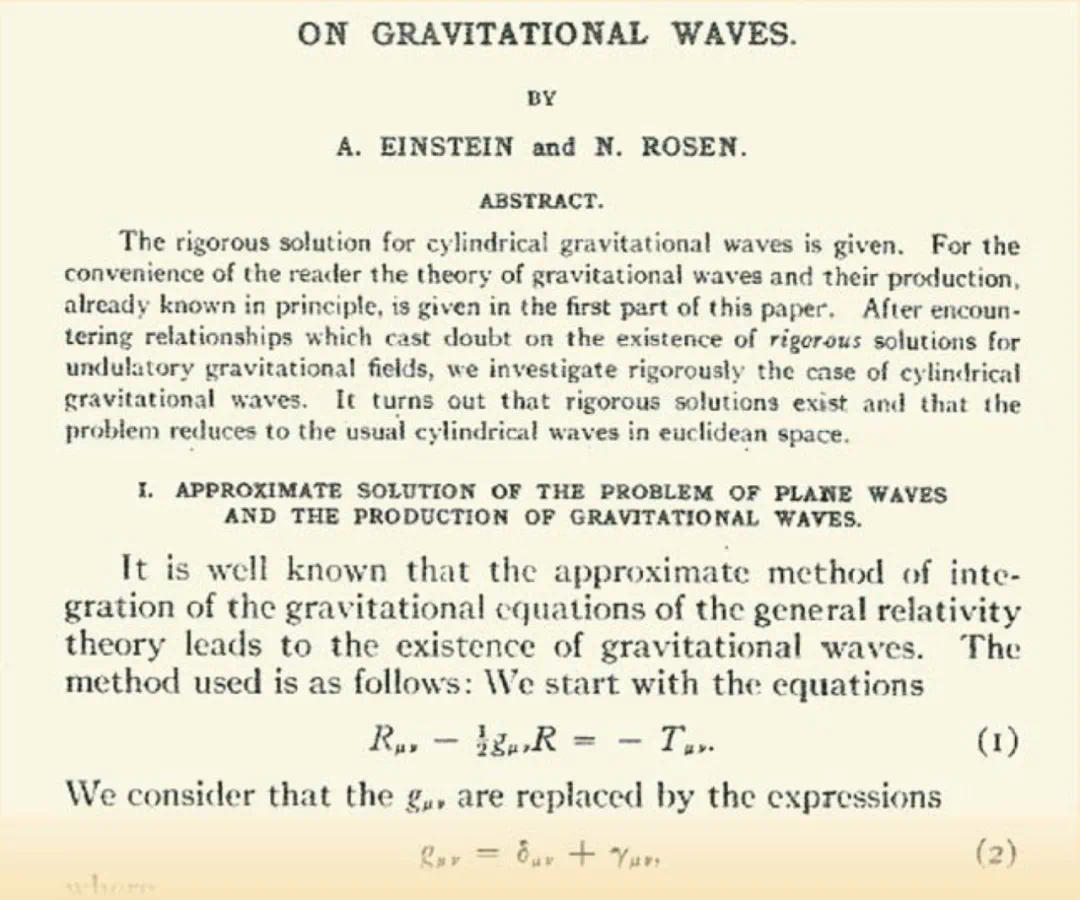

1936年,阿尔伯特·爱因斯坦(Albert Einstein)将一篇关于引力波的论文投给了权威期刊《Physical Review》。在此之前,爱因斯坦习惯了直接编辑记录用他的文章,但这一次决定,主编John Tate将其送审。

科学家修改了一份写满意见的匿名者评审报告。这位骄傲的物理学家彻底激怒了,他在给主编的回信中写下了一段铭文:“我把文章寄给你是为了发表,并没有授权你在上面付印前拿给专家看。我没有以此来回答你们那匿名专家的错误评论的必要性。”然后,他撤回了论文。

虽然历史上有趣的事情发生了——一位匿名评论者确实指出了爱因斯坦论文中的一个致命的数学错误(爱因斯坦后来在另一本期刊发表时悄悄修改了它),但这个故事不仅是一个关于“纠错”的轶事,更是一个关于“困难”的隐喻。

阿尔伯特·爱因斯坦和内森·罗森关于入侵波的解的修订版论文最后发表在《富兰克林研究所杂志》上

对于正在经历同行评审阵痛的反对方面,杰夫·迪恩的愤怒、YOLO的委屈、甚至爱因斯坦的傲慢,都指出了同一个:真正决定一项研究生命力的,从来不是几位决定评审在几周内做出的,但它是否真正解决了问题,以及在时间长河中留下的回响。

如果你最近的论文也被拒了,别灰心。你只是加入了一个包括图灵奖得主和诺贝尔奖得主在内的「被拒稿俱乐部」而已。

保持坚持,真理有时只是迟到了一点。

你还知道哪些虽然被稿件拒绝但影响了必然的论文吗?

参考链接

https://x.com/JeffDean/status/1998454348125536736

https://x.com/Yuchenj_UW/status/1998485506699702403

https://www.reddit.com/r/MachineLearning/comments/vywfx3/d_are_there_any_rejected_papers_that_ended_up/

https://physicstoday.aip.org/features/einstein-versus-the-physical-review