IBM 本月 2 日介绍了其 Granite 4.0 系列模型中的最小版本之一:Granite 4.0 Tiny 的预览版本。

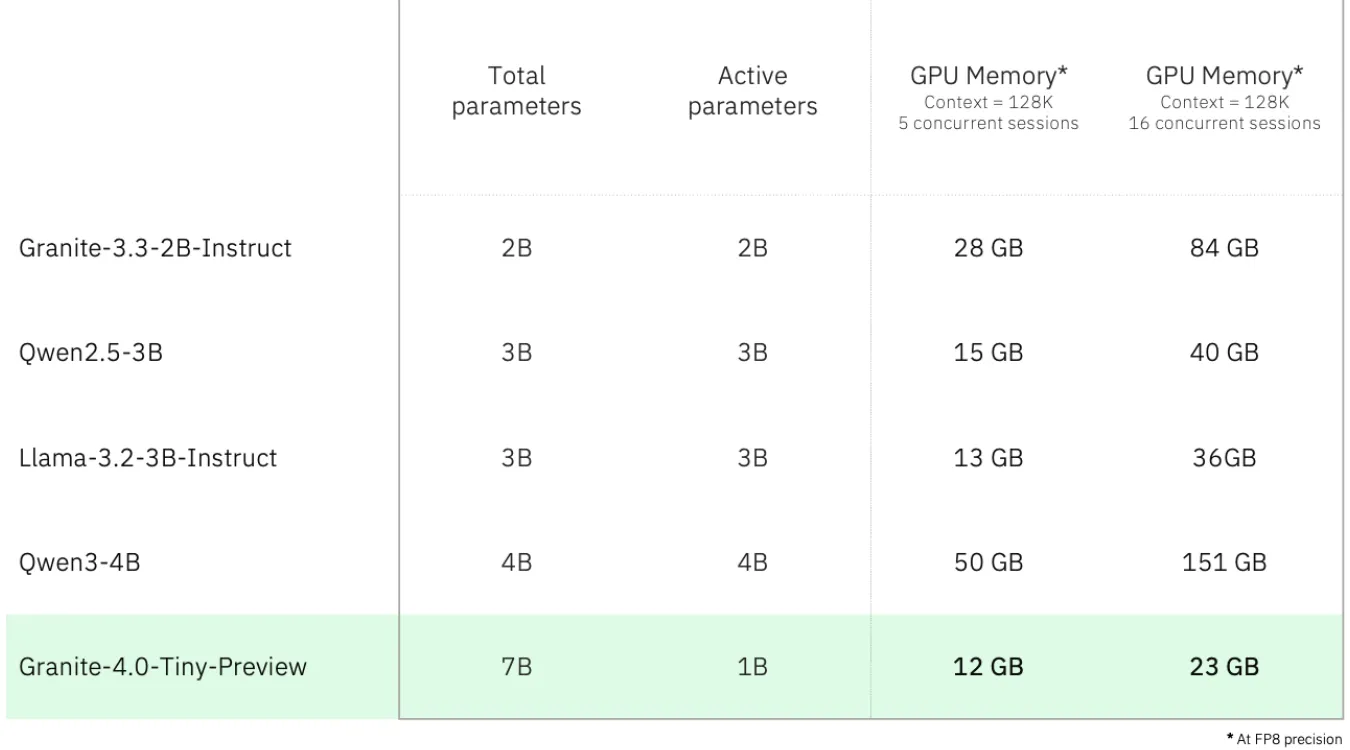

Granite 4.0 Tiny Preview 的优势在于高计算效率和低内存需求:在 FP8 精度下,运行 5 个 128KB 上下文窗口的并发对话仅需 12GB 显存,一张建议零售价 329 美元(AI在线注:现汇率约合 2383 元人民币)的英伟达 GeForce RTX 3060 12GB 消费级显卡即可满足。

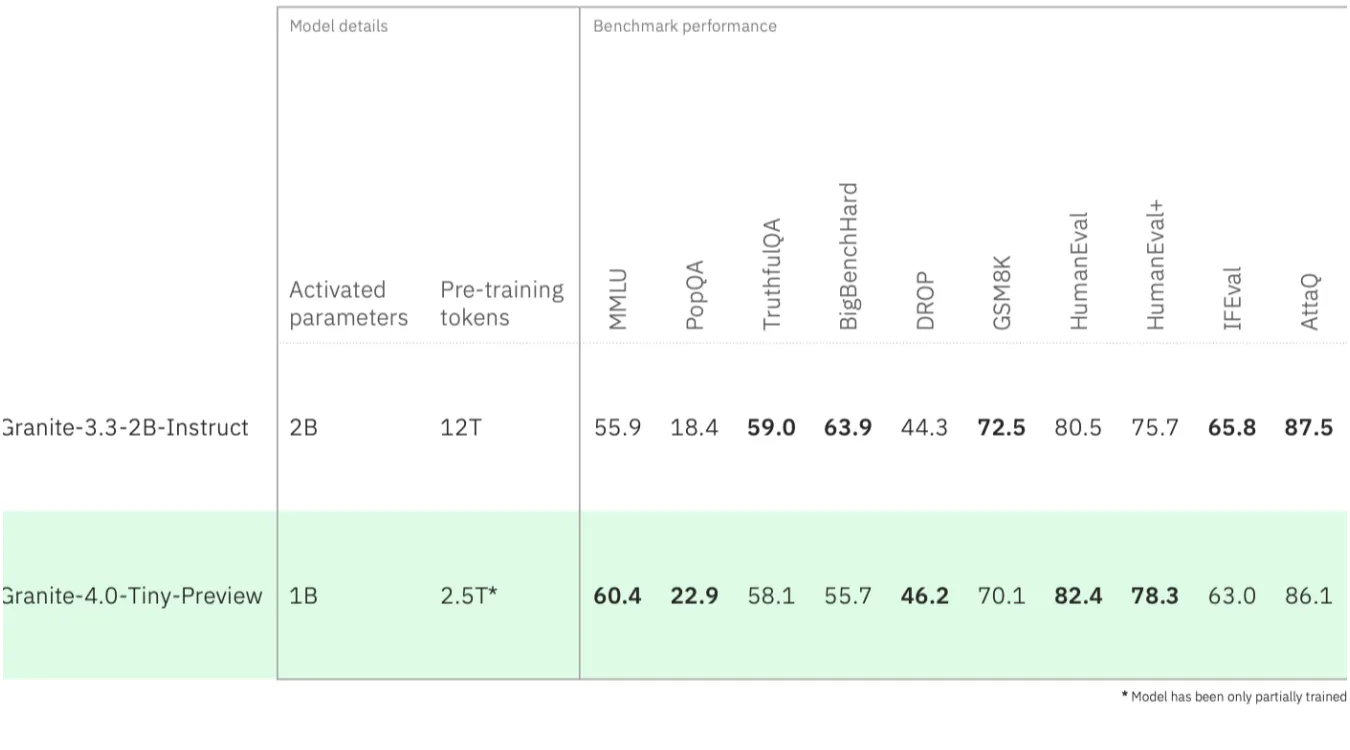

Granite 4.0 Tiny 计划的训练 Token 数至少为 15T,目前 Preview 预览版本仅训练了 2.5T,但已能提供与 12T 训练 Token 的 Granite 3.3 2B Instruct 相当的性能,同时在 128KB 上下文窗口 16 并发会话下内存需求降低了约 72%,预计最终性能可与 Granite 3.3 8B Instruct 相当。

Granite 4.0 Tiny Preview 的总参数规模为 7B,实际活动参数为 1B,其基于被 Granite 4.0 系列全线采用的混合 Mamba-2 / Transformer 架构,结合了两者的速度与精度,降低了内存消耗而不明显损失性能。

Granite 4.0 Tiny 的预览版本现已在 Hugging Face 上以标准 Apache 2.0 许可证提供,IBM 将于今年夏天正式推出 Granite 4.0 系列模型的 Tiny 和 Small、Medium 版本。