大家好,我是小寒

今天给大家分享一个超强的算法模型,LSTM。

LSTM(长短期记忆网络,Long Short-Term Memory)是一种特殊的循环神经网络(RNN)算法,专门设计用来解决传统RNN在处理长序列数据时存在的梯度消失和梯度爆炸问题。

它通过引入细胞状态和门控机制,使得模型能够捕捉和保存长期依赖信息,从而有效地处理序列数据中的长期依赖关系。

LSTM 广泛应用于自然语言处理、语音识别、时间序列预测等领域。

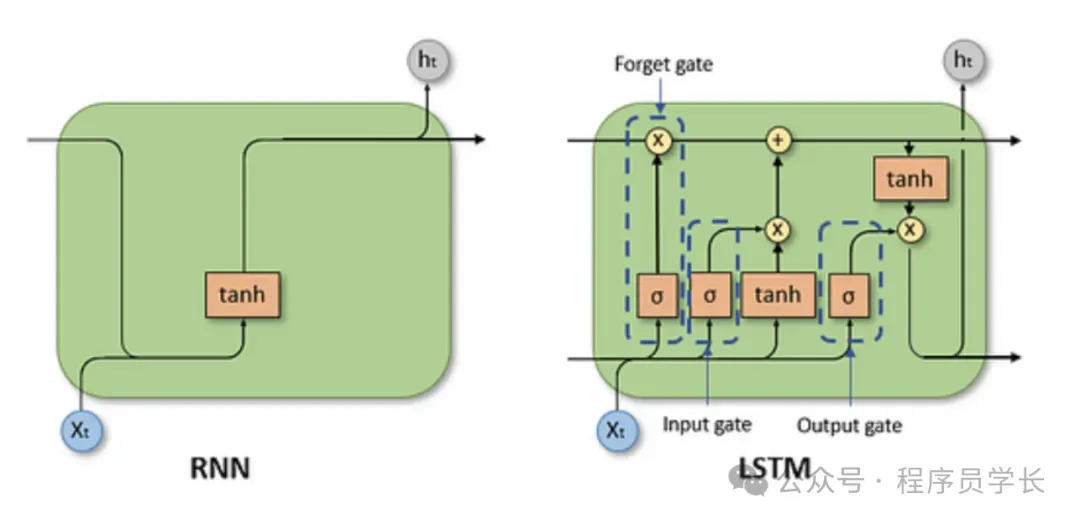

LSTM 的基本结构和原理

LSTM 的核心思想

传统的 RNN 在处理长序列时,由于信息在时间步长上的反向传播,导致靠近输入端的梯度变得非常小或非常大,从而使得模型难以学习到长期依赖关系。

LSTM 的核心思想是通过引入门控机制来控制信息的流动,从而有效地“记住”重要的信息并“遗忘”不重要的信息,解决了长期依赖问题。

LSTM 单元内部包含一个细胞状态 (cell state),可以看作是信息流动的 “高速公路”,它直接穿过整个链条,只进行少量的线性交互。信息可以通过门控机制被添加到细胞状态或从中移除。

基本结构

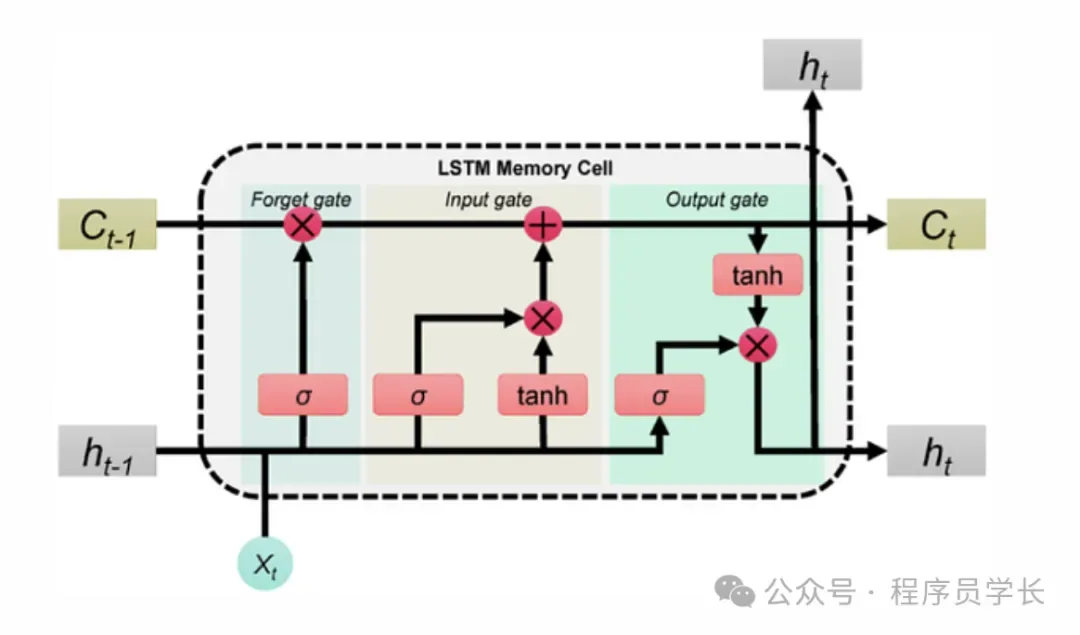

LSTM 单元主要由以下几个部分组成。

- 细胞状态:这是 LSTM 的核心,可以看作是网络的 “记忆单元”。它能够沿着时间链传输信息,并且只受到门控单元的少量线性交互。

- 遗忘门:决定细胞状态中哪些信息需要被丢弃。

- 输入门:决定当前输入中哪些信息需要写入细胞状态。

- 输出门:决定当前细胞状态中哪些信息应该被输出。

通过这三个门的控制,LSTM 能够选择性地保留和丢弃信息,从而有效捕捉长期依赖。

LSTM 的数学公式

假设在时刻 t,输入为 xt,前一时刻隐藏状态为 ht-1,前一时刻细胞状态为 Ct-1。

LSTM 的计算过程如下

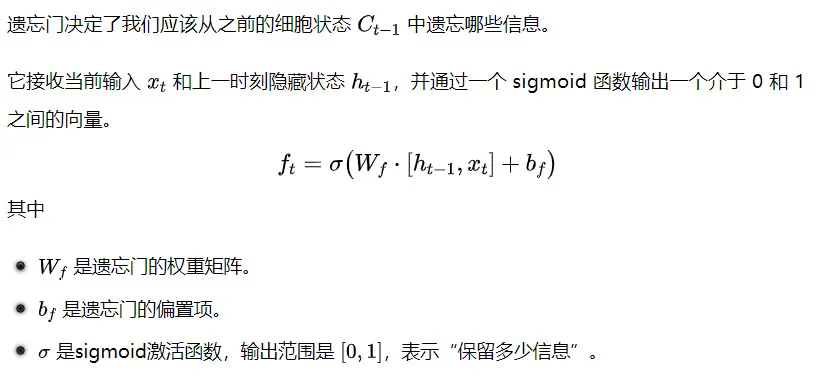

1.遗忘门

2.输入门

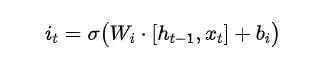

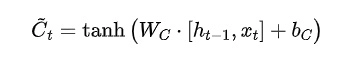

输入门决定了有多少新的信息要添加到细胞状态中。它包含两个部分:

这包括两个部分

- 输入门层决定哪些值将被更新。

- 候选细胞状态产生新的候选信息向量,准备加入到细胞状态中。

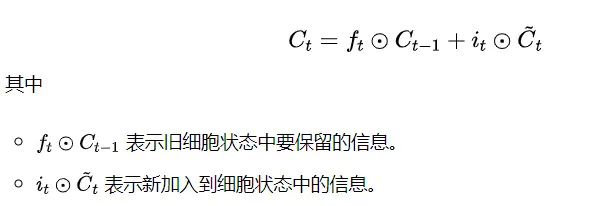

3.更新细胞状态

细胞状态结合遗忘门和输入门的结果进行更新。

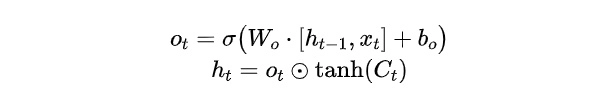

4.输出门

输出门决定了细胞状态中有哪些信息将被 “输出” 作为当前时间步的隐藏状态 ht。

LSTM 的优势

- 解决长期依赖问题:LSTM 能够有效地捕获和利用序列中远距离的依赖关系,这是其最显著的优势。

- 更好的梯度流动:门控机制确保了梯度在反向传播时能够更好地流动,缓解了梯度消失问题。

- 适用于各种序列任务:在语音识别、自然语言处理(机器翻译、文本生成、情感分析)、时间序列预测等领域表现出色。

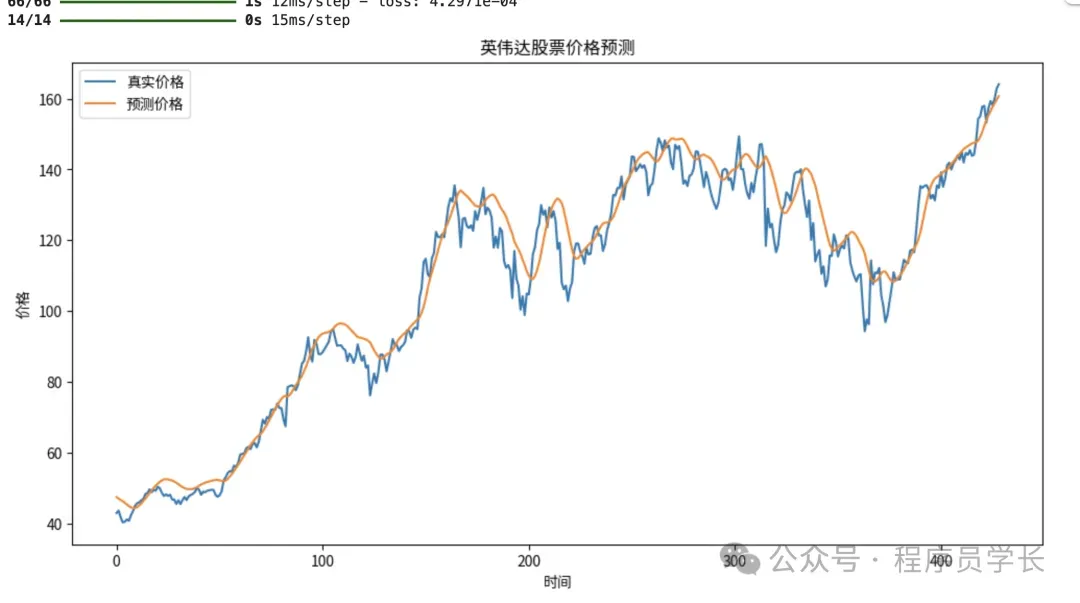

案例分享

下面是一个使用 LSTM 算法预测英伟达(NVIDIA,股票代码NVDA)股票价格的示例代码。代码会用 Python 和 TensorFlow/Keras 实现,流程包括数据获取、预处理、模型构建、训练和预测。