大家好,我是肆〇柒。这篇论文的研究来自 MetaGPT、Montréal & Mila人工智能研究所、南洋理工大学、美国阿贡国家实验室、悉尼大学、宾夕法尼亚州立大学、微软亚洲研究院、伊利诺伊大学厄巴纳-香槟分校、香港科技大学、南加州大学、耶鲁大学、斯坦福大学、佐治亚大学、俄亥俄州立大学、阿卜杜拉国王科技大学、杜克大学、香港理工大学、谷歌 DeepMind 以及加拿大高等研究院(CIFAR)等众多研究者的集体智慧与前瞻思考,历时半年创作而成。

这篇论文的质量很高,为我们综述了 AI Agent 领域的全景现状,能看的出来是花了大心思的。其实,我很早就看到了相关作者在朋友圈的发布:

我读了一段时间,共 264 页,1416 篇外部论文、资料的引用,坦白讲,这很花精力;我没有快速产出综述,是因为这个论文真的太长了,却又比较有价值。但学习就是这样,越是花精力的事情,就越应该坚持面对它。在这之前的很多天,我每天抽一点时间出来阅读这篇论文,甚至包括它引用的材料。所以,为了学习的需要,我将它消化整理为6万字的综述,一方面给自己留下一份笔记;另一方面,希望能为同样对AI感兴趣的你,减轻对在这篇论文的阅读负担。但让我意外的是,当我要发布文章的时候,发现微信公众号的文章最大限制是5万字。

写作目的与目标读者

- 写作目的 :本文致力于为读者呈现一幅智能体技术的全景图,从基础理论到前沿实践,全面剖析智能体的核心模块和工作机制。目的是帮助读者深入理解智能体的本质,把握其技术脉络和发展趋势,为从事相关领域的研究和开发提供坚实的理论基础和有益的实践指导。

- 目标读者定位 :无论是从事人工智能研究的专业人员,还是在高校学习相关专业的学生;无论是制定政策的政府部门工作人员,还是关注技术应用的行业从业者,本文都将是一份有价值的参考资料。期望通过深入浅出的讲解和丰富的实例,满足读者对智能体知识的渴望,激发人们在这一领域的探索和创新热情。

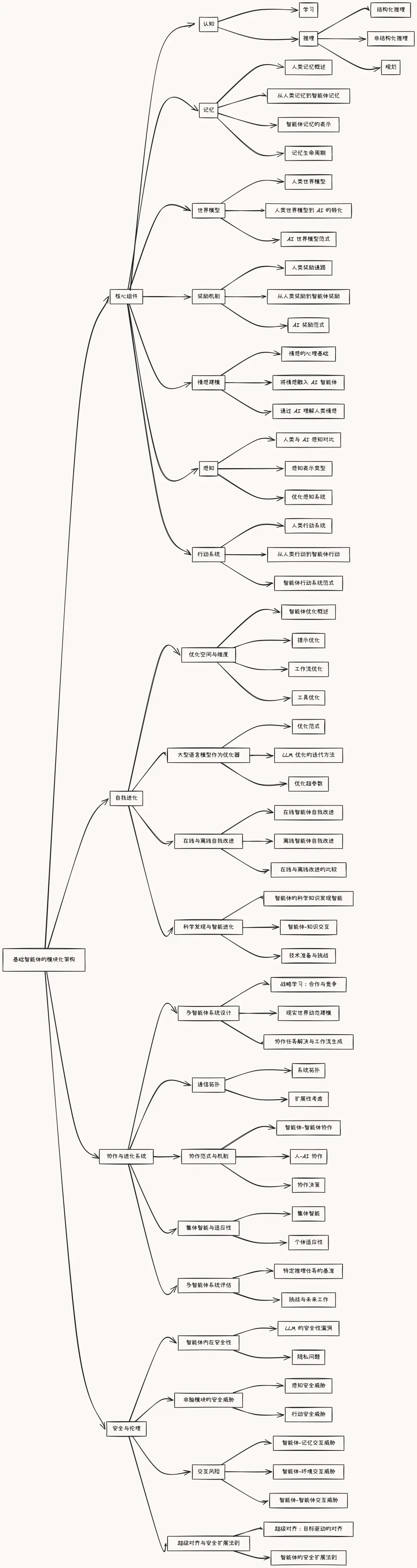

好了,不说更多废话了,下面我们一起来阅读这篇综述,下图是本综述的架构。

引 大型语言模型(LLM)的出现推动了人工智能的变革性转变,为具有复杂推理、强大感知和跨领域灵活行动能力的先进智能体铺平了道路。随着这些智能体越来越多地推动人工智能研究和实际应用,它们的设计、评估和持续改进面临着复杂、多方面的挑战。本文提供了全面概述,将智能体置于模块化、脑启发的架构中,该架构整合了认知科学、神经科学和计算研究的原则。本文将研究者的探索分为四个相互关联的部分。

第一部分,我们深入研究智能体的模块化基础,系统地将其认知、感知和操作模块映射到类似的人类大脑功能,并阐明核心组件,如记忆、世界建模、奖励处理和类似情感的系统。 第二部分,我们讨论自我增强和自适应进化机制,探讨智能体如何自主优化其能力,适应动态环境,并通过自动化优化范式实现持续学习,包括新兴的 AutoML 和 LLM 驱动优化策略。第三部分,我们研究协作和进化多代理系统,调查智能体交互、合作和社会结构中产生的集体智慧,强调与人类社会动态的相似之处。第四部分,我们解决构建安全、可靠和有益的 AI 系统的关键紧迫任务,强调内在和外在安全威胁、道德一致性、鲁棒性和必要的实际缓解策略,以实现可信赖的现实部署。通过综合不同学科的见解与模块化 AI 架构,本综述确定了关键研究差距、挑战和机遇,鼓励创新,使技术进步与有意义的社会效益相协调。

上篇

第一部分 智能体的奥秘从认知到行动的全方位解析

现在,我们开始正事,来深入探索智能体的核心模块,从认知的基石到行动的延展,揭开智能体神秘的面纱。

智能体的崛起与发展

- 智能体概念的起源 :智能体的概念可追溯至人工智能发展的早期阶段,当时研究人员试图构建能够模拟人类智能行为的系统。从最初的专家系统到如今的深度学习驱动的智能体,这一领域经历了漫长而曲折的发展历程。早期的智能体往往基于规则,依赖于人类专家的知识进行编程,以解决特定领域的问题。然而,这种方法在面对复杂多变的现实世界时显得力不从心。

- 现代智能体的重要性 :随着机器学习技术的飞速发展,尤其是深度学习的兴起,智能体迎来了新的春天。现代智能体不再局限于简单的规则执行,而是能够通过学习从数据中提取模式和知识,从而在各种环境中实现自主决策和行动。它们在众多领域展现出了巨大的潜力,如自动驾驶、智能助手、游戏 AI 等,成为推动人工智能技术进步和应用落地的核心力量。

- 当前研究的挑战与机遇 :尽管智能体技术取得了显著进展,但仍然面临着诸多挑战。如何提升智能体的适应性,使其能够在动态环境中快速调整策略;如何增强智能体的可解释性,以便人类更好地理解和信任它们的决策过程;以及如何确保智能体的行为符合伦理和安全标准,都是当前研究需要解决的问题。同时,硬件技术的不断突破、大数据的涌现以及算法的持续创新,也为智能体的发展带来了前所未有的机遇。

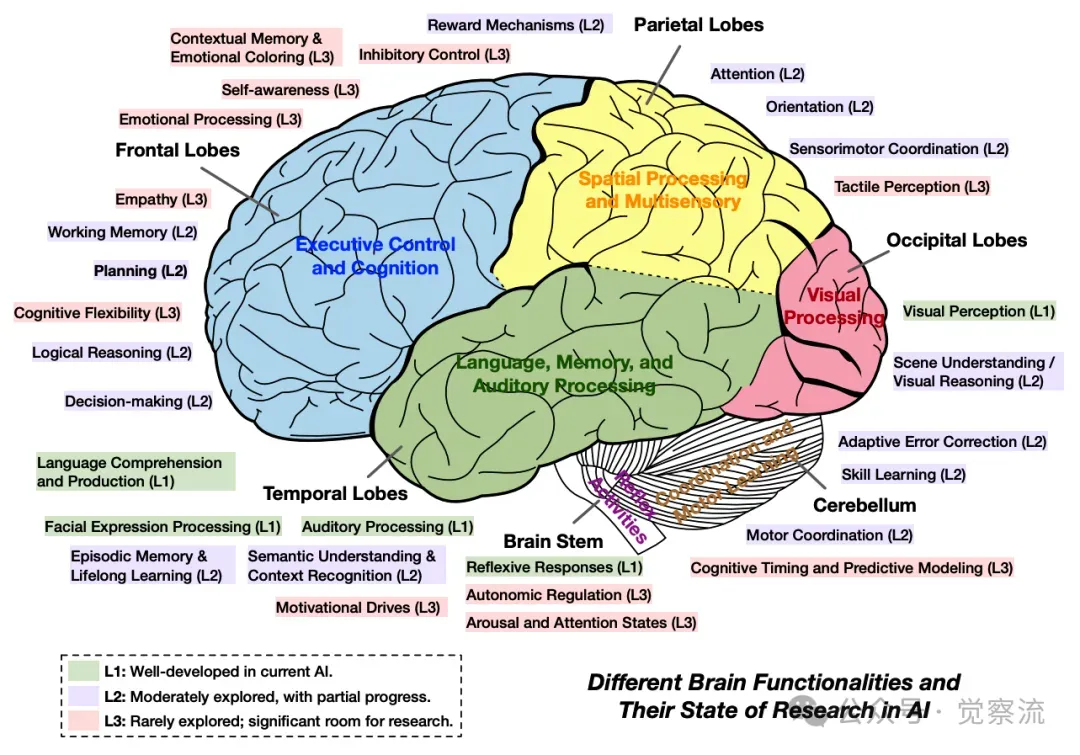

根据当前 AI 研究中的探索水平,按主要大脑区域对关键人类脑功能进行分组说明

上图展示了人类大脑功能区域及其在人工智能研究中的探索水平,帮助我们更好地理解智能体技术的发展方向和潜在机会。从图中可以看出,尽管我们在某些领域已经取得了显著进展,但仍有许多未被充分探索的区域,这些区域为未来的研究提供了广阔的空间。

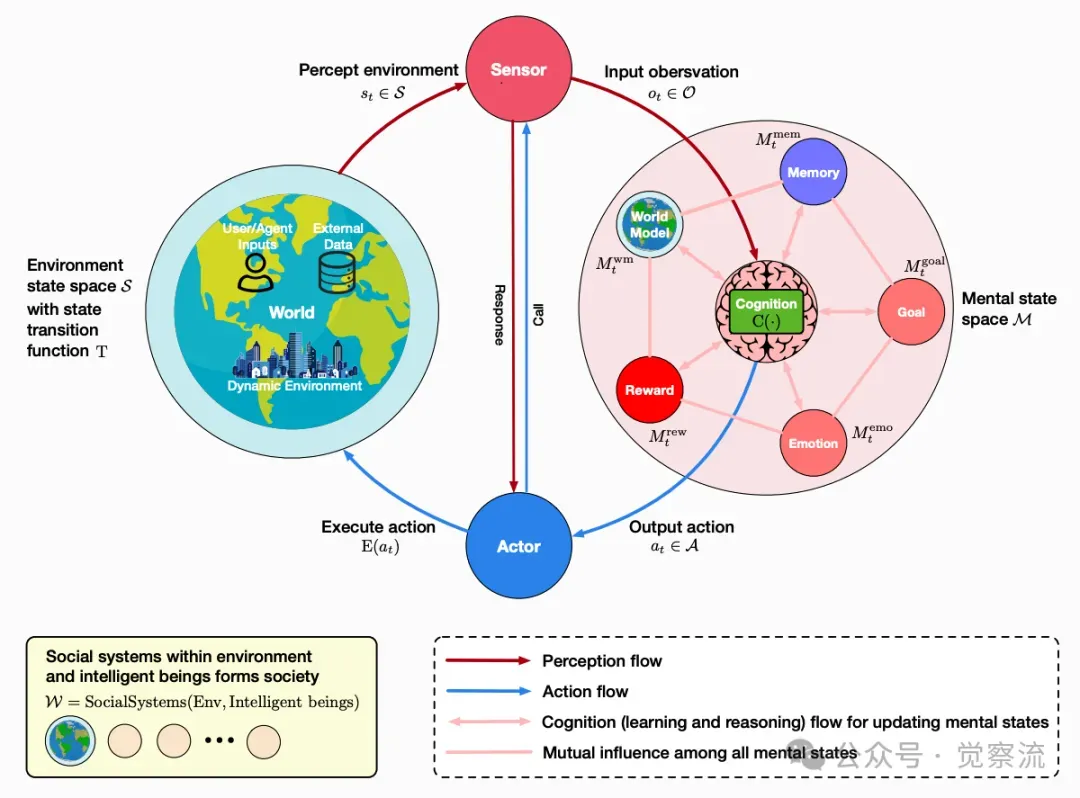

在深入探讨智能体的各个核心模块之前,我们先来了解一下智能体的整体架构及其在社会中的运作方式。下图提供了一个关于智能体循环和智能体社会的通用框架的概览,展示了智能体如何在感知、认知、行动的循环中与环境和社会系统交互。这个框架不仅帮助我们理解单个智能体的工作原理,还揭示了智能体在更广泛的社会环境中如何形成复杂的交互模式。通过这个框架,我们可以更好地理解智能体技术的整体结构和其在现实世界中的应用潜力。

描述智能体循环和智能体社会的通用框架概览

一、智能体的认知基础

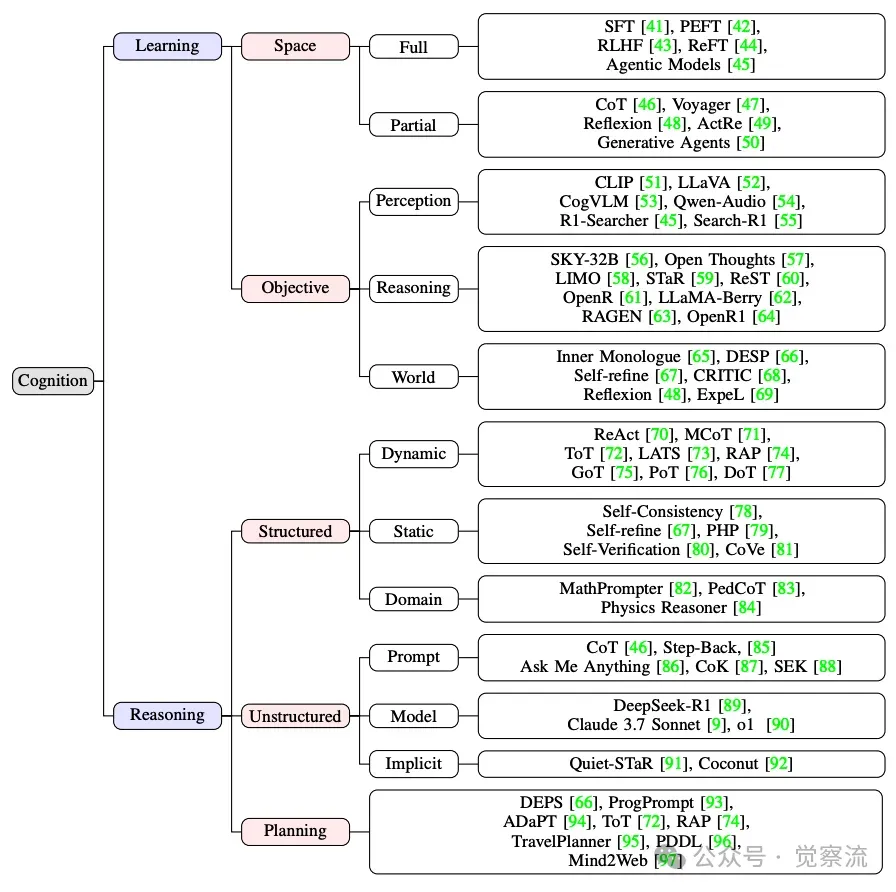

如下图示是认知系统的示例性分类,包括学习和推理范式。

认知系统的示例性分类

(一)学习机制

- 学习空间与维度 :

- 全局学习方法解析 :全局学习着眼于智能体整体能力的提升。预训练是全局学习的基础阶段,通过在大规模数据集上进行无监督或自监督学习,智能体能够吸收广泛的知识和模式,为其后续的特定任务学习奠定坚实基础。例如,语言模型在海量文本上的预训练,使其掌握了语言的语法、语义等基本规律。指令微调则是在预训练模型的基础上,利用带有明确指令和相应输出的人工标注数据,进一步优化模型参数,使智能体能够更加准确地理解和执行各种任务指令。基于提示的学习则更加灵活,通过巧妙设计提示(prompt),引导智能体在特定情境下产生符合预期的输出,无需对模型进行大规模的参数更新。

- 局部学习的关键作用 :局部学习专注于智能体心理状态的特定认知组件的优化。在记忆组件中,学习表现为对信息编码、存储和检索方式的改进,以便智能体能够更高效地利用记忆中的知识进行推理和决策。对于世界模型组件,局部学习则是通过与环境的交互数据不断调整和精化智能体对环境的内部表征,使其能够更准确地预测环境的变化和结果。

- 学习目标的多维度提升 :

- 感知理解能力的强化手段 :多模态感知学习是提升智能体感知理解能力的重要途径。通过融合视觉、听觉、触觉等多种感知模态的数据,智能体能够更全面地感知环境,捕捉到单一模态所无法提供的丰富信息。例如,在自动驾驶场景中,结合摄像头的视觉图像、雷达的距离信息和麦克风的音频信号,智能体可以更准确地感知周围交通状况、识别潜在危险。检索增强机制则为智能体提供了一种利用外部知识的高效方式。当智能体面临复杂问题时,能够通过检索外部数据库或知识图谱中的相关信息,迅速扩展自己的知识边界,增强对问题的理解和解决能力。

- 推理能力的优化策略 :结构化推理方法通过建立明确的逻辑规则和推理步骤,帮助智能体进行严谨的逻辑推理。例如,在数学问题求解中,智能体可以按照预设的推理模板,逐步分析问题条件,应用数学定理和公式,最终得出正确的答案。非结构化推理方法则更加灵活,智能体能够根据输入数据的特征和模式,自适应地调整推理路径,适用于处理复杂、不确定的信息。例如,在自然语言理解中,智能体可以依据上下文语境和语义关联,对文本进行灵活解读,挖掘潜在含义。

- 世界知识的构建与积累 :智能体通过持续不断地与环境进行交互,收集大量的感知数据和经验样本。基于这些数据,智能体运用机器学习算法,如强化学习和监督学习,逐步构建起对世界的深刻理解。例如,在机器人探索未知环境的过程中,它通过不断地移动、感知和试错,学习到环境的布局、物体的属性和行为模式,从而建立起丰富的世界知识库。

(二)推理机制

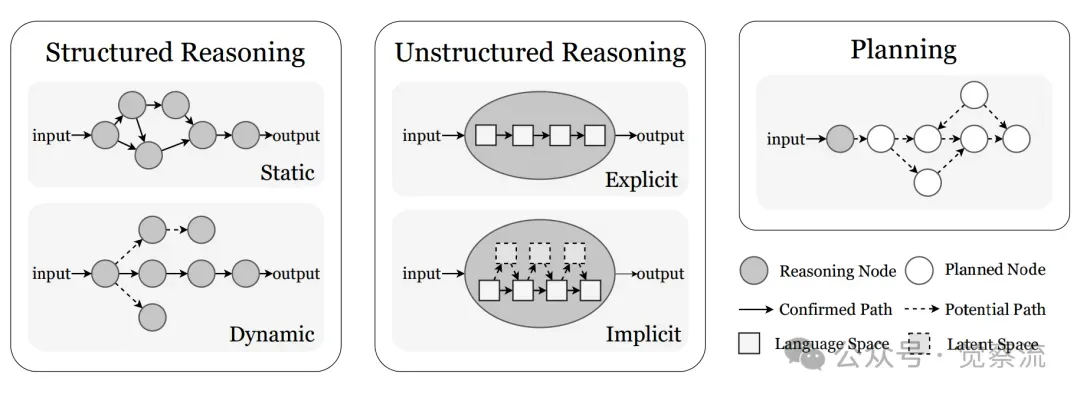

在探讨推理方法之前,我们先来对比一下结构化和非结构化推理方法的特点。

基于 LLM 的智能体推理范式的比较

上图展示了这两种推理范式在 LLM 基础智能体中的对比。从图中可以看出,结构化推理方法强调逻辑步骤的明确性和可解释性,而非结构化推理方法则更加灵活,能够处理复杂、多变的信息。

- 结构化推理方法的深度剖析 :

- 动态推理结构的多样性 :线性序列推理按照固定的步骤顺序执行推理任务,每一步的输出作为下一步的输入,适用于具有明确流程的问题求解。基于规划的推理则以目标为导向,通过分解目标和寻找实现目标的行动序列,构建出从当前状态到目标状态的路径。树搜索方法通过构建树状结构来表示问题的解空间,智能体可以在树中进行深度优先搜索或广度优先搜索,寻找最优解。图推理则将问题表示为图结构,利用图的特性进行推理,适用于具有复杂关系和相互依赖的问题。

- 静态推理结构的特点与应用 :基于固定框架的推理方法,如自我一致性方法,通过生成多个推理路径并进行相互验证,提高推理的准确性和可靠性。集成方法则结合多个模型或推理策略的输出,利用集成学习的优势,提升整体推理性能。这些方法在处理具有固定模式或结构化数据的问题时表现出色,但在面对复杂多变的动态环境时,可能需要与动态推理结构相结合,以发挥更大的优势。

- 非结构化推理方法的独特魅力 :

- 提示驱动推理的技巧与方法论 :链式思考(CoT)变体通过逐步展开推理步骤,使智能体能够深入分析问题并逐步解决问题。例如,在解决数学应用题时,智能体可以先分解问题,然后逐步推导出答案。问题重构策略则通过重新表述问题或从不同角度看待问题,帮助智能体打破思维定式,寻找新的解决方案。基于模型的推理利用智能体的内部世界模型,根据输入数据生成相应的推理路径,适用于处理需要基于背景知识进行推理的场景。

- 隐式推理的优势与局限性 :Quiet - STaR 方法通过在推理过程中生成内部的解释和思考,使智能体能够更好地理解和解决问题。Coconut 方法则在推理过程中利用潜在空间,使智能体能够在不直接暴露推理过程的情况下进行思考。隐式推理的优势在于它能够减少生成的 token 数量,提高推理效率,同时还能使智能体在推理过程中产生更高级的推理模式。然而,其局限性在于对训练数据的固定模式依赖较强,泛化能力相对较弱。

- 规划作为特殊推理形式的深入探索 :

- 规划的定义与重要性 :规划是从初始状态到目标状态的路径构建过程,是智能体实现复杂任务的关键能力。它能够帮助智能体提前规划行动步骤,合理分配资源,提高任务完成的效率和成功率。

- 规划面临的挑战与应对策略 :世界知识的缺乏可能导致智能体无法准确预测环境的变化和结果,从而影响规划的准确性。动态规划能力不足则可能使智能体在面对动态环境时无法及时调整规划。为应对这些挑战,智能体可以通过与环境的持续交互,不断积累经验,丰富世界知识库;同时,结合先进的搜索算法和在线规划技术,提升动态规划能力。

- 规划方法的详细阐述 :任务分解方法将复杂任务分解为多个子任务,智能体可以逐一解决这些子任务,最终实现整体目标。搜索优化方法通过在解空间中进行高效搜索,寻找最优的行动路径。外部知识整合方法则利用外部知识库或专家系统中的信息,为智能体提供更多的规划参考和指导。

二、智能体的记忆管理

(一)人类记忆的概述

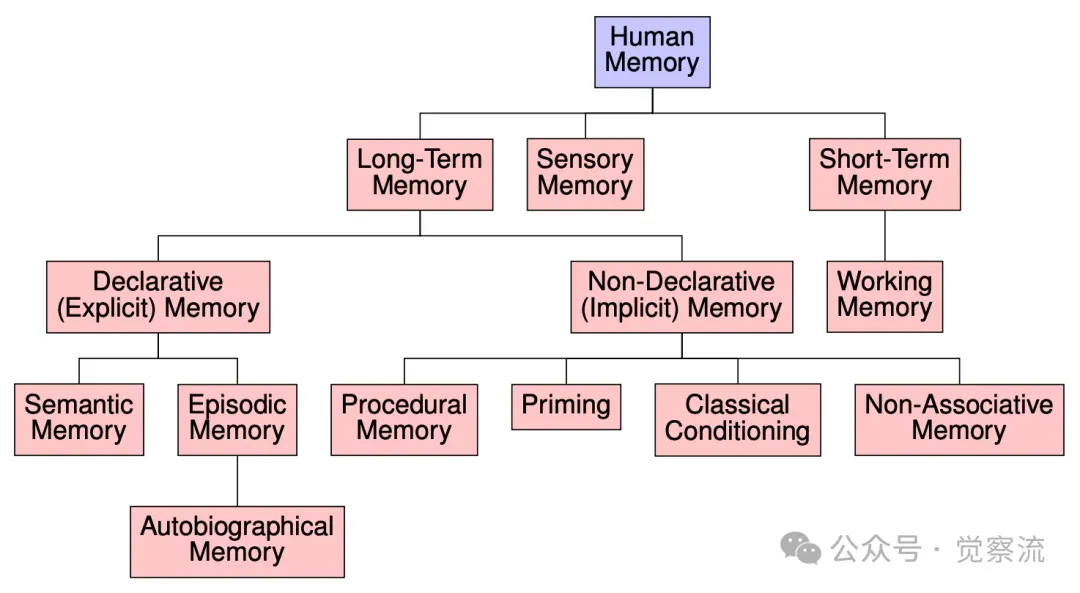

如下图展示人类记忆系统的分层分类体系。

人类记忆系统的层级分类

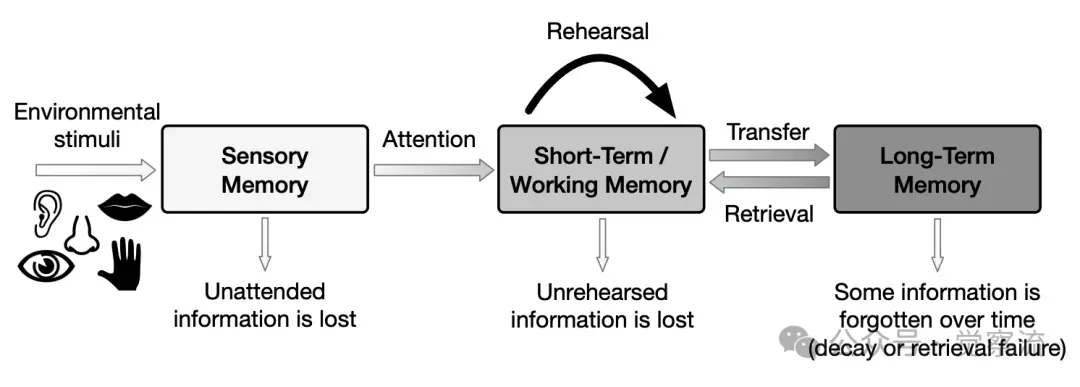

1.人类记忆的类型 :人类记忆是一个复杂而精妙的系统,主要包括感觉记忆、短时记忆(工作记忆)和长时记忆。为了更直观地理解这些记忆类型及其相互关系,我们可以参考经典的 Atkinson - Shiffrin 三阶段模型。

Atkinson-Shiffrin 人类记忆三阶段模型这个模型将记忆分为三个主要阶段:感觉记忆、短时记忆和长时记忆,展示了信息从感知到存储再到提取的过程。 感觉记忆是记忆的最初阶段,它对来自环境的原始感觉信息进行瞬间的记录和存储,具有容量大、持续时间短的特点。例如,当我们看到一幅美丽的画面时,视觉感觉记忆能够短暂地保留画面的细节信息,为我们进一步的视觉处理提供基础。 短时记忆(工作记忆)则是对少量信息进行暂时存储和加工的记忆系统,它在信息处理、问题解决和决策制定等过程中起着关键作用。 长时记忆负责对信息进行长期的存储,它是我们知识、技能和经验的仓库,能够存储大量的信息,并且在需要时可以被提取和利用。

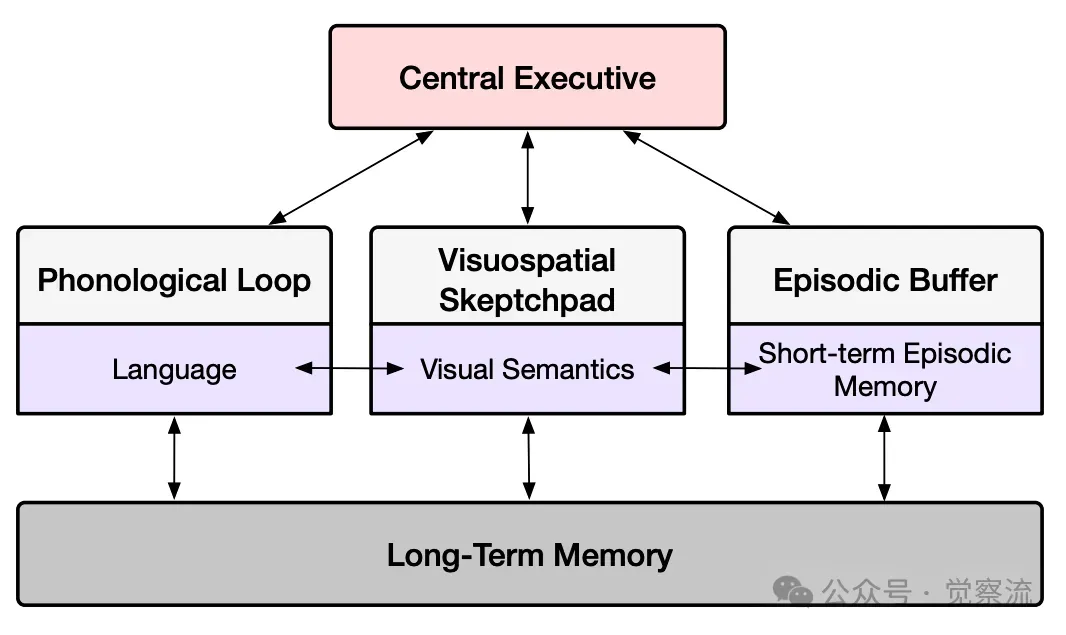

2.人类记忆的模型 :为了更深入地理解记忆的工作机制,我们可以参考一些经典的记忆模型。多存储模型将记忆分为不同的存储阶段,如感觉记忆、短时记忆和长时记忆,并认为信息在这些存储阶段之间进行流动和转化。工作记忆模型则强调短时记忆的主动加工特性,包括中央执行系统、语音回路和视空画板等子系统,它们协同工作,实现对信息的暂时存储和操作。Baddeley 的工作记忆模型进一步细化了这一过程,提出了中央执行系统、语音回路和视空画板等子系统。

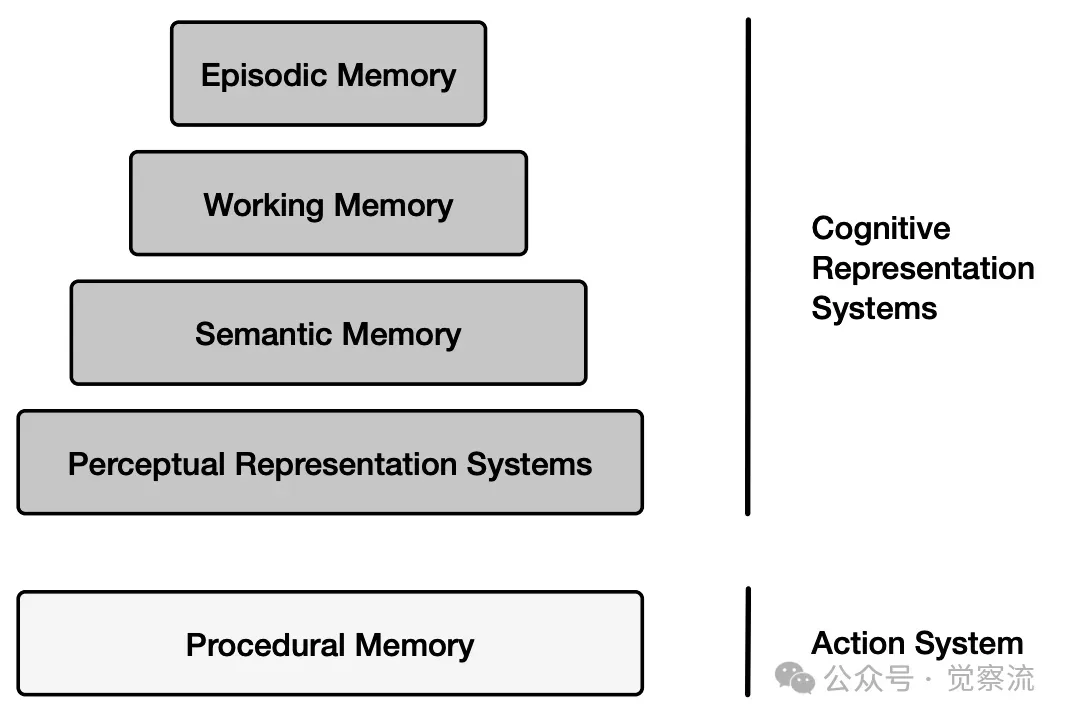

3.Baddeley 工作记忆模型这个模型展示了这些子系统如何协同工作,实现对信息的高效处理和管理。除了上述模型外,Tulving 提出的 Serial-Parallel-Independent (SPI) 模型进一步细化了记忆系统的结构。SPI 模型将记忆分为认知表征系统和行动系统,其中认知表征系统处理感知输入和语义信息,行动系统负责程序性技能的存储和执行。这两个系统在记忆的形成和使用过程中相互独立又相互作用。下图就展示了 SPI 模型的结构,帮助我们更好地理解记忆的不同功能模块及其相互关系。

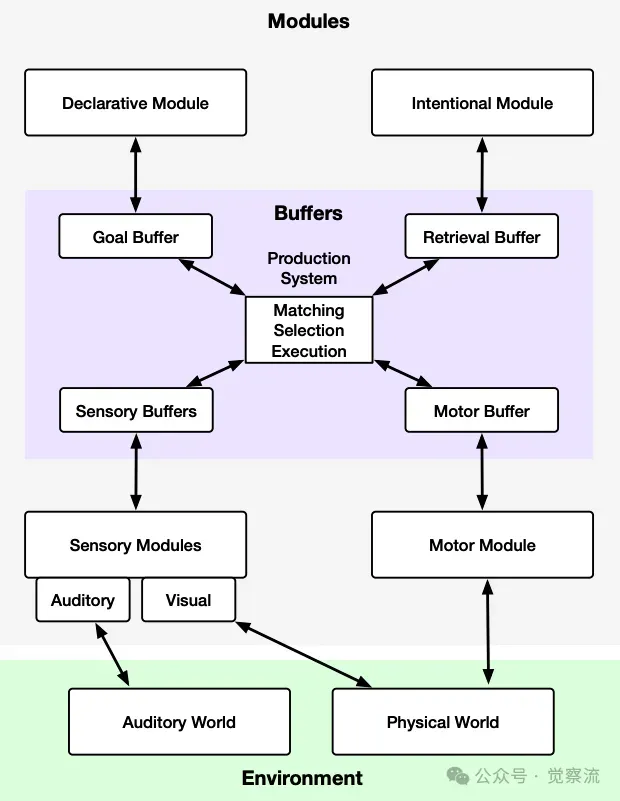

4.人类记忆的串行-并行独立(SPI)模型而 ACT-R(Adaptive Control of Thought - Rational)模型是一个综合性的认知架构,将记忆、感知和运动过程整合到一个统一的理论框架中。该模型通过多个模块(如视觉模块、手动模块、声明性记忆模块、程序性记忆模块等)来模拟人类的认知过程。下图展示了 ACT-R 模型中最重要的过程,包括各个模块之间的交互以及如何通过模式匹配器选择合适的生产规则来驱动行为。

ACT-R 模型中最重要的过程的抽象

ACT-R 模型中最重要的过程的抽象

(二)从人类记忆到智能体记忆的转变

- 智能体记忆的设计灵感与挑战 :智能体记忆的设计受到人类记忆特性的启发,目的是构建能够支持智能体高效学习、推理和决策的记忆系统。例如,智能体的短期记忆可以借鉴人类短时记忆的功能,对当前任务相关的信息进行临时存储和处理;长期记忆则可以参考人类长时记忆的组织方式,对知识和经验进行长期存储和管理。然而,智能体记忆也面临着诸多挑战,如如何实现记忆的高效存储和检索,如何处理记忆的动态更新和遗忘,以及如何确保记忆内容的准确性和一致性等。

- 智能体记忆的表示形式 :在智能体中,感官记忆主要用于存储从环境传感器获取的原始感知数据,如图像、声音等,并对其进行初步的处理和编码。短时记忆则负责存储智能体在当前任务中需要频繁访问和操作的信息,如任务目标、当前状态和最近的感知信息等。长时记忆在智能体中通常以知识库、数据库或神经网络的形式存在,用于存储智能体通过学习和经验积累获得的知识和技能,这些知识和技能可以被智能体在不同的任务和场景中反复调用和应用。

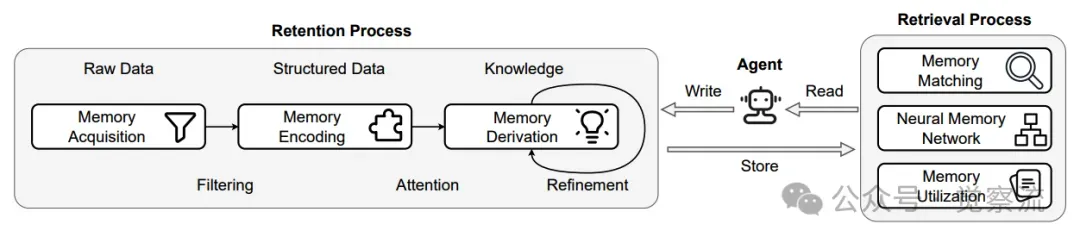

(三)智能体记忆的生命周期

为了更好地理解智能体记忆的动态管理过程,下图展示了记忆生命周期的整体框架。记忆生命周期包括记忆的获取、编码、衍生、检索和利用等环节,每个环节都有其独特的功能和策略。接下来,我们将探讨这些环节的具体内容。

记忆生命周期的示意图

- 记忆获取 :在记忆获取阶段,智能体通过感知系统接收来自环境的各种信息,并对其进行初步的筛选和处理。信息压缩技术可以将高维的感知数据降维处理,提取关键特征,减少存储空间和计算负担。例如,对图像数据进行特征提取,将彩色图像转换为灰度图像,或者对文本数据进行词频统计等。经验整合则结合智能体的先验知识和当前任务目标,对获取的信息进行初步的语义分析和标注,使其更具意义和价值。

- 记忆编码 :记忆编码是将获取的信息转换为适合存储和后续使用的内部表示的过程。选择性注意机制使智能体能够聚焦于与当前任务最相关的信息,忽略无关或次要的信息,提高编码效率。多模态融合技术将来自不同感知模态的信息进行融合和整合,构建统一的语义表示。例如,将视觉图像和文本描述相结合,生成对物体或场景的综合语义表示,为智能体的记忆存储提供更丰富的信息。

- 记忆衍生 :记忆衍生是为了优化记忆内容和提升记忆价值而进行的一系列处理。反思机制使智能体能够主动分析和总结过去的记忆,发现其中的规律、关系和潜在问题,从而提炼出更有价值的知识和经验。总结方法将大量的记忆信息进行归纳和提炼,生成简洁而具有代表性的摘要,便于智能体快速回顾和应用。知识蒸馏技术将复杂的知识表示转换为更紧凑、更易于处理的形式,例如,通过训练一个较小的模型来模仿大型模型的输出,从而实现知识的压缩和传承。选择性遗忘则根据记忆的重要性和相关性,定期清理过时、冗余或不重要的记忆,保持记忆系统的高效性和相关性。

- 记忆检索与匹配 :记忆检索与匹配是智能体根据当前需求从记忆中提取相关信息的过程。基于向量搜索的方法将记忆内容和查询请求转换为高维向量表示,通过计算向量之间的相似度来快速检索出与查询最相关的记忆片段。神经记忆网络通过模拟大脑的记忆神经元网络,实现记忆的存储、检索和更新,能够自动学习记忆的表示和检索策略,提高检索的准确性和效率。记忆利用则将检索到的记忆信息应用于智能体的推理、决策和行动中,为智能体的行为提供支持和指导。

- 神经记忆网络 :神经记忆网络是一种基于神经网络的记忆存储和检索方法,它将记忆信息编码为神经元的连接权重或激活模式,使得记忆能够与神经网络的计算过程紧密结合。通过训练神经记忆网络,智能体可以学习到如何存储和检索记忆,以及如何将记忆与当前任务相结合,实现记忆的动态更新和高效利用。例如,Hopfield 网络利用能量函数来编码和检索记忆模式,Bidirectional Associative Memories(BAMs)支持异关联想记忆,能够实现记忆的快速存储和检索。

(四)记忆的利用与讨论

- 智能体记忆在认知过程中的作用 :智能体记忆在认知过程中发挥着至关重要的作用。它为推理提供了必要的知识和经验基础,使智能体能够基于已有的记忆进行逻辑推理和决策。例如,在问题求解过程中,智能体可以利用长时记忆中存储的知识和规则,结合短时记忆中的当前状态信息,进行推理和推导,最终找到解决方案。同时,记忆也为学习提供了支持,智能体通过不断更新和丰富记忆内容,从经验中学习,提高自己的认知能力和适应性。

- 智能体记忆面临的挑战与未来发展方向 :当前,智能体记忆在适应性、上下文理解和弹性等方面仍存在不足。在适应性方面,智能体需要能够根据不同的任务和环境动态调整记忆的存储和检索策略,提高记忆的灵活性和效率。上下文理解能力的提升将使智能体能够更好地利用记忆中的语义信息,将记忆与当前的情境相结合,生成更准确、更合理的推理结果。弹性方面的改进则关注于提高记忆系统的抗干扰能力和容错性,确保在面对错误记忆或记忆缺失时,智能体仍能正常运行和工作。未来,智能体记忆的发展将朝着更高效、更智能、更灵活的方向迈进,通过结合深度学习、强化学习和认知科学等多学科的研究成果,构建更加完善的智能体记忆系统。

三、智能体的世界模型构建

(一)人类世界模型的启示

- 人类大脑如何构建内部世界模型 :人类大脑通过整合多个脑区的活动,构建了一个复杂的内部世界模型,以预测和理解环境变化。例如,额叶的前额叶皮层负责规划和决策,它基于大脑其他区域提供的感知信息和记忆信息,构建对未来事件的预测模型。同时,大脑的运动皮层和感觉皮层之间存在着紧密的反馈回路,使得人类能够根据预测结果调整自己的行为,并根据实际反馈更新内部模型。这种内部世界模型使人类能够在脑海中模拟各种可能的情境和行为结果,从而为决策提供依据。

- 人类世界模型在空间导航、决策制定中的关键作用 :在空间导航中,人类的大脑海马体发挥着重要作用。它能够形成所谓的 “认知地图”,帮助我们记住环境的布局和位置关系,从而在陌生环境中找到正确的路径。在决策制定方面,内部世界模型使我们能够基于对未来的预测和对过去经验的回忆,评估不同选择的潜在后果,选择最优的行动方案。例如,在选择职业时,我们会综合考虑自己的兴趣、能力、市场需求等多方面的因素,构建一个对未来职业发展的预测模型,从而做出合理的决策。

(二)智能体世界模型的转变

- 智能体如何从人类世界模型中汲取灵感 :智能体借鉴了人类世界模型的构建原理,通过感知系统获取环境信息,并利用学习算法构建自己的环境理解框架。例如,智能体可以使用视觉传感器获取环境的视觉图像,然后通过卷积神经网络(CNN)等深度学习模型对图像进行处理和分析,提取环境的特征和结构信息。同时,智能体还可以结合记忆中的知识和经验,对环境进行语义理解和预测,构建出一个类似于人类认知地图的内部世界模型。

- 智能体世界模型与人类世界模型的差异与联系 :智能体世界模型与人类世界模型在构建原理和表现形式上存在一定的差异。人类世界模型是基于生物神经网络的复杂系统,具有高度的适应性和灵活性,能够处理丰富的语义信息和情感因素。而智能体世界模型通常是基于人工神经网络或符号处理系统的简化模型,虽然在某些特定任务上能够表现出色,但在处理复杂、多变的现实环境时,仍存在一定的局限性。然而,两者也存在着紧密的联系,智能体世界模型的目标是尽可能地模拟人类的认知过程,以实现更好的环境理解和决策能力。

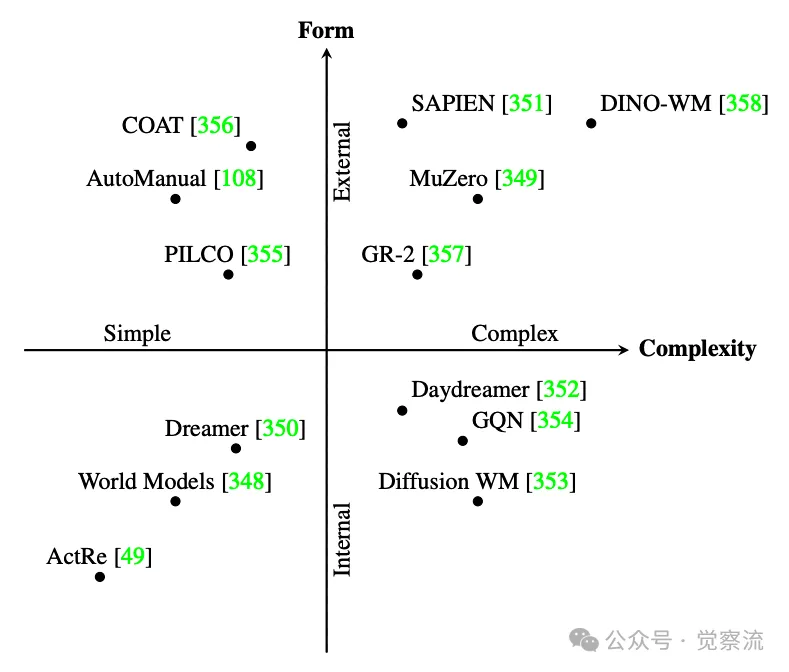

(三)智能体世界模型的范式

在探讨智能体世界模型的构建方法时,我们可以从不同的角度对这些方法进行分类。下图提供了一个二维布局,展示了 AI 世界模型方法在复杂性和内部/外部机制依赖程度上的分布。这个图表帮助我们更好地理解不同范式的特征和适用场景。

AI 世界模型方法的二维布局

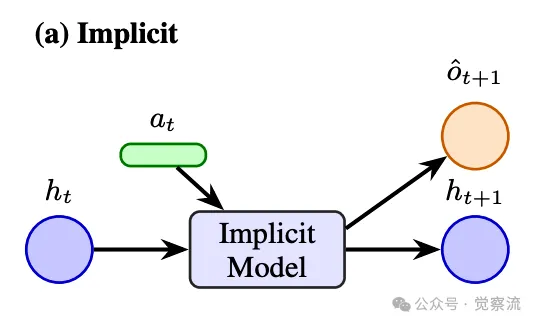

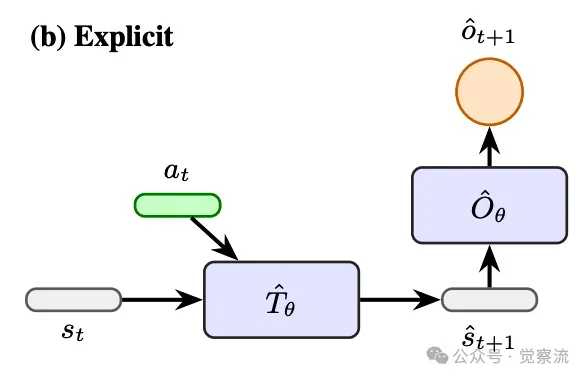

下面,我们来探讨四种主要的世界建模范式:隐式范式、显式范式、基于模拟器的范式和混合/指令驱动范式。

- 隐式范式的原理与应用 :隐式范式通过一个单一的神经网络或潜在结构,将环境的动态变化编码为内部表示,而不需要显式地分离状态转移和观测函数。例如,基于 “World Models” 框架的智能体,使用变分自编码器(VAE)和循环神经网络(RNN)共同学习环境的潜在表示,从而能够在潜在空间中进行轨迹预测和规划。这种范式的优势在于其简洁性和灵活性,能够自动学习环境的特征表示,适用于各种复杂环境。然而,它的局限性在于模型的可解释性较差,难以对环境的特定部分进行精确的控制和调整。如下图示

- 显式范式的优势与挑战 :显式范式直接对环境的状态转移模型和观测模型进行建模或学习,使得智能体能够更清晰地理解环境的动态行为。例如,基于模型的强化学习方法(如 MuZero)通过学习环境的转移概率模型和奖励模型,实现对环境的准确预测和规划。显式范式的优点在于其较高的可解释性和可控性,能够为智能体提供更深入的环境知识。但同时,它也面临着模型构建和训练的复杂性挑战,尤其是在面对高维、非线性的环境时,准确建模的难度较大。如下图示

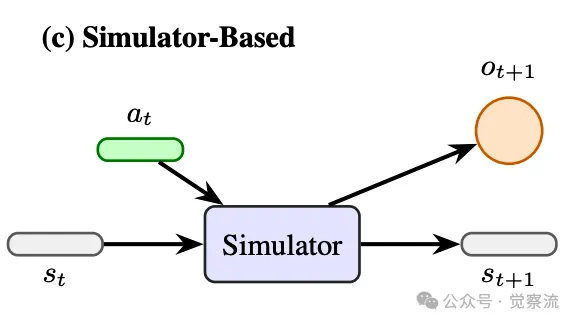

- 基于模拟器的范式的实践与特点 :基于模拟器的范式依赖于外部的模拟器或物理世界作为真实环境的代理,智能体通过与模拟器的交互来学习环境的动态模型。这种方法的优势在于能够利用现有的高性能模拟器(如机器人仿真平台)提供丰富的训练数据,降低实际环境中的试验成本和风险。然而,模拟器通常难以完全精确地模拟现实世界的复杂性和物理特性,导致智能体在模拟环境中学习到的模型可能存在与现实环境的差异,影响其在真实世界中的应用效果。如下图示

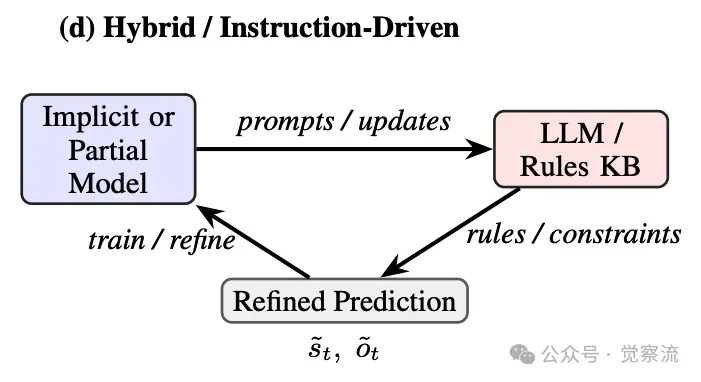

- 混合与指令驱动的范式的创新与探索 :混合与指令驱动的范式结合了多种方法的优势,例如将文本形式的规则、因果图等符号表示与神经网络的潜在表示相结合。这种方法能够在一定程度上弥补单一范式的不足,提高智能体对环境的理解和预测能力。例如,一些研究将语言模型与因果图结合,使智能体能够通过语言指令生成因果关系图,从而更好地理解和处理具有因果关系的复杂问题。如下图示

(四)世界模型与其他模块的关系

- 世界模型与记忆的协同作用 :世界模型与记忆相互作用,共同支持智能体的预测、规划和决策。世界模型为记忆提供了组织和存储的框架,使智能体能够更有条理地存储环境信息和经验。同时,记忆中的历史数据和知识又为世界模型的更新和完善提供了依据。例如,智能体可以根据记忆中的过去事件和结果,调整世界模型中的参数,提高模型的预测准确性。在决策过程中,世界模型基于当前状态和记忆中的信息生成可能的未来情景,为智能体的选择提供参考。

- 世界模型与感知的融合机制 :世界模型与感知系统紧密配合,共同构建智能体对环境的全面理解。感知系统为世界模型提供实时的环境观测数据,这些数据经过感知处理后被输入到世界模型中,用于更新模型的状态和预测。世界模型则根据感知数据和内部预测结果,指导感知系统的注意力分配和信息采集方向。例如,在自动驾驶场景中,感知系统获取的图像和雷达数据被输入到世界模型中,模型根据这些数据预测周围车辆和行人的运动轨迹,同时指导感知系统重点关注可能对行驶安全产生威胁的区域。

- 世界模型与行动的关联与互动 :基于世界模型的预测,智能体能够进行有效的行动选择和规划。世界模型为行动系统提供了环境的预测信息,使智能体能够在行动之前评估不同行动方案的潜在后果,从而选择最优的行动路径。例如,在机器人操控任务中,智能体利用世界模型预测物体的运动和碰撞情况,规划出合理的抓取和移动轨迹。同时,行动的结果反馈又可以用于更新世界模型,使其能够更好地适应环境的变化和动态。

四、智能体的奖励机制

(一)人类奖励途径的解析

- 大脑中的多巴胺系统与奖励处理的基本原理 :在人类大脑中,多巴胺系统是奖励处理的核心机制之一。当个体预期或实际获得奖励时,大脑中的多巴胺神经元会被激活,释放多巴胺神经递质。多巴胺在大脑的多个区域发挥作用,如伏隔核、前额叶皮层等,调节个体的动机、愉悦感和学习过程。例如,当我们完成一项任务并获得奖励时,多巴胺的释放会让我们感到愉悦,同时强化与该任务相关的神经连接,促使我们在未来更有可能重复类似的行为。

- 人类奖励途径在动机、学习与决策中的核心作用 :奖励途径在个体的动机激发、学习过程和决策制定中起着至关重要的作用。在动机方面,奖励预期能够激发个体的行为动力,促使我们去追求目标和奖励。在学习过程中,奖励信号为学习提供了指导,帮助我们调整行为策略,强化有益的行为模式。在决策制定时,个体会基于对不同选择的奖励预期进行评估和比较,选择预期奖励最大的选项。例如,在选择职业时,我们会权衡不同职业的薪资、发展前景、工作环境等因素,综合评估其奖励价值,从而做出决策。

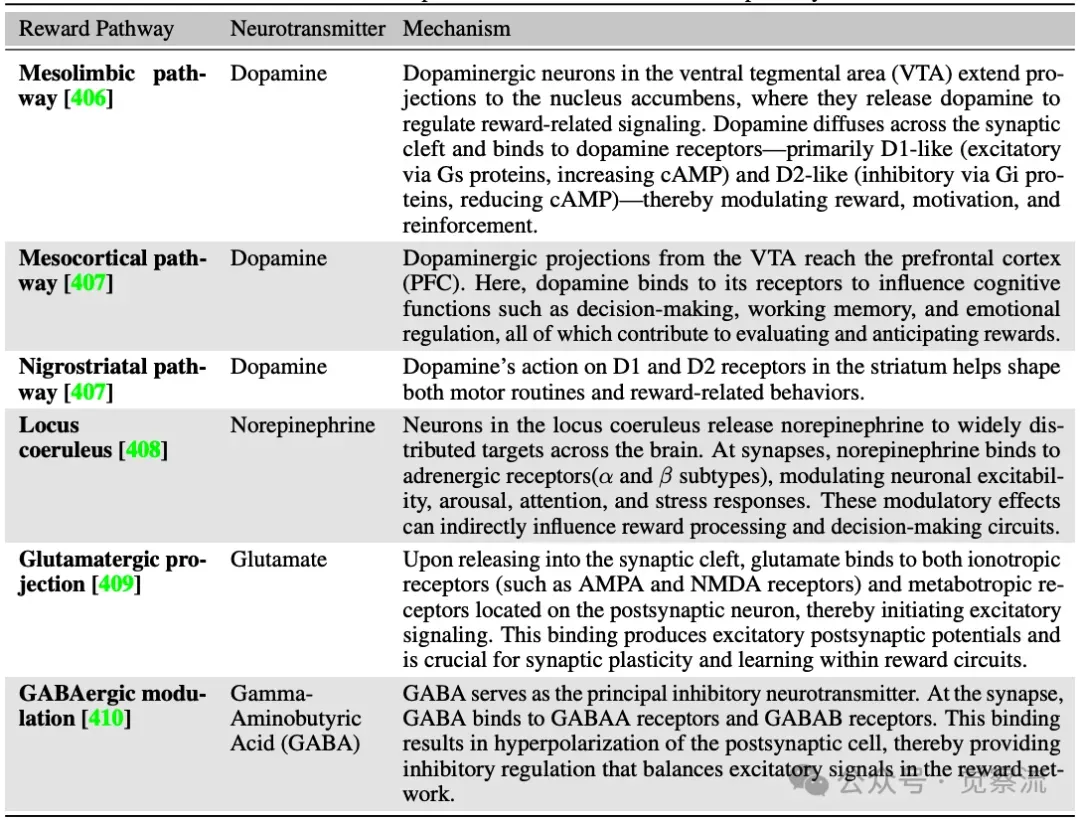

人类常见奖励通路的比较上表对比了人类常见的奖励通路,帮助我们更好地理解奖励在人类行为中的作用机制。

(二)从人类奖励到智能体奖励的转变

- 智能体如何借鉴人类奖励机制构建自己的奖励系统 :智能体的奖励系统借鉴了人类奖励机制的基本原理,通过设置奖励函数来引导智能体的行为。奖励函数根据智能体的行动和环境状态,为智能体提供一个标量或概率形式的反馈信号,指示当前行动的好坏。例如,在强化学习中,智能体通过与环境的交互,根据获得的奖励信号调整自己的策略,以最大化长期的累积奖励。与人类类似,智能体的奖励系统也目的是激励智能体朝着有益的方向发展,提高其在特定任务或环境中的表现。

- 智能体奖励机制与人类奖励系统的关键区别与联系 :智能体奖励机制与人类奖励系统在本质上存在一些区别。人类奖励系统是基于生物神经网络和复杂的神经化学反应,具有高度的主观性和情感性。而智能体奖励系统则是基于数学定义和算法实现,具有客观性和可编程性。然而,两者也存在着联系,智能体奖励机制的设计通常会参考人类奖励系统的工作原理和心理学理论,以更好地模拟人类的行为和决策过程。(三)智能体奖励范式

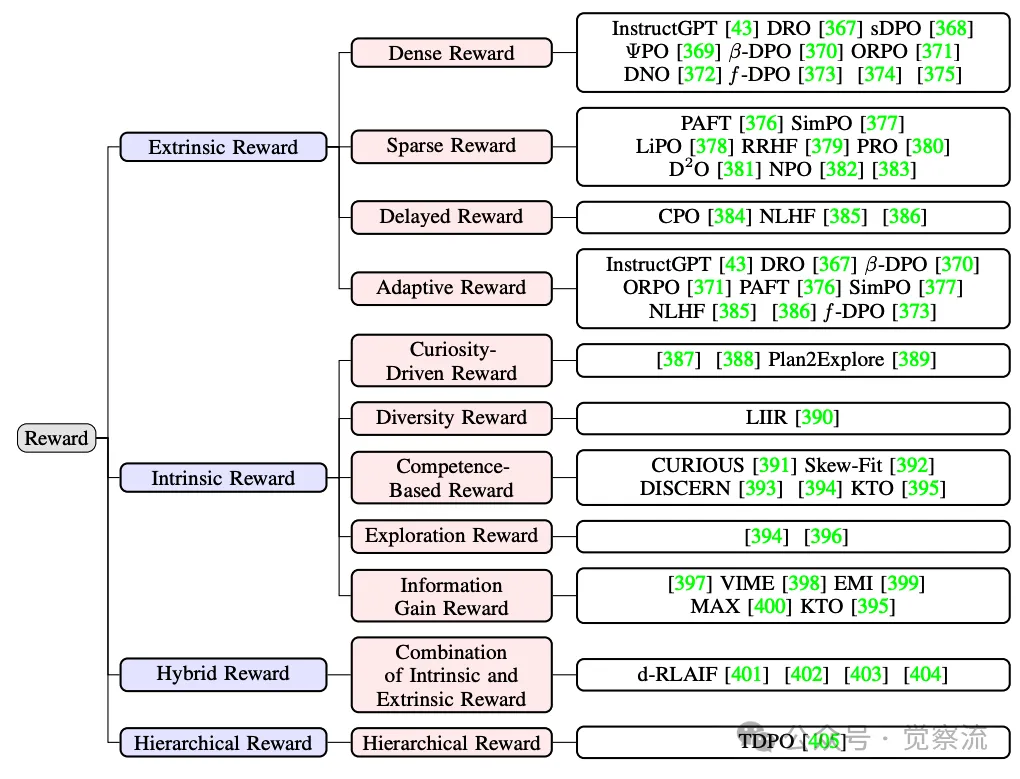

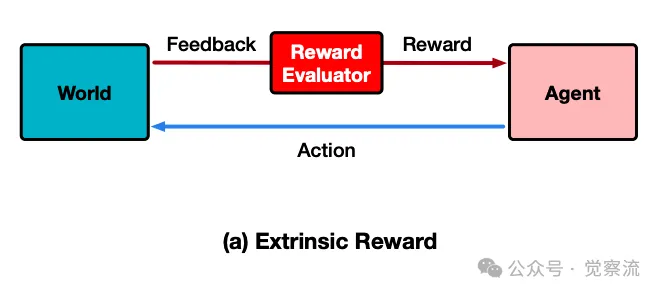

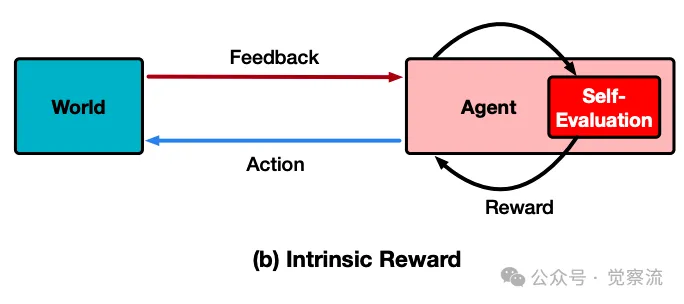

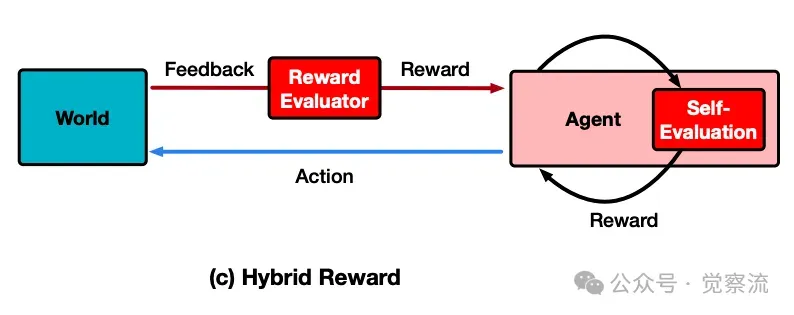

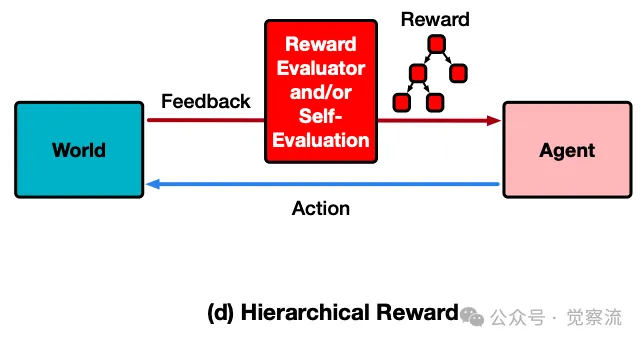

在介绍智能体奖励机制时,我们首先需要了解奖励系统的分类。奖励系统可以分为外部奖励和内部奖励两大类,每类又包含多种具体的奖励方式。下图展示了奖励系统的分类,帮助我们更好地理解不同奖励机制的特点和应用场景。

奖励系统的分类

接下来,介绍不同类型的奖励机制。包括外部奖励(如密集奖励、稀疏奖励、延迟奖励等)和内部奖励(如好奇心驱动奖励、多样性奖励等)。这些奖励机制在智能体的学习和决策过程中发挥着重要作用。

- 外部奖励的多样性与应用场景 :外部奖励是智能体从环境或其他外部来源直接获得的奖励信号。密集奖励意味着智能体在每个时间步或每次行动后都能获得奖励反馈,这种奖励方式能够为智能体提供频繁的指导,加速学习过程,适用于需要智能体快速学习简单任务的场景。稀疏奖励则只在特定的关键事件或任务完成时给予奖励,它更适合于那些需要智能体探索复杂环境和长期规划的任务。延迟奖励将奖励信号延迟到一系列行动之后才给出,要求智能体具备较强的长期规划和信用分配能力,常用于需要智能体完成多步骤任务的场景。自适应奖励能够根据智能体的学习进度和环境的变化动态调整奖励的强度和形式,以保持智能体的学习动力和适应性,适用于动态和不确定的环境。

- 内部奖励的原理与实践 :内部奖励是由智能体自身生成的奖励信号,目的是激励智能体进行探索、学习和自我改进。好奇心驱动奖励基于智能体对新奇和未探索状态的偏好,促使智能体主动探索环境,发现新的知识和模式。多样性奖励鼓励智能体采用多样化的行动策略,避免陷入局部最优解,提高智能体的适应性和创造力。基于能力的奖励关注智能体技能的提升和掌握程度,推动智能体不断学习和提高自身能力。探索奖励直接激励智能体探索环境中的未知区域,扩大智能体的经验范围。信息增益奖励则以信息理论为基础,衡量智能体在行动后所获得的信息量,鼓励智能体采取能够带来最大信息增益的行动,从而提高其对环境的理解和认知。

- 混合奖励的优势与实现 :混合奖励通过结合内部奖励和外部奖励的优势,为智能体提供更全面、更平衡的激励。例如,在机器人导航任务中,外部奖励可以用于引导机器人到达目标位置,而内部奖励(如好奇心驱动奖励)则鼓励机器人在探索过程中发现新的路径和障碍物信息。通过合理的设计和权衡,混合奖励能够使智能体在追求外部目标的同时,保持对环境的积极探索和学习,提高智能体的整体性能和适应性。

- 层次化奖励的结构与应用 :层次化奖励将复杂的目标分解为多个层次的子目标,为智能体提供结构化的奖励信号。例如,在游戏 AI 中,最终的胜利目标可以分解为多个阶段性的目标,如获得特定道具、击败特定敌人等。智能体在完成每个子目标时都能获得相应的奖励,这种层次化的奖励方式有助于智能体更好地理解和规划长期任务,逐步实现最终目标。同时,层次化奖励也能够降低智能体的学习难度,提高学习效率。

(四)奖励与其他模块的交互及挑战

- 奖励信号对其他模块的影响 :奖励信号在智能体的各个模块中发挥着重要的调节作用。在感知模块中,奖励信号可以引导智能体的注意力分配,使其更加关注与奖励相关的感知信息。在情感模块中,奖励信号可以影响智能体的情感状态和动机水平,进而影响其行为表现。在记忆模块中,奖励信号可以作为记忆存储和检索的重要依据,智能体更有可能记住那些与高奖励相关的事件和经验。例如,当智能体在执行任务时获得高奖励,它会更倾向于将相关的感知特征、情感体验和行动策略存储在记忆中,并在未来类似的情境下优先调用这些记忆。

- 智能体奖励机制面临的挑战与优化方向 :智能体奖励机制面临的主要挑战包括奖励稀疏性、延迟性和奖励欺骗等问题。奖励稀疏性使得智能体在学习过程中难以获得足够的反馈,影响学习进度和效果。为应对这一挑战,可以采用基于模型的方法,通过构建环境模型来预测潜在的奖励,或者利用内在动机奖励来激励智能体进行探索。延迟性要求智能体具备长期规划和信用分配能力,这可以通过引入辅助任务、分层强化学习等方法来缓解。奖励欺骗是指智能体为了获得高奖励而采取不符合设计初衷的行为,这需要通过精心设计奖励函数、引入惩罚机制和约束条件来避免。未来,智能体奖励机制的发展将朝着更智能、更高效、更符合人类价值观的方向前进,通过结合多模态信息、强化学习与监督学习等技术,构建更加完善和可靠的奖励系统。

五、智能体的情感建模

(一)情感的心理学基础

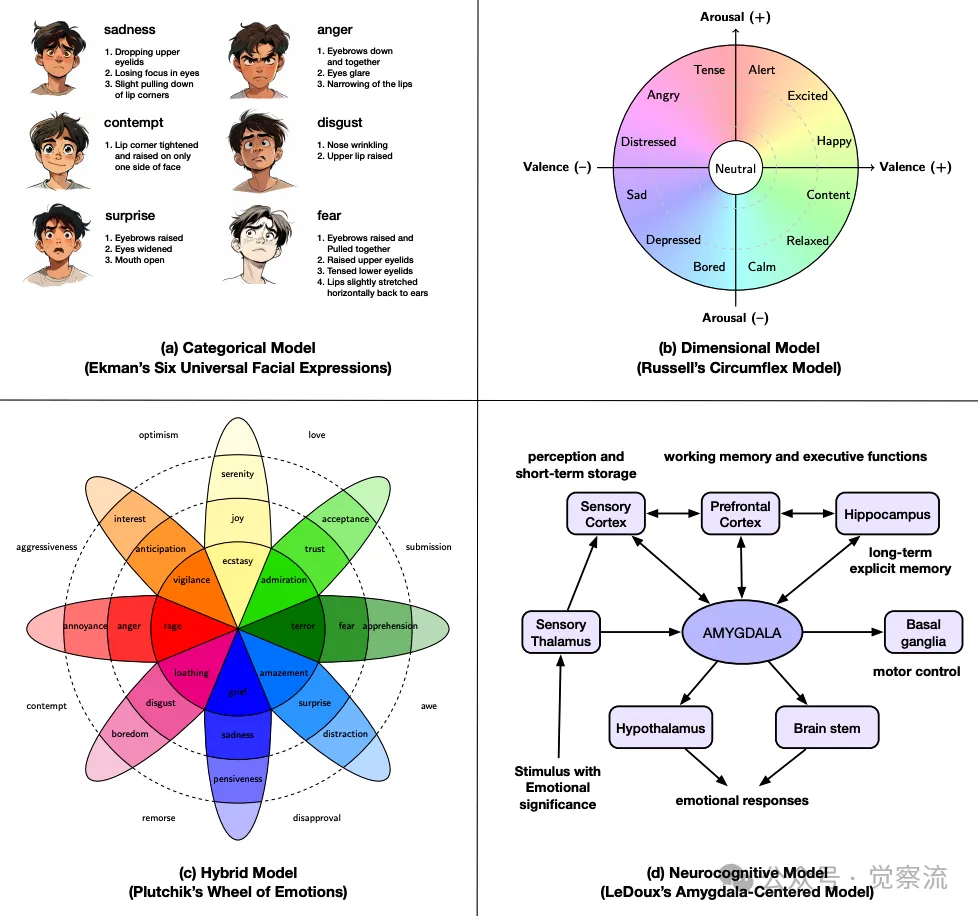

1.情感的分类理论 :情感的分类理论从不同的角度对情感进行了描述和解释。离散情绪理论认为情感是由有限的几种基本情绪(如快乐、愤怒、悲伤、恐惧等)构成的,这些基本情绪具有普遍性和生物学基础。维度模型则将情感表示为连续的维度,如情感的愉悦度、唤醒度和支配度,能够更细致地描述情感的多样性和复杂性。混合与成分框架结合了离散和连续的观点,认为情感是由基本情感成分组合而成的复杂体验。神经认知视角则关注情感在大脑中的神经机制和认知过程,揭示情感是如何在大脑中产生、加工和调节的。

不同情感理论的可视化和示例上图展示了不同情感理论的可视化和示例,帮助我们更好地理解情感建模在 AI 系统中的多种方法。

2.情感在人类认知、决策与社交中的关键作用 :情感在人类的认知、决策和社交过程中起着不可或缺的作用。在认知方面,情感影响我们的注意力分配、信息处理和记忆存储,使我们对与情感相关的信息更加敏感和难忘。在决策过程中,情感为我们提供了快速判断和选择的依据,帮助我们在复杂的情境中做出直觉性的决策。例如,当我们面临危险时,恐惧情感会促使我们迅速采取逃避行动。在社交互动中,情感是人与人之间沟通和理解的重要桥梁,通过表达和识别情感,我们能够建立和维护社会关系,实现有效的合作和交流。

(二)将情感融入智能体

- 情感在智能体中的功能与价值 :情感在智能体中具有多方面的重要功能和价值。首先,情感可以作为决策工具,使智能体能够根据情感状态调整行为策略,更好地适应环境和任务需求。例如,在与用户交互时,智能体可以根据用户的情感反馈调整自己的回应方式和内容,提高交互的质量和满意度。其次,情感有助于提升智能体的学习适应性,情感驱动的探索和学习能够使智能体更主动地发现新的知识和技能,优化自身的行为模式。此外,情感还能增强人机交互体验,使智能体更具亲和力和人性化,促进人与智能体之间的信任和合作。

- 赋予智能体情感类特性的设计与实现方法 :赋予智能体情感类特性可以通过多种方式实现。简单的情感分类可以通过设定情感标签和相应的触发条件,使智能体在特定情境下表现出相应的情感反应。例如,当智能体检测到用户使用了愤怒的语气时,它可以被设置为表现出安抚的情感反应。复杂的情感表达与调节能力则需要更深入的设计,如构建情感模型和情感生成算法。情感模型可以基于心理学理论和数据驱动的方法,对智能体的情感状态进行建模和预测;情感生成算法则根据情感模型的输出,生成相应的情感表达和行为反应,使智能体能够动态地调节和展示情感。

(三)智能体对人类情感的理解

- 文本情感分析的技术与方法 :文本情感分析是智能体理解人类情感的重要途径之一。基于语言模型的情感推理方法利用预训练的语言模型(如 BERT、GPT 等)对文本进行语义理解和情感分析,通过微调模型或设计特定的提示(prompt),使智能体能够从文本中识别出情感倾向和情感强度。多模型情感框架则结合了多种模型和算法的优势,如将语言模型与情感词典、机器学习分类器等相结合,提高文本情感分析的准确性和鲁棒性。

- 多模态情感识别的发展与应用 :多模态情感识别通过融合视觉、听觉、文本等多种模态的信息,增强了智能体对人类情感的感知和识别精度。例如,智能体可以同时分析用户的面部表情、语音语调和文字内容,综合利用这些信息来判断用户的情感状态。这种多模态融合的方法能够克服单一模态信息的局限性,更全面、准确地捕捉人类情感的复杂性和多样性。在实际应用中,多模态情感识别技术被广泛应用于智能客服、情感陪护机器人、心理健康监测等领域,为提高人机交互的情感智能提供了有力支持。

(四)分析智能体情感与个性

- 智能体情感与个性的可靠性评估 :现有对智能体情感与个性的测试方法主要包括基于人类标注的评估和基于行为数据的分析。基于人类标注的评估方法通过让人类专家或用户对智能体的情感和个性表现进行打分和评价,能够提供直观且具有参考价值的结果。然而,这种方法可能受到人类主观因素的影响,存在一定的偏差。基于行为数据的分析方法则通过对智能体的行为数据进行挖掘和建模,从数据中提取情感和个性特征。例如,分析智能体在不同情境下的行为模式、语言风格和决策倾向,从而对其情感和个性进行评估。这种方法具有较高的客观性,但需要大量的行为数据和复杂的分析算法。目前,这两种方法各有优缺点,未来需要进一步改进和完善,以提高智能体情感与个性评估的可靠性和准确性。

- 心理测量方法与认知建模在智能体情感分析中的应用 :心理测量方法通过设计特定的测试和量表,对智能体的情感和个性进行量化评估。例如,借鉴人类心理测量中的大五人格模型,设计相应的测试任务和指标,分析智能体在不同任务中的行为表现,从而推断其人格特质。认知建模方法则基于认知心理学理论,构建智能体的情感和个性认知模型,模拟智能体在情感处理和个性表现方面的认知过程。通过将心理测量结果与认知模型相结合,可以更深入地理解智能体的情感和个性机制,为智能体的情感设计和优化提供理论依据。

(五)操控智能体情感反应的方法与挑战

- 基于提示的操控方法 :基于提示的操控方法通过向智能体提供特定的角色或人设提示,引导其情感和个性表现。例如,在与智能体交互时,用户可以指定智能体扮演一个友好、幽默或严肃的角色,智能体根据提示调整其语言风格和行为反应,以符合该角色的情感和个性特征。这种方法简单易行,能够快速改变智能体的情感表现,适用于实时交互和个性化定制的场景。然而,其效果可能受到提示设计和智能体对提示理解能力的限制,需要精心设计提示内容和格式,以确保智能体能够准确地解读并响应提示。

- 基于训练的操控方法 :基于训练的操控方法通过微调智能体的模型参数或采用参数高效策略(如 LoRA),将特定的情感和个性特性嵌入到智能体的内部表示中。例如,通过在训练数据中加入带有情感和个性标注的样本,对智能体进行监督微调,使其能够学习到不同情感和个性特征的表达方式。这种方法可以使智能体的情感反应更加稳定和持久,但需要额外的训练数据和计算资源,训练过程相对复杂。

- 基于神经元的操控方法 :基于神经元的操控方法通过定位智能体模型中的个性特定神经元,并直接操控其激活状态,实现对智能体情感维度的精准调控。这种方法具有高度的精确性和灵活性,能够在不改变模型整体结构的情况下,快速调整智能体的情感反应。然而,它需要对智能体模型的神经元活动进行深入分析和理解,技术门槛较高,且可能对模型的其他功能产生一定的影响,需要谨慎应用。

(六)总结与讨论

- 情感智能在智能体发展中的重要性与潜力 :情感智能是智能体发展的重要方向之一,它能够使智能体更好地理解和适应人类的情感世界,提高人机交互的质量和效果。具备情感智能的智能体不仅能够为人类提供更加个性化、贴心的服务,还能够在复杂的社会环境中更好地协作和共存。未来,随着情感计算技术的不断进步和应用场景的不断拓展,情感智能将在智能体的各个领域发挥越来越重要的作用,推动智能体技术向更加人性化、智能化的方向发展。

- 情感智能面临的伦理与隐私挑战 :情感智能的发展也带来了一系列伦理和隐私挑战。情感操控问题引起了广泛关注,如果智能体的情感反应被恶意利用,可能会对用户的情感和心理产生负面影响,甚至导致情感欺骗和操纵。此外,智能体在收集和处理人类情感数据时,涉及到大量的个人隐私和敏感信息,如何确保这些数据的安全和合法使用,防止数据泄露和滥用,是情感智能发展过程中必须解决的重要问题。未来,需要建立健全的伦理准则和法律法规,规范情感智能的研发和应用,保障人类的情感和隐私权益。

六、智能体的感知系统

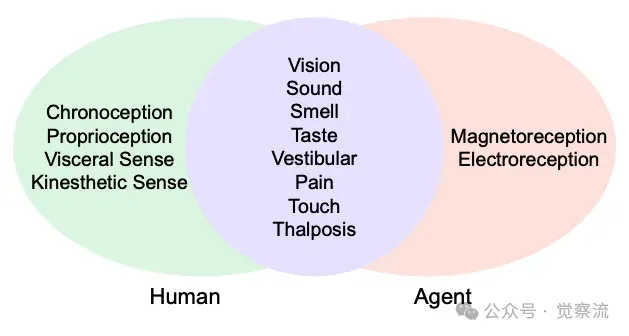

(一)人类与智能体感知的差异

- 人类感知的多模态融合与自然流畅性 :人类的感知系统是一个复杂而协调的多模态系统,视觉、听觉、嗅觉、触觉等多种感官协同工作,为我们提供了一个自然流畅、丰富多维的感知世界。例如,当我们走进一家餐厅时,视觉感知让我们看到餐厅的装修和菜品的外观,听觉感知让我们听到背景音乐和周围人的交谈声,嗅觉感知让我们闻到食物的香气,这些感知信息在大脑中被无缝融合,形成一个完整的餐厅环境感知。这种多模态融合使得人类能够在复杂多变的环境中迅速准确地感知和理解周围世界,做出相应的反应。

- 智能体感知的工程化实现与局限性 :智能体的感知系统是基于传感器和算法的工程化实现,通过将环境刺激转换为数字信号进行处理和分析。目前,智能体在视觉、听觉和文本感知等方面已经取得了显著的进展,例如,计算机视觉技术能够使智能体识别图像中的物体、场景和文字,语音识别技术能够将语音信号转换为文本。然而,智能体感知也存在一些局限性。首先,智能体感知的精度和可靠性在某些情况下可能受到传感器性能和环境条件的限制,例如,在低光照条件下视觉传感器的成像质量会下降。其次,智能体感知的多模态融合技术还不够成熟,与人类的自然流畅融合相比,存在一定的差距。此外,智能体对于一些人类特有的感知方式(如嗅觉和味觉)的模拟还处于初级阶段,无法达到人类的感知水平。

- 人类与智能体感知类型的对比上图展示了人类与智能体感知类型的对比,帮助我们更好地理解两者之间的差异。

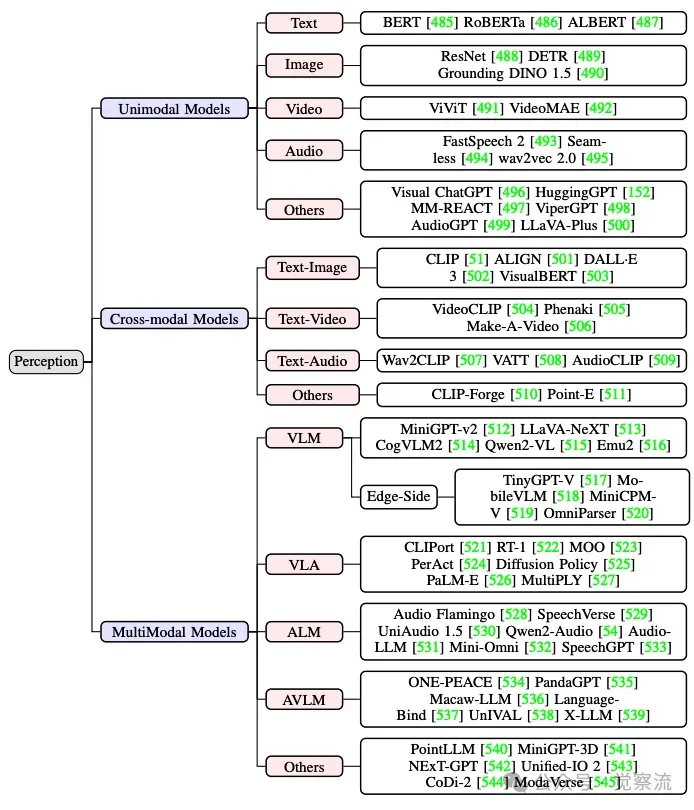

(二)感知表示类型

- 单模态模型的发展与应用 :

• 文本感知 :文本感知技术从早期的词袋模型发展到如今的大型语言模型,经历了巨大的变革。词袋模型通过统计文本中词汇的出现频率来表示文本的语义,虽然简单但能够捕捉到文本的基本主题信息。随着深度学习的发展,基于神经网络的语言模型(如 RNN、LSTM、Transformer 等)逐渐成为主流,它们能够学习到文本的语义结构和上下文依赖关系,生成更加准确和自然的文本表示。大型语言模型(如 GPT 系列、BERT 等)通过在海量文本数据上的预训练,掌握了丰富的语言知识和模式,为智能体的文本理解和生成能力提供了强大的支持。 • 图像感知 :计算机视觉领域的图像感知技术取得了飞速发展,从早期的基于手工特征提取的方法到现在的基于深度学习的模型。ResNet 等深度卷积神经网络通过构建深层的网络结构,能够有效提取图像的局部和全局特征,实现对图像的分类、检测和分割等任务。DETR 等基于 Transformer 的模型则通过引入自注意力机制,提高了对图像中物体关系和场景布局的理解能力,为智能体的图像感知提供了更加精确和语义丰富的表示。 • 视频感知 :视频感知技术在处理动态视觉信息方面发挥着重要作用。ViViT 等模型通过将视频序列分解为空间和时间维度的特征,利用 Transformer 等架构对视频进行建模,能够捕捉视频中的动态变化和时间依赖关系。VideoMAE 等基于自监督学习的模型通过在大规模无标注视频数据上进行预训练,学习到视频的通用特征表示,提高了智能体在视频理解和生成任务中的性能。 • 音频感知 :音频感知技术涵盖了语音识别、语音合成、音频分类等多个领域。FastSpeech 2 等语音合成模型通过引入语音特征(如音高、能量、时长等)和先进的生成算法,能够生成自然流畅的语音。wav2vec 2.0 等语音识别模型利用深度神经网络对语音信号进行建模,通过自监督学习和对比学习等方法,提高了语音识别的准确率和鲁棒性。

- 跨模态模型的创新与突破 :跨模态模型致力于解决不同模态之间的语义对齐和信息转换问题,实现跨模态的理解和生成。文本 - 图像模型(如 CLIP)通过对比学习方法,将文本和图像映射到同一个语义空间,使智能体能够根据文本描述生成相应的图像,或者根据图像内容生成相关的文本描述。文本 - 视频模型(如 VideoCLIP)则进一步拓展了跨模态技术的应用范围,使智能体能够处理视频与文本之间的关联和转换。这些跨模态模型为智能体的多模态感知和交互提供了新的思路和方法。

- 多模态模型的架构与实现 :多模态模型目的是整合多种模态的信息,实现更全面、更深入的环境理解。MiniGPT - v2 等模型通过设计统一的多模态编码器和解码器架构,将文本、图像等多种模态数据进行联合编码和解码,使智能体能够在多模态输入的情况下进行统一的理解和生成。CogVLM2 等模型则进一步优化了多模态信息的融合方式,通过引入跨模态注意力机制和动态融合策略,提高了模型对多模态信息的利用效率和表达能力。

- 感知系统示例分类上图展示了感知系统的分类,帮助我们更好地理解不同感知模型的特点和应用场景。

(三)优化感知系统的策略

- 模型层面增强的方法与实践 :微调是提升智能体感知模型性能的常用方法之一,通过在特定领域的数据上对预训练模型进行进一步训练,使模型能够更好地适应特定任务和数据分布。例如,在医学图像分析领域,对图像感知模型进行微调可以提高其对医学图像中病变特征的识别能力。提示工程通过精心设计提示信息,引导模型产生符合预期的感知结果。例如,在文本感知任务中,通过构造包含任务描述和示例的提示,可以帮助模型更好地理解任务要求,提高文本分类或生成的准确性。检索增强生成则通过结合检索技术和生成模型,为智能体的感知提供更丰富的背景知识和上下文信息。例如,在问答系统中,智能体可以先从知识库中检索与问题相关的信息,然后基于这些信息生成准确且详细的答案。

- 系统层面优化的策略与案例 :预期 - 重新评估机制使智能体在面对不完整或不确定信息时,能够根据先验知识和历史数据进行初步预测,并在获取新的信息后及时调整和优化预测结果。例如,在自动驾驶场景中,智能体可以根据路况的先验知识预测前方道路的情况,当传感器获取到新的路况信息时,重新评估并更新预测结果,确保车辆的安全行驶。多智能体协作通过多个智能体之间的信息共享和协同工作,提高感知系统的鲁棒性和准确性。例如,在智能监控系统中,多个智能体可以分别负责监控不同的区域,然后将各自的感知信息进行融合和分析,共同检测和跟踪目标对象。智能体专业化则通过为不同的智能体分配特定的感知任务,使每个智能体能够在其专业领域发挥最大的优势,提高整个系统的感知效率和性能。例如,在工业生产线上,不同的智能体可以专门负责对特定类型的零部件进行检测和识别,通过专业的模型和算法提高检测的精度和速度。

- 外部反馈与控制的方法与应用 :损失智能体优化方法通过将智能体作为损失函数的优化器,根据复杂的、非可微的外部目标(如人类反馈和模型评估结果)动态调整损失函数的权重,从而优化感知模型的性能。例如,在图像分类任务中,可以利用人类专家对分类结果的评价作为外部反馈,通过损失智能体优化方法调整模型的损失函数,使模型朝着更符合人类期望的方向进行训练。人机交互循环系统通过引入人类的实时反馈和监督,对智能体的感知结果进行纠正和优化,确保智能体的行为符合人类的意图和期望。例如,在智能教育系统中,教师可以根据学生的学习情况和智能体的教学反馈,对智能体的教学内容和方法进行调整,提高教学效果。内容与输出调解通过在智能体输出结果之前对内容进行过滤和修正,确保感知结果的质量和安全性。例如,在新闻推荐系统中,对智能体推荐的新闻内容进行审核和筛选,去除不符合规定或低质量的新闻,提高推荐内容的质量和可信度。

(四)感知应用实例

- 个人助理系统中的感知应用 :在个人助理系统中,感知技术的应用极大地提升了用户体验。语音交互技术使用户能够通过自然的语言与智能助理进行交流,完成各种任务,如设置提醒、查询信息、播放音乐等。情感语音增强技术通过分析用户的语音情感特征,使智能助理能够以更加贴心和自然的方式与用户交流,提高用户满意度。例如,当用户语气低落时,智能助理可以采用更加温和、鼓励的语气回应,为用户提供参考的解决方案。

- 游戏环境中的感知优化 :在游戏环境中,智能体的感知能力对于游戏体验至关重要。在程序生成环境(Procedurally Generated Environments)中,如 Minecraft,智能体通过视觉信息处理技术,能够快速理解和适应游戏环境的变化,提高资源搜索和任务执行的效率。例如,智能体可以利用图像识别技术识别游戏中的不同方块和生物,根据视觉信息规划行动路径,完成建造、探索等任务。通过端到端的多模态训练,智能体能够更好地结合视觉和文本信息,解决环境理解延迟等问题,提升游戏中的表现。

- 机器人流程自动化(RPA)中的感知技术 :在 RPA 领域,智能体的感知技术被广泛应用于各种任务执行和自动化流程中。在 VisualWebArena 等场景中,智能体通过基于截图的探索性学习,结合上下文信息和掩码集成技术,能够自动完成复杂的网页操作任务,如数据输入、表格处理、文件下载等。这种感知技术的应用提高了工作效率,降低了人力成本,同时也减少了人为错误。

- 多媒体内容生成中的多智能体协作 :多智能体协作在多媒体内容生成领域展现出了巨大的创新潜力。在视频编辑任务中,智能体可以通过多智能体协作理解视频内容的风格和语义,根据用户的需求进行自动剪辑、特效添加和音频处理。例如,一些智能体负责分析视频的画面内容和情感氛围,另一些智能体负责生成与之匹配的背景音乐和音效,通过协作完成高质量的视频编辑工作。在音频操控方面,智能体能够结合文本和视觉输入,实现对音频的全面编辑和处理,如语音合成、音频增强、噪声去除等,为多媒体创作提供了更加丰富的工具和功能。

(五)总结与讨论

- 智能体感知系统面临的挑战与未来研究方向 :智能体感知系统目前面临着感知精度与鲁棒性不足、多模态融合不充分、实时性与效率有待提高等挑战。未来的研究方向将集中在以下几个方面:一是进一步提升感知模型的性能和泛化能力,通过改进模型架构和训练方法,使其能够在更广泛的任务和环境中实现高精度感知。二是加强多模态融合技术的研究,探索更加有效的融合策略和算法,实现感知信息的无缝整合和协同处理。三是优化感知系统的实时性和效率,通过模型压缩、硬件加速等技术,降低感知系统的延迟和计算成本,满足实时应用的需求。四是关注感知系统的可解释性和安全性,发展可解释的感知模型和安全感知机制,确保智能体感知的可靠性和可信度。

- 推动感知系统发展的关键技术与方法 :推动感知系统发展的关键技术包括深度学习算法的不断创新、传感器技术的持续进步、大数据资源的充分利用以及跨学科研究的深入开展。深度学习算法的创新将为感知模型提供更强大的特征提取和表示能力,如新型神经网络架构的设计和优化算法的改进。传感器技术的进步将为智能体提供更丰富、更准确的感知数据,如高分辨率摄像头、高灵敏度麦克风、新型生物传感器等的研发。大数据资源的利用将为感知模型的训练和优化提供充足的数据支持,促进感知模型的性能提升。跨学科研究的深入开展将融合计算机科学、神经科学、认知科学、心理学等多学科的知识和方法,为感知系统的理论创新和技术突破提供新的思路和途径。

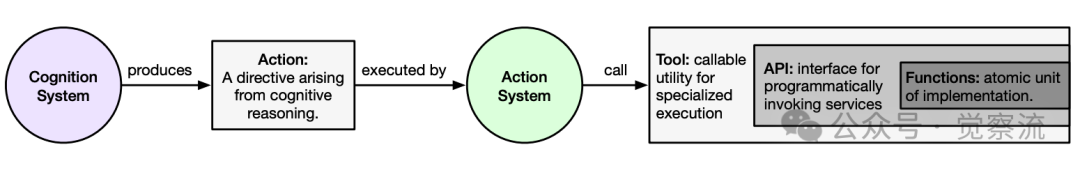

七、智能体的行动系统

(一)人类行动系统概述

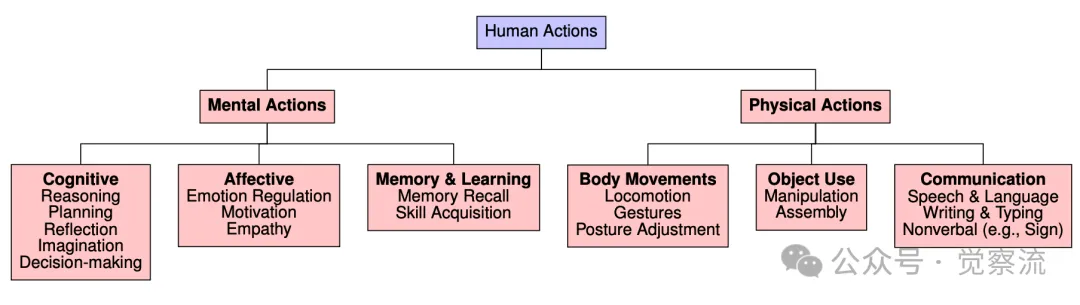

几种与"动作"和"动作执行"相关的概念

- 人类行动系统的构成 :人类行动系统是一个复杂而精密的体系,由心理行动和物理行动两大部分构成。心理行动主要包括认知推理、决策制定、情感调节等过程,它们是人类根据目标和环境信息在大脑中进行的内部思维活动,为物理行动提供指令和动机。物理行动则是人类通过身体运动来实现与外部世界交互的具体行为表现,如肢体运动、语言表达、面部表情等。心理行动和物理行动紧密配合,共同完成人类的各种目标导向行为。

- 人类行动系统的作用机制 :人类行动系统在目标导向行为中的作用机制体现了高度的智能和适应性。当人类设定一个目标时,大脑会根据当前的环境状态和内部需求,调用认知资源进行问题分解、规划制定和决策分析。例如,在计划一次旅行时,我们会考虑目的地的选择、行程的安排、交通方式、住宿预订等多个方面。在决策过程中,我们会权衡各种因素的利弊,如时间成本、经济预算、个人喜好等,最终确定最优的行动方案。然后,大脑将这些抽象的决策转化为具体的物理行动指令,指挥身体各个部位协调运动,执行旅行计划。同时,人类行动系统还具备反馈调节机制,能够根据行动结果和环境反馈及时调整行动策略,确保目标的顺利实现。

人类行动系统的分类上图展示了人类行动系统的分类,帮助我们更好地理解行动系统的心理和物理层面。

(二)从人类行动到智能体行动

- 人类行动系统对智能体行动系统设计的启示 :人类行动系统的设计原理为智能体行动系统提供了宝贵的借鉴。首先,智能体行动系统需要具备明确的目标表示和规划能力,能够根据任务要求将复杂的目标分解为可执行的子任务,并生成相应的行动序列。其次,智能体需要具备灵活的决策机制,能够在动态环境中根据实时信息调整行动策略。例如,在机器人导航任务中,智能体需要根据环境的障碍物分布和目标位置动态调整路径规划。此外,人类行动系统中的反馈调节机制也应被引入智能体设计中,使智能体能够通过环境反馈不断优化行动效果,提高行动的成功率和效率。

- 不同基础模型在智能体行动系统中的应用与区别 :不同的基础模型在智能体行动系统中扮演着不同的角色并发挥着独特的作用。大型语言模型(LLM)主要擅长处理语言相关的行动任务,如文本生成、对话交互和基于语言的指令执行。例如,智能体可以根据用户提供的文本指令生成相应的行动规划,并通过语言反馈与用户进行交互。大型多模态模型(LMM)在处理多模态信息(如视觉、文本和音频)的基础上,能够执行更复杂的行动任务,如图像描述生成、视频内容编辑和跨模态指令执行。机器人基础模型(RFM)专注于物理世界的控制和操作,通过与环境的实时交互进行机器人动作规划和执行,如机械臂操作、移动机器人导航等。大型行动模型(LAM)则更侧重于生成具体的、可执行的行动策略,直接与环境进行交互,实现对物理世界的改变和操作。例如,在工业自动化生产线上,LAM 可以控制机器人的动作,完成高精度的装配和加工任务。这些基础模型在智能体行动系统中的应用各有侧重,但也相互补充,共同构成了智能体行动系统的多样化技术支撑。

(三)智能体行动系统范式

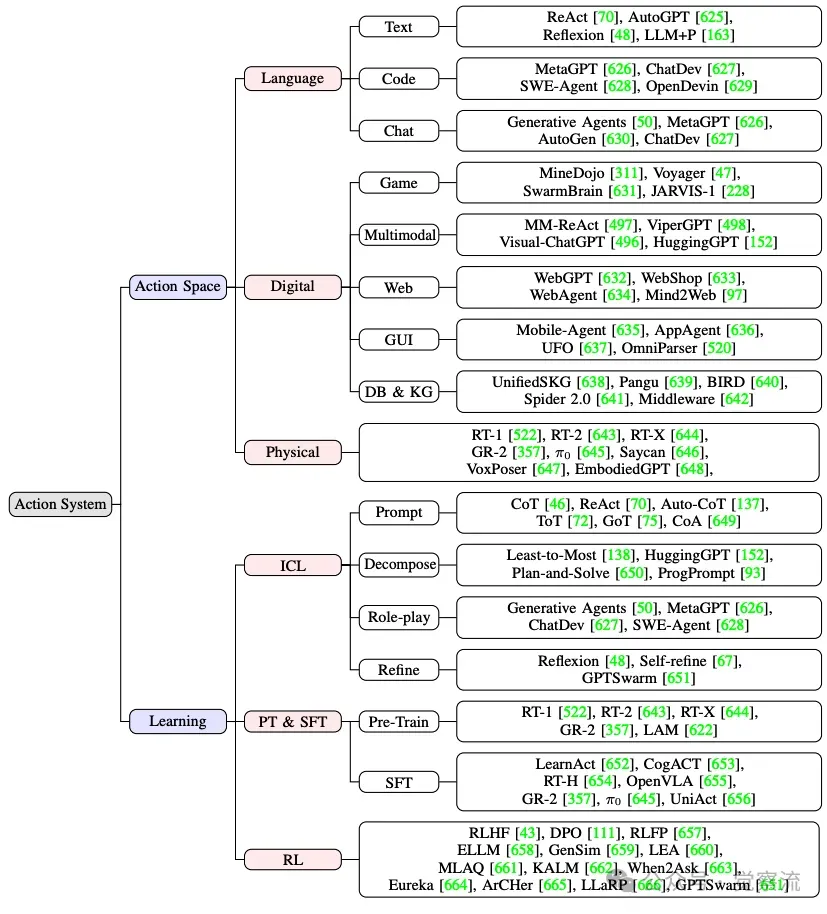

- 行动空间范式的构建与拓展 :

- 语言行动空间的设计与应用 :语言行动空间涵盖了从纯文本交互到复杂的代码编程以及多智能体通信等多种形式。在纯文本交互中,智能体通过自然语言处理技术理解和生成文本,与用户进行对话交流,完成如信息查询、知识解答等任务。代码编程作为语言行动空间的一种扩展形式,使智能体能够直接生成可执行的代码,实现更复杂的功能和操作。例如,智能体可以根据用户的需求生成 Python 脚本,完成数据分析、文件处理等任务。多智能体通信则通过设计特定的通信协议和语言格式,使多个智能体之间能够协调合作,共同完成复杂的任务。例如,在分布式系统中,多个智能体通过消息传递机制相互通信,协同完成大规模数据处理和任务调度。

- 数字行动空间的创新与实践 :在游戏环境中,智能体的数字行动空间包括角色控制、任务执行、资源获取等多种行动类型。例如,在实时战略游戏中,智能体可以通过学习和规划,控制虚拟角色进行战斗、建造基地、采集资源等操作。在多模态任务中,智能体结合视觉、语言和音频等多种模态信息,执行复杂的任务,如智能体可以分析视频内容并根据语音指令进行剪辑和编辑。在网络交互方面,智能体通过与网络服务和应用程序的交互,完成网页浏览、在线购物、信息检索等任务。例如,智能体可以根据用户的搜索意图,自动浏览网页并提取相关信息,为用户提供更精准的搜索结果。在 GUI 操作中,智能体通过模拟人类的鼠标和键盘操作,实现对图形用户界面的应用和控制。例如,在智能办公场景中,智能体可以自动完成文档编辑、表格处理和幻灯片制作等任务。

- 物理行动空间的规划与挑战 :物理行动空间主要涉及机器人控制、物理模拟和手术机器人等实际物理世界的行动场景。机器人控制要求智能体能够根据环境感知和任务要求,生成精确的运动指令,控制机器人的关节和末端执行器完成各种动作。例如,在工业机器人操作中,智能体需要精确规划机器人的运动轨迹,实现对物体的抓取、搬运和装配等操作。物理模拟则通过构建虚拟的物理环境,使智能体能够在模拟环境中进行行动训练和测试,降低在真实物理世界中的试验成本和风险。例如,在机器人运动学和动力学模拟中,智能体可以学习如何在复杂的物理环境中保持平衡、避免碰撞并完成任务。手术机器人是物理行动空间中一个具有挑战性的应用领域,它要求智能体具备高精度的感知、实时的决策和精确的运动控制能力,以确保手术的安全性和有效性。例如,智能体需要根据医学影像数据和手术计划,精确控制手术器械的操作,完成微创手术任务。

行动系统的分类上图展示了行动系统的分类,帮助我们更好地理解不同行动空间的特点和应用场景。

- 行动学习范式的探索与实践 :

- 在上下文中学习的技巧与方法 :提示工程是在上下文中学习的重要技巧之一,通过精心设计提示信息,引导智能体在特定情境下产生正确的行动。例如,在代码生成任务中,通过提供包含代码结构和功能描述的提示,帮助智能体生成符合要求的代码片段。链式思考(CoT)方法通过逐步展开行动推理过程,使智能体能够深入分析问题并生成详细的行动步骤。例如,在解决数学应用题时,智能体可以先分解问题,然后逐步推导出解决方案并执行相应的行动。基于树或图的搜索方法通过构建树状或图状的行动空间,智能体可以在其中进行搜索和规划,寻找最优的行动路径。例如,在机器人路径规划任务中,智能体可以利用 A * 算法在网格地图上搜索最短路径。

- 监督训练的应用与案例 :预训练在智能体行动能力的提升中起到了基础性的作用,通过在大规模数据上进行无监督或自监督学习,智能体能够学习到通用的行动模式和策略。例如,机器人基础模型可以通过在大量的机器人操作视频上进行预训练,学习到基本的运动技能和操作模式。监督微调则是在预训练模型的基础上,利用带有标注的训练数据对模型进行进一步优化,使智能体能够更好地适应特定的行动任务。例如,在机器人抓取任务中,通过监督微调模型可以提高智能体对不同物体的抓取成功率。

- 强化学习的融合与挑战 :强化学习为智能体行动系统提供了强大的优化工具,通过与环境的交互和奖励信号的引导,智能体能够不断调整行动策略,以最大化累积奖励。例如,在游戏 AI 中,智能体通过强化学习方法学习游戏策略,不断提高游戏水平。将强化学习与基础模型结合,可以实现行动策略的优化,但同时也面临着一些挑战,如如何设计有效的奖励函数、如何平衡探索与利用、如何提高强化学习的样本效率等。

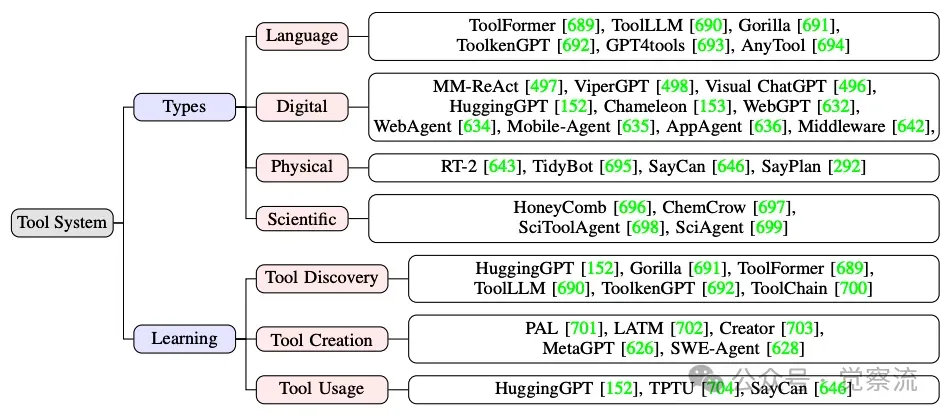

- 基于工具的行动范式的应用与拓展 :

下图清晰地展示了工具系统的分类,包括工具类别和学习范式,可以帮助我们更好地理解工具系统在智能体行动中的作用以及不同工具系统的特性。

AI Agent 工具系统的分类,包括工具类别和学习范式

- 工具类别的丰富与多样性 :工具类别丰富多样,涵盖了语言工具、数字工具、物理工具和科学工具等多个领域。语言工具如函数调用、API 接口等,使智能体能够利用外部的语言服务和功能扩展其语言行动能力。例如,智能体可以通过调用翻译 API 实现多语言之间的文本转换。数字工具包括网页浏览器、数据库查询工具、图形用户界面操作工具等,使智能体能够在数字环境中完成各种任务。例如,智能体可以利用数据库查询工具检索特定的信息,并根据查询结果执行相应的行动。物理工具如机器人手臂、传感器、手术器械等,使智能体能够在物理世界中进行实际操作和干预。例如,智能体可以通过控制机器人手臂完成物体的抓取和操作任务。科学工具则专门用于科学研究和实验领域,如化学反应模拟工具、物理实验设备控制工具等,为智能体在科学探索和研究中的应用提供了支持。

- 工具学习的流程与方法 :工具发现是工具学习的第一步,智能体需要从大量的工具中找到适合当前任务的工具。这可以通过检索工具库中的相关工具说明文档,或者利用智能体的自然语言理解能力分析用户指令中的工具需求来实现。工具创建则是在现有工具无法满足任务需求时,智能体通过编程和设计生成新的工具。例如,智能体可以根据用户的需求生成特定功能的 Python 脚本或开发新的 API 接口。工具使用是工具学习的核心环节,智能体需要学习如何正确地调用和操作工具,以完成特定的任务。例如,智能体需要学习如何设置工具的参数、如何处理工具的输出结果等。在工具学习的整个过程中,智能体需要不断地通过与工具的交互和环境的反馈来优化工具使用策略,提高工具使用的效率和准确性。

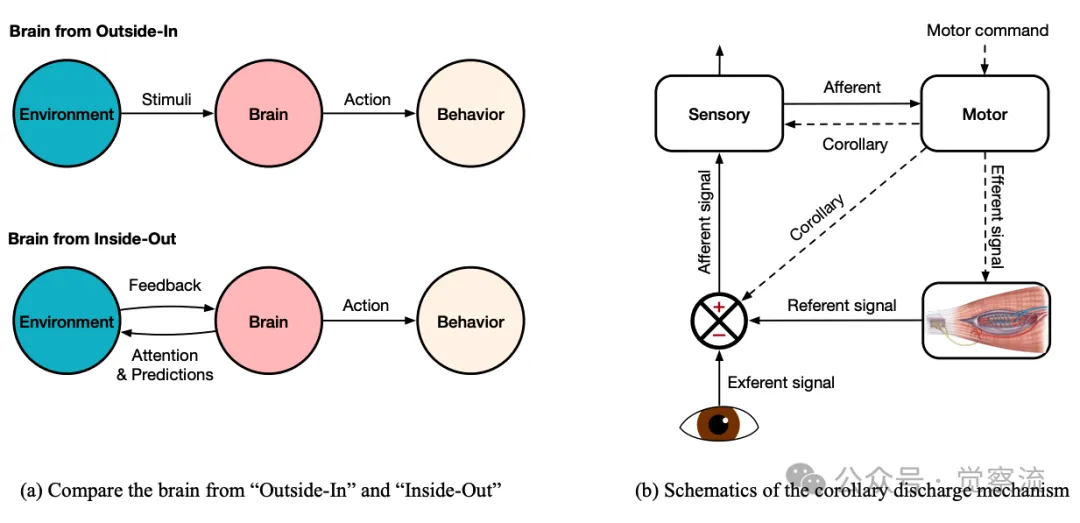

(四)行动与感知:“外部 - 内部” 或 “内部 - 外部” 的思考

- 认知科学与神经科学中的因果关系争论 :在认知科学和神经科学领域,关于行动与感知的因果关系存在两种不同的观点。“外部 - 内部” 观点认为因果关系始于外部刺激,环境中的事件通过感官系统传递到大脑,引发神经活动,最终导致行为反应。这种观点强调智能体对外部环境的被动响应,认为感知是行动的前提和基础。“内部 - 外部” 观点则认为智能体的内部状态和主动行为在因果关系中起主导作用。智能体根据内部的目标、动机和预测生成行动指令,这些行动指令不仅引发外部行为,还通过 “corollary discharge”(关联放电)或 “action copy”(动作副本)机制为感知系统提供预期信号,帮助智能体区分自我引发的感知变化和外部环境引起的感知变化。这种观点强调智能体的主动性和内部驱动,认为行动是感知的先导和塑造力量。

- “外部 - 内部” 和 “内部 - 外部” 两种观点的对比上图展示了 “外部 - 内部” 和 “内部 - 外部” 两种观点的对比,帮助我们更好地理解行动与感知的因果关系。(a) 比较“由外向内”和“由内向外”的大脑(功能或结构)。(b) 副本放电机制的示意图。运动指令(传出信号)从运动区域传递到眼肌,同时,一个副本放电(虚线箭头)被路由到感觉系统中的比较器。比较器利用这一内部信号来调节或抵消外部(外感受性)输入。此外,来自肌肉的张力反馈(再入信号)对感知产生延迟效应。在所有哺乳动物中,运动皮层到感觉皮层的直接投射构成了这种结构的基础。

- 进化与神经生理学视角下的行动优先性 :从进化的角度来看,行动能力在生物进化史上可能早于高级感知能力的出现。简单的生物体通过基本的运动行为(如趋利避害的运动)提高了生存和繁殖的机会,而复杂的感知系统则是在后续的进化过程中逐渐发展起来的。这表明行动在生物智能的形成和发展中具有基础性和优先性。从神经生理学的角度来看,大脑中的运动皮层和感觉皮层之间存在着紧密的反馈回路。运动皮层在发出运动指令的同时,也会向感觉皮层发送预期信号,帮助感觉皮层更好地处理和解释来自环境的感官信息。这种内部的预测机制表明行动在塑造感知输入方面发挥着重要作用,智能体通过主动的行动探索环境,生成与行动相关的感知信息,从而提高对环境的理解和适应能力。

- 对智能体设计的启示 :构建主动而非被动的智能体是智能体设计的重要方向。智能体应具备主动探索和行动的能力,通过行动与环境进行交互,获取感知信息,并根据这些信息调整行动策略。例如,在机器人探索未知环境任务中,智能体可以主动移动并观察环境变化,利用行动产生的反馈信息不断完善对环境的认知和理解。同时,智能体的设计应注重行动与感知的紧密结合,通过优化两者的交互机制,提高智能体的整体性能和智能水平。例如,设计高效的感知 - 行动循环,使智能体能够在短时间内完成感知信息的处理和行动决策的生成,实现快速、准确的环境交互。

(五)总结与讨论

- 智能体行动系统的核心地位与作用 :智能体行动系统是智能体与外部世界进行交互、实现目标的关键组成部分。它不仅体现了智能体的自主性和目的性,还直接影响着智能体在各种任务中的表现和效果。通过有效的行动系统,智能体能够将感知信息转化为具体的行动,改变环境状态,完成复杂的任务。例如,在智能仓储系统中,智能体通过行动系统控制机器人完成货物的搬运、存储和分拣任务,提高仓储管理的效率和自动化程度。行动系统的性能和功能在很大程度上决定了智能体的实用性和价值。

- 行动系统面临的挑战与未来发展方向 :智能体行动系统面临着效率提升、准确评估、多模态行动学习、隐私与安全保障等多方面的挑战。在效率提升方面,需要优化行动规划和执行算法,降低计算成本和延迟,提高智能体的行动速度和响应能力。例如,通过采用高效的路径规划算法和实时控制策略,使智能体能够在动态环境中快速做出行动决策。在准确评估方面,需要建立科学合理的评估指标和方法,对智能体的行动效果进行量化分析和客观评价,以便及时发现问题并改进系统性能。在多模态行动学习方面,应加强多模态信息融合技术的研究,使智能体能够综合利用多种感知模态的信息进行行动学习和决策,提高行动的准确性和适应性。在隐私与安全保障方面,需要关注智能体行动过程中可能涉及的个人隐私和安全问题,采取加密、权限控制、安全审计等措施,确保智能体行动的合法性和安全性。未来,智能体行动系统将朝着更加智能化、高效化、安全化和多模态融合的方向发展,为智能体技术的广泛应用提供坚实的支持。

在深入探讨了智能体的核心模块 —— 认知、记忆、世界模型、奖励、情感、感知与行动系统之后,我们已经对智能体的基础架构与功能有了较为全面的理解。然而,智能体的发展不仅仅局限于单个智能体的能力提升,还包括智能体的自我增强、适应性进化以及多智能体系统的协作与集体智慧的形成。在接下来的内容中,我们将转向智能体的自我增强与进化机制,探讨智能体如何通过自动化优化范式(如 AutoML 和大型语言模型驱动的优化策略)实现自我能力的精进与环境适应性的提升。同时,我们还将研究多智能体系统的设计与合作范式,分析智能体之间如何通过交互、协作与社会结构的构建来共同解决复杂问题,实现超越个体能力的群体智能。此外,智能体的安全性与伦理性考量也是不可忽视的重要方面,我们将深入探讨如何构建安全、有益且符合人类价值观的智能体技术,确保智能体在现实世界中的可靠部署与应用。

第二部分 智能体自我进化开启人工智能新时代

在上一部分,我们深入探讨了智能体的核心架构,包括其感知、认知、行动等关键模块以及这些模块与人类大脑功能的对应关系。然而,智能体的发展并非止步于此,它们还具备自我进化的能力,这使得它们能够不断提升性能、适应动态环境,实现持续学习与进步。随着技术的不断推进,智能体的自我进化已成为实现其强大功能的关键因素之一。接下来,就让我们一同走进智能体的自我进化世界,探索这一领域的最新进展。

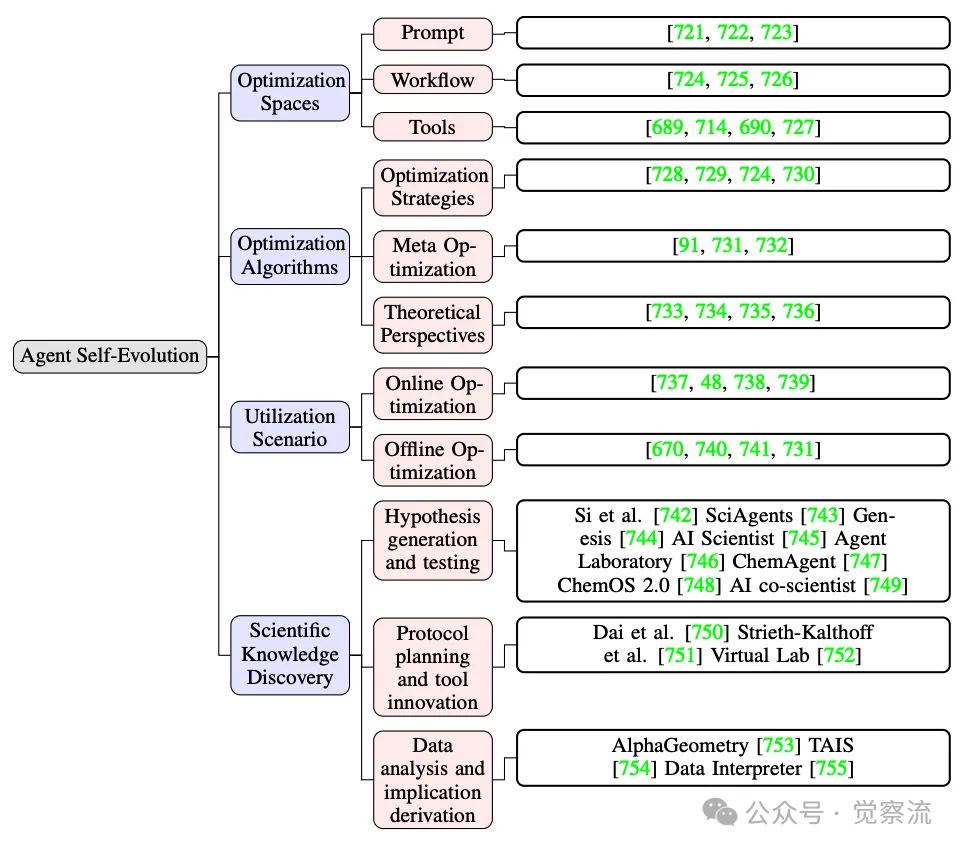

一、优化空间与维度:智能体进化的多元路径

智能体的优化是一个多层面的复杂挑战,涵盖多个抽象级别,与传统优化有着显著不同。它并非单一维度的提升,而是涉及多个关键要素的协同优化,共同推动智能体性能的飞跃。

(一)提示优化:智能体优化的核心引擎

提示优化作为智能体优化的核心部分,其目标是在给定任务 的情况下,生成任务特定的提示 ,以最大化性能。这里的 表示输入查询, 代表可选的真值。通过精心设计和优化提示,能够引导智能体更好地理解和处理任务,从而提升其在特定场景下的表现。例如,在一个文本生成任务中,通过优化提示,智能体可以生成更符合用户需求和语境的文本内容。

公式解读:这个公式表示的是,对于给定的任务,其中是输入查询,是可选的真实答案,目标是找到一个任务特定的提示,使得该提示在数据分布上的期望性能最大化。这里的表示执行函数,用于根据提示生成输出;而是评估函数,用于评估生成的输出与任务的真实答案 之间的匹配程度。

评估函数 在提示优化中扮演着至关重要的角色,它从评估源中获取信息,运用评估方法生成不同类型信号,为提示优化提供方向和反馈。评估源主要包括 LLM 生成的输出 和任务特定的真值 。评估方法则涵盖基于基准的评估、LLM 作为评判者以及人类反馈等多种方式。每种方法都有其独特优势和局限性。例如,基于基准的评估能够提供自动化且量化的反馈,但其有效性依赖于基准设计与人类偏好的契合度;LLM 作为评判者则借助 LLM 本身与人类偏好的一致性以及精心设计的评判标准,为任务完成质量提供更具针对性的反馈,然而其效果又受到评判提示设计和 LLM 与人类偏好对齐程度的影响;人类反馈虽能快速大幅提升提示质量,却也伴随着高昂的资源成本。

优化函数的设计直接决定了每次迭代中生成提示的质量。基于评估信号的优化方法通过选择最有效提示来优化,如 SPO 迭代改进基于当前最佳提示的输出,Evoprompt 采用进化算法利用 LLM 作为进化算子进行提示组合,PromptBreeder 进一步比较变异提示的分数变化,同时通过 LLM 修改元提示和提示。而基于优化信号的优化方法则利用明确的优化信号指导优化方向,如 OPRO 提取高表现提示中的通用模式,ProTegi 运用语言模型分析失败案例并预测错误原因作为优化指导,TextGrad 将提示反思转化为 “文本梯度”,Revolve 模拟二阶优化以实现更稳定、更长期的性能改进。例如,在一个智能体需要优化提示以提高文本分类任务的准确性时,基于评估信号的优化方法可能会从多个候选提示中选择出分类准确率最高的提示;而基于优化信号的方法则可能根据提示在分类任务中的表现,逐步调整提示的措辞和结构,以最大化分类性能。

优化方法的有效性还可通过多维度的评价指标进行评估。性能指标如 pass@1、准确率、F1 分值和 ROUGE-L 等,能够直观反映提示在特定任务中的表现,帮助研究人员把握提示优化过程的稳定性、有效性及收敛速度。效率指标则关注提示优化过程中的资源消耗,因为一些方法虽能取得出色结果,却需要大量算力、样本和数据,而其他方法能在较低资源条件下达到中等效果,这使得开发者需要在性能与效率之间做出权衡。此外,质量指标涵盖一致性、公平性和置信度等方面,用于评估智能体行为的多维度特性,当这些行为特征被纳入独立目标时,提示优化框架也能提供相应的评估指标。例如,在一个新闻分类任务中,性能指标可以帮助我们确定提示优化是否提高了分类的准确性;效率指标则让我们了解优化过程是否在可接受的时间和计算资源范围内完成;质量指标则确保智能体在分类过程中保持一致性和公平性,避免出现对某些类别的偏好或歧视。

(二)工作流优化:智能体协同工作的关键

工作流优化关注智能体中多个 LLM 组件的协调与互动,其目标是在保证任务完成质量的同时,优化计算效率和执行延迟等多方面性能。一个典型的工作流 可形式化表示为,其中代表 LLM 调用节点集合,表示节点间边的集合。每个节点包含可用语言模型、温度参数、提示空间和输出格式空间 等要素,这些参数共同决定了节点的行为和性能。例如,在一个复杂的问答系统中,工作流可能包括多个节点,每个节点负责处理不同方面的任务,如问题理解、知识检索、答案生成等。通过优化这些节点之间的协作和交互,可以提高整个问答系统的效率和准确性。

工作流的优化涉及对节点和边的综合考量。在边空间 的表示方面,当前主要有基于图、基于神经网络和基于代码的三种结构。基于图的表示能够自然展现节点间的层次、顺序和并行关系,便于结构操作和可视化,适合需要明确结构控制的场景;基于神经网络的结构擅长捕捉节点间的非线性关系,通过可学习参数实现动态调整,适用于输入反馈依赖型场景;基于代码的结构则具有最丰富的表达能力,支持线性序列、条件逻辑、循环结构以及图和网络结构的整合,能充分利用 LLM 的代码生成功能,为开发者提供对工作流执行的精细控制。例如,在一个需要处理多步骤任务的智能体中,基于图的表示可以帮助我们清晰地定义每个步骤的执行顺序和依赖关系;基于神经网络的结构则可以根据输入数据的特性,动态调整节点间的连接强度,以优化任务处理流程;基于代码的结构则允许开发者编写复杂的控制逻辑,如循环执行某个节点直到满足特定条件,从而实现更灵活的工作流管理。

节点空间 N 的优化则聚焦于节点的四个关键维度:输出格式、温度参数、提示空间和模型空间。输出格式对性能有显著影响,结构化的 LLM 输出能增强响应的精确性;温度参数控制输出的随机性,影响节点响应的稳定性与创造性;提示空间继承自提示优化的领域,决定了 LLM 交互的核心模式;模型空间涵盖不同能力与计算成本的 LLM,为智能体提供了多样化的选择。例如,在一个需要生成高质量文本的场景中,优化输出格式可以确保生成的文本结构清晰、易于理解;调整温度参数可以在文本的多样性和准确性之间取得平衡;优化提示空间可以提高 LLM 对任务的理解和响应能力;而选择合适的模型空间则可以根据任务的需求,在性能和计算成本之间做出权衡。

(三)工具优化:智能体能力拓展的重要途径

工具优化在智能体整体性能提升中占据重要地位。智能体具备多轮规划能力和外部世界交互能力,这使得工具优化成为提升其性能和适应性的关键环节。工具优化涵盖学习使用工具和创建新工具两个主要方面。

学习使用工具可细分为从演示中学习和从反馈中学习两种方法。从演示中学习通过模仿专家行为来训练模型,利用行为克隆等技术,让模型掌握工具使用的正确方式。例如,在一个智能体需要学习如何使用图像编辑工具的任务中,通过从演示中学习,智能体可以观察专家如何操作工具,逐步掌握图像编辑的技巧。从反馈中学习则借助强化学习,使模型根据环境或人类反馈的奖励进行适应性调整。例如,在一个智能体需要使用搜索引擎获取信息的任务中,通过从反馈中学习,智能体可以根据搜索结果的质量和相关性,不断优化搜索策略,提高获取准确信息的能力。

创建新工具是智能体适应复杂任务和提升效率的另一重要方式。例如,ToolMakers 框架通过编程示例、验证功能和自我调试等步骤,迭代生成新的工具;CREATOR 采用创建、决策、执行和修正的生命周期,强调工具的多样性、抽象与具体推理的分离以及错误恢复机制;CRAFT 则通过离线范式,将领域特定数据提炼为可复用的原子工具,避免了模型微调,实现了可解释的工具链。这些方法的结合为智能体提供了强大的工具创建和使用能力,使其能够更好地应对各种复杂任务。例如,在一个需要处理大量文本数据的场景中,智能体可以创建一个新的工具,用于自动提取文本中的关键信息,从而提高数据处理的效率和准确性。

二、大语言模型作为优化器:智能体进化的加速器

大语言模型(LLM)作为优化器,为智能体的自我进化提供了全新的思路和方法。与传统优化方法相比,LLM 基于优化具有独特的优势和特点。

(一)优化范式:传统与 LLM 基于优化的对比

传统优化方法主要分为梯度优化和零阶优化两大类。梯度优化依赖于目标函数的显式梯度信息,通过迭代更新参数来优化目标函数。例如,随机梯度下降(SGD)和牛顿法等方法在连续优化领域得到了广泛应用。然而,这些方法在处理离散问题,如提示优化和结构化决策工作流时,由于缺乏可微性,其适用性受到限制。例如,在优化一个文本分类模型的提示时,传统的梯度优化方法可能无法直接应用于文本数据,因为文本数据的离散性质使得梯度信息难以获取。

零阶优化则不依赖显式梯度信息,而是通过函数评估来估计搜索方向。贝叶斯优化、进化策略和有限差分方法等属于零阶优化范畴。这些方法在梯度信息难以获取或计算成本高昂的情况下表现出色,但仍然局限于数值目标和结构化搜索空间,对于基于语言的任务适用性有限。例如,在优化一个自然语言处理模型的超参数时,零阶优化方法可能需要大量的函数评估来确定最优的超参数组合,这在计算成本上可能较高。

LLM 基于优化则突破了传统优化方法的局限。它将优化空间从数值领域扩展到更广泛的结构化和高维输入空间,以自然语言作为优化领域和反馈机制。LLM 能够利用其强大的语言理解和生成能力,优化提示、生成适应性工作流,并根据用户反馈迭代改进任务性能。例如,在提示优化中,LLM 可以根据给定的任务和评估指标,生成和优化一系列提示,以提高智能体在特定任务上的表现。这种基于自然语言的优化方式使得智能体能够更灵活地适应各种复杂任务,而不受传统优化方法在数据类型和问题结构上的限制。

(二)LLM 优化的迭代方法:从随机搜索到贝叶斯优化

LLM 优化的迭代方法主要包括随机搜索、梯度近似和贝叶斯优化与代理建模等。随机搜索方法通过在离散自然语言空间中随机采样候选决策变量,并选择表现最佳的变量进行更新。这种方法简单易实现,高度并行化,并在单提示工作流中表现出色。例如,在一个需要优化文本生成提示的任务中,随机搜索可以从大量的候选提示中快速找到表现较好的提示。然而,其效率较低,每次迭代需要大量的并行 API 查询,对于涉及多个查询的复杂工作流来说成本过高。

梯度近似方法则通过估计梯度方向来迭代优化解决方案。例如,一些方法在工作流的不同阶段生成改进,利用中心差分启发式方法估计下降方向,或者将计算图建模为类似反向传播的结构进行优化。这些方法借鉴了连续优化中梯度更新的核心思想,通过“下降方向”这一概念,系统地修改决策变量以改善目标函数。与随机搜索相比,梯度近似方法能够利用历史信息,通常具有更快的收敛速度,并且可以更好地处理多阶段工作流中相互依赖的优化模块。例如,在一个需要优化多个提示的工作流中,梯度近似方法可以根据每个提示在工作流中的表现,逐步调整提示的内容,以最大化整个工作流的性能。

贝叶斯优化和代理建模则通过构建目标函数的噪声鲁棒代理模型来进行优化。代理模型能够根据已有的评估结果进行学习和更新,从而在后续的优化过程中提供更准确的预测和指导。例如,MIPRO 使用树结构 Parzen 估计器作为其代理模型,而 PROMST 则训练一个分数预测模型来指导提示调整。这种方法在减少 LLM 交互次数和提高优化效率方面具有显著优势,尤其是在面对高成本和噪声干扰的优化任务时。例如,在一个需要优化复杂工作流的任务中,贝叶斯优化可以通过构建代理模型,快速找到工作流中性能瓶颈所在,从而针对性地进行优化,提高整体效率。

(三)优化超参数:影响优化效果的关键因素

LLM 优化过程中的超参数对优化效果有着至关重要的影响。例如,聚合函数 Agg(·)的选择决定了如何将文本反馈合成以指导提示更新。不当的选择可能导致关键信息的丢失或迭代调整的不一致性。例如,在一个需要优化文本生成提示的任务中,如果聚合函数不能有效地整合多个反馈信号,可能会导致提示的更新方向不明确,影响优化效果。批量大小是另一个关键超参数,它在 LLM 基于优化中发挥着类似传统优化中批量更新的作用,能够提高优化的稳定性和效率。动量机制则通过引入历史修正信息,帮助优化过程保持稳定并提高性能。

元优化是 LLM 优化中的一个重要概念,它允许 LLM 优化器通过迭代改进自身的提示策略,将过去的决策视为经验进行学习。这种方法类似于深度学习中的学习优化器,能够使 LLM 优化器更好地适应不同的优化任务和环境。例如,一个经过元优化的 LLM 优化器可以在处理新的优化任务时,自动调整其超参数和优化策略,以达到更好的优化效果。此外,一些研究还尝试通过训练辅助模型来预测有效的超参数,从而减少穷举搜索的计算成本。然而,这些方法也面临着新的挑战,如在自适应调整过程中平衡探索与利用的权衡,以及确保优化策略在多样化任务中的泛化能力。

(四)深度与时间维度的优化:动态优化的探索

与传统优化器不同,LLM 在优化过程中不仅考虑单次执行的深度,还能够在时间维度上进行动态优化。在深度方面,LLM 类似于前馈神经网络,通过在不同模块之间传递信息来优化工作流。而在时间维度上,LLM 则可以像循环神经网络或通用变换器一样,通过迭代更新来优化决策过程。例如,StateFlow 通过在多次迭代中引入反馈,增强工作流的动态调整和适应能力。这种动态优化使得智能体能够根据环境变化和任务需求,实时调整其行为和策略,提高适应性和效率。例如,在一个需要处理实时数据流的智能体中,通过时间维度的优化,智能体可以不断更新其对数据的理解和处理方式,从而更好地应对数据的变化和不确定性。

尽管这种深度与时间维度的优化为智能体的自我进化提供了更强大的能力,但一些传统的工程优化技术,如检查点保存和截断反向传播等,在 LLM 优化中的应用仍然较少。这些技术在传统优化领域中被广泛使用,以提高优化效率和稳定性。因此,将这些技术引入 LLM 优化领域,可能会为智能体的自我进化带来新的突破和改进。例如,检查点保存技术可以在 LLM 优化过程中定期保存模型状态,以便在出现异常或需要回滚时快速恢复到之前的状态,提高优化过程的可靠性和稳定性。

(五)理论视角:探索 LLM 优化的理论基础

从理论角度来看,LLM 作为优化器的成功背后有着多方面的解释和研究。上下文学习是其中的一个重要视角。研究表明,LLM 能够在上下文中学习多种回归假设,包括正则化线性模型、决策树和浅层神经网络等。进一步的研究还证明了 LLM 可以实现迭代优化算法,如梯度下降和二阶更新等。然而,这些理论模型主要关注 LLM 在离散输入输出空间中的优化能力,对于大规模 LLM 在上下文学习中的泛化能力,目前还缺乏全面的理论解释。例如,尽管我们知道 LLM 可以在某些任务中表现出色,但对其在新任务或新领域中的泛化能力仍需更多理论支持来解释和预测。

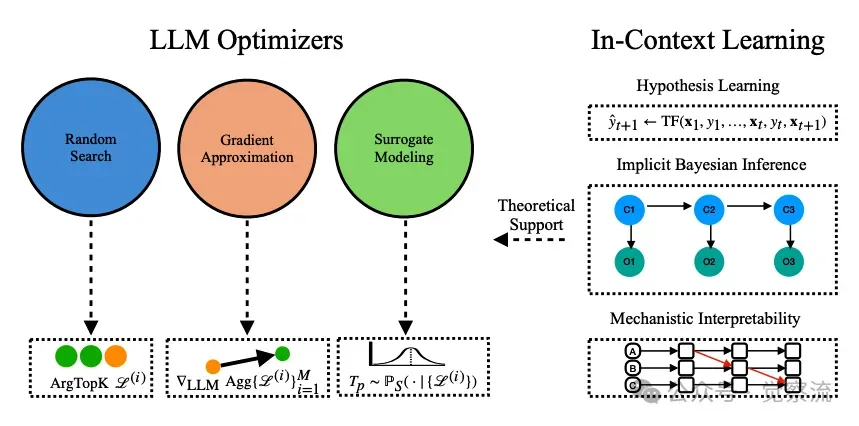

下图展示了基于 LLM 的优化方法的分类,包括随机搜索、梯度近似和代理建模等,同时强调了上下文学习的理论解释,如假设学习、隐式贝叶斯推理和机制可解释性,这些解释支撑了 LLM 的优化能力。通过这种分类,我们可以更清晰地理解 LLM 优化方法的多样性和理论基础,为选择和开发适合特定任务的优化策略提供指导。例如,在一个需要快速探索解空间的任务中,随机搜索方法可能更为合适;而在需要高效利用梯度信息的任务中,梯度近似方法则更具优势。这种对优化方法的深入理解,有助于我们在实际应用中更好地利用 LLM 的优化能力,推动生成式 AI 系统的自我进化和发展。

基于大型语言模型(LLM)的优化方法分类

三、智能体的在线与离线自我改进:适应与稳定的平衡

智能体的自我改进可以分为在线自我改进和离线自我改进两种主要方式,它们各自具有独特的特点和优势,适用于不同的应用场景。

(一)在线智能体自我改进:实时适应与动态优化

在线自我改进是指智能体在实时环境中,根据即时反馈动态调整自身行为的过程。这种方式使智能体能够快速响应环境变化,持续优化关键性能指标,如任务成功率、延迟、成本和稳定性等。在线自我改进在需要动态适应性的应用中表现出色,例如实时决策制定、个性化用户交互和自动化推理系统等。

迭代反馈与自我反思是在线自我改进中的重要策略。例如,Reflexion、Self-Refine 和 Tree of Thoughts 等方法通过引入自我批评循环,让模型实时识别错误并提出修正方案。ReAct 则结合了链式思考 “推理” 和 “行动”,使模型能够在观察外部反馈后迭代修订步骤。这些方法通过减少错误传播,支持智能体在无需单独离线微调周期的情况下快速适应。例如,在一个需要实时处理用户请求的智能客服系统中,通过迭代反馈与自我反思,智能体可以根据用户的反馈及时调整回答策略,提高用户满意度。

在多智能体系统中,主动探索也是一种有效的在线自我改进策略。例如,MetaGPT、CAMEL 和 ChatDev 等系统展示了多角色或多智能体生态系统,它们通过实时互动和连续反馈来优化各自的表现。HuggingGPT 则通过中央 LLM 控制器协调托管在 Hugging Face 上的多个专业模型,动态分配任务并收集反馈。这些策略不仅展示了智能体之间的协同进化,还强调了在线更新在多智能体系统中的重要性。例如,在一个需要多个智能体协作完成复杂任务的场景中,通过主动探索和实时反馈,智能体可以不断调整自己的行为和策略,以更好地与其他智能体协作,提高任务完成效率。

实时奖励塑造是在线自我改进中的另一种策略。一些框架通过整合即时反馈信号,不仅纠正错误,还动态调整内部奖励函数和策略。这种自适应奖励校准能够平衡性能、计算成本和延迟之间的权衡,使智能体能够根据用户互动动态优化奖励机制。例如,在一个需要智能体根据用户行为动态调整推荐内容的场景中,实时奖励塑造可以根据用户的点击率、停留时间等反馈信号,实时调整推荐策略,以提高用户的参与度和满意度。

动态参数调整则允许智能体根据实时反馈自主更新内部参数,如提示模板、工具调用阈值和搜索启发式等。例如,Self-Steering Optimization(SSO)通过在迭代训练过程中自动生成偏好信号,消除了手动标注的需要,同时保持了训练的准确性。这种动态参数调整使得智能体能够根据环境变化和任务需求,实时优化自身的参数配置,提高适应性和性能。例如,在一个需要智能体在不同网络环境下调整数据传输策略的场景中,通过动态参数调整,智能体可以根据网络状况实时调整传输参数,以确保数据传输的稳定性和效率。

(二)离线智能体自我改进:系统优化与长期稳定

与在线自我改进不同,离线自我改进依赖于结构化的批量训练过程。它利用预先收集的高质量数据集,在训练阶段对智能体进行全面优化。这种方法允许使用计算密集型的技术,如批量参数更新和微调、元优化以及系统性奖励模型校准等,从而在部署前为智能体提供强大的泛化能力和稳定性。

批量参数更新和微调是离线自我改进中的常见方法。智能体通过监督学习或强化学习技术,在多个训练周期内对大规模数据集进行优化。例如,检索增强生成(RAG)技术常被集成到离线训练中,以增强智能体的情境理解和长期记忆检索能力。这种方法不仅优化了智能体的检索策略,还提高了其在广泛知识库上的推理能力。例如,在一个需要智能体处理大量文本数据的场景中,通过离线的批量参数更新和微调,智能体可以学习到更有效的文本表示和检索策略,从而在处理新文本数据时表现出更好的性能和准确性。

元优化是离线自我改进中的另一个重要方面。它不仅关注任务性能的提升,还致力于优化算法本身的改进。例如,通过优化超参数或动态重构优化过程,智能体能够发现适用于新问题领域的最有效学习参数。这种方法使智能体在面对新任务时能够快速适应并优化性能。例如,在一个需要智能体处理不同类型数据的任务中,通过离线的元优化,智能体可以自动调整其学习算法的超参数,以适应不同类型数据的特点,提高任务处理效率和准确性。

系统性奖励模型校准也是离线自我改进中的关键环节。通过使用层次化或列表式奖励整合框架(如 LIRE),智能体能够在梯度基础上优化奖励函数,从而确保其行为与长期目标保持一致。这种校准方法能够减少奖励函数中的偏差,提高智能体的泛化能力,使其在复杂任务中表现出色。例如,在一个需要智能体在多目标优化任务中平衡不同目标的场景中,通过离线的系统性奖励模型校准,智能体可以优化其奖励函数,以更好地平衡不同目标之间的关系,提高整体任务绩效。

(三)在线与离线改进的比较:各有所长与取舍

在线和离线优化各有优势,适用于不同的应用场景。在线优化在动态环境中表现出色,能够实时响应环境变化,快速适应新情况。然而,频繁的更新可能会导致性能不稳定或出现漂移现象,需要采取措施来缓解这些问题。例如,在一个需要智能体实时处理股票市场数据的场景中,在线优化可以使智能体快速适应市场变化,但同时也需要防止因频繁更新而导致的性能波动,以免影响投资决策的稳定性。

离线优化则侧重于使用结构化的、高质量的数据集进行高保真度的训练,确保智能体在部署前具有强大的泛化能力和稳定性。这种方法能够利用计算密集型的学习方法,如批量训练和微调,为智能体提供坚实的性能基础。然而,离线优化缺乏在线学习的灵活性,可能难以快速适应新场景,需要额外的再训练过程。例如,在一个需要智能体处理医疗影像数据的场景中,离线优化可以利用大量的历史医疗影像数据对智能体进行系统训练,使其具备强大的疾病诊断能力。但在面对新的疾病类型或影像特征时,可能需要重新进行离线训练,才能提高诊断准确性。

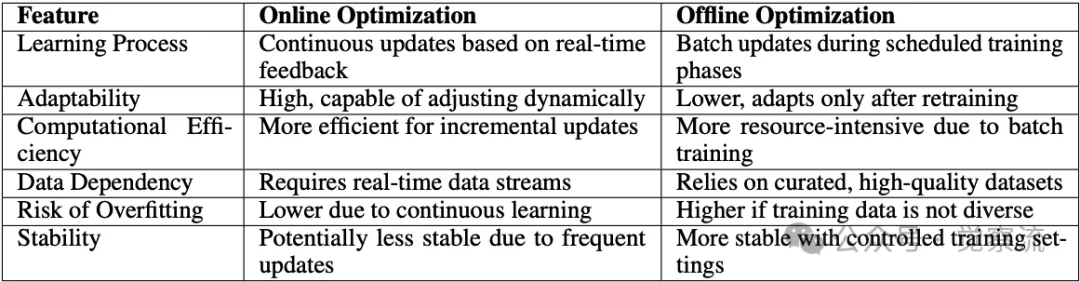

下表展示了在线与离线优化策略的比较,涵盖了学习过程、适应性、计算效率、数据依赖、过拟合风险和稳定性等多个方面。通过这种比较,我们可以更清晰地了解每种方法的优势和局限性,从而在实际应用中做出明智的选择。例如,在需要快速适应动态环境的应用中,在线优化可能更为合适;而在需要高稳定性和泛化能力的场景中,离线优化则更具优势。这种对优化策略的深入理解,有助于我们在智能体的开发和部署中,充分发挥各自的优势,实现最佳的性能表现。

在线与离线优化策略在自我改进智能体中的比较

(四)混合方法:融合在线与离线优势的优化策略

为了充分发挥在线和离线优化的优势,现代智能系统越来越多地采用混合优化策略。这种策略将离线训练的稳定性与在线更新的动态性相结合,使智能体能够在动态环境中持续改进,同时保持长期的稳定性和可靠性。

混合优化过程通常包括三个阶段:离线预训练、在线微调和定期离线整合。在离线预训练阶段,智能体通过在高质量数据集上的广泛训练,获得强大的基础能力。例如,Schrittwieser 等人提出的方法展示了如何通过离线预训练系统地增强智能体的初始能力,为后续的在线改进奠定坚实基础。在这个阶段,智能体可以从大量的历史数据中学习到通用的知识和技能,为后续的在线优化提供坚实的基础。

在线微调阶段,智能体根据实时反馈动态调整其行为和策略。例如,Decision Mamba-Hybrid(DM-H)展示了智能体如何在复杂多变的环境中高效适应,通过实时评估和调整策略来优化其性能。在这个阶段,智能体可以利用实时数据对预训练模型进行微调,使其更好地适应当前环境和任务需求。例如,在一个需要智能体处理实时交通数据的场景中,通过在线微调,智能体可以根据当前的交通状况实时调整交通流量预测模型,提高预测准确性。

定期离线整合阶段,智能体将在线交互中获得的增量改进系统地整合到其核心模型中。例如,Uni-O4 框架展示了如何在离线知识整合和在线适应改进之间实现无缝过渡,确保智能体在长期运行中保持稳定性和有效性。在这个阶段,智能体会将在线优化过程中积累的经验和数据进行系统整理和分析,进一步优化模型结构和参数,为下一轮的在线优化提供更强大的基础。例如,在一个需要智能体不断学习新知识的教育应用场景中,定期离线整合可以帮助智能体将在线教学过程中收集到的学生反馈和学习数据进行深度分析,优化教学内容和策略,提高教学效果。

通过这种混合优化策略,智能体能够在动态环境中实现持续的自我进化,同时保持长期的稳定性和可靠性。这种方法不仅提高了智能体的适应能力,还为其在复杂现实场景中的应用提供了有力支持。例如,在一个需要智能体同时处理多种不同类型任务的工业自动化场景中,混合优化策略可以使智能体在保持稳定运行的同时,不断适应新的生产流程和任务要求,提高生产效率和质量。

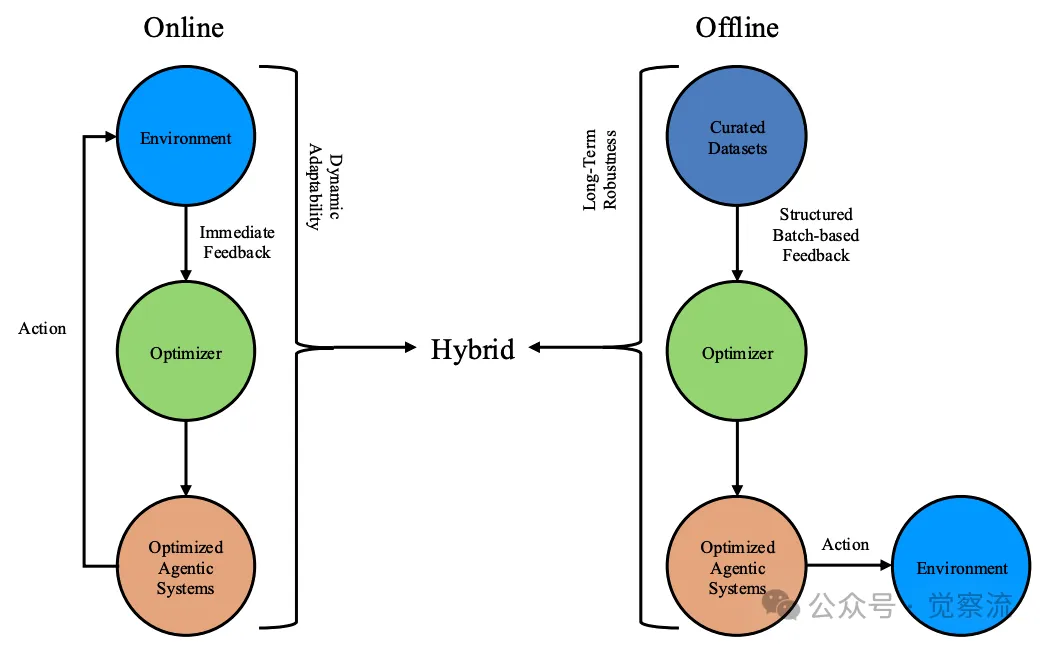

下图通过三种不同的使用场景(在线、离线和混合自我改进)来说明智能体的自我改进过程,展示了智能体如何在不同的优化策略下实现自我进化。这种对比不仅帮助我们更直观地理解智能体的自我改进机制,还为我们在实际应用中选择合适的优化策略提供了参考。通过观察图中不同场景下的改进路径,我们可以发现,在线自我改进在动态环境中具有快速响应的能力,而离线自我改进则在稳定性和泛化能力上更具优势。混合方法则结合了两者的优势,使智能体能够在不同的环境条件下实现最佳的性能表现。这种对智能体自我改进机制的深入理解,有助于我们在实际应用中更好地设计和优化智能体系统,以满足多样化的任务需求。

在线与离线优化策略在自我改进智能体中的比较

四、科学发现与智能进化:智能体的自主探索之旅

智能体在科学知识发现中的应用是其自我进化的一个重要方向。科学知识发现不仅是智能体适应世界的一种方式,也是推动人类科技进步的重要力量。通过自主发现科学知识,智能体能够帮助人类扩展知识边界,加速科学创新。

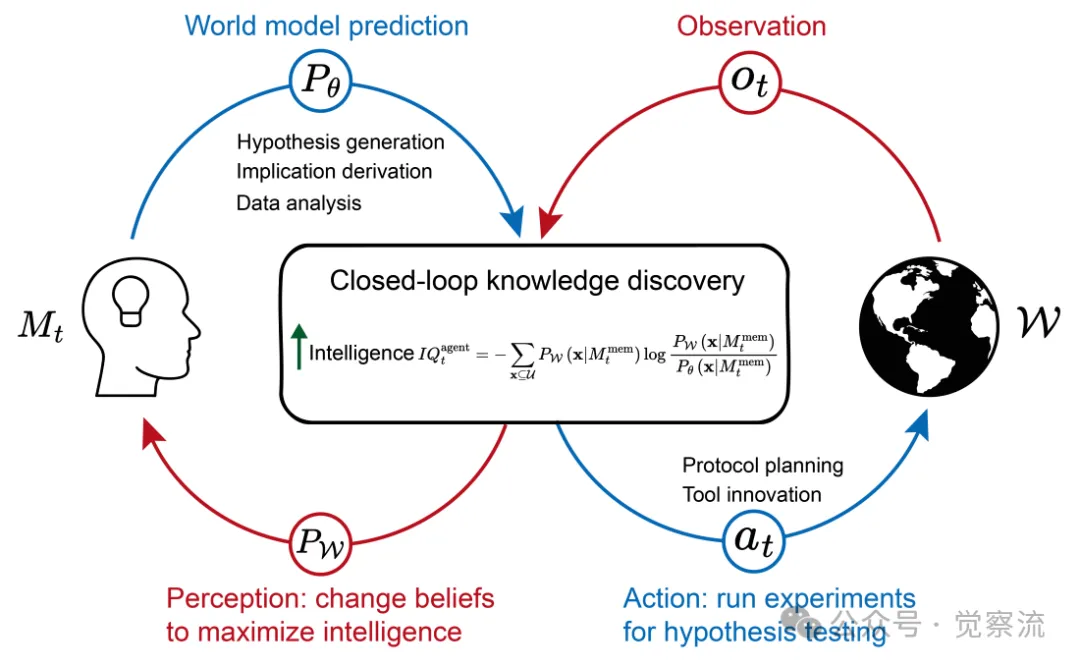

(一)智能体在科学知识发现中的智能度量

科学知识发现可以被定义为收集数据和信息以验证或证伪关于目标科学问题的理性假设的过程。为了衡量智能体在科学知识发现中的智能水平,我们可以从信息论的角度出发,使用 KL 散度来衡量智能体预测分布与真实世界分布之间的差异。

假设智能体的世界模型参数为 ✓,其预测分布为 P✓(x),而真实世界的分布为 PW(x),那么智能体的智能度量可以表示为:

其中, 表示智能体的记忆, 表示未知信息空间。这个公式表明,智能体的智能度量与其记忆和世界模型参数密切相关。随着智能体获取更多知识并优化其世界模型,其智能度量会相应提高。例如,在一个材料科学领域,智能体可以通过不断学习和实验,积累关于材料性质和合成方法的知识,优化其世界模型参数,从而提高在新材料发现任务中的智能度量。

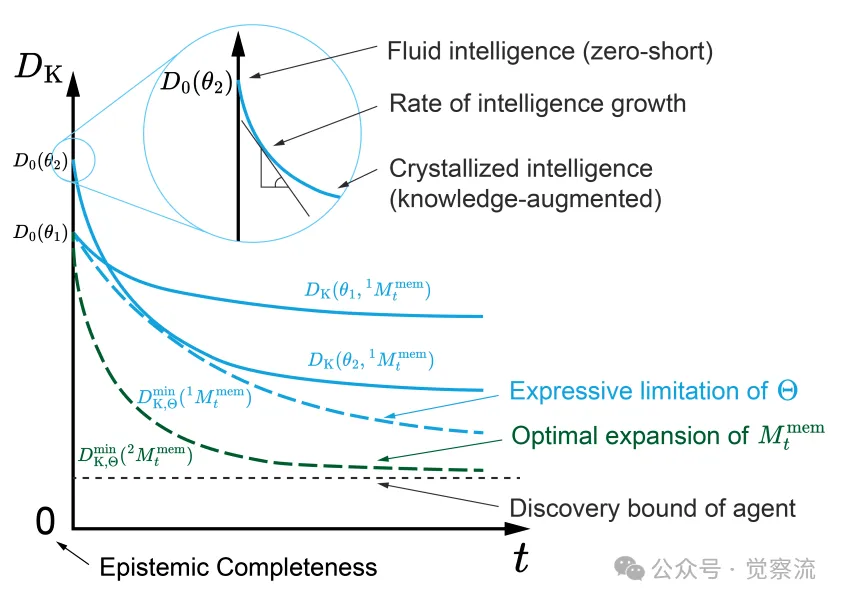

下图通过 KL 散度展示了智能体智能随时间的演变,从流体智能到晶体智能的转变过程。图中展示了在世界模型参数空间中,智能体的智能度量如何随着记忆的积累而变化,以及不同知识扩展策略对智能体智能发展的影响。这种可视化不仅帮助我们更直观地理解智能体智能的演变过程,还揭示了智能体在科学知识发现中的潜力和局限性。通过观察图中智能体智能度量的变化趋势,我们可以更好地把握智能体在不同阶段的学习重点和发展方向,为智能体的优化和改进提供指导。例如,在智能体的早期发展阶段,我们可能更关注其流体智能的提升,以增强其对新问题的零样本预测能力;而在后期阶段,我们则更注重晶体智能的增强,通过知识的积累和整合,提高智能体在特定领域的专业知识和预测能力。这种对智能体智能演变的深入理解,有助于我们在智能体的设计和训练过程中,制定更有效的策略,以充分发挥其在科学发现中的潜力。

智能体及其知识发现的示意图

(二)智能体与科学知识的交互:从假设生成到数据分析

智能体与科学知识的交互主要体现在三个典型场景中:假设生成与测试、协议规划与工具创新以及数据分析与意义推导。

假设生成与测试是智能体在科学知识发现中的一个重要应用。智能体可以根据其当前的知识和理解,生成关于未知现象的假设,并设计实验或计算方法来验证这些假设。例如,AI Scientist 系统能够独立进行研究,包括提出原创性研究想法、编写代码、进行计算实验、可视化结果、撰写科学论文,甚至模拟同行评审过程。通过这种方式,智能体能够快速扩展其知识库,提高其对科学问题的理解。例如,在一个生物学研究中,智能体可以生成关于某种基因功能的假设,然后设计实验来验证该假设,如通过基因编辑技术观察基因表达变化对生物体的影响,从而推动生物学知识的发现和进步。

协议规划与工具创新则涉及到智能体在实验和计算过程中的策略制定和工具使用。智能体需要能够规划实验协议,选择合适的工具,并在必要时创新工具以解决复杂的科学问题。例如,Virtual Lab 系统中的 AI 代理通过团队合作和任务分配,开发了多种工具来设计和验证新型 SARS-CoV-2 纳米抗体。这些工具不仅提高了实验效率,还帮助智能体更好地完成科学发现任务。例如,在一个化学合成研究中,智能体可以规划合成路线,选择合适的反应条件和试剂,甚至创新性地设计新的合成方法,以合成具有特定性能的新化合物。

数据分析与意义推导则侧重于智能体对已有数据的深入分析和理解。通过运用演绎推理和归纳推理,智能体可以从已知数据中推导出新的知识和结论。例如,AlphaGeometry 系统能够基于欧几里得平面几何中的现有定理,通过前向演绎生成新的数学定理。这种能力使智能体能够在没有直接实验观察的情况下,通过逻辑推理和数据分析来扩展其知识库。例如,在一个天文学研究中,智能体可以分析大量的天文观测数据,通过数据挖掘和统计分析方法,发现新的天体运行规律或宇宙现象,为天文学研究提供新的见解和理论支持。

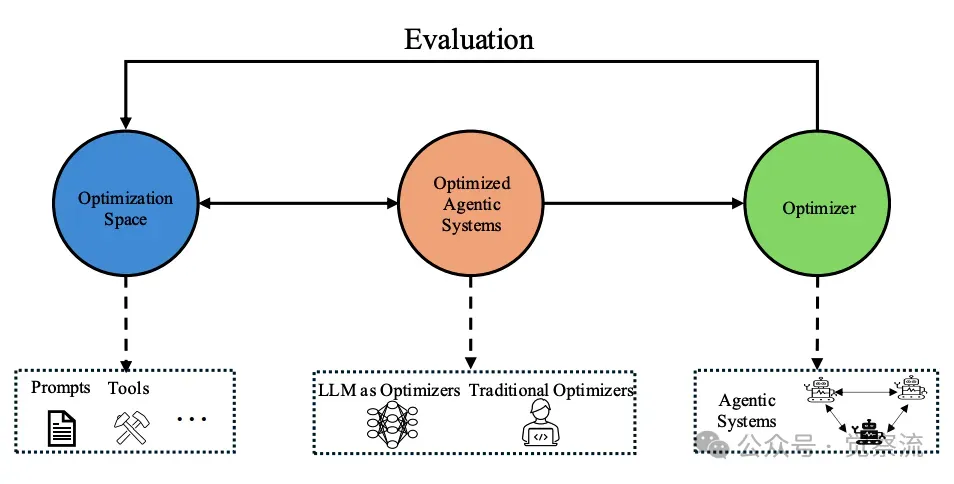

下图展示了 LLM 智能体自我进化的结构,包括优化空间、优化器和优化目标之间的关系。通过这种结构化展示,我们可以更清晰地理解智能体自我进化的各个方面如何相互作用,共同推动智能体的性能提升和能力扩展。图中强调了不同优化空间(如提示优化、工作流优化和工具优化)之间的联系,以及优化器如何在这些空间中迭代改进智能体的各个组件。这种对智能体自我进化机制的可视化理解,有助于我们在实际应用中更有效地设计和实施优化策略,以实现智能体的持续改进和发展。例如,在开发一个需要处理复杂文本数据的智能体时,我们可以参考图中的结构,首先优化提示以提高文本理解能力,然后优化工作流以协调多个 LLM 组件的协作,最后优化工具以增强智能体的数据处理和分析能力。通过这种系统性的优化方法,智能体能够在多个层面实现自我进化,更好地完成复杂的任务。

大型语言模型智能体中的自我进化结构

(三)技术成熟度与挑战:迈向完全自主的智能体

尽管智能体在科学知识发现中已经取得了一些初步成果,但要实现完全自主的自我进化,仍面临诸多挑战。这些挑战主要集中在实际世界交互、复杂推理和先验知识整合等方面。

实际世界交互方面,智能体主要通过应用程序接口(API)与物理实验室进行交互。然而,目前能够直接执行物理实验任务的 API 仍然稀缺,开发这些接口需要大量的时间、专业知识和成本。此外,现有的自主实验室大多处于早期发展阶段,难以直接复制或大规模推广。因此,开发更多能够直接控制实验室设备的物理 API,以及将现有设备与智能体系统进行有效集成,是实现智能体自主科学发现的关键任务。例如,在一个需要智能体控制显微镜进行细胞观察的实验中,由于缺乏合适的物理 API,智能体可能无法直接操作显微镜,这就需要开发专门的接口来实现智能体与显微镜之间的通信和控制,以完成实验任务。

复杂推理方面,尽管 LLM 驱动的智能体在语言生成和理解方面表现出色,但在处理复杂的逻辑和数值问题时仍存在不足。例如,在解决高级数学问题和科学实验设计中,智能体常常需要借助外部工具来弥补其在数值计算和逻辑推理上的不足。因此,提升智能体的复杂推理能力,使其能够更好地处理科学知识发现中的复杂任务,是当前研究的一个重要方向。例如,在一个需要智能体进行高精度数学建模和计算的工程设计任务中,智能体可能需要调用专门的数学计算库或工具来完成复杂的方程求解和模型优化,以提高设计的准确性和效率。

先验知识整合方面,尽管 LLM 已经包含了大量公开可获取的知识,但仍有许多知识未被纳入其训练范围。例如,付费墙后的知识、行业特定数据、专家经验以及与实际应用场景相关的知识等,这些知识对于智能体在特定领域的深入理解和创新至关重要。此外,如何有效地整合这些不同来源的知识,避免信息冲突,也是一个需要解决的问题。例如,在一个需要智能体处理医疗领域专业知识的任务中,由于医疗数据的敏感性和专业性,许多关键知识可能未被包含在 LLM 的训练数据中。这就需要我们开发有效的知识整合方法,将这些外部知识安全、准确地融入智能体的知识体系,以提高其在医疗领域的决策能力和创新能力。

下图通过图示展示了智能体自我进化中的关键概念,包括优化空间、优化器和优化目标之间的关系。图中展示了优化器如何在优化空间中迭代改进各个组件,以提升智能体系统的性能,从而实现自我进化。这种直观的展示方式有助于我们更好地理解智能体自我进化的机制,明确优化过程中各个要素的作用和相互作用。例如,优化空间代表了智能体可以改进的各个维度,如提示、工作流和工具等;优化器则是负责在这些空间中进行搜索和调整的机制,如 LLM 本身或其他专门的优化算法;优化目标则是指导优化方向的指标,如性能、推理成本和延迟等。通过这种图示,我们可以更清晰地看到智能体自我进化的全貌,理解如何通过优化器在不同的优化空间中进行迭代改进,以达到提升智能体整体性能的目的。这种对智能体自我进化过程的深入理解,为我们设计和开发更高效的智能体系统提供了宝贵的指导。

智能体自我进化中的关键概念示意图,包括优化空间、优化器和优化目标。优化器在优化空间内迭代地改进各个组件,以增强智能体系统,直至达到满意的成果,从而实现大型语言模型智能体系统中的自我改进。.下图描绘了智能体在科学知识发现中的闭环过程,展示了智能体如何通过假设生成与测试以及数据分析与推导来提升其智能水平。图中展示了智能体在与物理世界交互时如何生成假设、进行实验、观察结果并更新信念,以及在不与物理世界交互时如何从已有数据中提炼知识并直接更新心理状态。这种闭环过程不仅体现了智能体在科学知识发现中的自主探索能力,还展示了其通过不断学习和实践提升智能水平的路径。通过这种可视化展示,我们可以更清晰地理解智能体在科学发现中的工作原理和进化机制,为开发更智能、更自主的科学探索系统提供参考。例如,在一个化学研究场景中,智能体可以根据已有的化学知识生成关于新化合物性质的假设,通过实验验证这些假设,收集实验数据并分析结果,从而不断扩展其对化学领域的理解。同时,智能体还可以利用其积累的数据和知识,进一步优化实验设计和数据分析方法,提高科学发现的效率和准确性。这种闭环的科学知识发现过程,使智能体能够在不断的实践中自我进化,为科学进步做出贡献。

闭环知识发现以实现可持续的自我演化

本节总结:智能体自我进化的未来展望

回顾智能体自我进化的主要机制与方法,我们可以看到从优化空间与维度的拓展、大语言模型作为优化器的应用,到在线与离线自我改进策略以及智能体在科学发现中的智能进化,这些研究进展为智能体技术的发展奠定了坚实基础。优化空间与维度的拓展为智能体提供了更广阔的进化路径,大语言模型作为优化器则为智能体的自我进化提供了强大的技术支持,而在线与离线自我改进策略则确保了智能体在动态环境中的持续适应能力。在科学发现领域,智能体的智能进化不仅推动了其自身能力的提升,也为人类的科学进步提供了新的可能性。

随着智能体个体能力的不断提升,多个智能体之间的协作与相互作用将成为实现更复杂任务和更高级智能的关键方向。在第三部分,我们将详细探讨多智能体系统的协作与演化,包括智能体之间的协同工作、通信拓扑结构、协作范式以及集体智能的涌现等问题。这些内容将进一步揭示智能体技术的未来发展潜力,为实现真正的人工智能提供更全面的视角和更深入的理解。

由于微信公众号文章的字数限制,上篇到此结束。

参考资料

- ADVANCES AND CHALLENGES IN FOUNDATION AGENTS -(FROM BRAIN-INSPIRED INTELLIGENCE TO EVOLUTIONARY, COLLABORATIVE, AND SAFE SYSTEMS)

https://arxiv.org/pdf/2504.01990

- 本项目的 Github 仓库

https://github.com/FoundationAgents/awesome-foundation-agents

- Agent Hospital: A Simulacrum of Hospital with Evolvable Medical Agents

https://arxiv.org/pdf/2405.02957

- MetaGPT Repo - geekan/MetaGPT

https://github.com/geekan/MetaGPT

- CAMELAI Repo - camel-ai/camel

https://github.com/camel-ai/camel

- ChatDev Repo - OpenBMB/ChatDev

https://github.com/OpenBMB/ChatDev