一、什么是正则化?

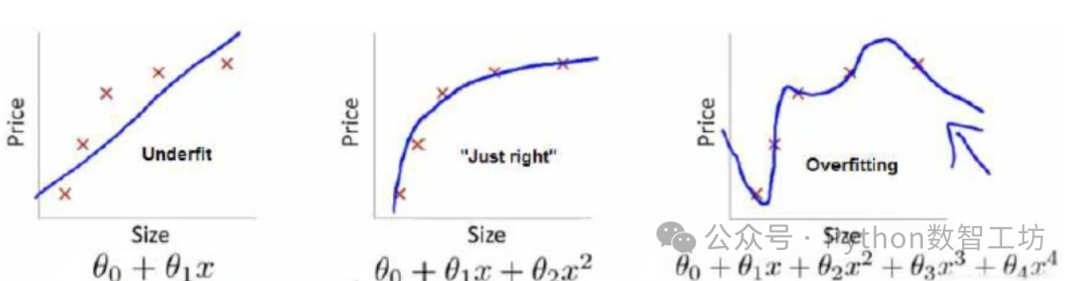

正则化是机器学习和统计建模中的关键技术,用于控制模型复杂度,防止过拟合(overfitting)。当模型过度拟合训练数据时,它会过度关注数据中的噪声和细节,导致在新数据上表现显著下降。

核心机制:在损失函数中添加惩罚项,约束模型参数的大小或数量,引导模型学习简单规律而非噪声。

▲ 左图欠拟合、右图过拟合、中间为理想状态

二、为什么需要正则化?

1. 过拟合的致命陷阱

现象:模型在训练集上准确率高(如95%),但在测试集上暴跌(如60%)。

根源:

- 数据噪声干扰(如传感器误差)

- 特征过多而样本不足

- 模型复杂度过高(如深层神经网络)

2. 正则化的数学本质

通过修改损失函数实现:

复制其中 λ(正则化参数) 控制惩罚强度:

- λ 过小 → 惩罚无效 → 仍过拟合

- λ 过大 → 模型塌缩 → 欠拟合[1][5]

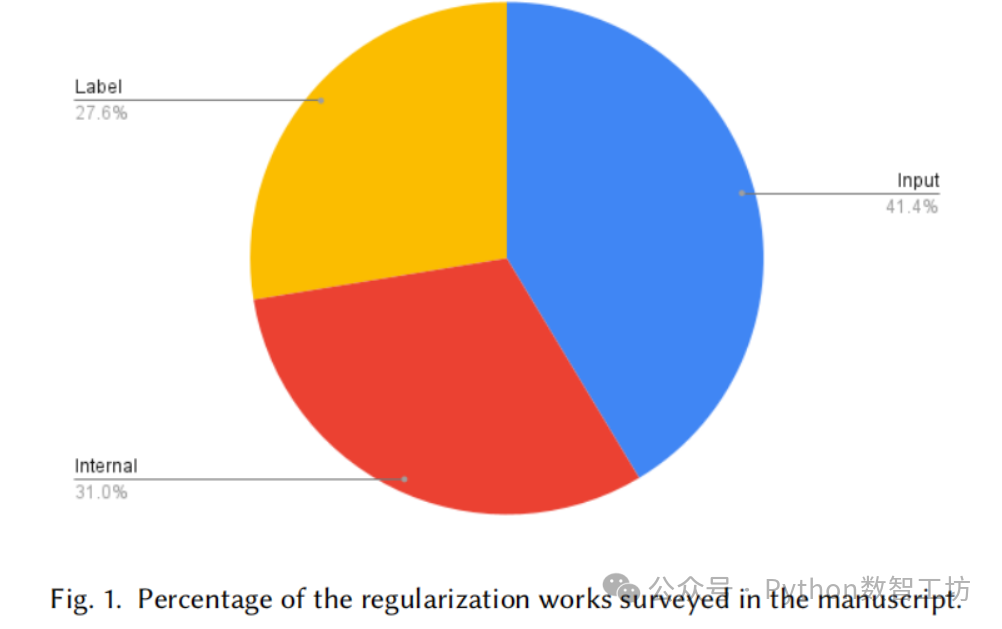

三、主流正则化技术详解

1. L1正则化(Lasso)

数学形式:

复制核心作用:强制部分权重归零 → 特征自动选择

适用场景:高维数据中筛选关键特征(如基因分析)

复制2. L2正则化(Ridge)

数学形式:

复制核心作用:压缩所有权重但不归零 → 提升稳定性

适用场景:防止权重爆炸(如RNN时序模型)

▲ L1产生稀疏解,L2平滑收缩参数

3. Dropout(深度学习守护者)

工作原理:

- 训练时:随机丢弃神经元(概率为p)

- 测试时:激活值按比例缩放(乘以1-p)

本质:强制网络学习冗余特征,模拟大脑神经备份机制。

4. 数据增强(Data Augmentation)

策略:

- 图像:旋转/裁剪/颜色抖动

- 文本:同义词替换/回译效果:通过扩展数据多样性提升泛化能力,尤其在计算机视觉中效果显著

四、工程实践指南

1. 正则化参数λ调优

λ值 | 训练损失 | 验证损失 | 状态 | 行动建议 |

<0.0001 | 0.01 | 0.25 | 严重过拟合 | 增大λ至10倍 |

0.001 | 0.05 | 0.12 | 轻微过拟合 | 增大λ至2倍 |

0.01 | 0.08 | 0.09 | 最优 | 微调(±20%) |

>0.1 | 0.30 | 0.35 | 欠拟合 | 减小λ至1/10 |

2. 场景化选择策略

复制五、前沿发展

1. 对抗正则化(Adversarial Regularization)

在损失函数中增加对抗样本约束:

复制使模型抗攻击能力提升10倍。

2. 量子正则化雏形

通过量子纠缠约束模型复杂度:

复制其中H_reg编码复杂度限制,已在量子机器学习中验证。

六、结语:正则化的科学哲学

“正则化不是锦上添花,而是生存必需。” —— 深度学习先驱 Yoshua Bengio

正则化的本质是模型容量与泛化需求的平衡艺术:

- L1正则化是“特征剪刀”,剪除冗余特征

- L2正则化是“权重压缩器”,防止数值膨胀

- Dropout是“脑力沙盘推演”,模拟神经元失效的极端情况

在数据爆炸的时代,正则化从被动防御转向主动构建鲁棒性(如对抗训练),成为AI模型泛化的核心引擎。