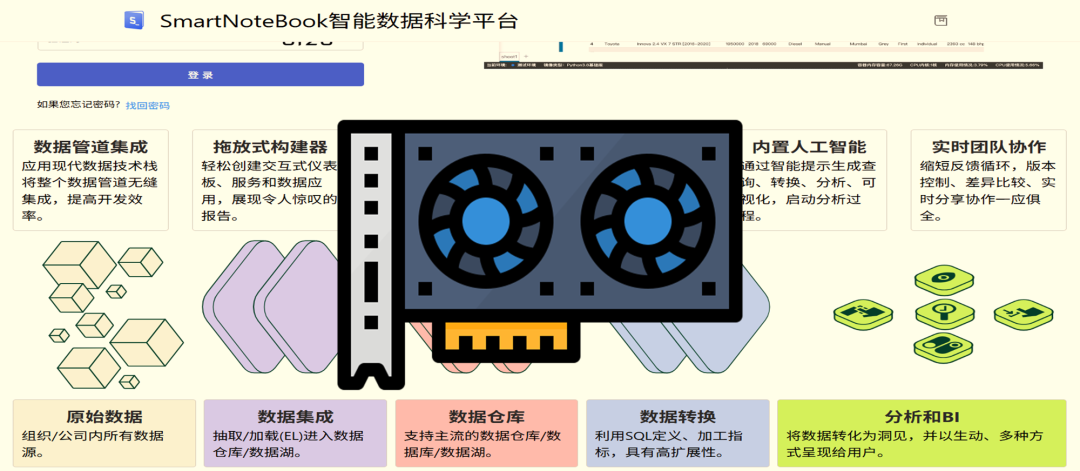

在数据科学与深度学习的日常工作中,GPU 已经成为不可或缺的计算加速工具。无论是训练大规模 Transformer 模型,还是运行复杂的图像处理与科学计算任务,GPU 都能显著提升性能。

SmartNotebook 作为一款类似 Hex.tech 的现代化 DataNotebook 平台,不仅支持在容器环境中快速部署,还可以通过简单的配置实现 GPU 加速,让用户在 DataNotebook 内即可运行深度学习任务。。

本文将介绍如何在 SmartNotebook 中配置 GPU 支持,并以 torch 为例进行验证,内容分为以下四个部分:

- CUDA 安装

- Docker 及 Container-Toolkit 配置

- docker-compose 添加 GPU 支持

- 安装 Torch 并测试

1.CUDA 安装

cudu 默认已经内置了 NVIDIA 驱动。如果在宿主机上额外安装驱动,可能导致版本冲突,出现 安装失败 等问题。

NVIDIA CUDA 下载地址,可以根据系统类型进行筛选:

复制安装命令如下:

复制 图片

图片

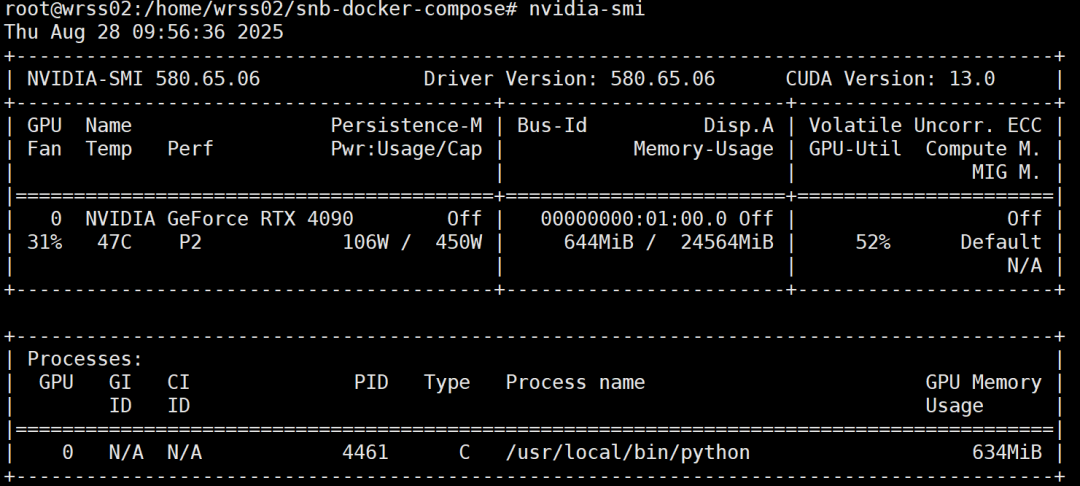

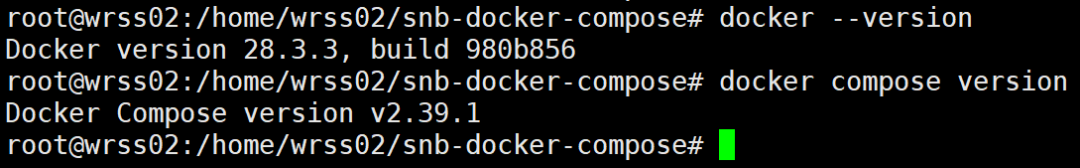

2.docker及NVIDIA container-toolkit的安装

从 Docker 20 版本开始,Docker 已经原生支持 docker compose 命令,不再需要单独安装 docker-compose。

因此需要确保安装 Docker 28+,并安装 docker compose 插件。

安装 Docker:

复制复制复制 图片

图片

安装 NVIDIA Container Toolkit(用于容器访问 GPU)

安装文档:

复制修改运行脚本 docker-compose-simple.sh:

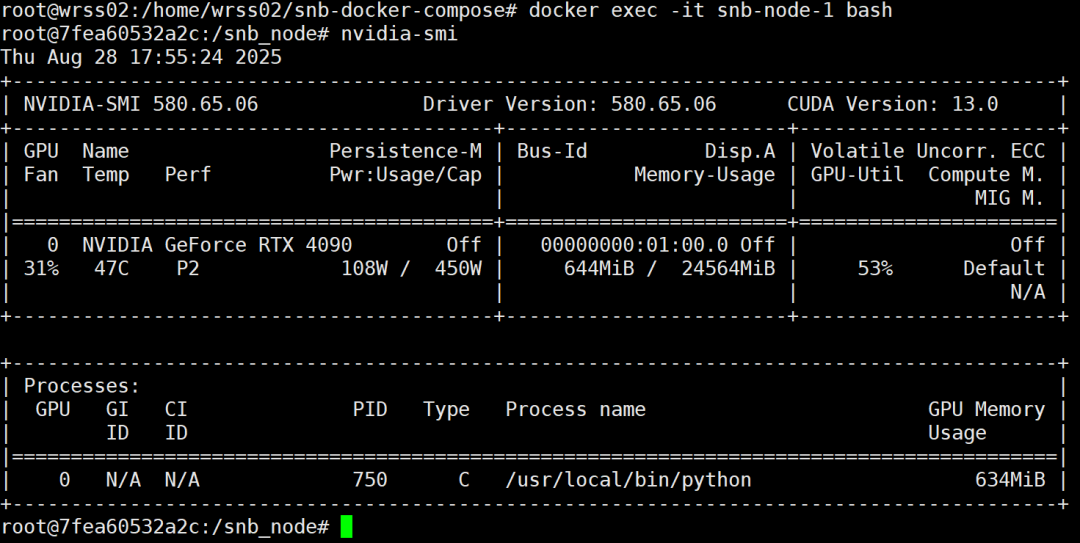

复制3.docker-compose 添加GPU配置项

在完成 NVIDIA Container Toolkit 安装后,可以在 docker-compose.yml 中使用 gpus: all 来开启 GPU。

示例 docker-compose-simple.yml:

复制这里 node 服务绑定了宿主机 GPU,Notebook 内部的 Python 环境即可调用 CUDA。

图片

图片

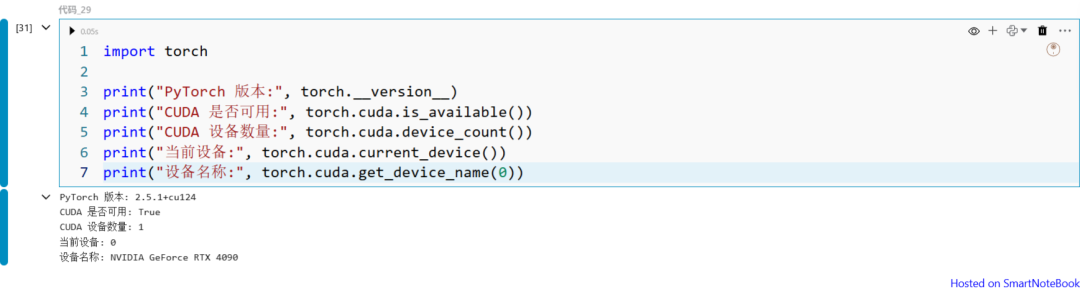

4.安装torch及测试

进入 Notebook 或容器后,安装 torch:

复制测试 GPU 是否可用:

复制 图片

图片

如果输出结果显示 CUDA is available: True,并且能正确列出 GPU 型号(如 NVIDIA A100),说明 Notebook 已经成功开启了 GPU 支持。

通过以上四个步骤,我们完成了 SmartNotebook 的 GPU 环境配置:

- 安装 CUDA,确保宿主机具备 GPU 工具链;

- 配置 Docker 与 Container-Toolkit,为容器打通 GPU 通道;

- 在 docker-compose 中开启 GPU,让 Notebook 容器能使用显卡;

- 安装 PyTorch 并测试,验证 GPU 是否可用。

这样,用户就可以在 SmartNotebook 中轻松运行深度学习任务,充分发挥 GPU 的强大算力,加速模型训练与数据分析。