国内著名社交平台小红书,开源了首个大模型——dots.llm1。

dots.llm1是一个1420亿参数的专家混合模型(MoE),在推理过程中仅激活140亿参数,能保持高性能的同时大幅度降低训练和推理成本。

dots.llm1最大特色是使用了11.2万亿token的非合成高质量训练数据,这在现阶段的开源大模型中非常罕见,看来小红书也得益于自己庞大的语料库出手就是阔啊。

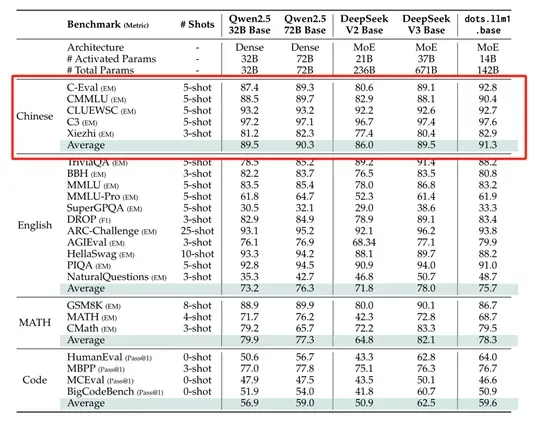

所以,在中文测试中dots.llm1的性能非常强,以91.3的平均分超过了DeepSeek开源的V2、V3和阿里开源的Qwen2.5 32B和72B。

开源地址:https://huggingface.co/rednote-hilab/dots.llm1.base/tree/main

dots.llm1架构简单介绍

dots.llm1使用了单向解码器Transformer架构,但把前馈网络替换为MoE。在传统的Transformer架构中,每一层的前馈网络是密集连接的,这意味着每一层都会对输入的所有标记进行计算。在处理大规模数据时会消耗巨大的算力。

而MoE将模型分为多个专家网络,每个专家网络专注于输入数据的不同方面。在推理过程中,并不激活所有的专家网络,而是根据输入标记的特性,动态地选择一小部分专家网络进行计算。这种稀疏激活的方式极大减少了算力的需求,同时保持了模型的高性能。

dots.llm1的MoE由128个路由专家和2个共享专家组成。每个专家网络是一个两层的前馈网络,使用了SwiGLU激活函数。SwiGLU是一种高效的激活函数,它结合了门控机制和非线性激活,能够更好地捕捉数据中的复杂关系。

在每个输入标记的处理过程中,dots.llm1会通过一个路由机制选择出6个最相关的专家网络,加上2个共享专家,总共激活8个专家网络。这种选择机制是动态的,会根据输入标记的特性来决定哪些专家网络最适合处理当前的标记。

除了MoE模块的设计,dots.llm1在注意力层也进行了优化。采用了经典的多头注意力机制(MHA),这是一种广泛应用于Transformer架构中的注意力机制。

dots.llm1在MHA的基础上引入了RMSNorm归一化操作。RMSNorm是一种改进的归一化方法,通过计算输入的均方根值来进行归一化,从而避免了输入值过大或过小对模型训练的影响。这种归一化操作在多头注意力机制中尤为重要,因为注意力机制的输出是多个头的加权和,如果没有适当的归一化,很容易出现数值不稳定的情况。通过引入RMSNorm,dots.llm1能够更好地控制注意力机制的输出,从而提高模型的稳定性和性能。

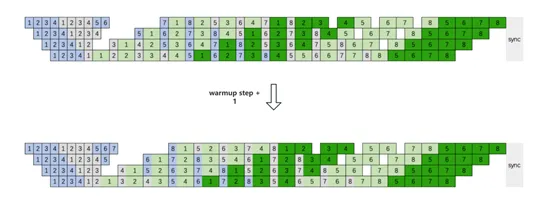

在MoE模块中,dots.llm1还引入了无辅助损失的负载平衡策略。负载平衡是MoE架构中的一个关键问题,因为如果专家网络之间的负载不平衡,会导致一些专家网络被过度使用,而另一些专家网络则很少被激活。

这种不平衡不仅会影响模型的性能,还会降低计算效率。dots.llm1通过引入一个动态调整的偏置项来解决这个问题。偏置项会根据每个专家网络的负载情况动态调整,从而确保所有专家网络的负载相对平衡,不仅能够有效地解决负载不平衡的问题,而且不会引入额外的损失函数,从而避免了对模型性能的负面影响。

此外,dots.llm1在训练过程中还采用了AdamW优化器进一步提高模型的性能和效率。这是一种改进的Adam优化器,它通过引入权重衰减来防止模型过拟合,同时采用了梯度裁剪技术,通过限制梯度的最大值来避免梯度爆炸的问题。

dots.llm1训练数据

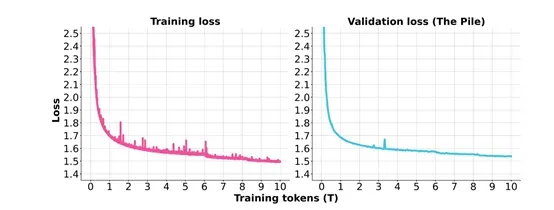

数据处理是大模型训练的基石,dots.llm1一共使用了11.2万亿token非合成数据,并构建了一套三级数据处理流水线,从杂乱无章的原始网页数据中筛选出高质量的语料。

在第一阶段的文档准备中,利用URL过滤技术屏蔽成人、赌博等有害域名,通过 trafilatura 库精准提取正文内容,借助 fastText 语言检测工具,将置信度 <0.65 的文档果断丢弃,并采用 MD5 去重方法去除重复数据,同时将中英文数据比例精心控制在 1:1。

第二阶段的规则处理同样至关重要,通过行级去重,删除前5行/后5行中出现超200次的重复行;利用启发式过滤移除广告、注册提示等低质内容;借助MinHash - LSH 模糊去重,保留 Jaccard 相似度< 80%的文档,这一系列操作剔除了约 30% 的低质内容。

第三阶段的模型处理堪称画龙点睛之笔,运用15亿参数分类器精准区分“文本详情页” 与工具 / 视频页面,保留高价值内容;通过自主开发的网页杂波去除模型逐行评分(0 - 1 分),过滤掉导航栏、边框等无关内容;

最后通过 200 类分类器平衡数据分布,将百科、科普等知识性内容占比提升至 60%,大幅减少小说和产品描述至 15%。经过TxT360数据集对比实验验证,该流水线处理后的网页数据在 MMLU、TriviaQA 等基准测试中表现优于当前 SOTA 开源数据。

值得一提的是,为了促进学术研究,小红书还开源了每1万亿token 的中间训练检查点,为大模型的学习动态提供了宝贵的见解。