近年来,大模型的应用正从对话与创意写作,走向更加开放、复杂的研究型问题。尽管以检索增强生成(RAG)为代表的方法缓解了知识获取瓶颈,但其静态的 “一次检索 + 一次生成” 范式,难以支撑多步推理与长期研究流程,由此催生了 Deep Research(DR)这一新方向。

然而,随着相关工作的快速涌现,DR的概念也在迅速膨胀并趋于碎片化:不同工作在系统实现、任务假设与评价上差异显著;相似术语的使用进一步模糊了其能力边界。

正是在这一背景下,来自山东大学、清华大学、CMU、UIUC、腾讯、莱顿大学等机构共同撰写并发布了目前最全面的深度研究智能体综述《Deep Research: A Systematic Survey》。文章首先提出一条由浅入深的三阶段能力发展路径,随后从系统视角系统化梳理关键组件,并进一步总结了对应的训练与优化方法。

GitHub:https://github.com/mangopy/Deep-Research-Survey

Website:https://deep-research-survey.github.io/

论文地址:https://deep-research-survey.github.io/static/doc/Deep-Research-Survey.pdf

什么是 Deep Research

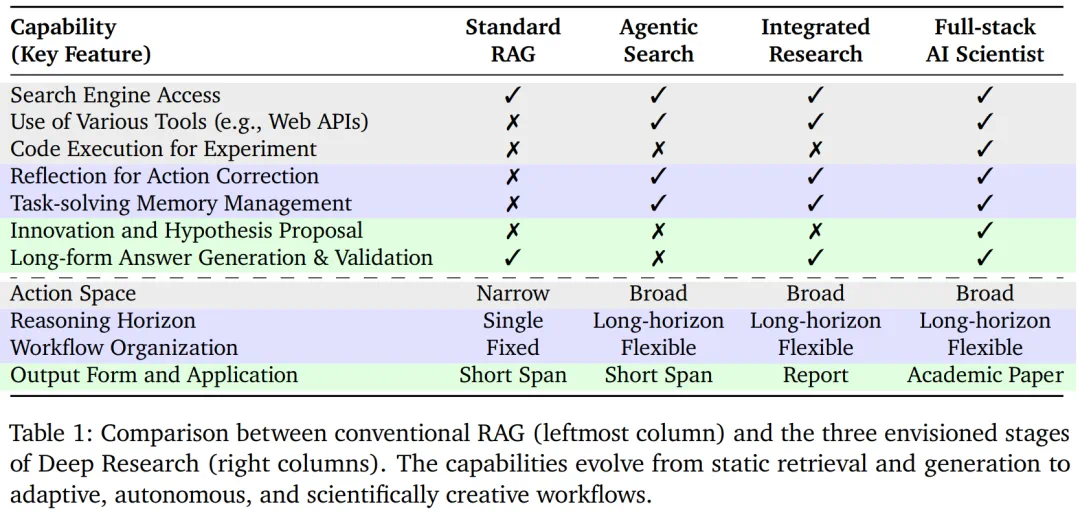

DR 并非某一具体模型或技术,而是一条逐步演进的能力路径。综述刻画了研究型智能体从信息获取到完整科研流程的能力提升过程。基于对现有工作的梳理,可将这一演进划分为三个阶段。

阶段 1:「Agentic Search」。模型开始具备主动搜索与多步信息获取能力,能够根据中间结果动态调整查询策略,其核心目标在于持续地找对关键信息。这一阶段关注的是如何高效获取外界信息。

阶段 2:「Integrated Research」。模型不再只是信息的收集者,而是能够对多源证据进行理解、筛选和整合,最终生成逻辑连贯的报告。

阶段 3:「Full-stack AI Scientist」。模型进一步扩展到完整的科研闭环,具备提出研究假设、设计并执行实验,以及基于结果进行反思与修正的能力。这一阶段强调的不仅是推理深度,更是自主性与长期目标驱动的科研能力。

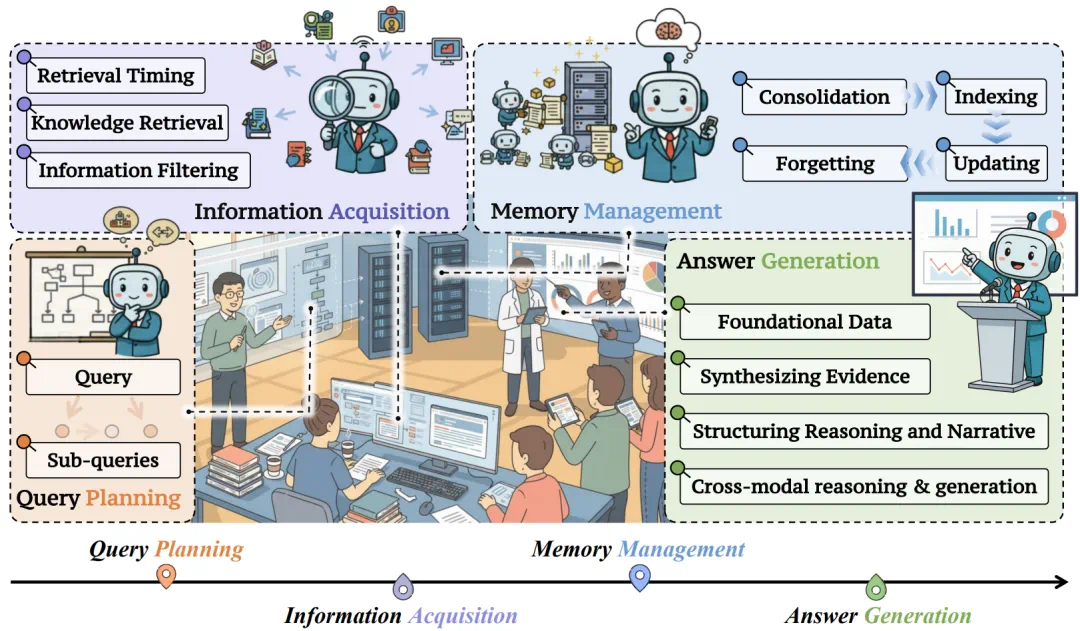

Deep Research 的四大核心组件

1. 查询规划

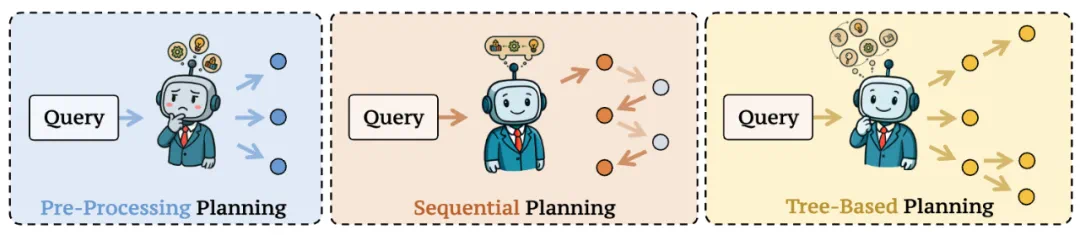

查询规划主要负责在当前状态下,决定下一步应该查询什么信息。具体分为三类规划策略:

顺序规划,将复杂问题拆解为线性的子问题序列,模型根据前一步的检索结果逐步推进,适用于依赖关系明确的研究任务。

并行规划,同时生成多个相对独立的子查询,用于加速搜索或降低单一搜索路径带来的信息缺失。

树状规划,显式建模子问题之间的层级与分支关系,允许模型在研究过程中进行探索与回溯。

相比传统 RAG 中一次性生成查询的做法,DR 将 “如何提问” 本身纳入推理过程,使模型能够在多轮研究中动态调整推理路径。

2. 信息获取

论文从三个维度对现有的信息获取方法进行归纳。

(1)何时检索:不同于固定步数或每轮必检索的策略,DR 智能体需要根据当前不确定性与信息缺口,动态判断是否触发检索,以避免冗余查询或过早依赖外部信息。

(2)检索什么: 在确定检索时机后,从 Web 或外界知识库中做检索,包括多模态和纯文本信息。

(3)如何过滤检索信息:面对噪声较高的检索结果,系统通常引入相关性判断、一致性校验或证据聚合机制,对外部信息进行筛选与整合。

3. 记忆管理

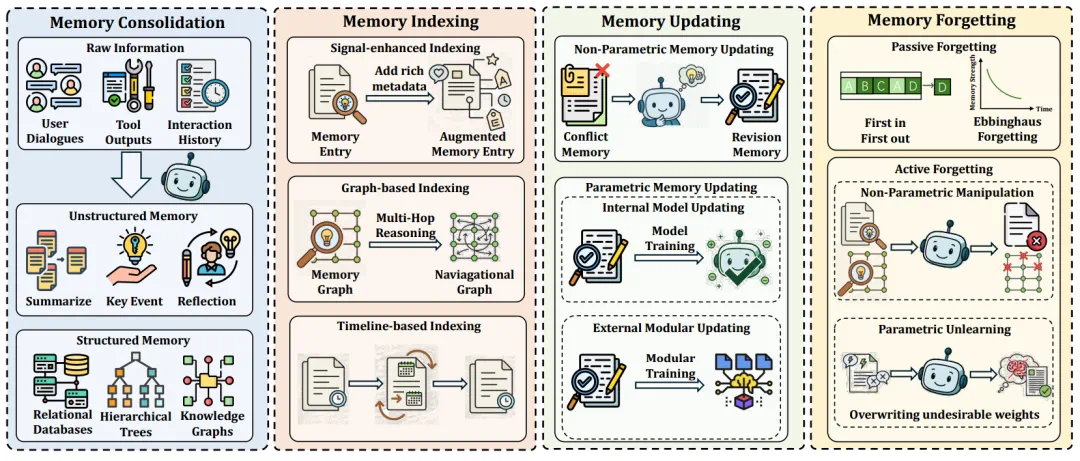

在开放任务中,智能体往往需要跨越多轮交互、多个子问题与不同信息源。记忆模块是支撑 DR 系统长期运行与持续推理的核心基础设施,为系统提供状态延续和经验累积,使模型能够使用长期长线推理任务。现有工作通常将记忆管理过程拆解为四个相互关联的阶段:记忆巩固、记忆索引、记忆更新与记忆遗忘。

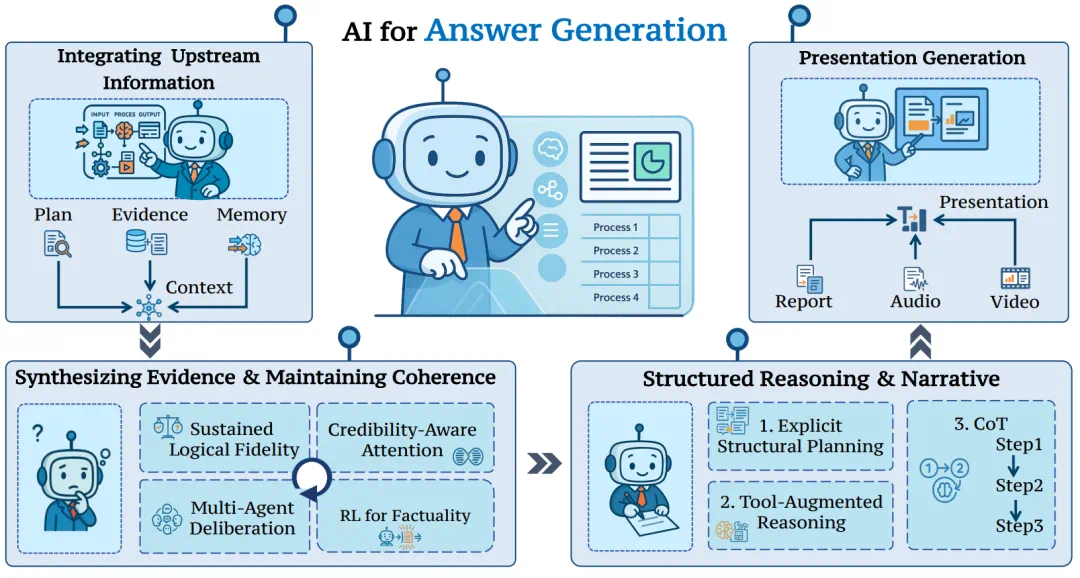

4. 答案生成

与传统生成任务不同,DR 场景的问答更强调结论与证据之间的对应关系,以及整体论证过程的逻辑一致性。因此,通常需要智能体显式整合多源证据与中间推理结果,使输出不仅在语言层面连贯,还能够支持事实核验与过程回溯。

如何训练与优化 Deep Research 系统?

文中总结了三类具有代表性的方法:

提示工程:通过精心设计的多步提示构建研究流程,引导模型执行规划、检索与生成等步骤,适合快速构建原型。其效果高度依赖提示设计,泛化能力有限。

监督微调:利用高质量推理轨迹,对智能体进行监督微调。该方法直观有效,但获取覆盖复杂研究行为的标注数据成本较高。

智能体强化学习: 通过强化学习信号直接优化 DR 智能体在多步决策过程中的行为策略,无需复杂人工标注。主要细分为两种做法:

端到端优化:输入到输出的完整决策过程,联合优化查询规划、检索、信息整合与报告生成等多个环节。这种方式有助于智能体学会协调各个模块,但是面临奖励稀疏、训练不稳定以及采样成本高等问题。

优化特定模块:仅对查询规划或调度等关键模块施加强化学习信号。在保持系统其他模块稳定性的同时,学习何时检索、如何推理等单一策略。这种模块化训练显著降低了训练难度,更易于在现有系统中落地。

Deep Research 真正难在哪里?

Deep Research 的核心挑战并不在于单一能力的提升,而在于如何在长期、开放且不确定的研究流程中,实现稳定、可控且可评估的系统级行为。现有工作主要面临以下几方面的关键难题。

(1)内部知识与外部知识的协同: 研究型智能体需要在自身参数化知识与外部检索信息之间做出动态权衡,即在何时依赖内部推理、何时调用搜索工具。

(2)训练算法的稳定性:面向长线任务的训练往往依赖强化学习等方法,但优化过程中容易出现策略退化或熵坍缩等问题,使智能体过早收敛到次优行为模式,限制其探索多样化的推理路径。

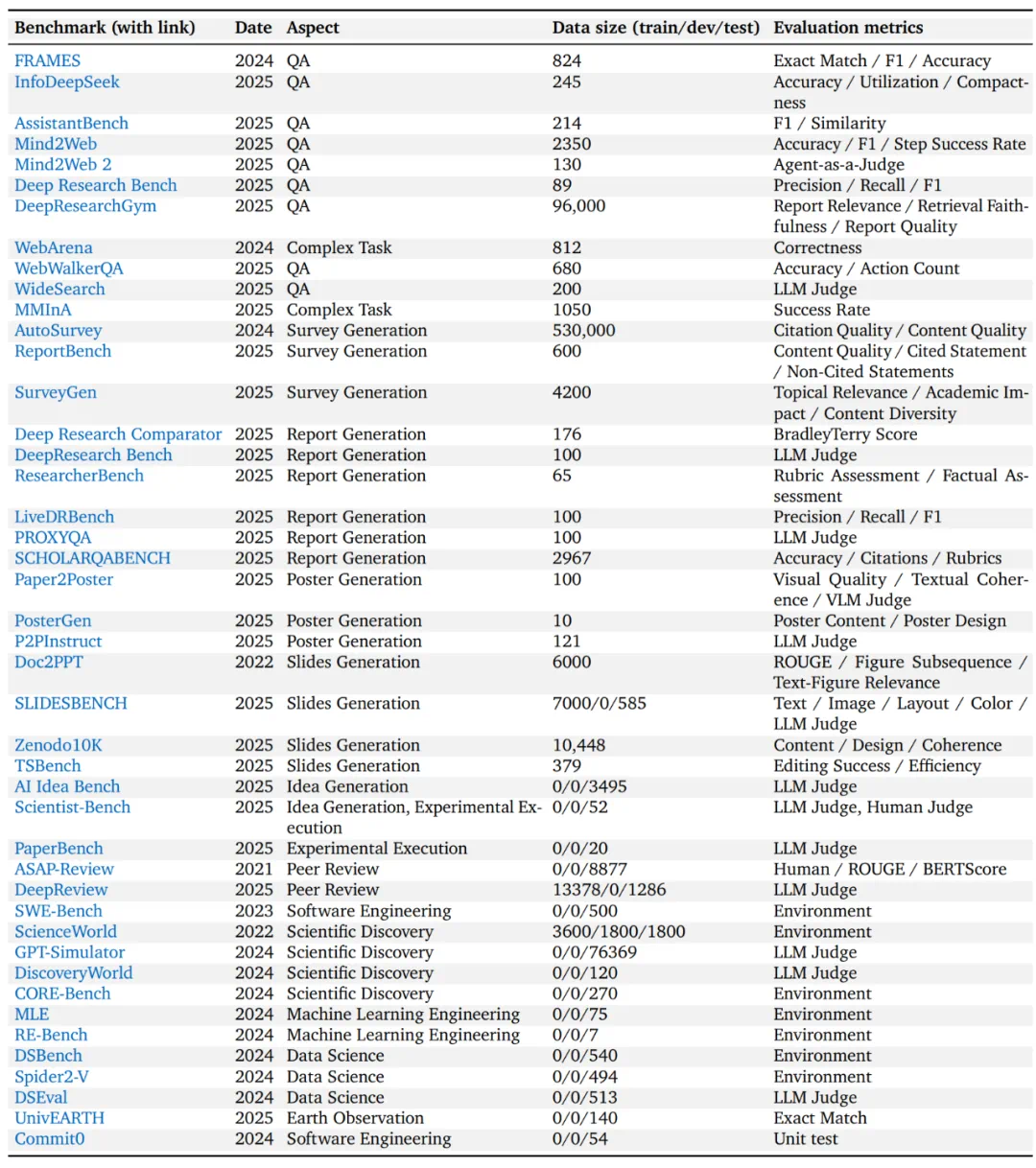

(3)评估方法的构建: 如何合理评估研究型智能体仍是开放问题。综述系统梳理了现有 benchmark。

尽管相关数据集不断涌现,构建可靠且高效的评估方法仍有待深入探索,尤其是在开放式任务中如何对 report-level 的模型输出进行全面评估。当前广泛采用的 LLM-as-a-judge 范式在实践中展现出便利性,但仍不可避免地受到顺序偏差,偏好 hacking 等问题的影响,限制了其作为测评方法的可靠性。

(4)记忆模块的构建:记忆模块的构建是 DR 系统中最具挑战性的部分之一。如何在记忆容量、检索效率与信息可靠性之间取得平衡,并将记忆机制稳定地融入端到端训练流程,仍是当前研究中的关键难题。

结语 Deep Research

Deep Research 并非对现有 RAG 的简单扩展,而是智能体在能力、动作空间以及应用边界上的一次转变:从单轮的答案生成,走向面向开放问题的深度研究。目前,该方向仍处于早期阶段,如何在开放环境中构建既具自主性、又具可信性的 Deep Research 智能体,仍是未来值得持续探索的重要问题。本文的 survey 也会持续更新,总结最新的进展。