VLM和扩散模型被整合到一起了。

ModelScope(魔搭)团队发布Nexus-Gen V2,一个同时支持图像理解、生成和编辑的统一模型,而且模型权重、训练流程和数据集全部开源。

这事儿有多重要?今年以来,GPT-4o-Image、Gemini、Blip3O这些大厂的统一模型都在证明一件事:把图像理解和生成能力塞进一个模型,不仅仅是为了省事,更是因为两种任务的有机结合能带来意想不到的效果。

魔搭团队其实早在五月就发布了V1版本,但他们很快发现了问题:图像理解能力相比原始VLM掉点严重,图像生成对提示词太敏感,编辑细节也保持不好。

于是他们憋了几个月大招,从三个方向全面优化,终于拿出了这个V2版本。

在图像理解上,优化了模型的训练策略,极大程度地保留了VLM的理解能力;

在图像生成上,对所有图像生成样本进行了重标注,采用长短描述同时标注并采样选取的策略,提升了图像生成的鲁棒性,同时加入了中文标注样本,支持了基于中文的图像生成。

在图像编辑上,团队系统性地研究了图像重建效果与图像编码token数量之间的关系,并设计了全新的编辑方案。经过以上优化,Nexus-Gen V2达到了第一梯队统一模型的水平,模型的模型权重和全链路训练流程全部开源。

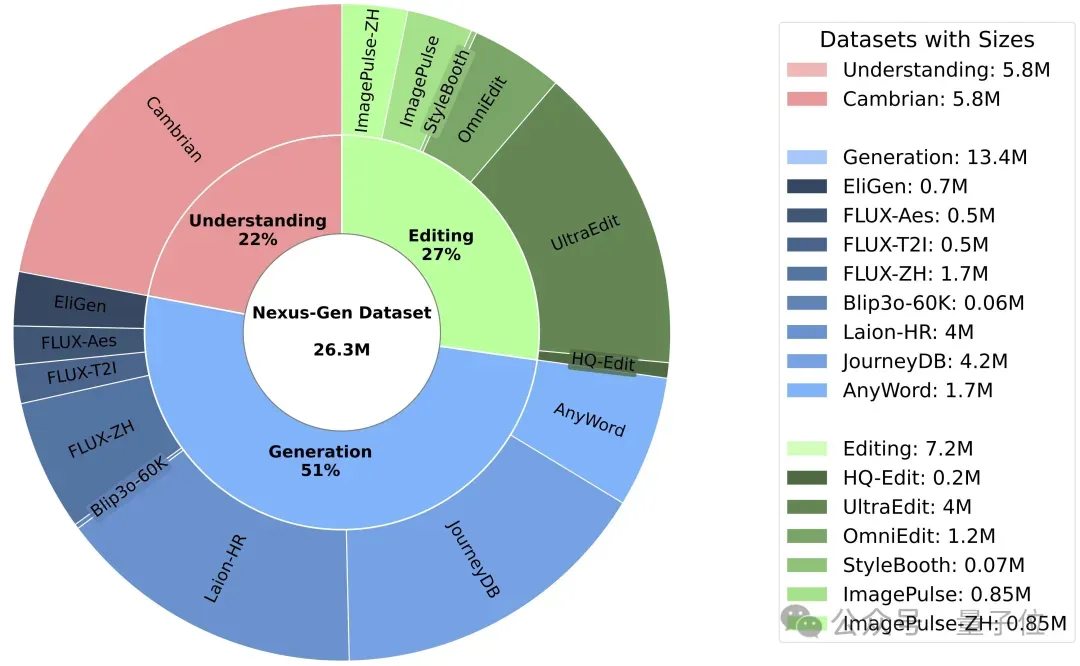

此外,Nexus-Gen V2使用2600万样本进行训练,包括580万图像理解、1330万图像生成和630万图像编辑样本,这个大规模数据集已经在ModelScope主站上开源。

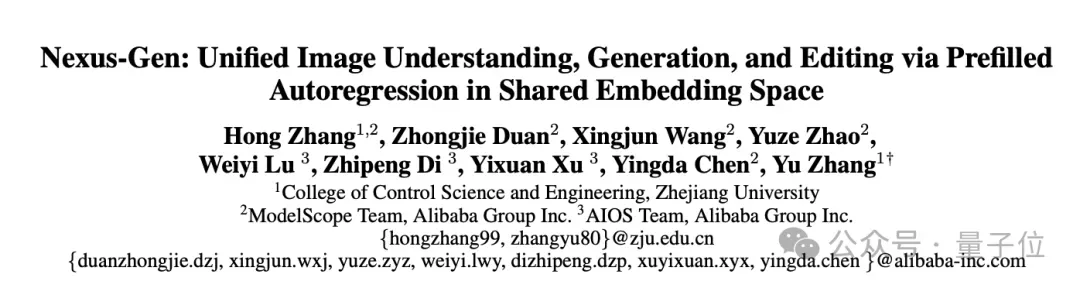

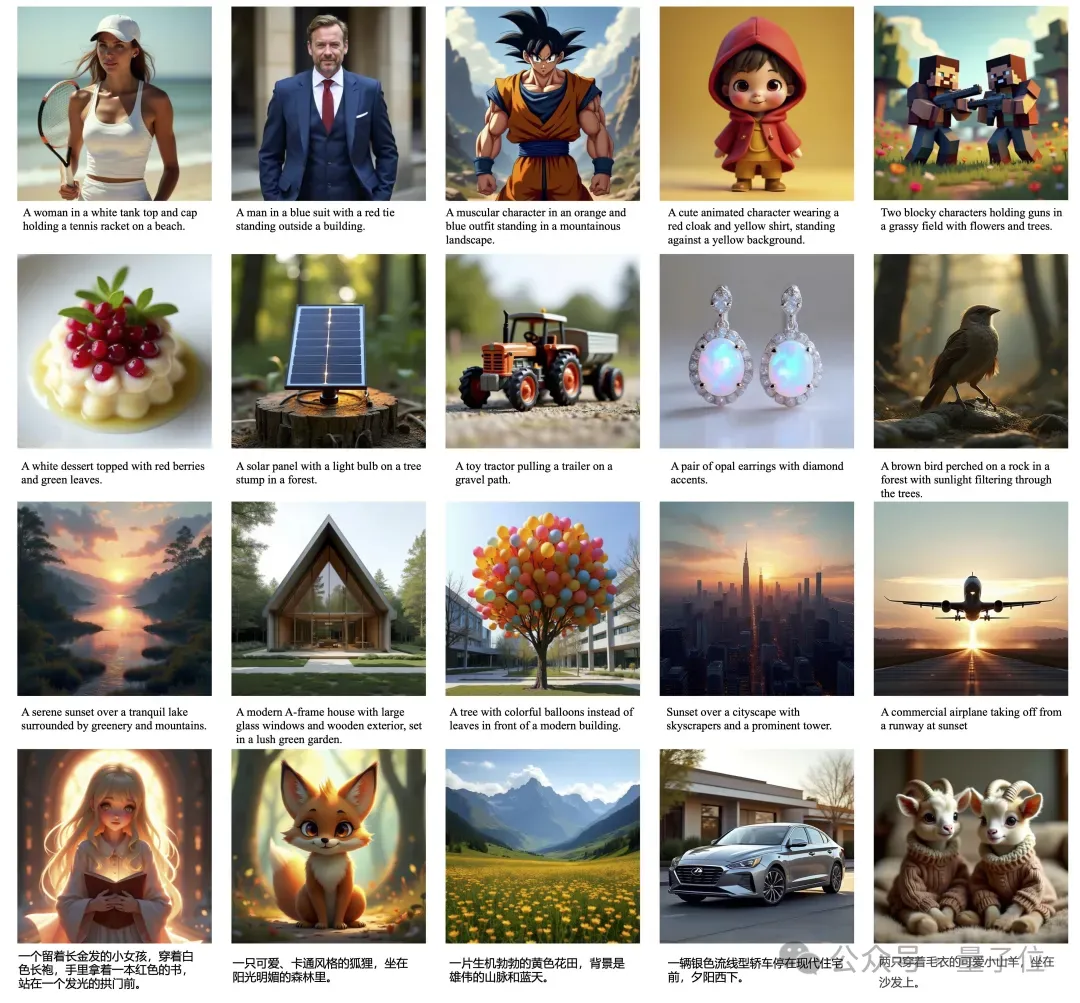

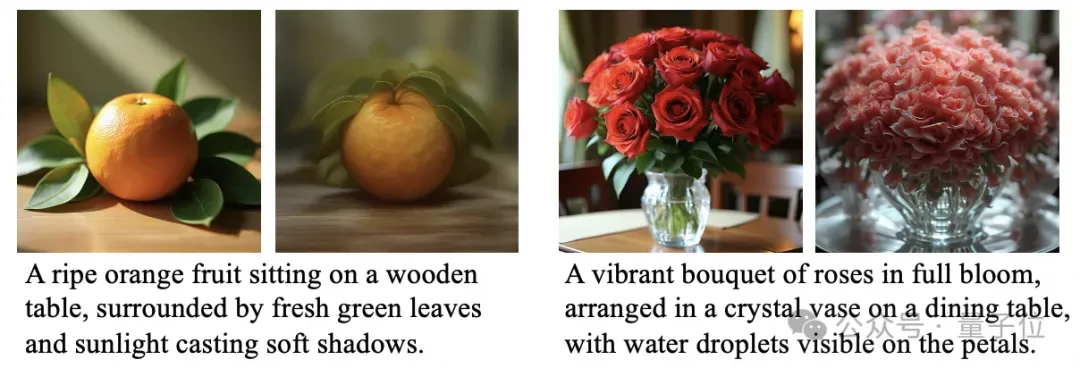

Nexus-GenV2模型的图像编辑和生成可视化效果下:

△图1 Nexus-Gen 图像生成效果

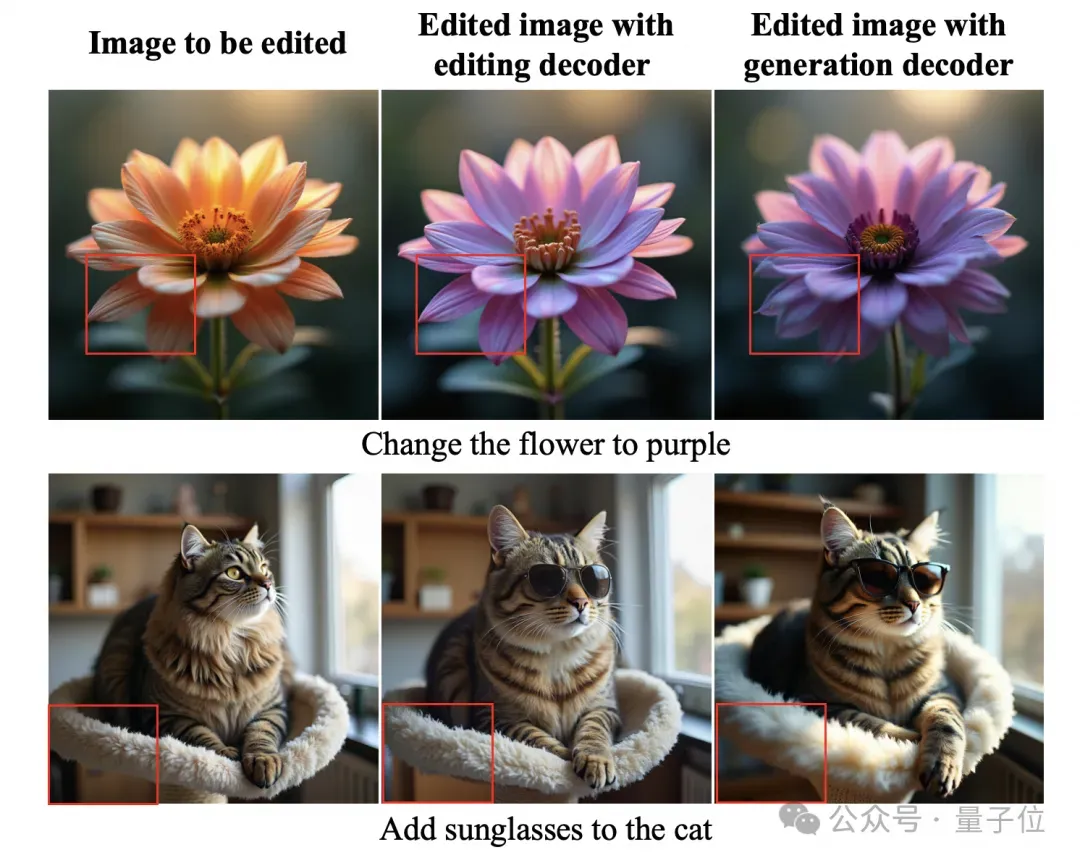

△图2 Nexus-Gen 图像编辑效果

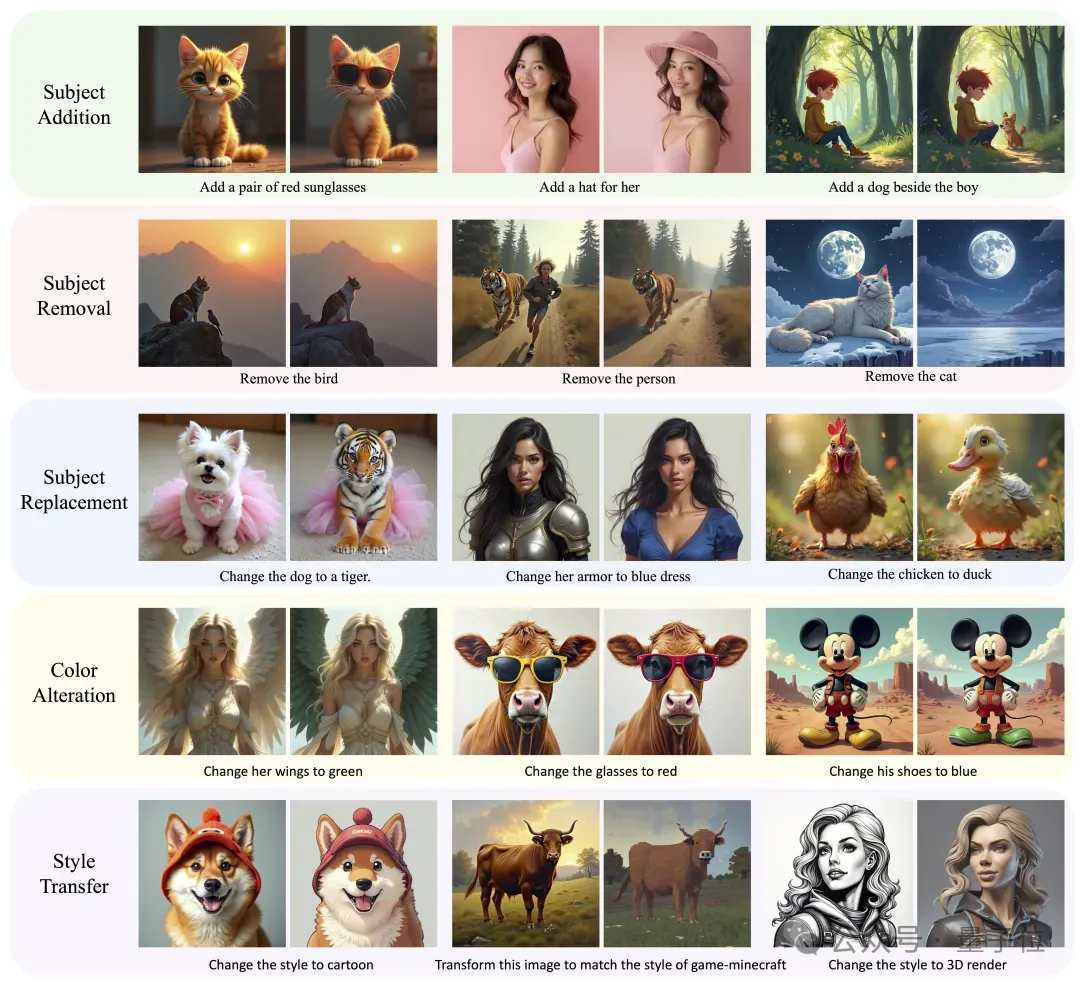

模型架构设计

Nexus-Gen V2沿用了V1的模型架构设计,如图3 a所示,其核心是将扩散模型作为自回归语言模型(Autoregressive Model)的视觉解码器(Vision Decoder),并使用一个统一的图像编码空间(Image Embedding Space)来连接两者,并统一建模图像理解、生成和编辑任务。

输入图像由视觉编码器(Vision Encoder)编码到统一编码空间中,由自回归模型处理。自回归模型使用预填充自回归策略预测输出图像在编码空间的特征向量,然后由视觉解码器解码为输出图像。

△图3 Nexus-Gen的模型架构和训练策略

Autoregressive Model 自回归模型

如图3 b所示,Nexus-Gen采用Qwen2.5-VL-7B-Instruct的语言模型部分作为自回归,并采用其ViT作为视觉编码器,将视觉编码器的输出空间作为统一图像编码空间。

在训练时,模型输出的图像特征的token数量固定为N_e(N_e的取值涉及到模型间和效果上的权衡,将在后续进行讲解),图像特征采用MSE和余弦相似度作为损失函数;对于模型输出的文本token,Nexus-Gen采用标准的交叉熵来作为损失函数。

Nexus-Gen的自回归模型在图像理解、生成和编辑三个任务上进行了预训练和视觉质量微调。预训练用上了全部26M数据;视觉质量微调只采用了4.3M数据,其中图像生成部分仅采用高质量样本。

Generation Decoder 图像生成解码器

如图3 c所示,Nexus-Gen采用Flux.1-Dev作为视觉解码器。图像生成任务的解码器 (Generation Decoder)采用图像重建的方式训练:输入图像被视觉编码器编码为N_e个特征向量,这些特征被作为图像生成解码器的输入条件,用于重建输入图像。训练采用的损失函数为标准Flow Matching的MSE损失函数。这一训练过程仅使用2M高质量的图像生成数据。

图像Embedding数量的权衡

Nexus-Gen采用的视觉编码器拥有动态分辩率的编码能力,图像分辨率越大,编码得到的token 数量越多,编码包含的细节信息越多,信息损失也越少;反之,分辨率越小,编码更偏向高层语义信息,信息损失越多。使用不同数量的图像特征来训练图像生成解码器时,图像重建对比效果如图4所示。

考虑128x128, 256x256, 512x512三种分辨率和他们对应的25,81和324三种token数量,实验现象为,token数量越少,重建效果越差,25个token重建的图像已经出现了语义缺失和图像畸变的情况。81和324token都能较好地重建出图像,324token细节重建更好。

△图4 不同token数量的重建效果

进一步地,考虑使用81和324两个token数量训练了自回归模型,再接上对应的解码器,对比生成效果,如图5所示。可以发现,324 token训练的模型出现了严重的语义重复现象,生成的图像质量也远不如81 token。

主要原因是324个token严重增加了图像特征预测任务的复杂度,7B的自回归模型没法胜任这个任务。经过权衡,Nexus-Gen最终采用81作为自回归模型的输出和图像生成解码器的输入token数量。

△图5 81和324 图像token数量下的Nexus-Gen生成效果对比

Editing Decoder 图像编辑解码器

理论上,只要重建效果足够好,图像生成解码器就能直接完成图像编辑任务,因为自回归模型预测的就是编辑后图像特征。然而,自回归和图像生成解码器采用的token数量是81,在这个数量下,图像重建能保证整体布局和语义正确,但细节重建效果不足,这就导致Nexus-Gen V1版本的图像编辑功能的细节保持效果不足。

因此,Nexus-Gen V2版本重新设计了图像编辑解码器(editing decoder),架构如图3 d所示。编辑解码器的输入条件有两个,第一个是自回归模型输出的81个目标图像token,第二个则是图像编码器直接编码的324个原图Token,用作细节信息的补充条件。团队对两种条件采用不同的位置编码,并在ImagePulse这个高质量图像编辑数据集上训练编辑解码器,训练的损失函数仍然是标准Flow Matching的MSE损失函数。 图像生成和编辑解码器在图像编辑任务上的效果对比如图6所示。可以看到编辑解码器的细节保持能力显著提高。

△图6 generation 和editing decoder的编辑效果对比

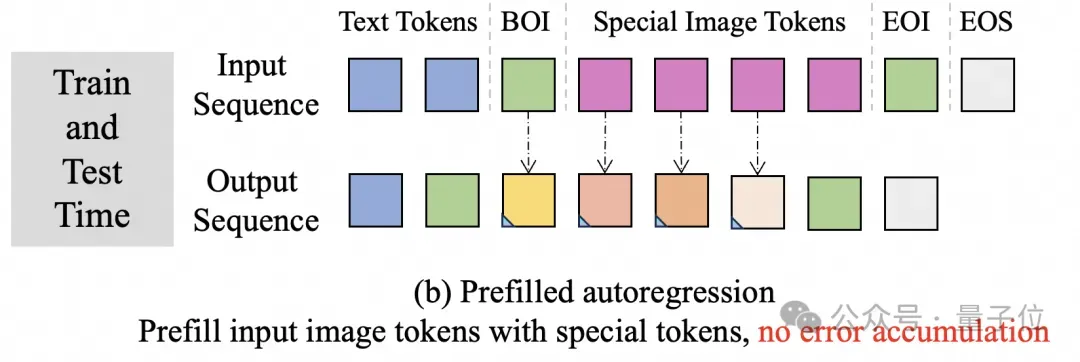

Prefilled Autoregression 策略

自回归模型在训练时采用teacher-forcing的策略,在推理时则采用token-by-token的预测方法。将这种自回归范式直接运用在连续特征空间的图像特征预测上,会带来比较严重的误差累积问题。误差累积的本质是训练和推理行为不一致。为了解决这个问题,提出了预填充自回归的策略,这一策略与可学习Qeury的思路类似,如图7所示。

在训练时,使用一组可学习特殊token填充对应位置的图像特征向量,这样就可以让模型学习直接预测任意位置的图像特征的能力。在推理阶段,只要预测到图像的起始token BOI,就直接预填充N_e个特殊token到输入序列中。通过这种方式,能够保证训练和推理阶段行为的一致性,从而消除误差累积。

△图7 预填充自回归的策略

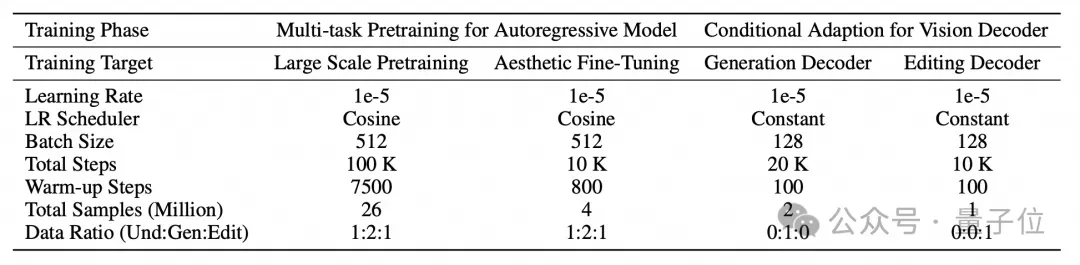

训练策略

Nexus-Gen V2的训练分成自回归模型的训练和视觉解码器的训练。V1版本发现模型在理解能力上退化严重,经过消融实验,主要是由于学习率过大导致知识遗忘导致的,Nexus-GenV2版本采用的自回归模型的学习率为1e-5。所有训练阶段的详细训练参数如表1所示。

△表1 Nexus-Gen训练超参数

训练数据集构建

为了对Nexus-Gen的自回归模型进行多任务协同优化,团队构建了一个涵盖图像理解、生成和编辑任务的大规模数据集,数据集已经在ModelScope开源。除了按照Nexus-Gen V2的训练过程划分的图像标注外,还针对盖图像理解、生成和编辑任务三个任务划分了数据集,方便后续在各个任务上的使用,详细请参考ModelScope数据集页面,链接在文末获取。

△图8 Nexus-Gen训练数据分布

Nexus-Gen的数据分布如图8所示。

图像理解的数据源主要是Cambrian-7M,为了提升数据质量,使用Qwen2.5-VL-72B对视觉问答问题的所有答案进行了重标注。

图像生成数据既包含真实图像数据源(Laion-HR,AnyWord),也包含合成图像数据源(EliGen、FLUX-ARS、FLUX-T2I、JourneyDB)。为了提升模型对图像生成prompt的鲁棒性,使用Qwen2.5-VL-72B对所有图像进行重标注;在标注时,模型同时生成简短和详细两种图像描述,训练时以20%的概率采用简短图像描述,80%的概率采用详细图像描述。

图像编辑的数据源来自于HQ-Edit,UltraEdit,OmniEdit,StyleBooth等。然而,现有开源图像编辑的图像质量较差,直接用于Diffusion模型的训练会破坏图像分布,严重降低图像质量。为此,团队创建了ImagePulse这一高质量图像编辑数据集,包含物体的添加、修改和删除,风格迁移和任务一致性保持几个子集。

为了支持使用中文进行图像生成和编辑,Nexus-Gen V2使用中文标注了部分数据,对应分布图中的FLUX-ZH和ImagePulse-ZH子集。经过实验验证,仅仅2.5M中文标注数据就完全模型的中文生成和编辑能力。

模型评测效果

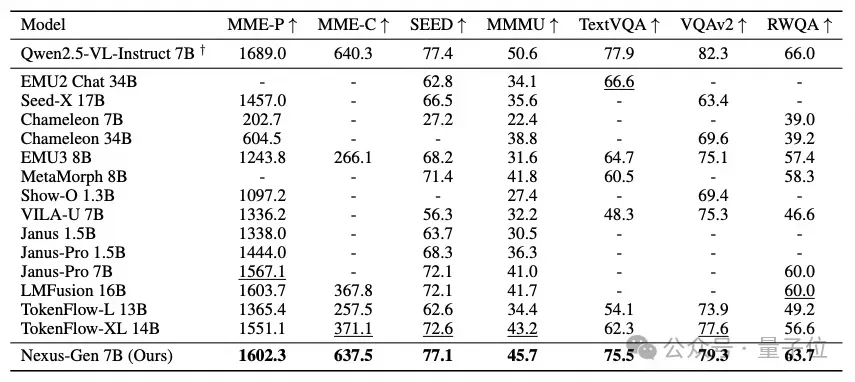

图像理解

团队在多个Benchmark上对Nexus-Gen进行了评测,如表2所示,在这些benchmark上,Nexus-Gen V2比之前经过联合优化的统一模型表现更好。此外,与VLM Baseline模型(Qwen2.5-VL-Instruct-7B)的对比结果表明,Nexus-Gen以较小的理解能力损失,为自回归模型增加了图像生成和编辑能力,这是符合预期的。

△表2 Nexus-Gen 图像理解能力评测

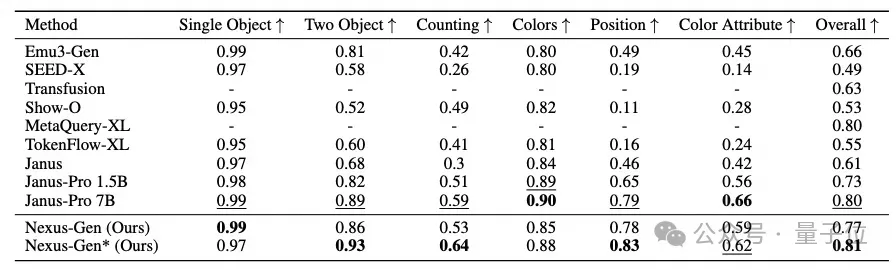

图像生成

在图像生成benchmark GenEval的评测结果如表3所示。实验结果表明,经过多任务联合优化的Nexus-Gen模型可以取得0.77的总分。如果进一步在blip3o-60k数据集上做对图像生成做一次指令微调,可以将总分提升到0.81。

△表3 Nexus-Gen 图像生成能力评测

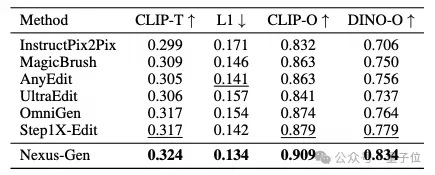

图像编辑

在图像编辑benchmark ImagePulse TestSet的评测结果如表4所示。CLIP-T表明模型与目标图像的语义信息对齐良好。而L1、CLIP-O和DINO-O分数则表明模型与目标图像的细节特征对其良好,也证明了此前设计的图像编辑解码器起到了作用。

△表4 Nexus-Gen 图像编辑能力评测

展望

Nexus-Gen采用了VLM+Diffusion的统一模型路线,同期的MetaQuery、Blip-3o、Uniworld和OmniGen2等都是采用这一路线,每个工作都很出色,都有各自的独特之处。Nexus-Gen的独特之处在于并没有将自回归模型冻住,而是在图像理解、生成和编辑任务上完成了语言模型的统一训练,团队始终认为多任务统一训练和协同优化是统一模型不能逃避的问题,它是统一模型走向更远应用的关键一步。统一模型的潜力在于理解生成模型相互促进的愿景、在于将多模态推理向前推再推进一步的可能,更在于它也许就是下一个世界模型的雏型,这些都是需要统一训练来激发的。

当然,Nexus-Gen模型仍然不是一个成熟完美的模型,模型仍然具有一定的局限性。比如图像生成的融洽性比不上纯Diffusion模型,图像编辑效果对不同图像不太稳定,图像生成和编辑的引入也一定程度降低了模型的指令遵行能力。此外,由于类CLIP图像特征不可避免的信息损失,当前架构并不能保证完美的图像重建。但团队也把模型、数据、训练过程和经验全部分享和开源,希望促进统一模型的快速发展,欢迎社区对Nexus-Gen和统一理解与生成模型的技术未来进行广泛交流。

论文链接:https://arxiv.org/pdf/2504.21356代码链接:https://github.com/modelscope/Nexus-GenNexus-Gen V2模型链接:https://www.modelscope.cn/models/DiffSynth-Studio/Nexus-GenV22600万统一模型数据集链接:https://www.modelscope.cn/datasets/DiffSynth-Studio/Nexus-Gen-Training-Dataset在线体验Demo:https://www.modelscope.cn/studios/DiffSynth-Studio/Nexus-Gen