腾讯宣布开源其新研发的图像转视频生成框架 ——HunyuanVideo-I2V。该模型的发布是在其成功开源 HunyuanVideo 之后的又一重要进展,旨在推动开放源代码社区的深入探索。

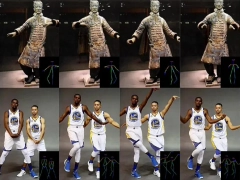

HunyuanVideo-I2V 结合了先进的视频生成技术,能够将静态图像转换为生动的视频内容,为创作者提供了更多的可能性。用户只需上传一张图片,并简单描述希望画面的动态效果,便可以生成一段五秒的短视频。这款模型的特点在于它不仅能让静态图片 “动起来”,还能够自动配上背景音效,极大地增强了视频的趣味性和吸引力。

HunyuanVideo-I2V 利用了一个预训练的多模态大语言模型作为文本编码器,显著增强了模型对输入图像语义内容的理解能力。这意味着,用户输入的图像能够通过模型生成语义图像标记,这些标记与视频潜在标记相结合,从而实现更全面的全注意力计算。通过这种方式,系统能够最大限度地发挥图像和文本模态之间的协同作用,确保从静态图像生成的视频内容更具连贯性和真实感。

为了让更多用户体验这一功能,混元 AI 视频官网已经上线,用户可以直接访问网站进行操作。此外,企业和开发者也可以通过腾讯云申请 API 接口,将该技术融入自己的应用中。这款图生视频模型是混元文生视频模型开源工作的延续,模型总参数量达 130 亿,适合生成多种类型的角色和场景,涵盖写实视频、动漫角色和 CGI 角色等。

在具体使用过程中,用户还可以上传人物图片,并输入希望其 “对口型” 的文字或音频,系统就能够让图片中的人物 “说话” 或 “唱歌”。与此同时,混元还推出了 “动作驱动” 功能,用户可以一键生成相应的舞蹈视频,提升创作的多样性和趣味性。

值得一提的是,此次开源的图生视频模型已经在 Github 和 HuggingFace 等主流开发者社区发布,开发者可以下载相关内容进行试验与开发。开源内容包括模型的权重、推理代码以及 LoRA 训练代码,这些都为开发者提供了更多的可能性,以便在此基础上训练专属的 LoRA 模型。

自开源以来,混元视频生成模型的热度不断上升,去年 12 月更是登顶 HuggingFace 的全站趋势榜第一,Github 上的 Star 数已超过 8.9K。许多开发者也积极为 Hunyuanvideo 制作插件与衍生模型,目前已经积累超过 900 个衍生版本。早前开源的混元 DiT 文生图模型同样表现不俗,衍生模型数量达 1600 多个。

官网:https://video.hunyuan.tencent.com/

github:https://github.com/Tencent/HunyuanVideo-I2V

huggingface:https://huggingface.co/tencent/HunyuanVideo-I2V