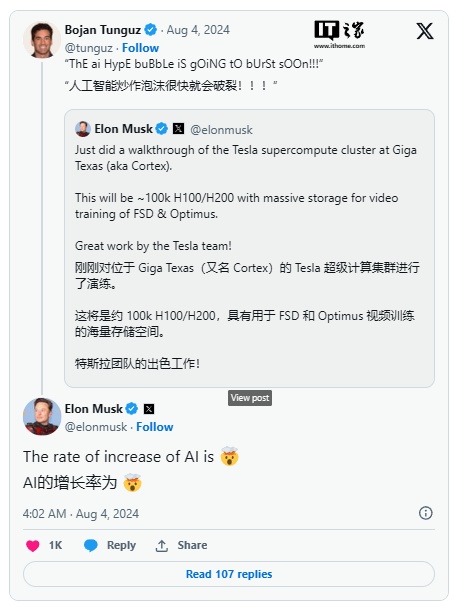

埃隆・马斯克 (Elon Musk) 周末在参观了最近建成的得克萨斯州超级计算集群后,透露了该工厂的名称。

周六,马斯克在 X 上写道,得州超级工厂的超级计算集群被命名为“Cortex”,并指出他刚刚完成了新设施的演练。“Cortex”拥有约 10 万颗英伟达 H100 和 H200 芯片,用于训练全自动驾驶(FSD)和人形机器人擎天柱(Optimus)的神经网络。

AI在线注意到,马斯克此前还详细介绍了 Cortex 超级计算集群的巨大冷却需求,并解释说该集群今年将需要约 130 MW 的电力,未来 18 个月内更是有望突破 500 兆瓦。为此,特斯拉在计算机中心内安装了巨大的风扇和四个水箱进行冷却。

马斯克在 6 月份估计,特斯拉今年在英伟达芯片上的支出可能达到 30 亿至 40 亿美元,占公司总人工智能相关支出 100 亿美元的一半,剩余的资金将用于内部研发的 AI 推理计算机、车辆传感器和 Dojo 超级计算机。