VectorSpaceLab

从文本生成到指令编辑 OmniGen2重塑开源多模态模型应用场景

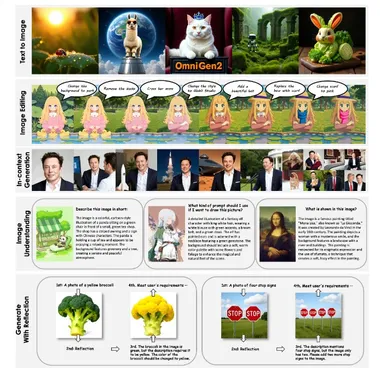

近日,VectorSpaceLab在Hugging Face平台正式开源全能多模态模型OmniGen2,以创新性双组件架构和强大的视觉处理能力,为研究者和开发者提供了高效的可控生成式AI基础工具。 这款模型由30亿参数的视觉语言模型(VLM)Qwen-VL-2.5与40亿参数的扩散模型组合而成,通过冻结的VLM解析视觉信号和用户指令,结合扩散模型实现高质量图像生成,在视觉理解、文本生成图像、指令引导图像编辑和上下文生成四大核心场景中展现出领先性能。 作为开源项目,OmniGen2的视觉理解能力继承自Qwen-VL-2.5的强大基础,可精准解析图像内容;其文本生成图像功能支持从文本提示生成高保真、符合美学标准的图像;在指令引导图像编辑领域,该模型以高精度完成复杂修改任务,性能达到开源模型中的前沿水平;而上下文生成能力更可灵活处理人物、物体、场景等多元输入,生成连贯新颖的视觉输出。

6/24/2025 11:00:41 AM

AI在线

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

腾讯

Agent

Claude

芯片

Stable Diffusion

具身智能

蛋白质

xAI

开发者

生成式

人形机器人

神经网络

机器学习

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

字节跳动

工具

华为

AGI

计算

大型语言模型

AI设计

搜索

生成式AI

视频生成

亚马逊

DeepMind

AI模型

特斯拉

场景

深度学习

Transformer

架构

MCP

Copilot

编程

视觉