吞吐量

Llama2推理RTX3090胜过4090,延迟吞吐量占优,但被A800远远甩开

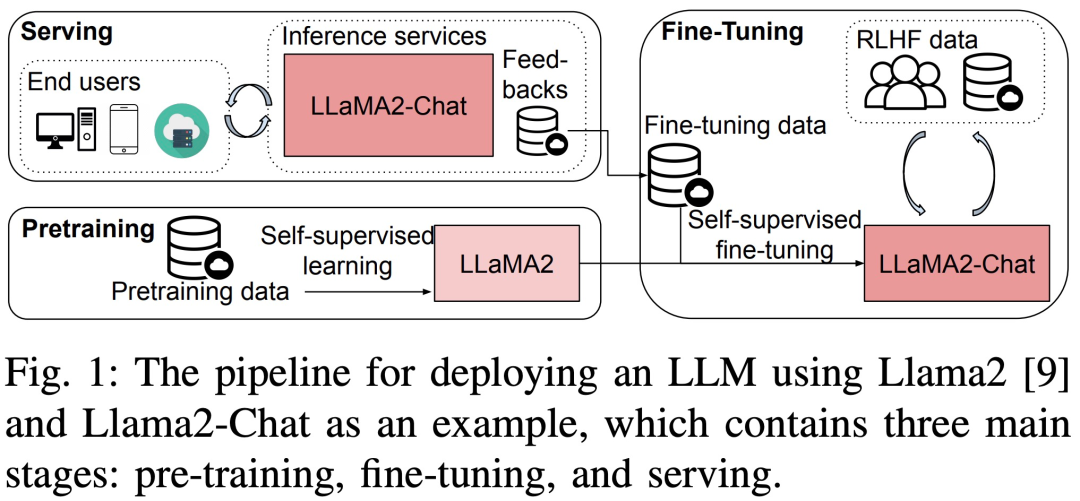

这是为数不多深入比较使用消费级 GPU(RTX 3090、4090)和服务器显卡(A800)进行大模型预训练、微调和推理的论文。大型语言模型 (LLM) 在学界和业界都取得了巨大的进展。但训练和部署 LLM 非常昂贵,需要大量的计算资源和内存,因此研究人员开发了许多用于加速 LLM 预训练、微调和推理的开源框架和方法。然而,不同硬件和软件堆栈的运行时性能可能存在很大差异,这使得选择最佳配置变得困难。最近,一篇题为《Dissecting the Runtime Performance of the Training,

12/27/2023 3:04:00 PM

机器之心

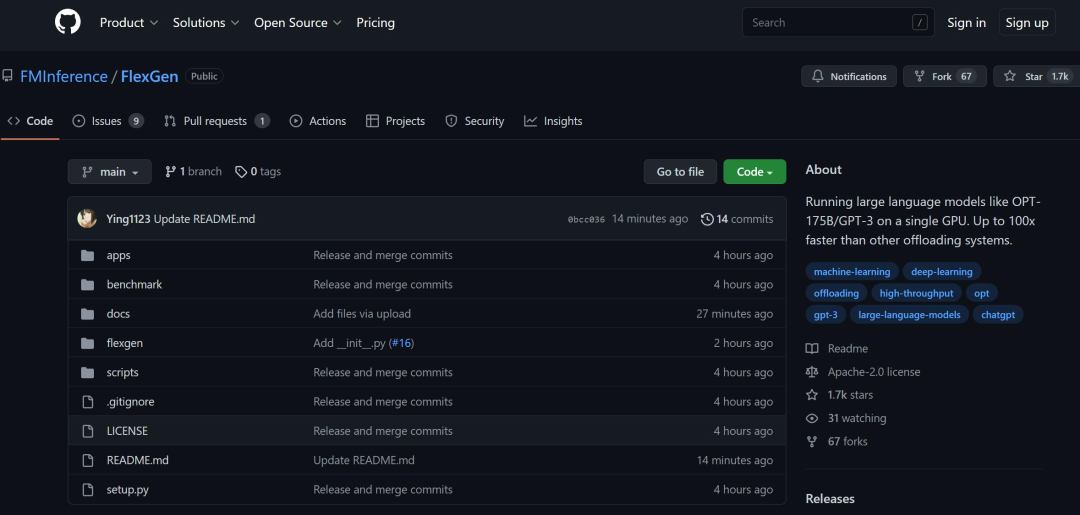

跑ChatGPT体量模型,从此只需一块GPU:加速百倍的方法来了

1750 亿参数,只需要一块 RTX 3090,ChatGPT 终于不再是大厂专属的游戏?

2/27/2023 5:21:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉