MLOps

融合AMD与NVIDIA GPU集群的MLOps:异构计算环境中的分布式训练架构实践

在深度学习的背景下,NVIDIA的CUDA与AMD的ROCm框架缺乏有效的互操作性,导致基础设施资源利用率显著降低。 随着模型规模不断扩大而预算约束日益严格,2-3年更换一次GPU的传统方式已不具可持续性。 但是Pytorch的最近几次的更新可以有效利用异构计算集群,实现对所有可用GPU资源的充分调度,不受制于供应商限制。

3/20/2025 11:22:12 AM

Rafał Siwek

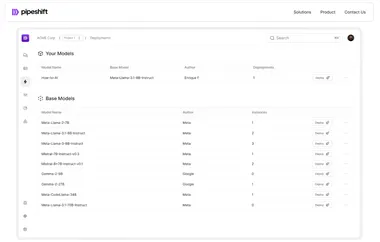

Pipeshift推出模块化推理引擎,实现AI推理GPU使用率降低75%

近日,初创公司 Pipeshift 推出了一款全新的端到端平台,旨在帮助企业更高效地训练、部署和扩展开源生成式 AI 模型。 该平台不仅可以在任何云环境或本地 GPU 上运行,还能够显著提升推理速度和降低成本。 随着 AI 技术的迅猛发展,许多企业面临着如何在多种模型之间高效切换的挑战。

1/24/2025 10:04:00 AM

AI在线

AI 运维的新时代:从 MLOps 到 LLMOps深度解析

作者 | 崔皓审校 | 重楼摘要文章围绕 LLMOps(大语言模型运维)展开,详细解析了企业如何使用大语言模型(LLMs),以及 LLMOps 在优化 LLM 开发、部署和管理中的核心作用。 文章首先介绍了提示词工程(Prompt Engineering)、检索增强生成(RAG)和微调(Fine-tuning)等常见 LLM 应用场景,并深入探讨了这些方法的挑战和局限性。 随后,通过对比 MLOps 和 LLMOps,突出了后者在管理复杂模型生命周期中的独特价值。

1/16/2025 11:45:26 AM

崔皓

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

开发者

具身智能

xAI

生成式

神经网络

机器学习

3D

人形机器人

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

视觉

预测