KV

字节Seed 团队推出 PHD-Transformer,成功扩展预训练长度,解决 KV 缓存问题!

近日,字节跳动的 Seed 团队在人工智能领域再传佳音,推出了一种新型的 PHD-Transformer(Parallel Hidden Decoding Transformer),这项创新突破了预训练长度的限制,有效解决了推理过程中的 KV 缓存膨胀问题。 随着大型推理模型的迅速发展,研究人员在后训练阶段尝试通过强化学习方法来生成更长的推理链,并在复杂的推理任务上取得了显著成果。 受到启发,字节 Seed 团队决定探索在预训练阶段进行长度扩展的可能性。

4/28/2025 5:00:40 PM

AI在线

一致哈希算法:如何分群,突破集群的“领导者”限制?

一、一致哈希算法的背景1.1 传统哈希算法的问题在传统的哈希算法中,数据存储通常采用如下映射关系:node=hash(key)%Nnode = hash(key) \% Nkey:数据的键N:当前集群中节点的数量问题:当节点数量发生变化(例如从2个节点扩展到3个节点),几乎所有的键都会被重新分配到不同的节点上,导致大量数据迁移。 示例:2个节点:hash(key) % 2 → 节点0、节点1扩展到3个节点:hash(key) % 3 → 节点0、节点1、节点2可以看到,大部分数据的映射发生了变化。 1.2 一致哈希的引入一致哈希算法 使用了一个逻辑哈希环(Hash Ring)的概念,将整个哈希空间(0到2^32-1)组织成一个环形结构。

12/31/2024 10:55:38 AM

架构师秋天

进我的收藏夹吃灰吧:大模型加速超全指南来了

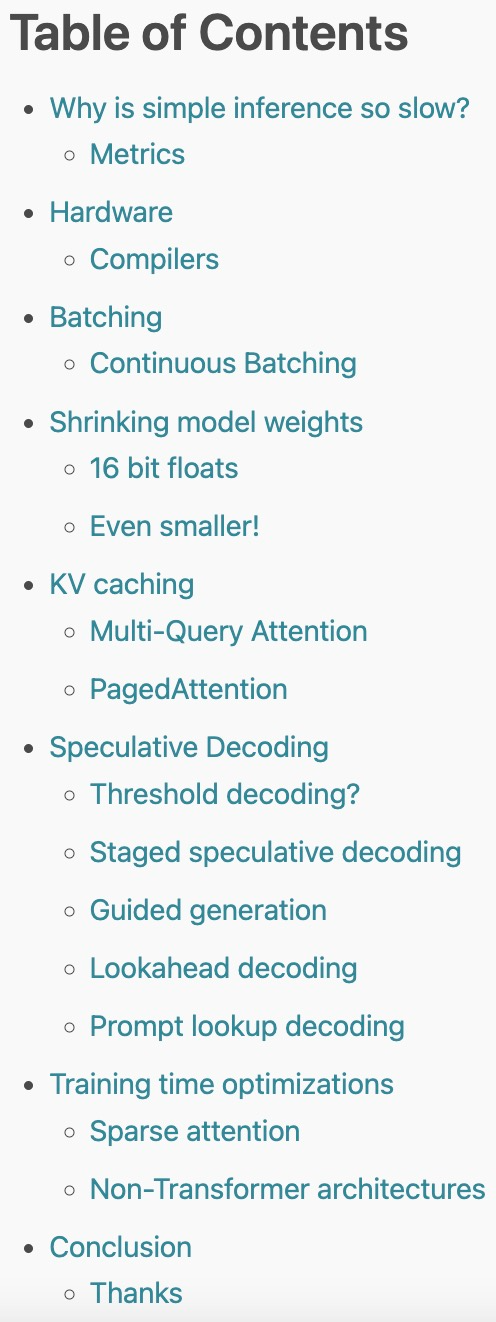

2023 年,大型 语言模型(LLM)以其强大的生成、理解、推理等能力而持续受到高度关注。然而,训练和部署 LLM 非常昂贵,需要大量的计算资源和内存,因此研究人员开发了许多用于加速 LLM 预训练、微调和推理的方法。最近,一位名为 Theia Vogel 的博主整理撰写了一篇长文博客,对加速 LLM 推理的方法进行了全面的总结,对各种方法展开了详细的介绍,值得 LLM 研究人员收藏查阅。以下是博客原文内容。之前,我使用经典的自回归采样器手动制作了一个 transformer,大致如下:这种推理方法很优雅,是 LL

2/15/2024 2:54:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉