COAT

FP8训练新范式:减少40%显存占用,训练速度提高1.4倍

近期DeepSeek V3 引爆国内外的社交媒体,他们在训练中成功应用了 FP8 精度,显著降低了 GPU 内存使用和计算开销。 这表明,FP8 量化技术在优化大型模型训练方面正发挥着越来越重要的作用。 近期,来自伯克利,英伟达,MIT 和清华的研究者们提出了显存高效的 FP8 训练方法:COAT(Compressing Optimizer states and Activation for Memory-Efficient FP8 Training),致力于通过 FP8 量化来压缩优化器状态和激活值,从而提高内存利用率和训练速度。

3/7/2025 10:30:00 AM

机器之心

CoAT: 基于蒙特卡洛树搜索和关联记忆的大模型推理能力优化框架

研究者提出了一种新的关联思维链(Chain-of-Associated-Thoughts, CoAT)方法,该方法通过整合蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)和关联记忆机制来提升大语言模型(LLMs)的推理能力。 区别于传统的单步推理方法,CoAT致力于增强LLM的结构化推理能力和自适应优化能力,实现动态知识整合。

2/13/2025 9:34:13 AM

佚名

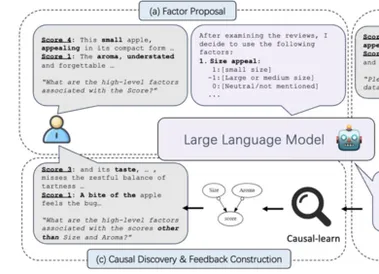

NeurIPS 2024 | 用LLM探寻隐秘的因果世界

因果发现的现实挑战:稀缺的高级变量寻找并分析因果关系是科学研究中的重要一环,而现有的因果发现算法依赖由专家预先定义的高级变量。 现实场景中的原始数据往往是图片、文本等高维非结构化数据, 结构化的高级变量是十分稀缺的,导致现有的因果发现和学习算法难以用于至更广泛的数据。 因此,香港浸会大学与MBZUAI、卡内基梅隆大学、香港中文大学、悉尼大学以及墨尔本大学合作发表论文《Discovery of the Hidden World with Large Language Models》,提出了一个名为 COAT 的新型框架,旨在利用大型语言模型和因果发现方法的优势,突破传统因果发现方法的局限性,更有效地在现实世界中定义高级变量、理解因果关系。

2/8/2025 4:56:00 PM

新闻助手

- 1

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

机器人

大模型

数据

Midjourney

开源

Meta

智能

微软

用户

AI新词

GPT

学习

技术

智能体

马斯克

Gemini

图像

Anthropic

英伟达

AI创作

训练

LLM

论文

代码

算法

Agent

AI for Science

芯片

苹果

腾讯

Stable Diffusion

Claude

蛋白质

开发者

生成式

神经网络

xAI

机器学习

3D

RAG

人形机器人

研究

AI视频

生成

大语言模型

具身智能

Sora

工具

GPU

百度

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

视频生成

场景

深度学习

DeepMind

架构

生成式AI

编程

视觉

Transformer

预测

AI模型

伟达

亚马逊

MCP