标记

AI 架构 Transformer 再进化:谷歌新方法突破长文本处理,注意力模块内存需求可降至 1/47

科技媒体 marktechpost 昨日(10 月 8 日)发布博文,报道称谷歌公司推出了选择性注意力(Selective Attention)方法,可以提高 Transformer 架构模型的性能。Transformer 架构简介Transformer 是一种革命性的神经网络架构,由谷歌在 2017 年提出,主要用于处理序列数据,特别是在自然语言处理(NLP)领域。Transformer 的核心是自注意力机制,允许模型在处理输入序列时捕捉词与词之间的关系,让模型能够关注输入序列中的所有部分,而不仅仅是局部信息。T

10/9/2024 10:44:18 AM

故渊

新SOTA,仅几个标记基因即可自动标记,复旦大学开发空间转录组学语义注释贝叶斯框架

编辑 | 萝卜皮空间转录组学的出现,彻底改变了组织内基因表达的研究。然而,注释空间点的生物特性仍然是一个挑战。为了解决这个问题,复旦大学的研究人员引入了 Pianno,一个基于标记基因自动进行结构语义注释的贝叶斯框架。Pianno 在精确注释各种空间语义(从不同的解剖结构到复杂的肿瘤微环境)以及估计细胞类型分布(跨各种空间转录组学平台生成的数据)方面的卓越能力。研究人员使用 Pianno 结合聚类方法,揭示了人类新皮质深层 3 中区域和物种特异性的兴奋性神经元亚型,展示了人类新皮质的细胞进化过程。Pianno 作为

5/6/2024 6:53:00 PM

ScienceAI

谷歌请印度标注员给Reddit评论数据集打标签,错误率高达30%?

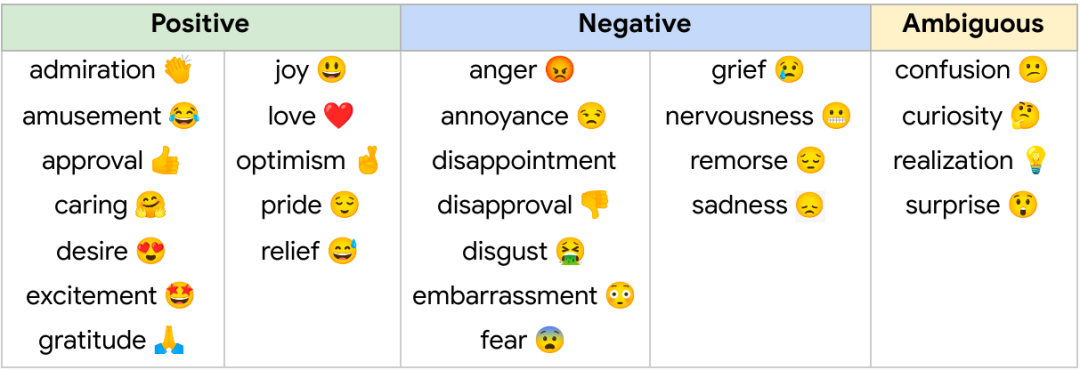

去年,谷歌发布了 GoEmotions 数据集,该数据集包含 58K 人工标注的 Reddit 评论,其中涉及 27 种情绪。

7/19/2022 2:32:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉