北京智源人工智能研究院

刚刚,智源悟界·Emu3.5登场,原生具备世界建模能力

当业界还在为自回归与扩散这两种主流技术路线孰优孰劣而激辩时,答案可能已经显现。 今天,北京智源人工智能研究院(BAAI)重磅发布了其多模态系列模型的最新力作 —— 悟界・Emu3.5。 这不仅仅是一次常规的模型迭代,Emu3.5 被定义为一个 “多模态世界大模型”(Multimodal World Foudation Model)。

10/30/2025 5:18:00 PM

机器之心

智源开源EditScore:为图像编辑解锁在线强化学习的无限可能

随着多模态大模型的不断演进,指令引导的图像编辑(Instruction-guided Image Editing)技术取得了显著进展。 然而,现有模型在遵循复杂、精细的文本指令方面仍面临巨大挑战,往往需要用户进行多次尝试和手动筛选,难以实现稳定、高质量的「一步到位」式编辑。 强化学习(RL)为模型实现自我演进、提升指令遵循能力提供了一条极具潜力的路径。

10/22/2025 11:47:00 AM

机器之心

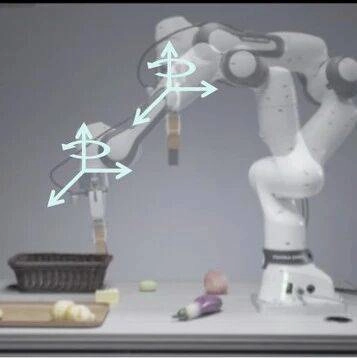

首个零样本跨本体泛化开源具身模型:智源RoboBrain-X0 技术细节全解析

为具身智能行业提供了一个可复用、可扩展的通用基座,同时开源训练数据集。 今天,北京智源人工智能研究院(BAAI)正式开源 RoboBrain-X0,一个能够在零样本泛化、轻量微调条件下,驱动多种不同真实机器人完成复杂任务的具身智能基座大模型。 其核心突破在于:用统一的动作空间与分层任务拆解,实现了「一个基座模型,N种身体」,为通用具身智能提供一条切实可行的路径。

9/29/2025 3:11:00 PM

机器之心

具身智能从此「边听边说」,智源研究院开源原生全双工语音大模型RoboBrain-Audio

语音交互作为人机通信的关键接口,长期以来受限于高延迟、低自然度的交替式对话架构。 为突破这一瓶颈,北京智源人工智能研究院联合 Spin Matrix 与新加坡南洋理工大学,正式发布 RoboBrain-Audio(FLM-Audio) —— 首个支持 “自然独白 双训练范式” 的原生全双工语音对话大模型。 在一段自然对话音频中,用户连续提出多个不同问题,并多次在模型回答过程中打断。

9/25/2025 11:47:00 AM

机器之心

智源大会发布“悟界”系列大模型,加速迈向物理AGI时代

在今日举行的 2025 北京智源大会上,北京智源人工智能研究院正式发布“悟界”系列大模型,全面展示其在物理通用人工智能(AGI)方向的最新研究成果与战略布局。 “悟界”系列意在突破虚实边界、赋能物理世界,涵盖四款前沿模型:多模态世界模型Emu3、脑科学模型见微Brainμ、具身智能大脑RoboBrain 2. 0 以及微观生命模型OpenComplex2,构建了从世界理解、神经建模到具身控制和生命模拟的全链条AI体系。

6/6/2025 12:01:06 PM

AI在线

智源发布RoboOS2.0与RoboBrain2.0:首个支持MCP机制的机器人

在今日举行的2025北京智源大会上,北京智源人工智能研究院正式发布具身智能操作系统RoboOS2.0与升级版大模型RoboBrain2.0,全面开源,推动具身智能生态走向开放协同。 RoboOS2.0是首个支持MCP(多本体协同平台)机制的机器人操作系统,具备无服务器本体部署能力和免适配小脑技能注册机制,大幅降低开发门槛。 系统性能方面,响应时延压缩至3毫秒以下,端云通信效率提升27倍,并引入时空场景图共享与任务闭环反馈机制,显著增强多机器人协作能力与任务稳定性。

6/6/2025 12:01:05 PM

AI在线

一脑多机!智源的新发布,让不同机器人轻松协作

3 月 29 日,智源研究院在 2025 中关村论坛 “未来人工智能先锋论坛” 上发布首个跨本体具身大小脑协作框架 RoboOS 与开源具身大脑 RoboBrain,可实现跨场景多任务轻量化快速部署与跨本体协作,推动单机智能迈向群体智能,为构建具身智能开源统一生态加速场景应用提供底层技术支持。 开源链接如下:具身多模态大脑模型 RoboBrainGitHub::: ShareRobotGitHub::: 打造感知 - 认知 - 决策 - 行动闭环在具身场景中,长程操作任务是机器人执行复杂任务的核心能力之一。 具身大脑 RoboBrain 融合了机器人任务规划、可操作区域感知、轨迹预测的三维能力,通过将抽象指令映射为具象动作序列,增强长程操作任务的能力。

4/1/2025 12:06:00 PM

机器之心

具身智能最佳形态是什么?它是通往AGI必由之路?八位头部玩家、学者现身说法

ChatGPT-4 被认为是人工智能技术发展的重要节点,语言大模型之后的多模态大模型初步显现了世界模型的影子。大模型最终将通过硬件与物理世界产生交互。人工智能的应用实现从数字世界到物理世界的扩展,具身智能是非常关键的技术方向。那么,具身智能应该依循何种发展路径,当前的技术水平处在什么阶段,发展过程中遇到了哪些瓶颈和难题,在应用场景上如何切入,离未来规模应用还有多远,身处在技术变革浪潮中的我们又该何去何从?4 月 27 日,北京智源人工智能研究院院长王仲远在中关村论坛年会未来「人工智能先锋论坛」上,和七位具身智能领域

4/30/2024 3:36:00 PM

机器之心

向数字世界AGI迈进!智能体已经从头开玩「荒野大镖客 2」了

通用计算机控制信息革命产生了数字世界,数字世界为大模型的诞生提供了数据,也最容易实现通用人工智能(AGI)。向数字世界 AGI 迈进,北京智源人工智能研究院、新加坡南洋理工大学、北京大学携手提出通用计算机控制 General Computer Control (GCC),即智能体需要像人一样看屏幕,通过键盘、鼠标完成计算机上的所有任务。在过去很长一段时间里,人工智能研究以游戏为场景,而 GCC 将为通用人工智能研究提供场景,也将进一步促进大模型和 AI Agents 的落地与产业化。为此,研究团队提出通用计算机控制

3/13/2024 2:54:00 PM

机器之心

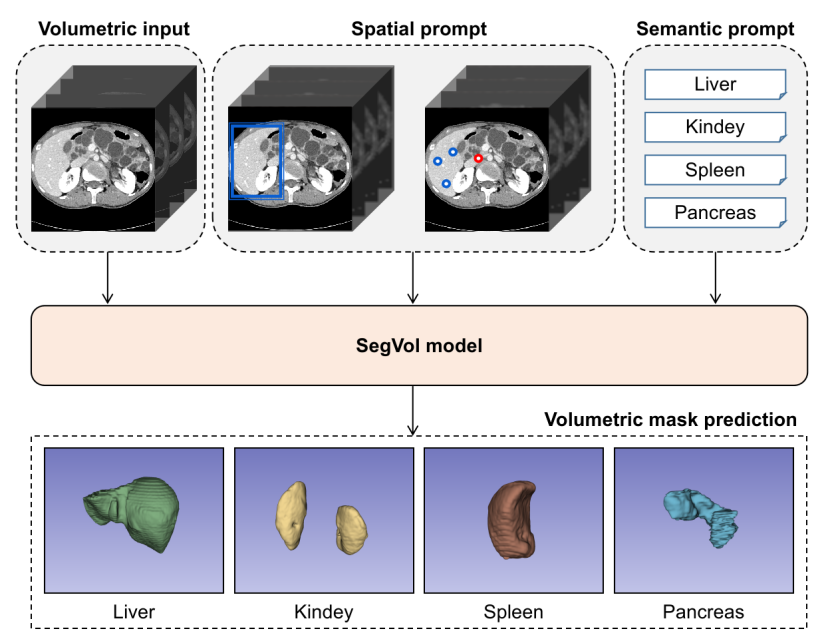

BAAI、北大&港中文团队提出 SegVol:通用且可交互的医学体素分割模型

编辑 | ScienceAI上周,北京智源人工智能研究院(BAAI)、北京大学和香港中文大学的研究团队开源了 SegVol 医学通用分割模型。与过去一些很棒的 Medical SAM 工作不同,SegVol 是第一个能够同时支持 box,point 和 text prompt 进行任意尺寸原分辨率的 3D 体素分割模型。作为一个便捷的通用分割工具,研究人员将 SegVol 代码和模型开源到 GitHub:BAAI-DCAI/SegVol,欢迎大家使用。目前开源的模型权重文件包括(1)使用 96k CTs 预训练 2

11/28/2023 2:20:00 PM

ScienceAI

让大模型自主探索开放世界,北大&智源提出训练框架LLaMA-Rider

大语言模型因其强大而通用的语言生成、理解能力,展现出了成为通用智能体的潜力。与此同时,在开放式的环境中探索、学习则是通用智能体的重要能力之一。因此,大语言模型如何适配开放世界是一个重要的研究问题。北京大学和北京智源人工智能研究院的团队针对这个问题提出了 LLaMA-Rider,该方法赋予了大模型在开放世界中探索任务、收集数据、学习策略的能力,助力智能体在《我的世界》(Minecraft)中自主探索获取知识并学习解决各种任务,提升智能体自主能力和通用性。

11/7/2023 2:41:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

AI for Science

苹果

Agent

腾讯

Claude

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

亚马逊

特斯拉

场景

深度学习

架构

Transformer

MCP

Copilot

编程

视觉