随着人工智能技术的普及,相关风险也在蔓延。安全负责人正面临保护尚未完全理解的系统的挑战,这构成了重大隐患。

帕拉丁全球研究所最新报告《AI技术栈:技术与网络政策入门》系统剖析了AI系统的构建原理及主要安全风险分布。该报告为首席信息安全官(CISO)提供了在实际环境中保障AI安全的实践思路。

简明而强大的分层模型

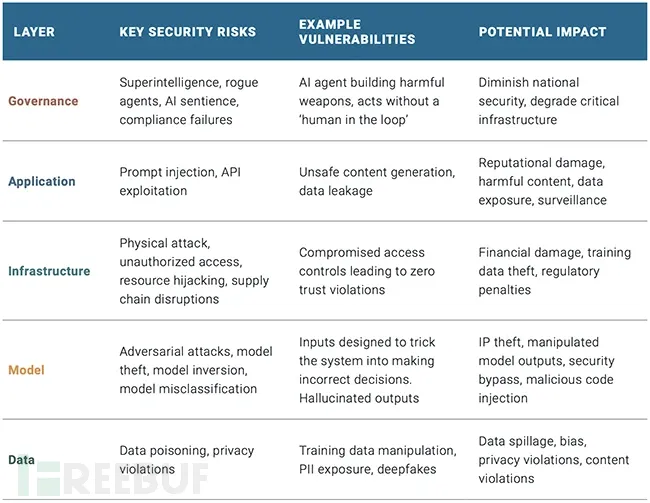

报告将AI技术栈定义为五个相互依存但功能独立的层级:

- 数据层:驱动AI系统的原始素材

- 模型层:处理数据的算法与机器学习模型

- 基础设施层:运行模型的算力与硬件环境

- 应用层:连接AI与用户及其他系统的接口

- 治理层:涵盖整个技术栈的法律、伦理与安全框架

报告特别警告:"单层风险可能引发系统性连锁反应——被污染的训练数据集会破坏模型,导致应用部署时出现不可预测行为,最终酿成具有公共影响的治理事故。"确保AI安全需要在整个技术栈嵌入防护措施,并理解各层级的协同机制。

优先防护数据与模型层

在资源有限的情况下,应优先保护可能造成最严重损害的数据层和模型层。报告明确指出:"正确实施AI安全防护,数据层与模型层最为关键。"这两层构成所有AI系统的基础,同时也存在极高脆弱性。

攻击者深谙此道。数据投毒、模型窃取、对抗性输入和逆向攻击等手段都能操纵AI行为或窃取敏感信息。单个被污染的输入就可能扭曲模型输出,甚至引发未授权访问。由于AI模型通常基于大量非结构化数据构建(部分涉及敏感信息),相关漏洞既难检测更难修复。

报告建议采取以下基础防护措施:

- 对训练数据实施加密与访问限制

- 采用数据脱敏与输入净化技术

- 通过强认证和防火墙保护模型端点

报告强调:"通过加密、访问控制和数据脱敏来保护数据层,对预防数据泄露、保护知识产权、维持用户信任及确保法规遵从都至关重要。"

基础设施与应用层:延伸现有防护

相比需要新策略的模型层和数据层,基础设施层和应用层可采用更成熟的安全方案。多数CISO已具备云工作负载管理、API安全防护和企业系统最小权限管控经验,这些实践同样适用于AI领域,但风险等级更高。

例如基础设施层的GPU集群和专用AI芯片可能成为供应链攻击或资源劫持的高价值目标。应用层则面临提示词注入(prompt injection)和API滥用等新型威胁,报告特别指出"提示词注入、API利用"以及"不安全内容生成、数据泄露"等风险。

防护建议包括:

- 在接口层部署TLS加密

- 实施严格的基于角色的访问控制

- 持续监控提示词与API的滥用行为

治理层:尚待完善的关键环节

尽管技术栈其他层面侧重技术实现,聚焦政策、伦理与监督的治理层成熟度最低,但CISO绝不能忽视其重要性。报告作者指出:"治理层虽不成熟,却是建立AI信任的基石,需要突破僵化监管,转向动态协议开发。"

这包括界定可接受使用范围、确保人工监督机制,以及应对AI做出未授权决策或生成有害内容等边缘案例。报告倡导借鉴TLS和DNSSEC等早期互联网安全标准的经验,建立由行业主导的灵活规范(而非一刀切的监管)。CISO可通过制定内部治理协议发挥作用,特别是在开源模型和第三方AI工具使用方面。

构建系统级安全思维

报告的核心观点之一是必须建立系统级安全观。传统网络安全方案多围绕终端、网络或数据中心构建,但AI系统打破了这些边界。

报告强调:"组织需要制定精密的多层安全策略,针对性解决AI技术栈各层级的独特漏洞。"这要求跨职能协作——数据团队负责训练管道、开发者掌控应用、IT部门管理基础设施,若各自为政将导致AI风险管控出现盲区。CISO必须主导或至少协调覆盖全技术栈的安全战略。