仅凭一段普通视频,能否像专业导演一样,在后期随意改变相机轨迹,同时精细调整变焦、光圈散景、曝光度甚至图像色温?

现有视频生成模型往往难以兼顾「运镜」与「摄影美学」的精确控制。为此,华中科技大学、南洋理工大学、商汤科技和上海人工智能实验室团队推出了 CineCtrl。作为首个统一的视频摄影控制 V2V 框架,CineCtrl 通过解耦交叉注意力机制,摆脱了多控制信号共同控制的效果耦合问题,实现了对视频相机外参轨迹与摄影效果的独立、精细、协调控制。

论文名称:Generative Photographic Control for Scene-Consistent Video Cinematic Editing

论文链接:https://arxiv.org/abs/2511.12921

项目主页:https://huiqiang-sun.github.io/cinectrl/

开源代码:https://github.com/huiqiang-sun/CineCtrl

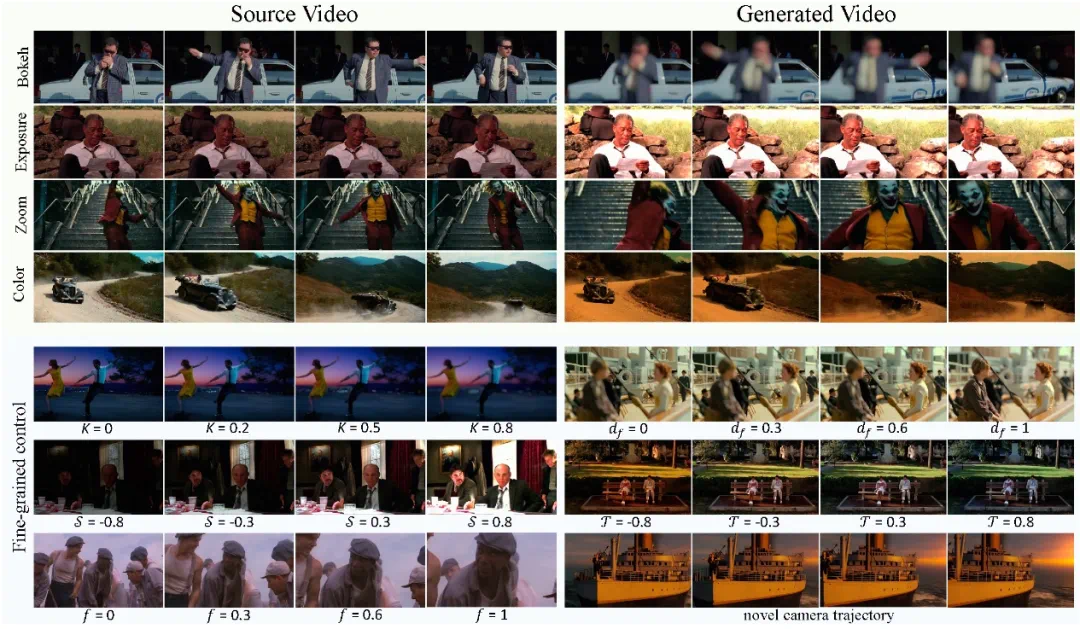

图 1 CineCtrl 摄影效果与相机运动的精细控制

背景

在生成式 AI 爆发的今天,视频生成模型虽然能生成惊艳的画面,但难以做到精确控制相机的运动和画面的摄影质感。现有的编辑工具或是只能在某个单独的摄影效果上处理单张图像,或是只能控制相机轨迹,缺乏一个能将相机运镜与摄影光学统一建模的系统。

如果能够在视频拍摄后做到不仅能够调整镜头运动,还可以精确调整视频的散景、曝光、色温、焦距等摄影效果,那么就可以将一个普通视频变得具有美学效果,达到类似电影级别的视频。这种功能无论是在电影制作,还是 AR/VR 内容生成领域都具有很大的应用前景。

然而,对于专业摄影效果的精细控制在学术界尚未进行广泛探索,同时对于输入视频实现相机轨迹与摄影效果的统一控制更是从未被解决的问题。

其核心的挑战主要包括:

多参数统一控制:散景、焦距、曝光等摄影效果与相机轨迹变化同时进行控制容易产生不同维度的效果耦合,从而出现伪影。如何能够将作用在输入视频的相机运镜与摄影效果以满足各自物理规律的方式有机统一起来成为难题。

缺乏相关数据:专业摄影效果与相机运动共同控制在学术界还未被广泛探索,目前缺乏大规模的成对数据集,即能够给出同一场景在不同相机轨迹以及不同精细化控制的摄影效果的视频对,用于生成模型进行训练。

CineCtrl 的提出填补了这一空白。它提出了首个专业摄影效果控制的 V2V 模型,使得用户可以做到对输入视频编辑不同摄影效果以及相机运动,使得人人都可以成为「导演」,编辑拍摄的普通视频从而具有美学价值。

CineCtrl 的提出填补了这一空白。它提出了首个专业摄影效果控制的 V2V 模型,使得用户可以做到对输入视频编辑不同摄影效果以及相机运动,使得人人都可以成为「导演」,编辑拍摄的普通视频从而具有美学价值。

方法架构

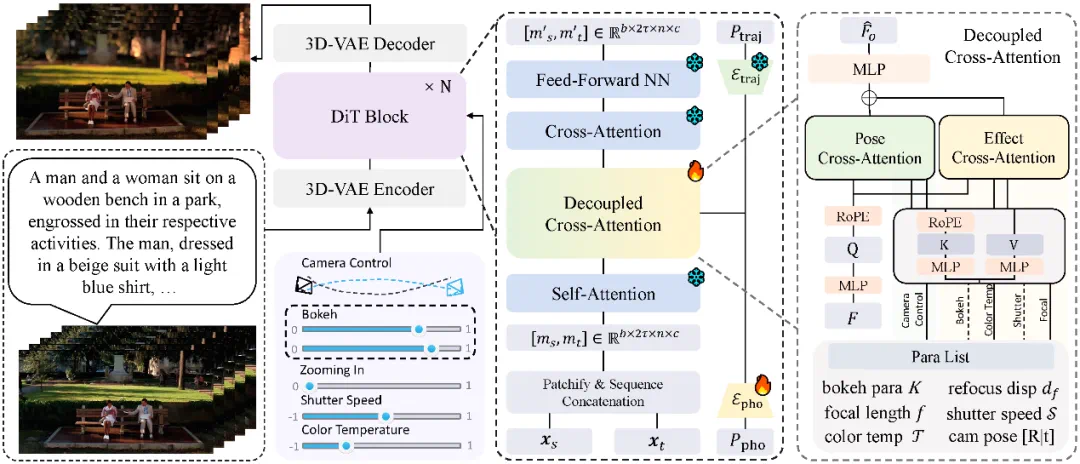

条件视频扩散模型

CineCtrl 基于 Wan2.1 基模型并扩展到 V2V 框架,并加入了相机外参以及专业摄影效果的控制信号。控制信号包括控制散景效果的光圈大小和聚焦位置;控制变焦效果的焦距;控制曝光效果的快门速度以及控制色彩效果的色温。

为了便于用户进行更加直观的摄影效果控制,CineCtrl 将控制信号归一化到用户友好的 [0, 1] 或者 [-1, 1] 的取值范围,用户通过对于效果的直观感受给出相对的效果变化。

控制信号的解耦控制

CineCtrl 通过两个分支分别编码相机外参以及摄影效果两个控制信号,同时通过解耦交叉注意力机制引入两组控制信号。通过专门设计的解耦交叉注意力模块,确保模型在注意力计算的非线性阶段能独立响应不同的控制信号,防止不同维度的控制效果产生不理想的耦合现象。同时该模型设计可以将多维度的控制效果实现有机统一,使得在多参数控制时得到高质量且合理的视频结果。

图 2 CineCtrl 框架总览

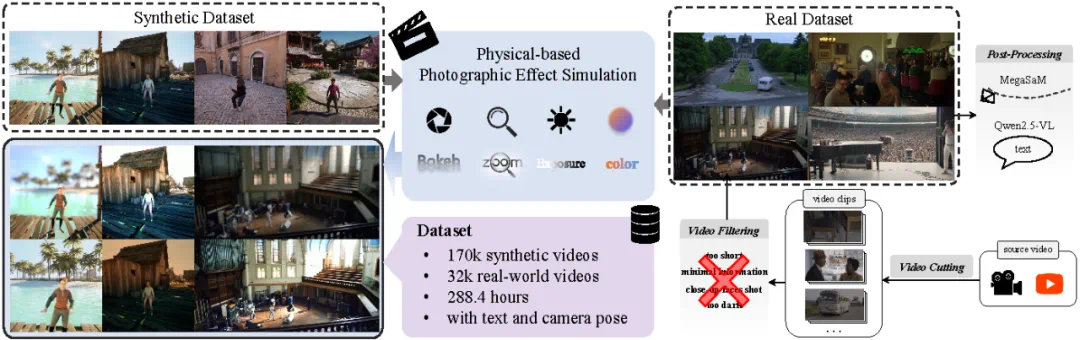

数据构建

摄影效果物理模拟器

为了得到具有精确摄影效果的视频对,CineCtrl 根据不同摄影效果产生的物理机制提出了精细添加摄影效果的模拟方法。同时在设计物理模拟器时结合归一化的参数取值范围进行修正,保证数据空间与用户编辑的参数空间进行对齐。

真实数据采集流程

为了增强模型对摄影效果响应的鲁棒性,CineCtrl 从电影源等具有丰富相机变化的数据中采集视频片段组成训练数据集。整体流程从给定的长视频开始,经过镜头检测、视频裁剪、质量筛选、相机参数预测以及文本 Caption 标注等流程,最终获得高质量的视频数据。

图 3 CineCtrl 数据管线总览

CineCtrl 从 MultiCamVideo-Dataset 收集合成数据集,从之前提到的真实数据采集流程获得真实场景数据,并通过摄影效果物理模拟器进行摄影效果控制,从而搭建了用于模型训练的大规模数据集。在散景效果的数据集构建时,对于散景效果为 0 的数据,其聚焦位置进行随机赋值,从而增强模型对于散景效果的正常响应。数据集包括 200k 视频片段,总计 288.4 小时,并带有本文以及相机参数的标注。

实验结果

对比实验

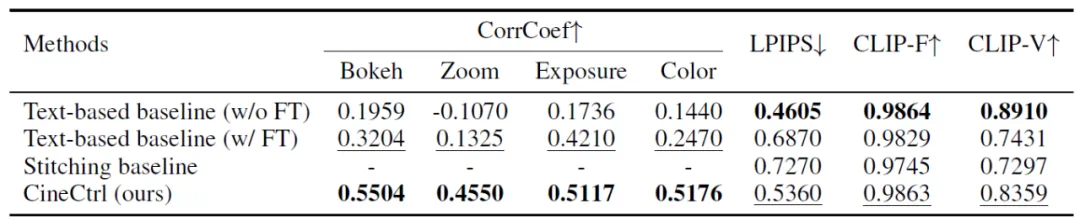

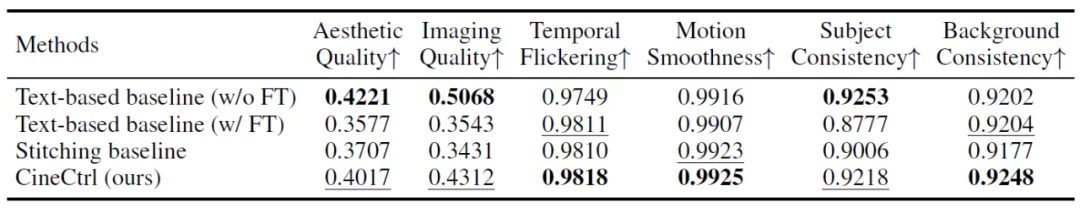

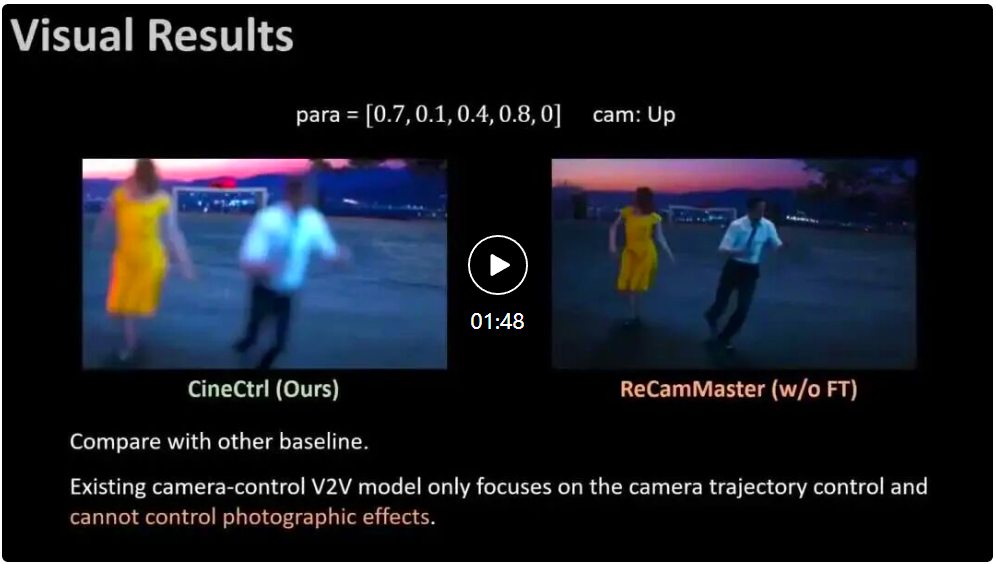

CineCtrl 在摄影效果与相机轨迹控制效果上与其他方法进行对比。由于此前没有类似的方法或模型完成摄影效果与相机运动的统一控制,论文构建多种 Baseline,例如基于 ReCamMaster 模型并使用文本进行摄影效果控制(微调/不微调);级联拼接 ReCamMaster 以及不同摄影效果的物理模拟方法。

如表 1、表 2 与图 4 所示,CineCtrl 在效果控制能力以及视频质量达到了综合最优,在摄影效果的控制上取得了显著领先。

表 1 各方法在摄影效果控制准确性、视频质量以及一致性维度的结果

表 2 各方法在 Vbench 指标上的结果

图 4 各方法的可视化对比结果

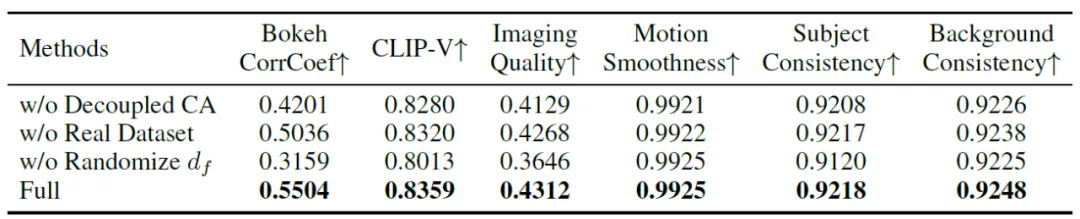

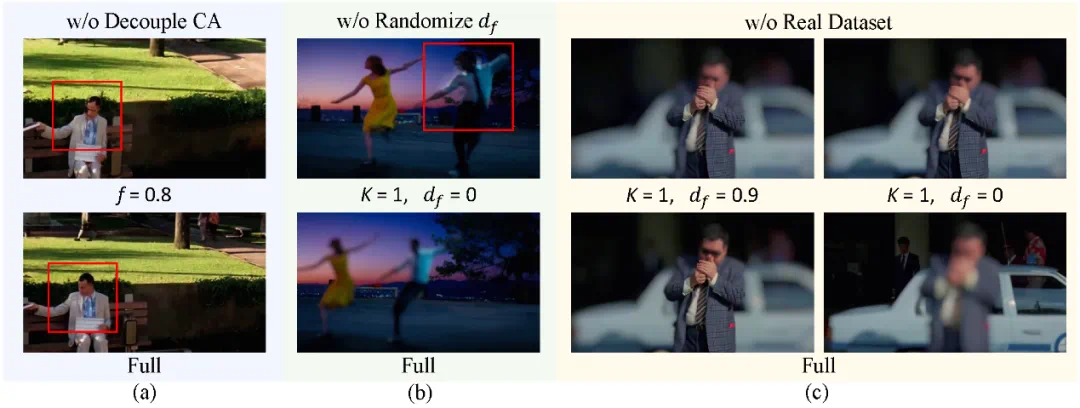

消融实验

消融实验(表 3 与图 5)从模型的解耦交叉注意力机制设计、真实数据集引入以及数据集构建三个方面进行分析。结果表明:解耦交叉注意力机制有效改善了多信号控制的耦合问题;真实数据集引入以及散景数据合成策略使得模型对于场景空间信息理解更加鲁棒,从而增强了对于散景效果的聚焦位置的响应。

表 3 消融实验定量结果

图 5 消融实验定性结果

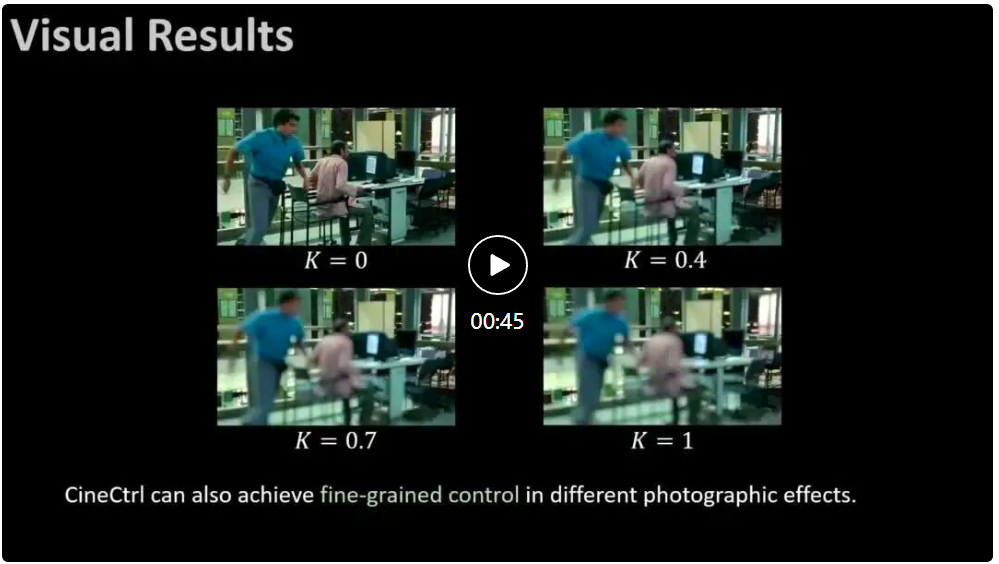

摄影效果精细化控制

本文可以做到不同摄影效果的精细化控制,如图 6 所示,用户可以在给定范围内进行精细化取值,从而得到所需要的摄影效果。

图 6 精细化控制结果

结语

CineCtrl 提出首个用于精细控制专业摄影效果的生成式视频电影编辑模型。通过相机解耦交叉注意力机制来注入控制信号,有效解决了相机轨迹和摄影参数之间的耦合问题。同时还开发了一种全面的训练数据生成策略,将基于物理的仿真方法与新的真实世界数据集流水线相结合。

大量实验验证了 CineCtrl 能够对所需的摄影效果进行精确有效的控制。展望未来,CineCtrl 提供的功能为更智能的电影制作系统开辟了新的可能性。未来研究的一个重要方向是在 CineCtrl 框架基础上,融入高级美学知识,自动确定给定场景的最佳相机轨迹和摄影效果,从而为自动化、电影级视频生成铺平道路。