本工作由南洋理工大学与腾讯 ARC 实验室联合完成。本文的第一作者为南洋理工大学博士生刘坤昊。本文的通讯作者为 ARC 资深研究员胡文博和南洋理工大学教授 Shijian Lu。

AI 能实时拍长片了吗?

想象一下,你正在玩一款开放世界游戏,角色在无缝衔接的世界中自由漫游,游戏引擎必须实时生成一条无限长的视频流来呈现这个虚拟世界。或者,你戴着 AR 眼镜在街头行走,系统需要根据你的视线与动作,即时生成与你环境交互的画面。无论是哪种场景,都对 AI 提出了同样的要求:能实时生成高质量、长时间连贯的视频流。

然而,这正是当前 AI 视频生成的最大瓶颈。现有模型在几秒钟的短片中表现不错,但当生成持续延伸时,问题会像滚雪球一样放大。这种现象被称为误差累积,就像「传话游戏」中信息一层层失真,每一帧的微小误差都会被下一帧继承、放大,最终导致画面崩坏 —— 颜色漂移、动作僵硬、主体变形…… 视频越长,问题越严重。

来自南洋理工大学与腾讯 ARC 实验室的研究者提出了一种新的实时视频生成方法:Rolling Forcing。它通过三大创新设计 —— 滚动窗口联合降噪、Attension Sink 机制、以及高效训练算法 —— 实现了「边生成边修正」,从而在单张 GPU 上实现分钟级视频的实时生成。

论文链接:https://arxiv.org/abs/2509.25161

项目主页:https://kunhao-liu.github.io/Rolling_Forcing_Webpage/

代码仓库:https://github.com/TencentARC/RollingForcing

Huggingface:https://huggingface.co/TencentARC/RollingForcing

研究背景:实时长视频生成的「不可能三角」

研究背景:实时长视频生成的「不可能三角」

实时长视频生成有一个「不可能三角」的困境: 高质量、一致性和实时性三者难以兼顾。其核心难点可分解为以下三个挑战:

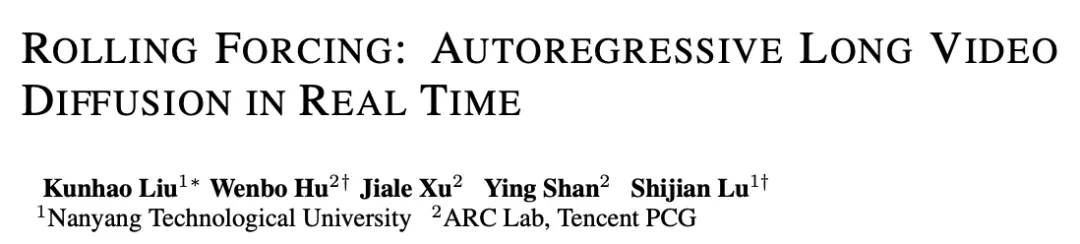

实时性要求模型顺序生成:流式生成要求帧严格按时间顺序输出,且每帧延迟极低。这使规划生成(Planning Generation)等非顺序方法不适用于流式生成。尽管先预测关键帧再插值能减少误差累积,但其乱序生成不适用于实时场景。

消除误差累积与保持一致性的两难:在自回归生成中,每一帧的微小误差(如色彩或运动失真)会像滚雪球一样被后续帧继承放大,导致长期漂移。为缓解此问题,历史腐蚀(History Corruption)通过噪声注入降低对历史的依赖,然而却牺牲了帧间连贯性,会有帧间跳动和长期漂移的问题。

自回归逐帧生成的局限:Self Forcing 等方法虽满足实时流式要求,但其逐帧生成的严格因果性使模型无法修正历史错误,导致误差随视频延长而累积,最终引发画面崩坏。

方法核心:Rolling Forcing如何实现「边生成边修正」

既然现有方法在高质量、一致性和实时性这个困境中难以突破,Rolling Forcing 的动机就很明确: 能否在严格遵守流式顺序的前提下,赋予模型一种「前瞻性」的局部修正能力?其答案是一个巧妙的「滚动窗口」思想。

它将视频生成从一种严格的串行因果过程,转变为一种滑动窗口内的并行协作过程。这好比是将传统工业上一步接一步、误差会逐级放大的串行流水线,升级为一个并行工作站,工作站内的成员可以相互沟通、协同修正,从而在保持产出节奏的同时,显著提升了成品的一致性与质量。

具体而言,Rolling Forcing 通过三项关键设计实现了实时长视频生成的突破:

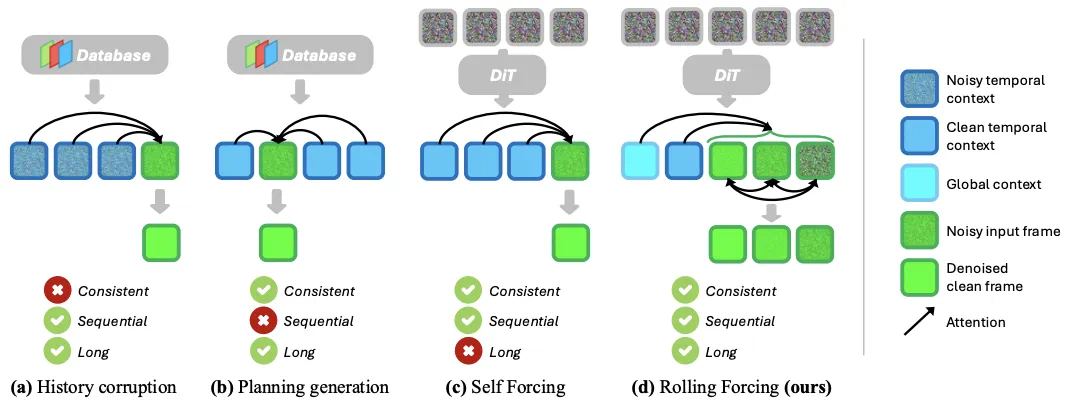

1. 滚动窗口联合降噪:Rolling Forcing 采用滑动窗口进行多帧联合优化。模型在单次前向传播中同时处理一个包含多帧的窗口,窗口内各帧通过双向注意力机制进行相互校准。每完成一次处理,窗口向前滑动:输出首帧作为最终结果,并引入新噪声帧作为窗口末端输入,实现连续流式生成。

2.Attention Sink 机制保障长期一致性:为解决长视频生成中的漂移问题,Rolling Forcing 引入了 Attention Sink 机制。该机制将初始生成帧作为全局锚点进行持久化缓存。在生成后续所有帧时,模型均能访问这些初始锚点信息,从而有效维持视频的长期视觉属性(如色调、光照和主体外观)的一致性。

3. 高效训练算法缓解曝光偏差:Rolling Forcing 设计了一种基于非重叠窗口的高效蒸馏训练算法。该算法在训练过程中使模型使用自身生成的历史帧而非真实数据,有效模拟了推理时的真实场景。

实验结果:实现高质量长视频生成与交互控制

定量结果:显著降低误差累积,实现实时生成

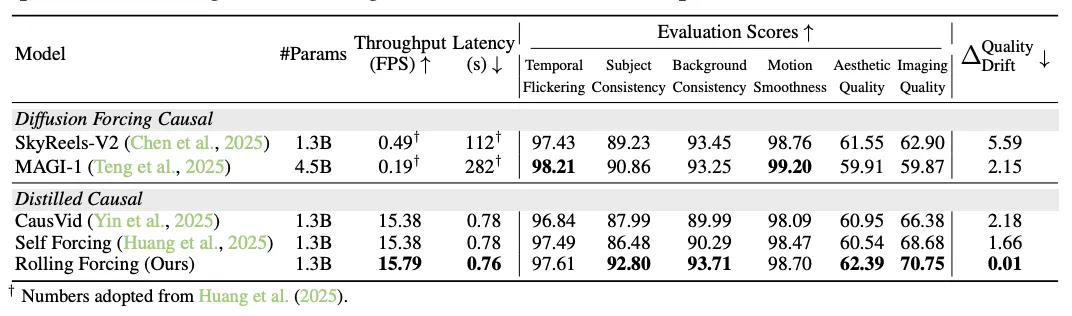

如表所示,Rolling Forcing 在多项关键指标上超越了现有主流方法。其最突出的优势体现在长期一致性上:衡量视频质量漂移的关键指标 ΔDriftQuality 远低于对比模型,这证明其有效抑制了长视频生成中的误差累积。同时,该方法在单张 GPU 上达到了 16 fps 的生成速度,实现了实时生成,为交互式应用奠定了基础。

定性对比:多分钟生成仍保持高保真度

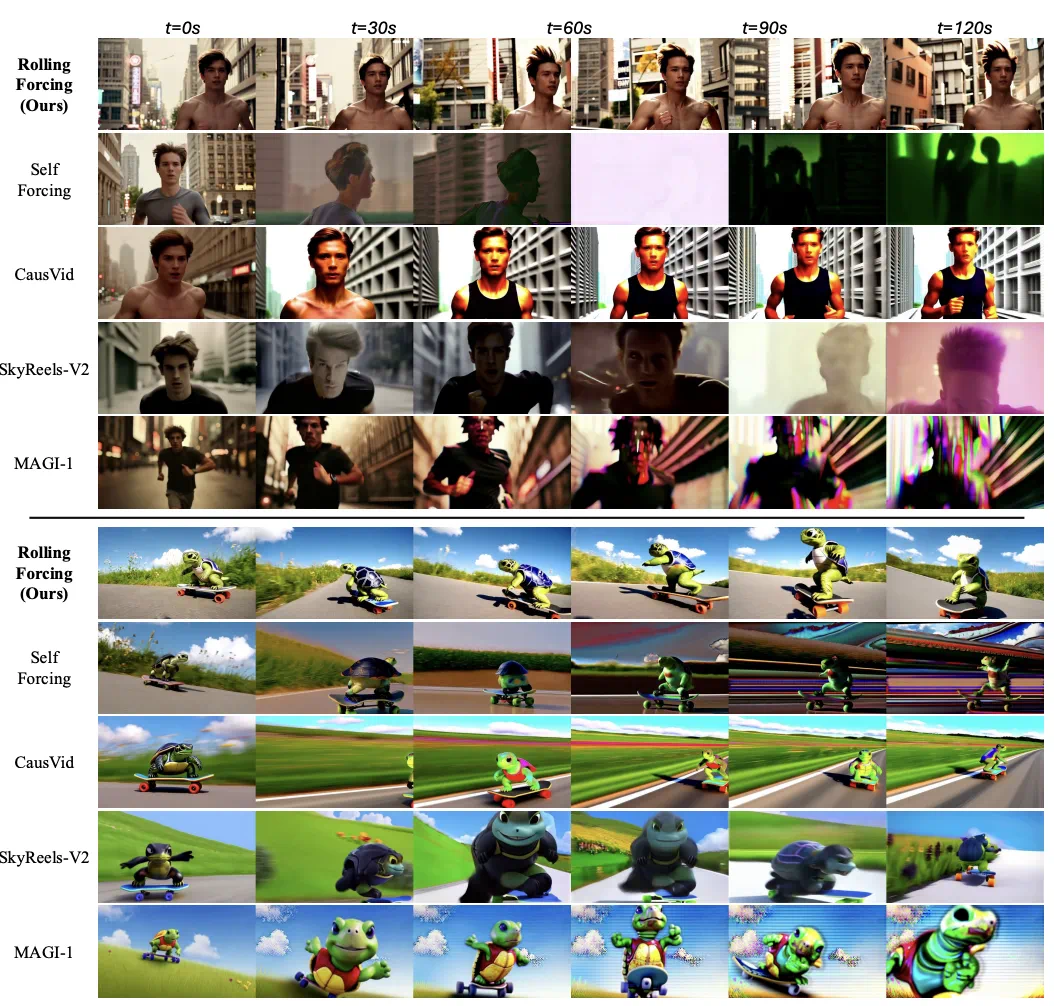

在长视频生成的定性比较中,Rolling Forcing 的优势更为直观。在长达 2 分钟的生成过程中,对比模型(如 SkyReels-V2, MAGI-1 等)出现了明显的颜色偏移、细节退化或主体变形,而 Rolling Forcing 生成的内容在细节、色彩和运动连贯性上均保持了高度稳定。

交互式视频生成:动态引导内容创作

交互式视频生成:动态引导内容创作

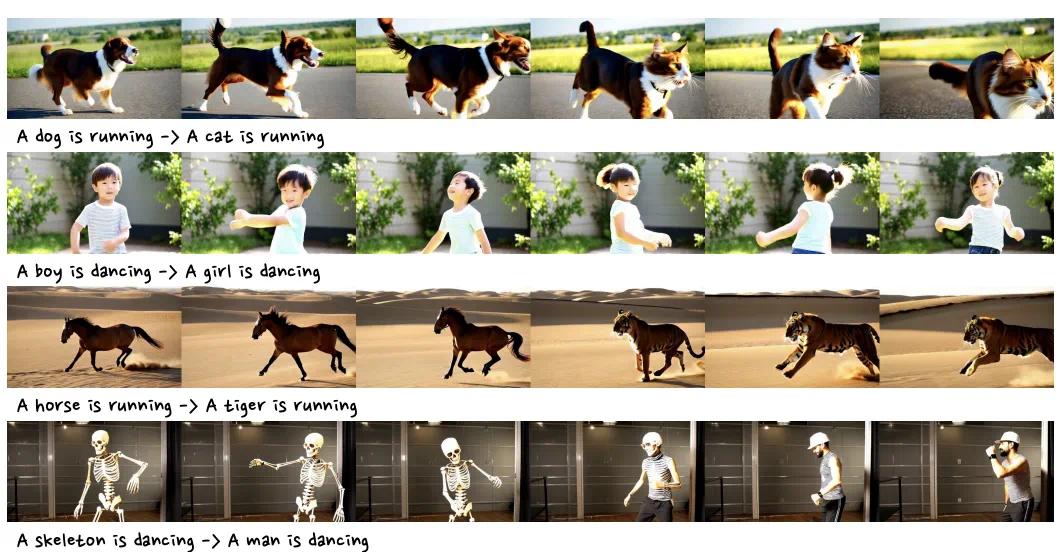

Rolling Forcing 的另一项能力是支持交互式视频流生成。在视频流生成过程中,用户可以随时改变文本提示词,模型能够动态地根据新指令调整后续生成内容,实现内容的无缝切换与引导。

总结与未来挑战

总结与未来挑战Rolling Forcing 成功突破了实时长视频生成的不可能三角,在保持 16 fps 实时生成速度的同时,显著降低了长序列生成中的误差累积,实现了分钟级别的高质量视频流生成,为交互式世界模型、神经游戏引擎等应用提供了基础。

尽管取得了突破性进展,以下方向仍值得进一步探索:

1. 记忆机制优化:当前方法仅保留初始帧和近期帧的上下文,生成过程中段的内容会被丢弃。未来需要探索更高效的长程记忆机制,实现对视频中段关键信息的动态保存与召回。

2. 训练效率提升:大窗口注意力与 DMD 损失计算导致训练成本较高。未来可以探索在不牺牲性能的前提下降低计算复杂度,将模型扩展到更大规模。

3. 交互延迟优化:滚动窗口机制在提升质量的同时会引入微量延迟。针对需要极低延迟的交互场景(如 VR/AR),需要开发更灵活的推理策略。