译者 | 涂承烨

审校 | 重楼

像 GitHub Copilot、ChatGPT、Cursor 和其他 AI 编码助手这样的工具可以在几秒钟内生成样板代码、建议算法,甚至创建完整的测试套件。这加快了开发周期,减少了重复性的编码工作。

然而,幻觉是 AI 生成代码的一个常见问题。幻觉有多种类型,在本文中,我将重点介绍一些基本的逻辑幻觉。

AI 并不能保证理解问题领域、业务需求或架构约束。它生成的输出在语法上看起来正确且逻辑上合理,但可能隐藏着矛盾或遗漏。这些问题可能很微妙,常常能通过单元测试或静态分析,却在集成、生产或面向客户的场景中后期暴露出来。

本文重点介绍逻辑幻觉的三个关键领域:开发代码逻辑、测试逻辑和架构逻辑。针对每个领域,我们将探讨示例和检测策略。

一、开发代码逻辑

开发代码中的逻辑幻觉是一种 AI 生成(或受 AI 影响)的产物,它可能在语法上看起来合理可信。然而,它可能内部自相矛盾或与其声明的目的、周围系统或领域规则不一致。与语法错误不同,这些问题通常能够编译、运行并通过测试。

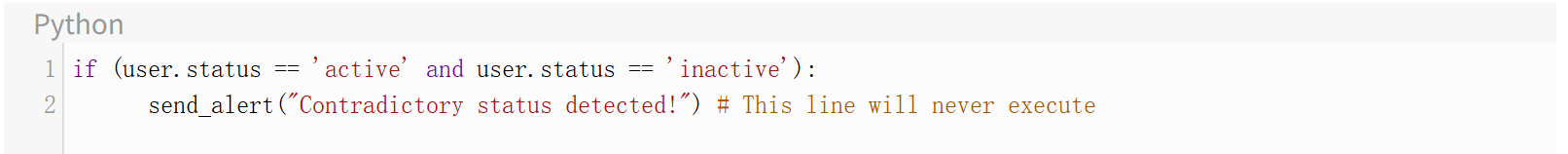

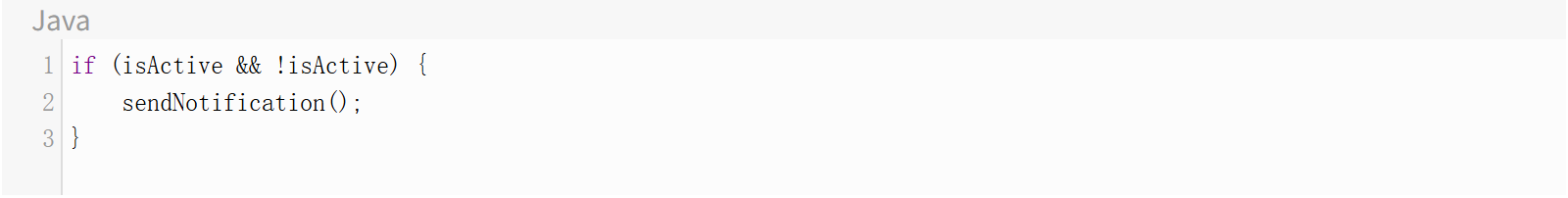

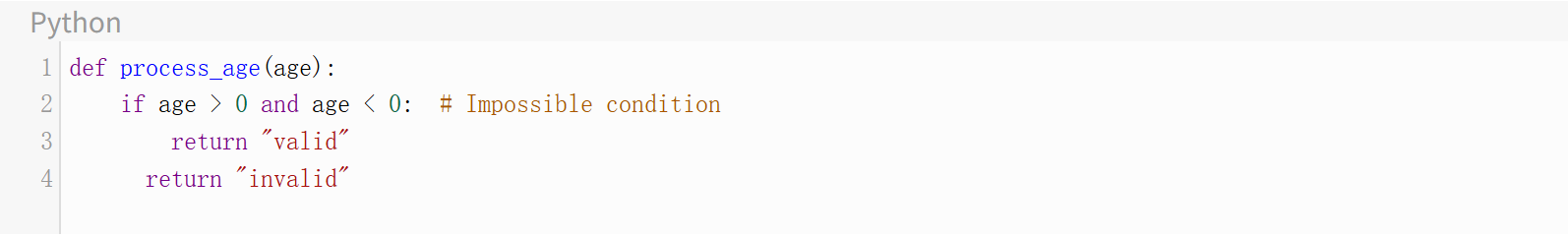

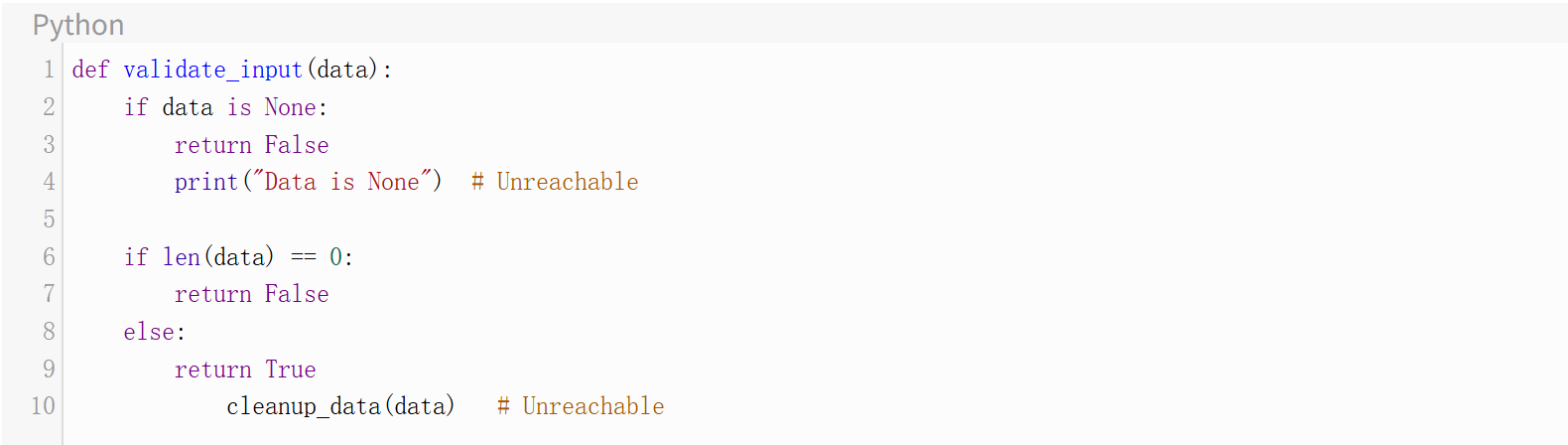

不可能的条件/不可达代码

AI 可能生成条件永远为假,或者某段代码永远无法执行的情况。这表明对程序流程或数据属性的根本性误解。

示例 1:

示例 2:

示例 3:

示例4:

需要注意的方面:

1、总是为真/假的布尔表达式

2、永远无法到达的嵌套 if 语句

3、使用 and 但相互矛盾的条件

4、静态分析(不可达分支检查)

5、分支覆盖率报告(分支从未被覆盖)

6、return 语句之后的代码

7、当 if 总是返回时,else 块中的代码

8、永远无法触发的异常处理

9、在代码审查中,要求对复杂条件提供分支理由

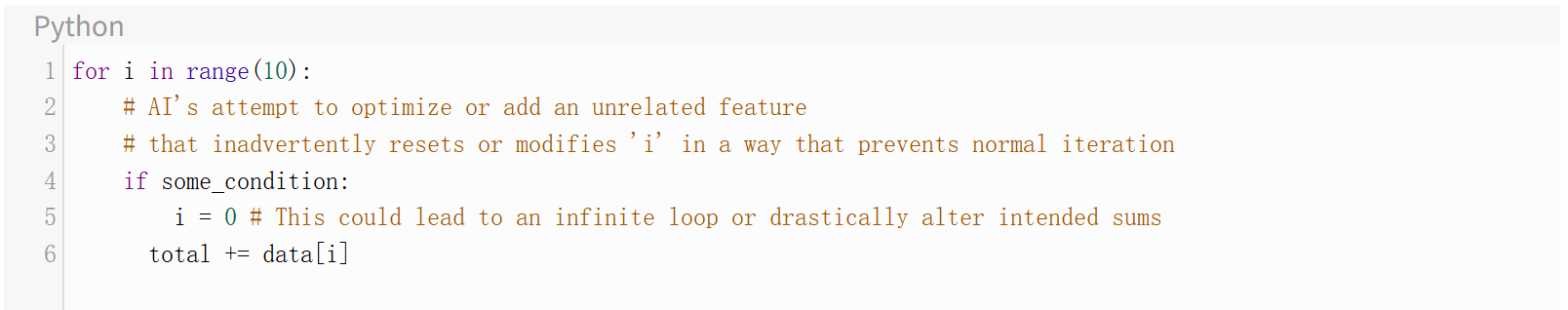

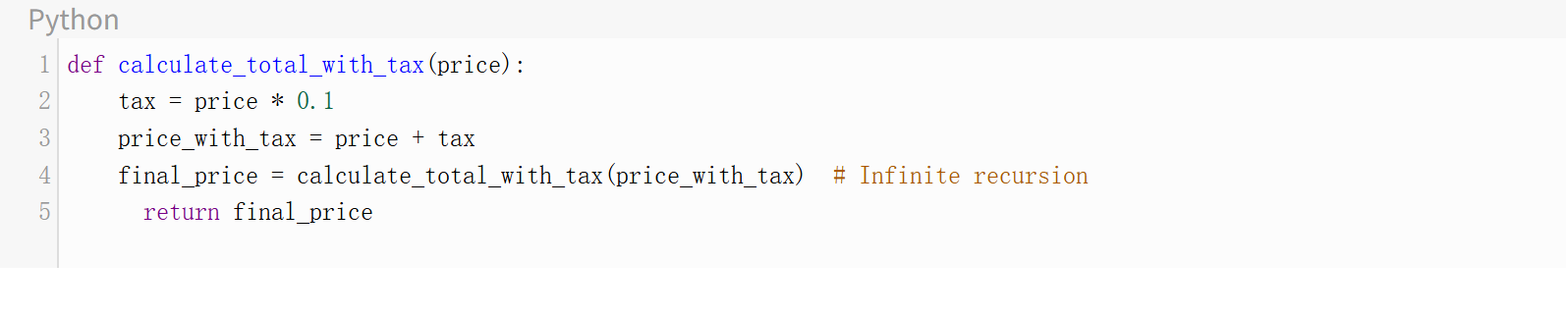

冲突的循环/循环逻辑

循环中的冲突和矛盾可能以多种方式出现。例如,可能存在自相矛盾的循环,即以阻止循环按预期进行的方式修改迭代变量。可能存在由于有缺陷的终止条件而导致的无限循环。可能存在没有适当基本情况的递归函数,导致栈溢出。

示例 1:

示例2:

需要注意的方面:

1、在没有适当基本情况的情况下调用自身的函数

2、形成循环回路的依赖链

3、不合逻辑的操作顺序

4、终止条件永远无法满足的 while 循环

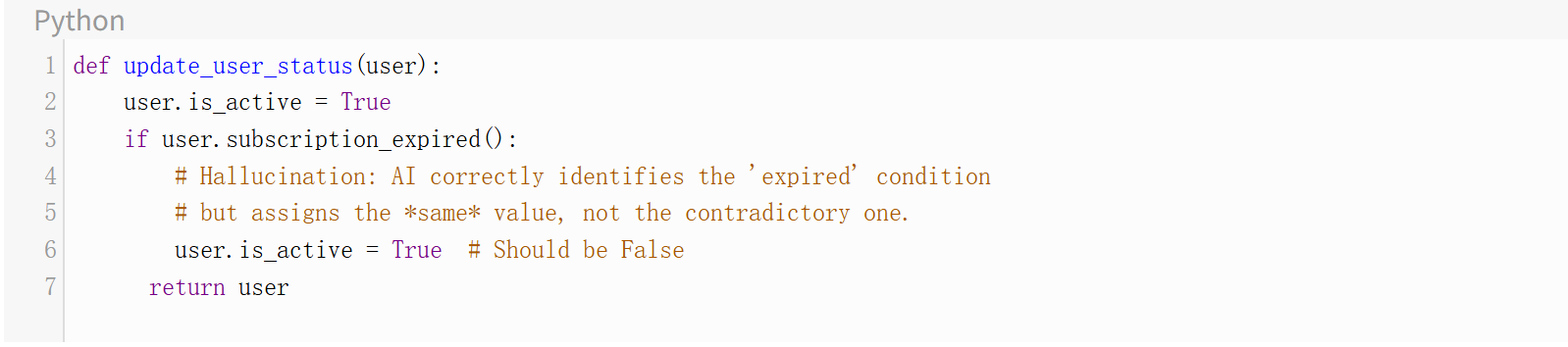

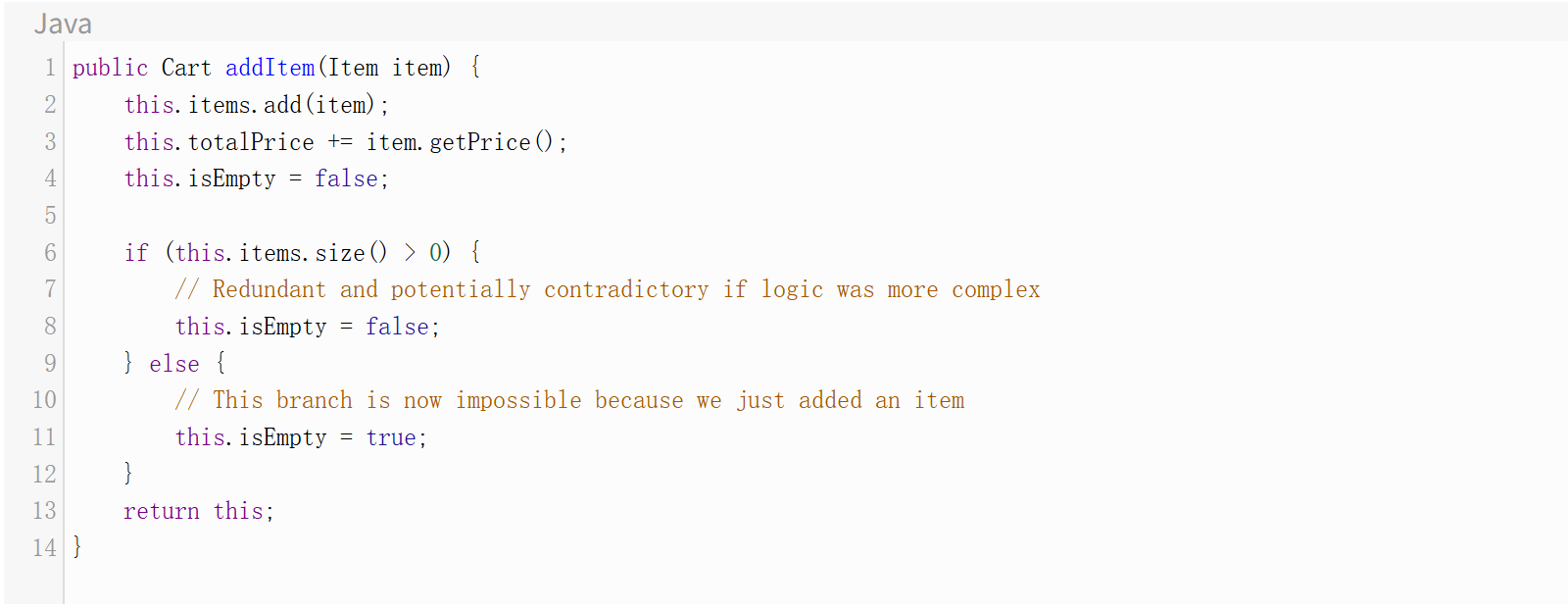

矛盾的状态变更

当 AI 生成的代码将对象或变量设置为特定状态,却又立即否定该状态时,就会发生这种情况。这通常是由于对 if/else 逻辑或业务规则的误解造成的。

示例 1:

示例2:

需要注意的方面:

1、在同一逻辑路径中,变量被设置为冲突的值。

2、在没有中间逻辑的情况下,对同一状态变量进行连续赋值。

3、与业务意图矛盾的状态变更。状态机违规(例如,将状态设置为 'Closed',然后又设置为 'In Progress')。

4、缺少 else 子句,导致错误地应用了默认状态。

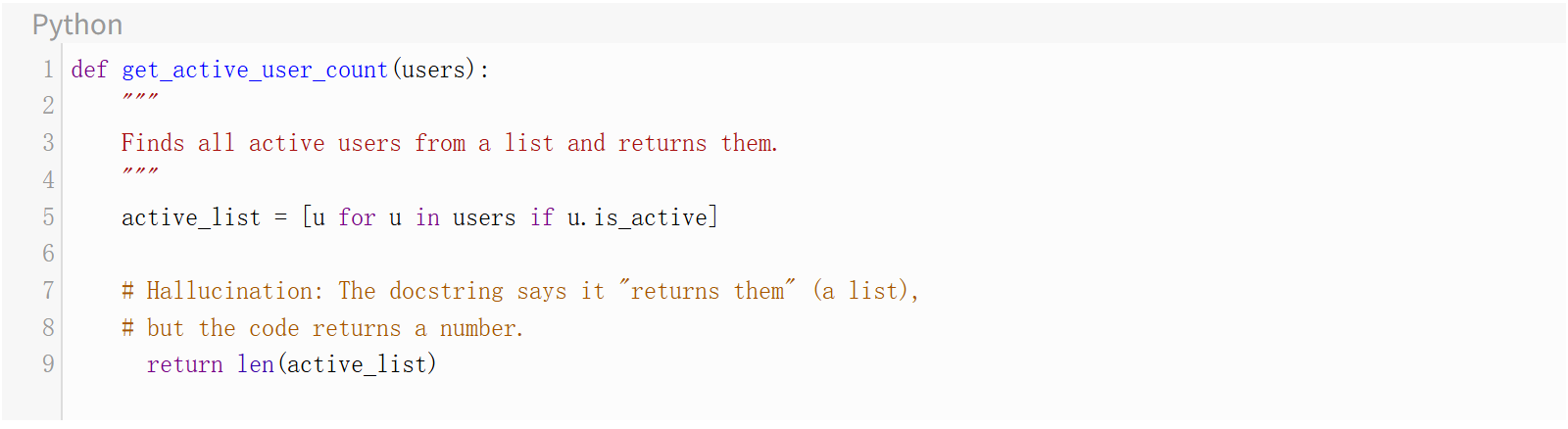

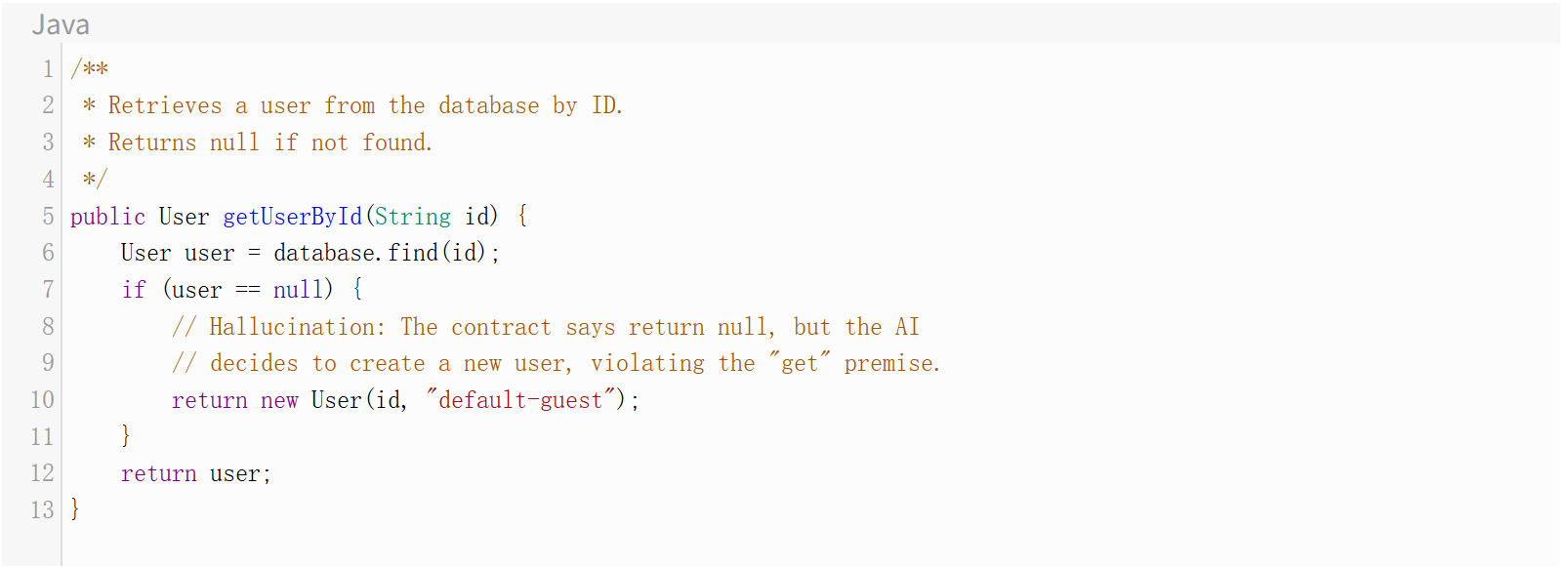

返回/测试契约不匹配

这里,AI 生成的函数实现与其名称、其文档或其隐含的契约不匹配。

示例 1:

示例2:

需要注意的方面:

1、函数/方法名称与其函数体不匹配(例如,一个修改数据的 “get” 函数)。

2、文档字符串/注释与返回语句之间的不一致。

3、具有意外副作用的函数(例如,一个 calculate_ 函数同时也保存到数据库)。

4、测试错误返回类型的单元测试(例如,assert count > 0 而不是 assert isinstance(users, list))。

二、测试代码逻辑

测试代码中的逻辑幻觉尤其危险,因为它们破坏了捕获其他错误的主要安全网。一个通过的 AI 生成的测试会产生错误的信心,使得有缺陷的应用程序代码被合并和部署。

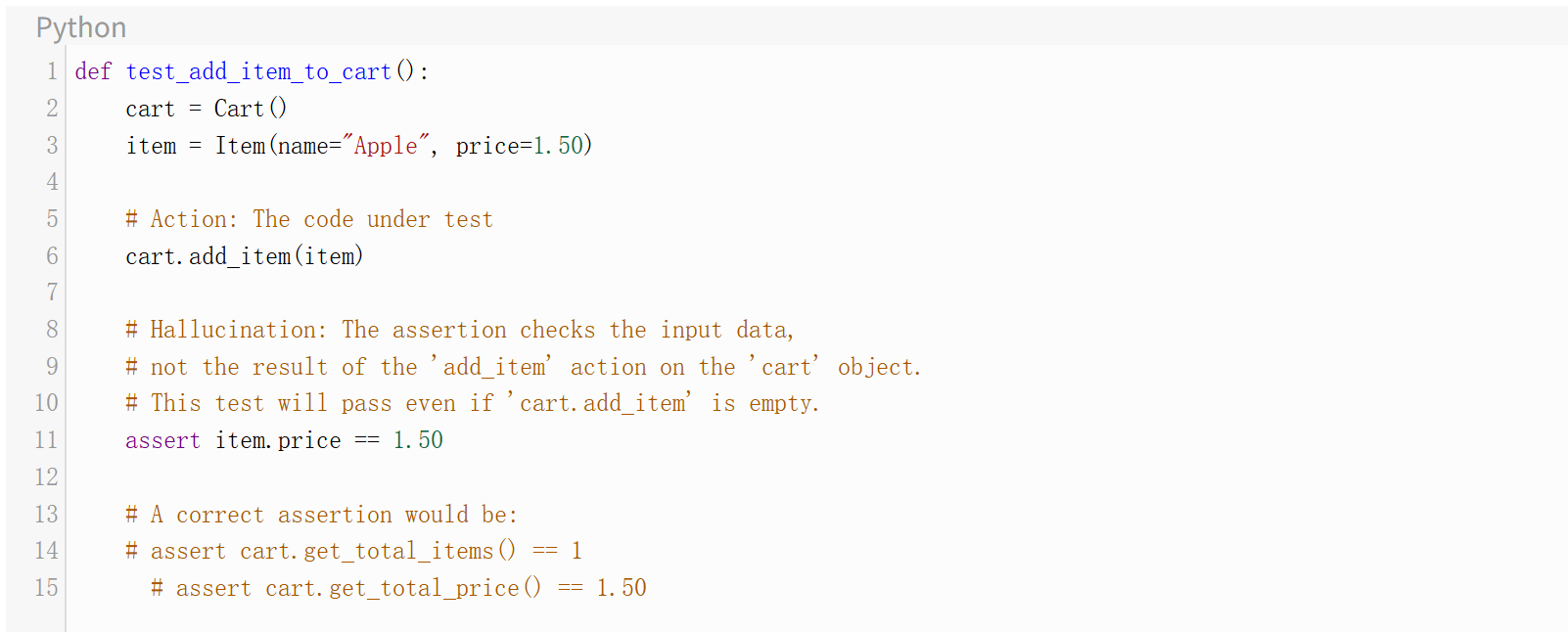

忽略设置的断言

这种情况是指测试精心设置了特定的场景,但 assert 语句未能验证该场景的结果。相反,它断言了一些琐碎的、同义反复的、或者在动作执行之前就已经为真的值。

示例:

需要注意的方面:

1、检查常量的断言(例如,assert 1 == 1)。

2、断言输入变量的状态,而不是被测系统的输出或突变后状态的测试。

3、即使被测试的主要逻辑被注释掉也能通过的测试。

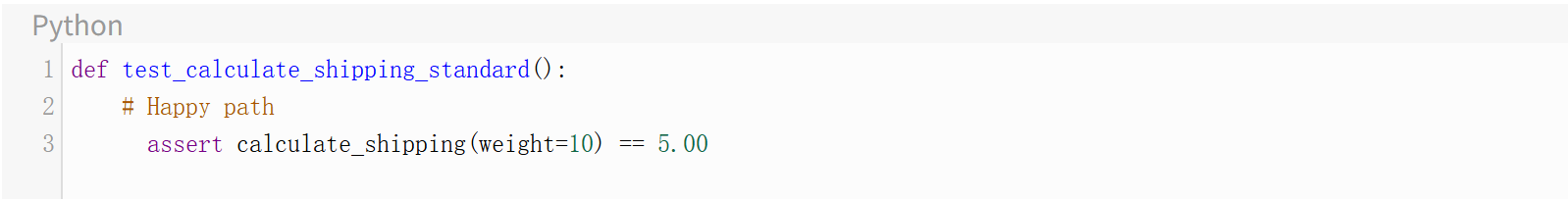

测试覆盖度缺口

AI 助手通常很乐观。它们可能擅长为“快乐路径”生成测试——即所有输入都有效,一切按预期工作。然而,它们可能会忽略为边界情况、错误条件或无效输入生成测试。

示例:一个针对 calculate_shipping(weight) 的测试:

这里的幻觉在于认为这个测试是充分的。我们缺少基本的边界情况,例如:

- test_calculate_shipping_zero_weight()(应该是免费还是报错?)

- test_calculate_shipping_negative_weight()(应该抛出 ValueError)

- test_calculate_shipping_max_weight()(测试边界值)

- test_calculate_shipping_non_numeric()(应该抛出 TypeError)

需要注意的方面:

1、缺少针对 null、None、空列表或零值输入的测试。

2、缺少对预期异常的断言(例如,pytest.raises、assertThrows)。

3、所有测试都是正向断言,没有负向测试用例的测试套件。

4、依赖“行覆盖”指标,这些指标不显示分支或条件覆盖度。

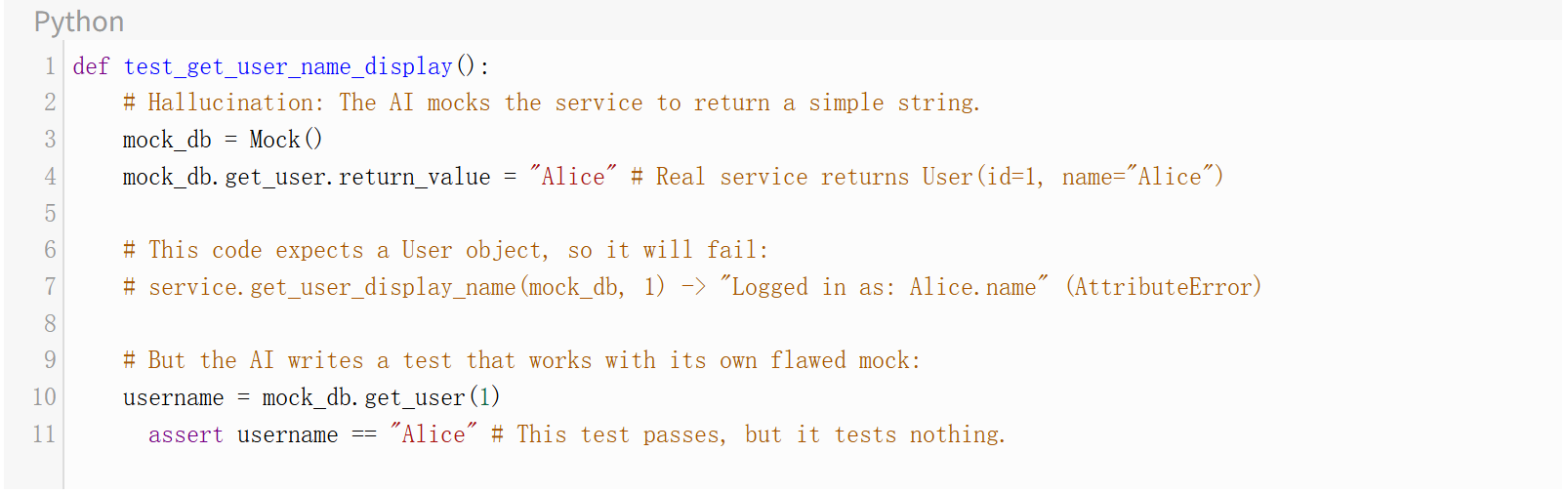

不兼容的模拟(Mocking)

模拟(Mocks)和桩(stubs)用于隔离测试。AI 可能生成一个语法正确但与它所替换对象的真实接口或行为不匹配的模拟。这导致测试在隔离情况下通过,但在集成时严重失败。

示例:真实的 DatabaseService 返回一个 User 对象:User(id=1, name="Alice")。

需要注意的方面:

1、当期望复杂对象时,模拟返回简单类型(字符串、整数)。

2、模拟与真实方法的参数签名不匹配。

3、缺乏“自动规格化”(如 Python 的 create_autospec),这强制模拟符合真实对象的接口。

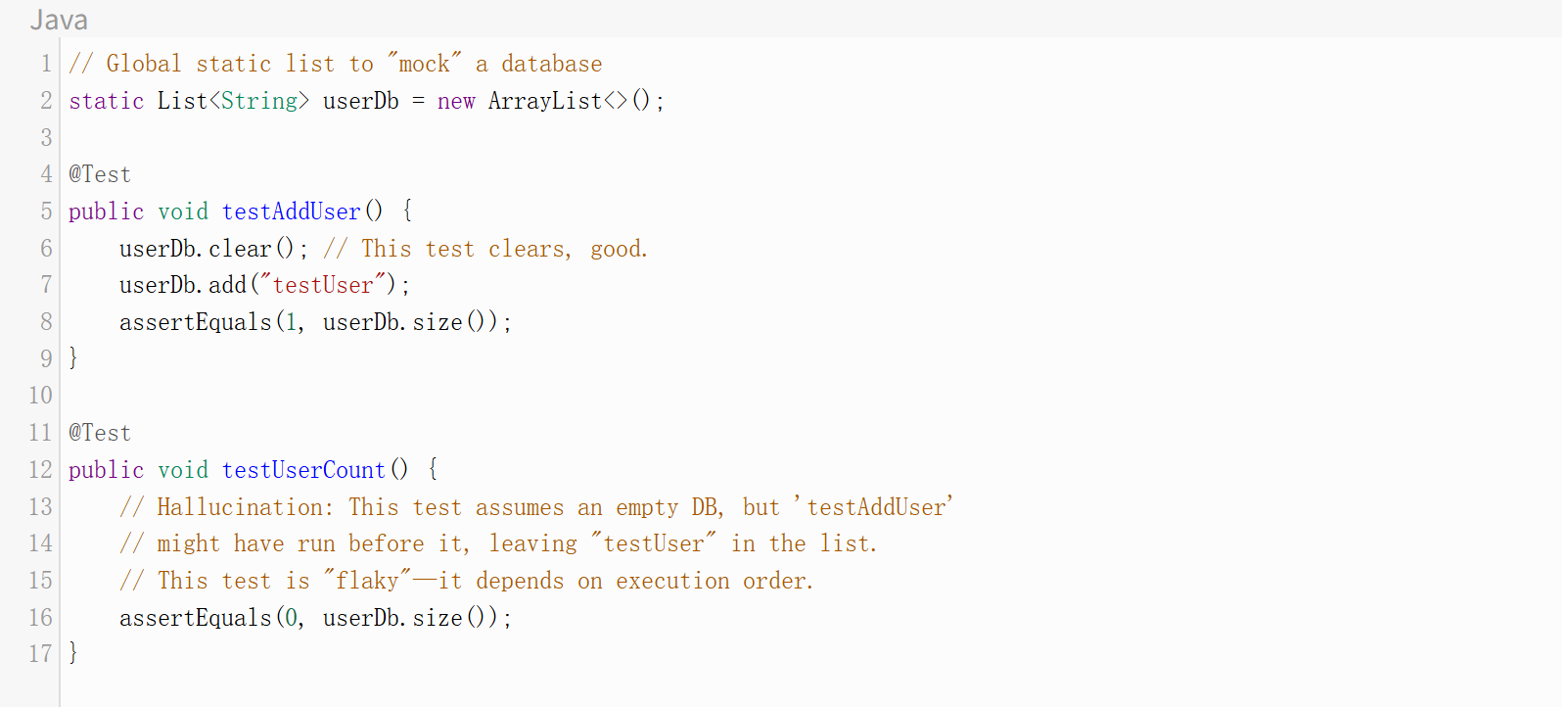

上下文一致性失败

AI 可能在同一个文件中生成一系列没有适当隔离的测试。一个测试可能“污染”全局或静态状态(如数据库连接或单例),导致后续测试失败,或者更糟,因为错误的原因而通过。

需要注意的方面:

1、当以不同顺序或并行运行时失败的测试。

2、缺乏适当的 setup() 和 teardown() 方法(或固件)来在每个测试之间重置状态。

3、在测试文件中使用全局或静态变量。

三、架构逻辑幻觉

这些是高级的、系统性的幻觉。生成的代码在孤立情况下功能正确,但违反了大型应用程序的基本设计原则、模式或约束。

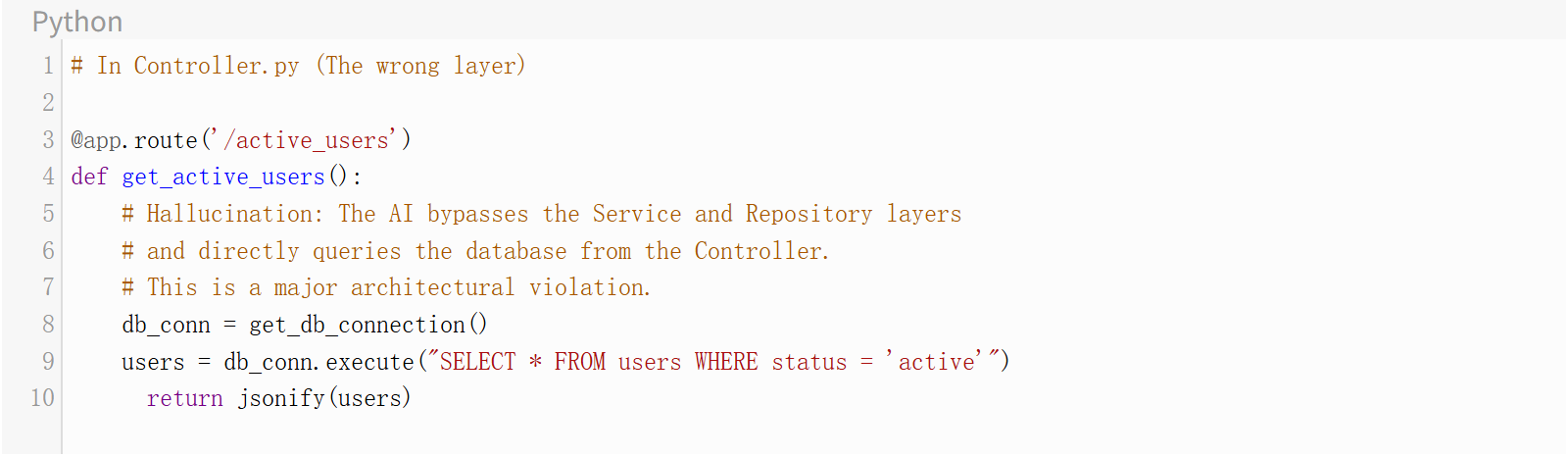

架构矛盾/违规

当 AI(通常只关注单个函数)生成破坏既定架构规则(如分层分离,例如 MVC、3 层架构)的代码时,就会发生这种情况。

示例:在严格的三层架构(Controller -> Service -> Repository)中,要求 AI“添加一个获取活跃用户的端点”。

需要注意的方面:

- 跨越架构边界的 import 语句(例如,View 或 Controller 文件导入 Database 或 ORM 库)。

- 业务逻辑(计算、复杂规则)出现在 UI 或 Controller 层。

- 数据访问代码(SQL、ORM 调用)出现在 Repository 或数据访问层之外的任何地方。

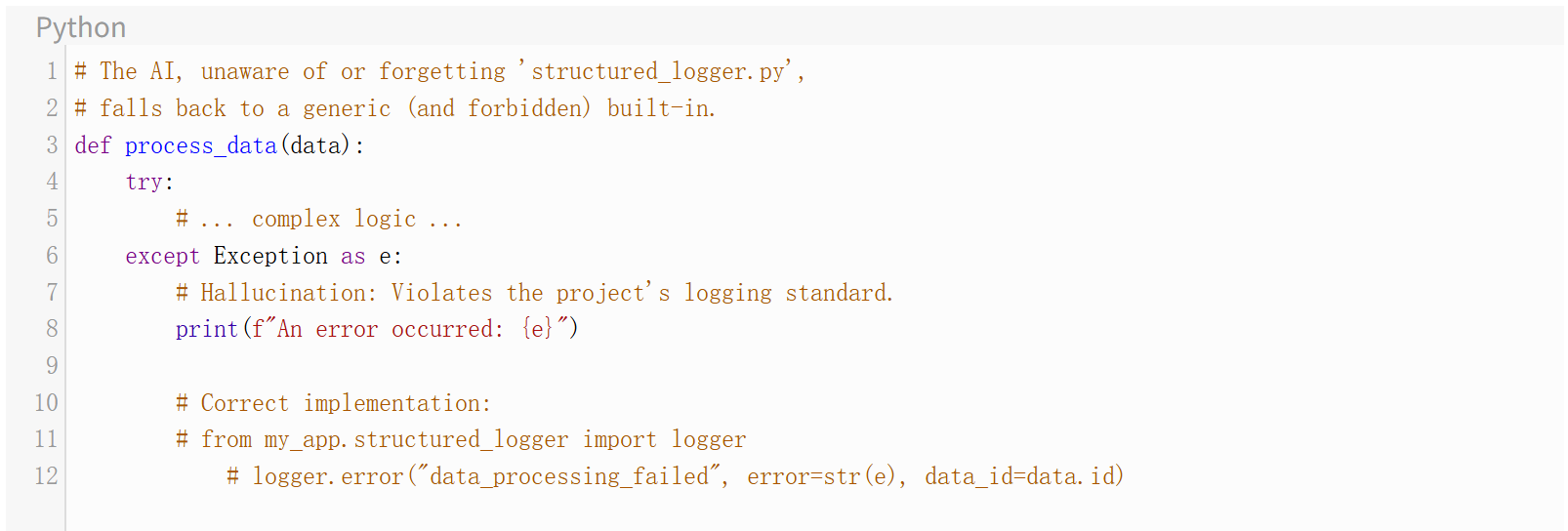

上下文窗口限制

AI 的“记忆”(上下文窗口)是有限的。它无法看到你的整个代码库。这导致它“忘记”在另一个文件中或在长时间对话的早期定义的关键约束、自定义工具或设计模式。

示例:你的项目有一个自定义的 structured_logger.py,必须用于所有日志记录。你要求 AI 为一个函数添加错误处理。

需要注意的方面:

1、辅助函数、自定义工具或常量的不一致使用。

2、重新实现项目中其他地方已在工具模块中存在的逻辑。

3、当需要项目特定的自定义函数时,使用了通用的内置函数。

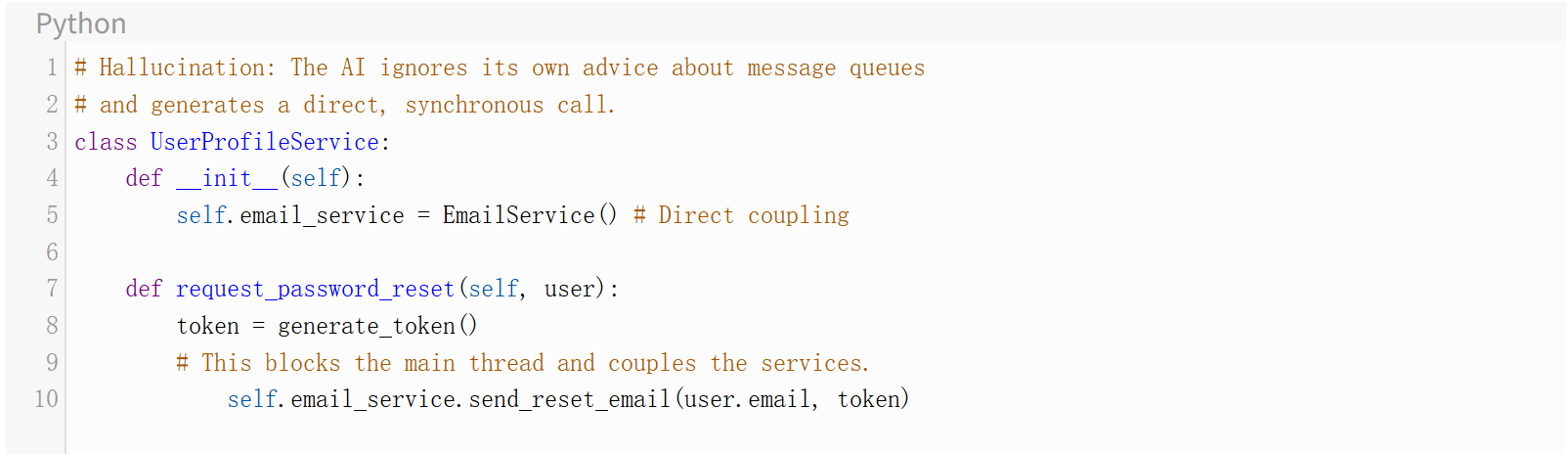

元逻辑不一致

这是指 AI 与它自己的高级建议相矛盾。它可能建议一种设计模式(“我们应该在这里使用工厂模式”),但随后生成的代码却实现了另一种更简单的模式(如基本的 switch 语句),或者反之亦然。

示例:

开发者:“我应该如何处理电子邮件、短信和推送的通知?”

AI:“你应该使用像 RabbitMQ 这样的消息队列来解耦这些服务。主应用程序将发布一个 'notification_request' 事件。”

开发者:“好的,为用户资料服务生成发送密码重置通知的代码。”

AI:

需要注意的方面:

1、违反刚刚讨论或商定的设计模式的代码。

2、建议一种模式,随后却实现另一种模式。

3、在没有明确理由的情况下混合架构风格(例如,同步和异步逻辑、轮询和事件驱动)。

总结

AI 辅助开发标志着一个新的生产力时代。然而,它也催生了一种新的失败类型:看似合理的假象,代码能运行,测试能通过,架构似乎合规。然而,业务可能会失败。

AI 代码助手表现得像过度自信的初级开发人员。我们应该将每个 AI 建议视为来自一个全新的、才华横溢但危险地天真的实习生的代码。始终假设它缺乏上下文。实施二次确认规则。在得到一个建议后,始终提出后续问题:“这段代码是线程安全的吗?” “这个锁的性能影响是什么?” “重构这段代码使其具有幂等性。” 为此,本文解释了 AI 生成代码中的多种逻辑幻觉。对于所呈现的每种情况,我也提出了在二次确认规则中需要注意的方面。

AI 并不能取代专业知识;它要求更多的专业知识。我们的工作不再仅仅是编写代码。我们应该熟练地管理—并严格地质疑—一个由无限快速、无限自信、偶尔胡说八道的数字实习生组成的团队。唯一的防御措施是一个人工指导的 QA 免疫系统—一个分层验证过程,它不仅测试 AI 编写了什么,还要测试逻辑、规则和架构是否仍然协调一致。

译者介绍

涂承烨,51CTO社区编辑,具有18年以上的开发、项目管理、咨询设计等经验,获得系统架构设计师、信息系统项目管理师、信息系统监理师、PMP,CSPM-2等认证。

原文标题:Fundamentals of Logic Hallucinations in AI-Generated Code,作者:Stelios Manioudakis