Meta的PyTorch团队近日发布了Monarch,这是一个革命性的开源框架,专门用于简化跨多个GPU和机器的分布式AI工作流程。

该系统的最大亮点是引入了单控制器模型,让开发者只需一个脚本就能协调整个集群的计算任务,大幅降低了大规模训练和强化学习任务的复杂度,同时保持标准PyTorch代码的编写方式不变。

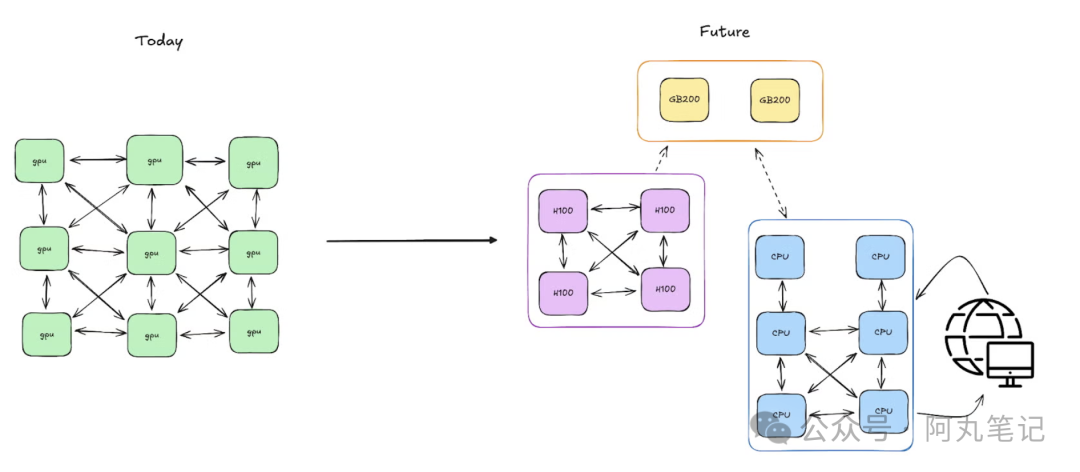

传统多控制器模式的终结

Monarch彻底颠覆了传统的多控制器方法。在过去,开发者需要在每台机器上独立运行相同脚本的多个副本,这种方式不仅复杂,还容易出现同步问题。

而Monarch的单控制器模型则完全不同——一个脚本就能掌控全局,从启动GPU进程到处理故障,所有操作都由一个控制器统一协调。

这种架构让开发者产生了一种"本地开发"的错觉,实际上却是在整个集群上运行。PyTorch团队将其描述为"将单机PyTorch的简洁性带到了整个集群"。开发者可以使用熟悉的Python构造——函数、类、循环、futures——来定义分布式系统,实现无缝扩展,无需重写逻辑来处理同步或故障。

核心创新:进程网格和Actor网格

Monarch的核心创新在于引入了进程网格(process meshes)和Actor网格(actor meshes)。这些是可扩展的分布式资源数组,可以像NumPy中的张量一样进行切片和操作。这意味着开发者可以:

• 广播任务到多个GPU - 轻松将计算任务分发到整个集群

• 分割成子组 - 灵活地将资源分组处理不同任务

• 从节点故障中恢复 - 使用直观的Python代码处理故障恢复

在底层,Monarch将控制与数据分离,允许命令和大型GPU到GPU传输通过不同的优化通道进行,从而提高了效率。

"Monarch是朝着以最小摩擦扩展PyTorch迈出的坚实一步。我很好奇它在真实分布式工作负载中的表现——特别是与Ray或Dask相比。希望能看到更多关于调试支持和大规模容错的信息。这是一个有前途的开始!"——Sai Sandeep Kantareddy,高级应用AI工程师

强大的容错能力

Monarch的容错能力同样令人印象深刻。开发者甚至可以使用标准的Python try/except块来捕获远程Actor的异常,逐步构建容错层。同时,分布式张量直接与PyTorch集成,因此即使运行在数千个GPU上,大规模计算仍然"感觉"像本地操作。

Rust后端:性能与可靠性的保证

Monarch的后端采用Rust语言编写,由名为hyperactor的低级actor框架提供动力。这个框架提供了可扩展的消息传递和跨集群的健壮监督。这种设计允许Monarch使用多播树和多部分消息传递来高效分发工作负载,而不会使任何单个主机过载。

开源生态与集成支持

Monarch现已作为开源项目在GitHub上提供,包含完整的文档、示例notebook以及与Lightning.ai的集成指南。该框架的目标是让集群规模的编排变得像本地开发一样直观,为研究人员和工程师提供从原型到大规模分布式训练的平滑路径。

对于AI社区来说,Monarch的发布标志着分布式AI开发进入了一个新阶段。它不仅仅是一个技术工具,更是对传统分布式计算思维的一次根本性革新。通过将复杂的集群管理抽象化,Monarch让更多开发者能够轻松驾驭大规模AI训练,这无疑将加速整个AI领域的发展进程。

随着AI模型规模的不断增长,分布式训练已成为不可避免的趋势。Monarch的出现,为这一挑战提供了优雅的解决方案,让"让AI训练像本地开发一样简单"的愿景真正成为现实。