赶紧学习起来吧!

OpenAI 的风波暂时告一段落,员工也忙着「干活了」。

年初回归 OpenAI 的 Andrej Karpathy 最近做了一场关于大型语言模型(LLM)的 30 分钟入门讲座,但该讲座当时没录制。因此,他基于这场讲座重新录制了一个长达 1 小时的视频,希望让更多人看到和学习。

视频的主题为《大型语言模型入门》,涵盖了 LLM 的推理、训练、微调以及新出现的 LLM 操作系统和 LLM 安全。视频主打「非技术性」,偏科普,所以更加容易理解。

想要了解更详细内容,大家可观看原视频。

我们接下来整体了解一下 Karpathy 都讲到了哪些内容。视频主要分为三大部分展开,分别是 LLMs、LLMs 的未来和 LLM 安全。

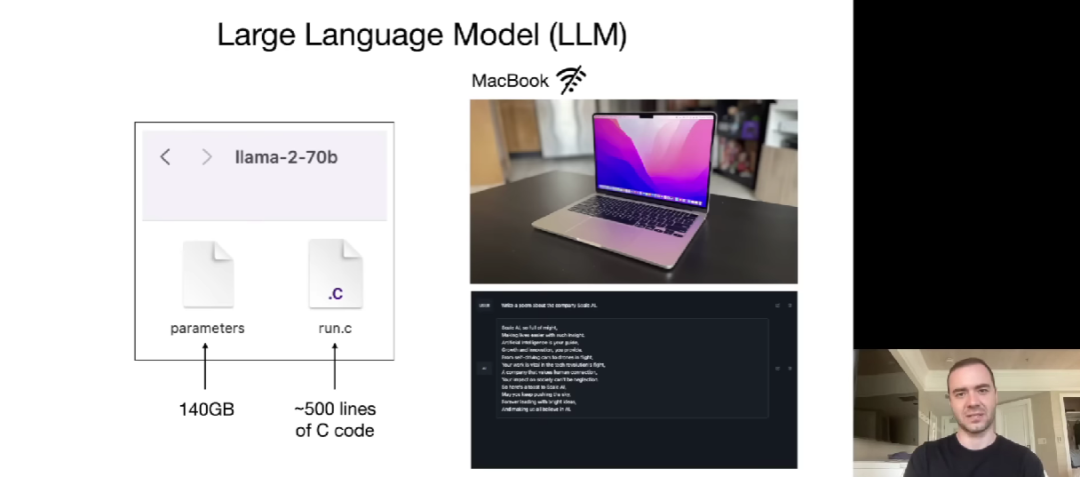

在第一部分,Karpathy 首先介绍了 LLM 的一些入门知识,并以 Meta 推出的开源大模型 Llama 2-70b 为例讲解。该模型有 700 亿参数,它主要包含两个文件,分别是参数文件(文件大小为 140GB)和运行这些参数的代码(以 C 语言为例需要约 500 行代码)。

因此,在 LLM 推理阶段,Karpathy 表示只要有这两个文件再加上一台 MacBook,我们就可以构建一个独立的系统,无需联网或其他设施。这里他展示了跑 70 亿参数大模型的例子。

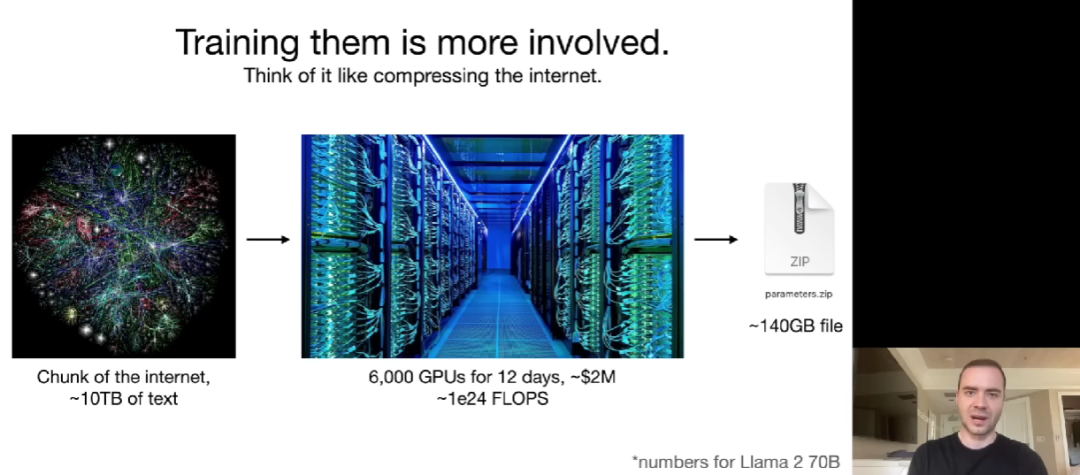

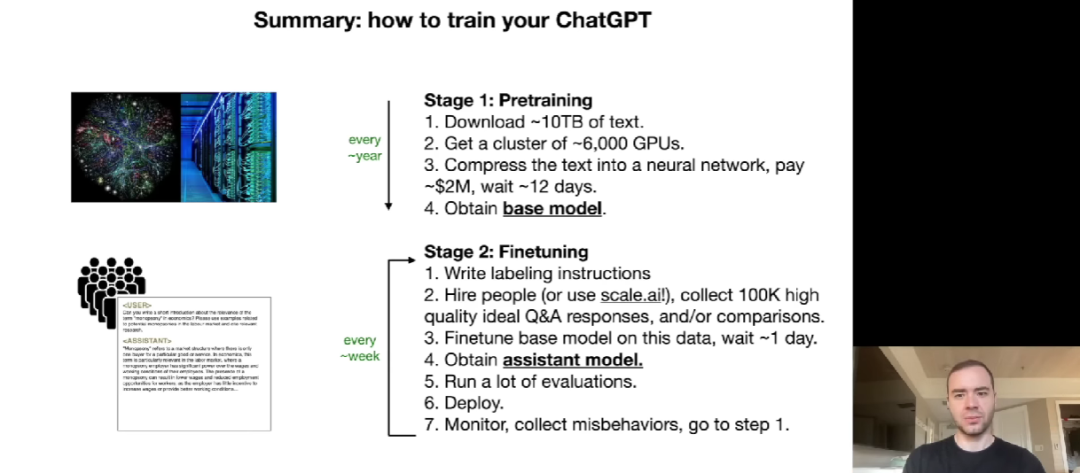

LLM 训练比推理复杂得多。Karpathy 表示,模型推理可以在一台 MacBook 上运行,但模型训练过程耗费的计算量就非常大了。因此,我们需要对互联网内容进行压缩。他以 Llama 2-70b 为例来说明,训练该模型需要从网络爬取约 10TB 的文本,大约需要 6000 个 GPU 训练约 12 天,耗资 200 万美元,参数文件大小约为 140GB。

显然 Llama 2-70b 并不是最大的,如果训练 ChatGPT、Claude 或 Bard,这些数字可能会增加 10 倍或者更多,耗资可能高达千万甚至上亿美元。

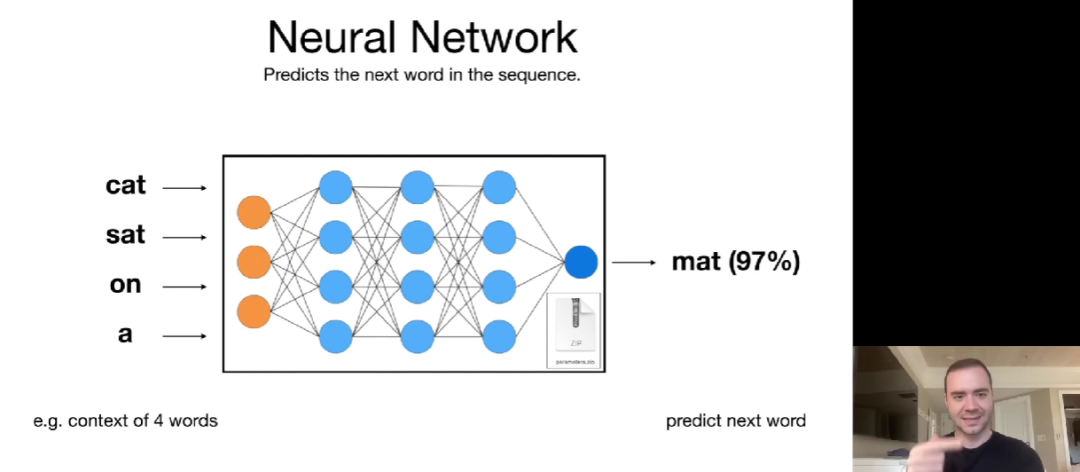

不过,一旦拥有了这些参数,运行神经网络的计算成本就相对较低了。Karpathy 解释了什么是神经网络,它的基本任务是预测序列中的下一个单词。他将训练过程视为一种互联网的压缩,如果可以准确地预测下一个单词,则能够用来压缩数据集。

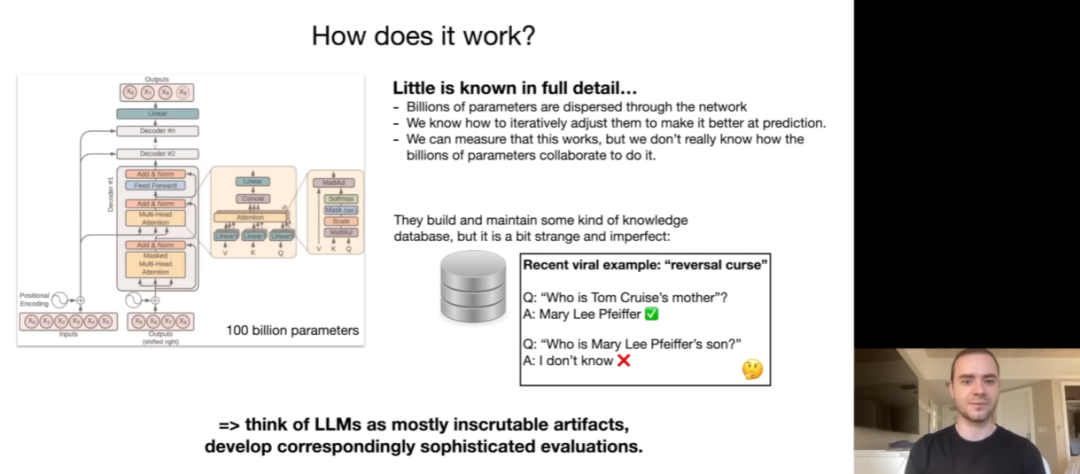

神经网络是如何预测下一个单词的呢?Karpathy 介绍称,正如以下 Transformer 神经网络架构示意图,1000 亿参数分布在整个神经网络中。这就需要迭代地调整这些参数,使网络作为一个整体来更好地执行预测下一个单词的任务。

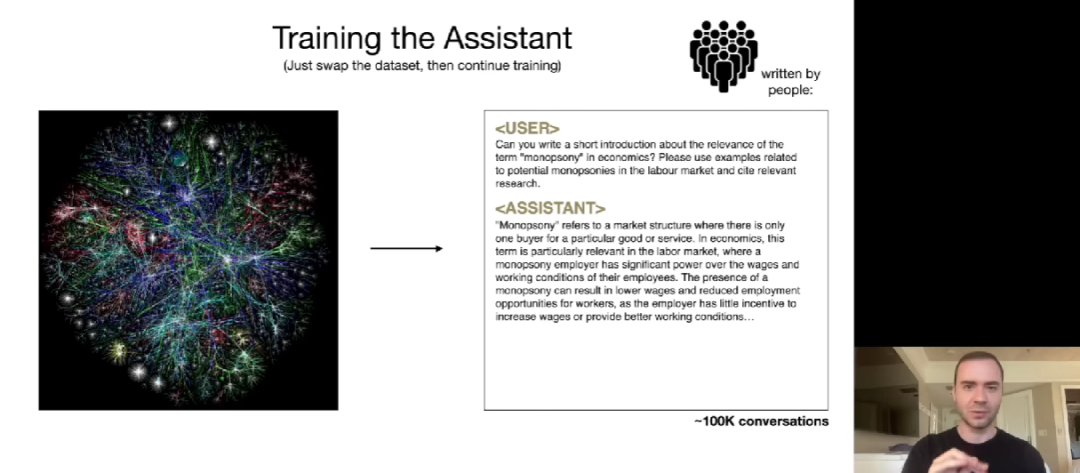

上面这些是训练的第一阶段,称为预训练,显然还不足以训练出一个真正的助理模型。这就要进入微调阶段。预训练阶段需要大量来自互联网的文本数据,这些数据可能质量不高。但微调阶段看重数据的质量而非数量,比如需要非常高质量的对话文档。

Karpathy 总结了如何训练自己的 ChatGPT。预训练阶段获得基础模型,微调阶段则需要编写标签指令、雇人收集高质量的 QA 响应、对基础模型进一步微调、进行大量评估以及部署等步骤。

第二部分讲的是 LLMs 的未来,包括 LLM 缩放法则、工具使用、多模态、思考及 System 1/2、自我改进及 LLM AlphaGo、LLM 定制、GPTs Store 以及 LLM 操作系统等。

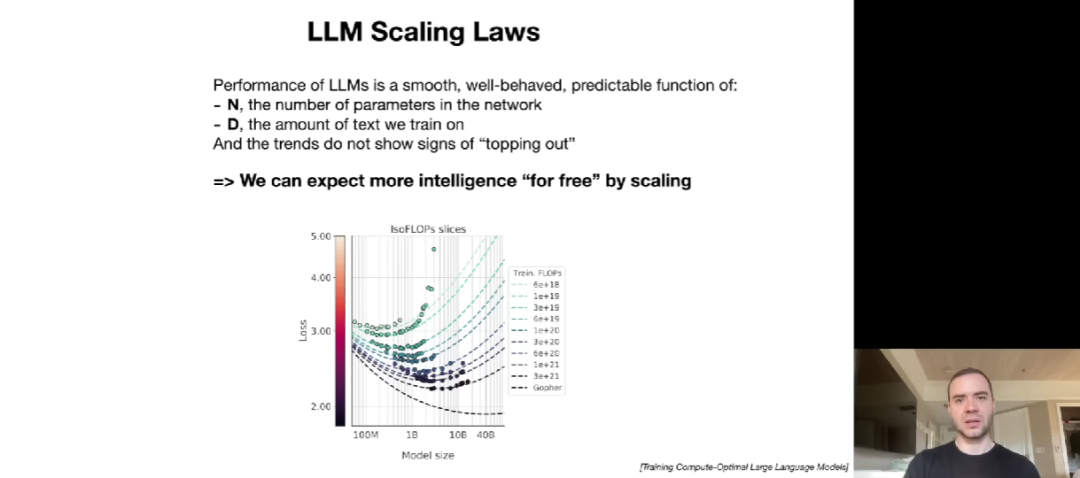

所谓 LLM 缩放法则,即 LLM 的性能可以表示为非常平滑、表现良好且可以预测的两个变量函数,分别是网络中的参数量(N)和要训练的文本量(D)。我们可以根据这两个变量通过缩放来预测下一个单词预测任务中的准确率。

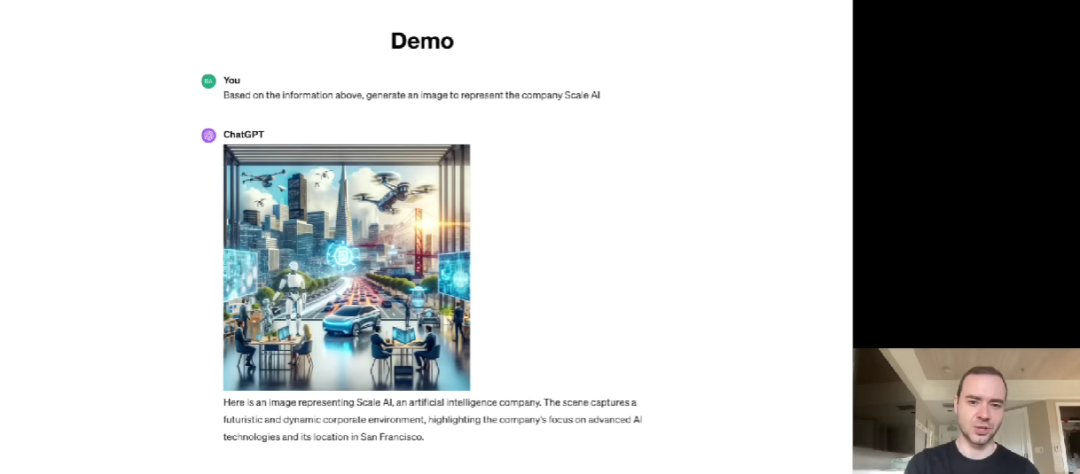

至于工具使用,Karpathy 提到了浏览器、计算器、解释器和 DALL-E。这里着重讲一下 DALL-E,它是 OpenAI 开发的文生图工具。目前,最新版本 DALL-E 3 已经集成到了 ChatGPT 中,可以输入自然语言描述来生成图像。

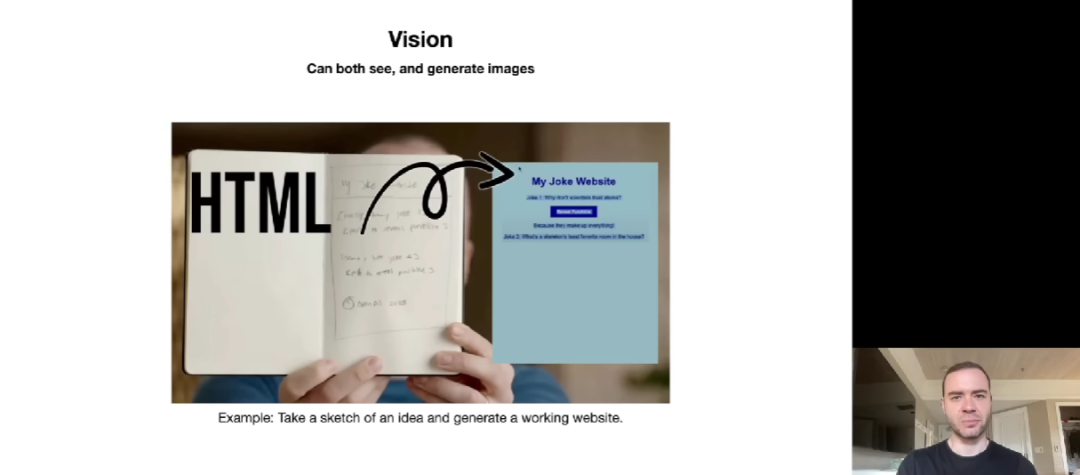

多模态也是近来领域关注的重点,比如视觉、音频等。在视觉领域,大模型不仅可以生成图像,还可以看到(See)图像。Karpathy 提到了 OpenAI 联合创始人 Greg Brockman 的一个演示,后者向 ChatGPT 展示了一张 MyJoke 网站的手写小图。结果 ChatGPT 看明白了这张图,并创建一个 MyJoke 网站。我们可以访问这个网站,还可以看到笑话。

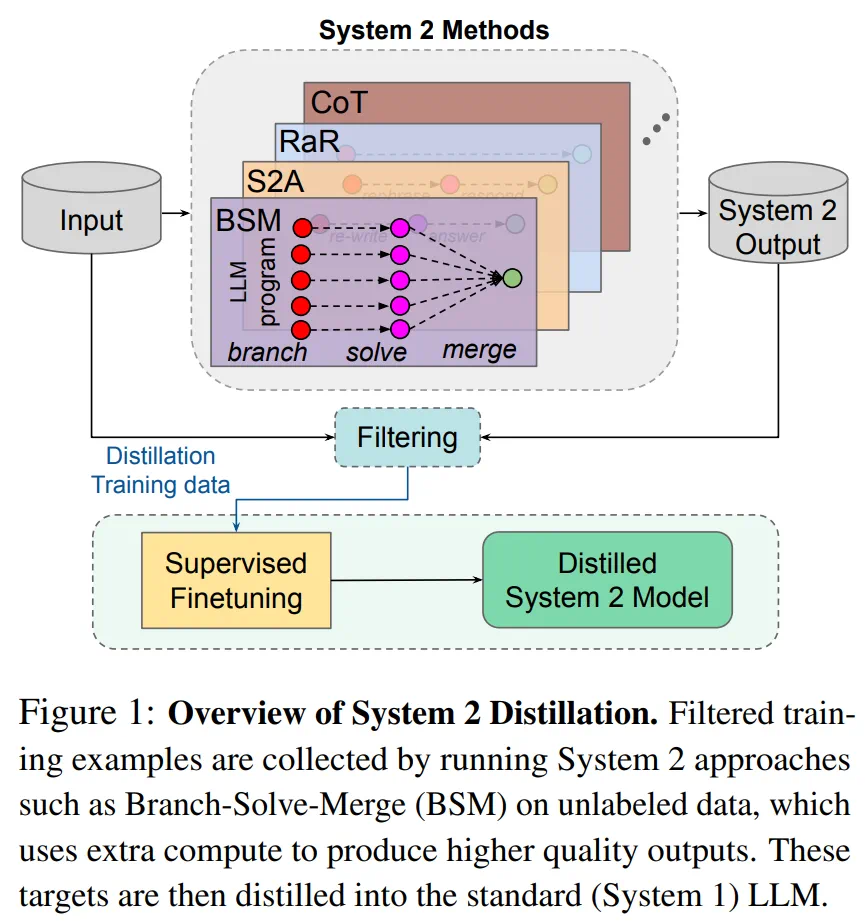

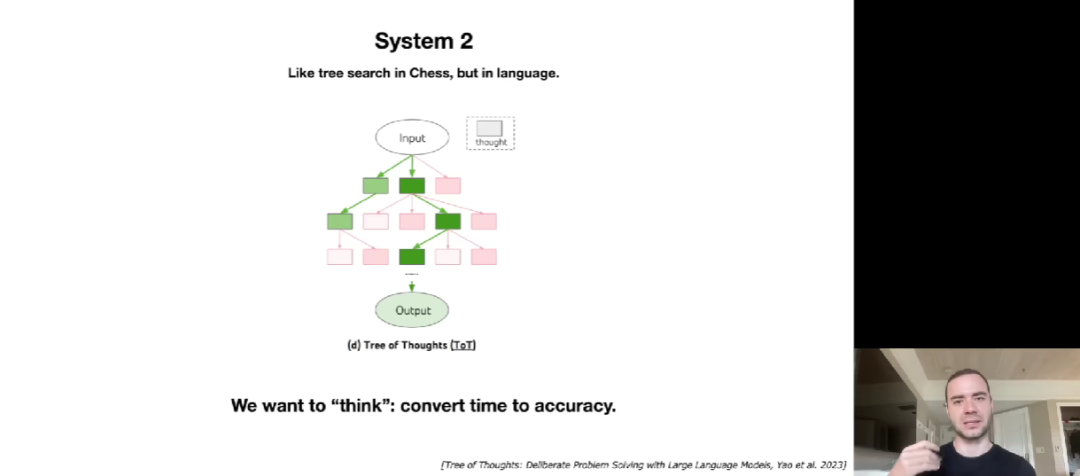

在谈到 LLM 的未来发展时,Karpathy 提到了 System 1 和 System 2 的思维模式。System 1 是快速、本能和自动的思维过程,System 2 则是有意识、有思考的思维过程。现在,人们希望为 LLM 引入更多类似 Sytem 2 的思维能力。此外 LLM 的自我改进也是需要关注的重点问题之一。

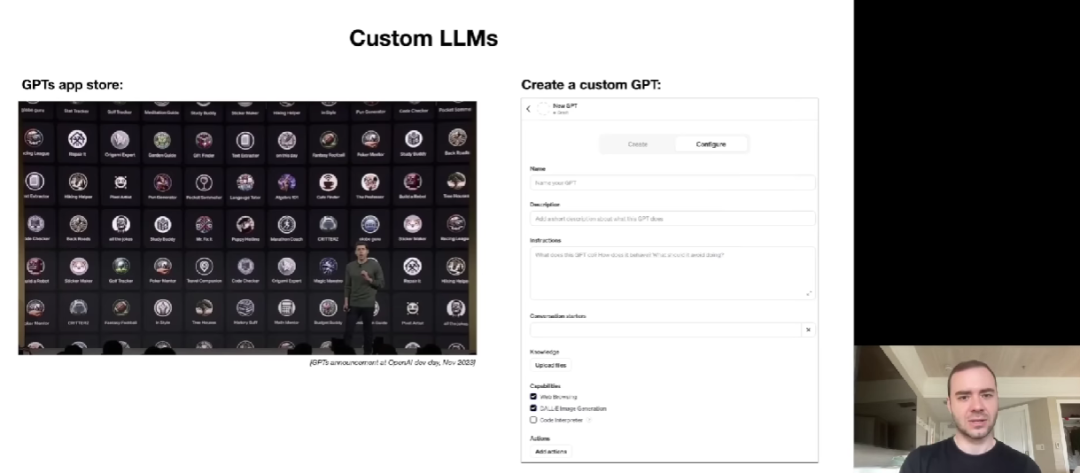

LLMs 的定制化更是近来的热点。OpenAI CEO Sam Altman 在开发者日上宣布推出的 GPTs 商店走出了模型定制化的第一步。用户可以创建自己的 GPT,根据需求进行定制,或者添加更多知识。未来对 LLM 进行微调和定制的可能性越来越大。

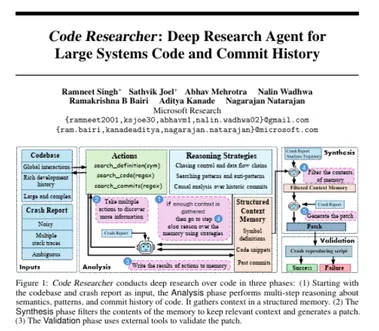

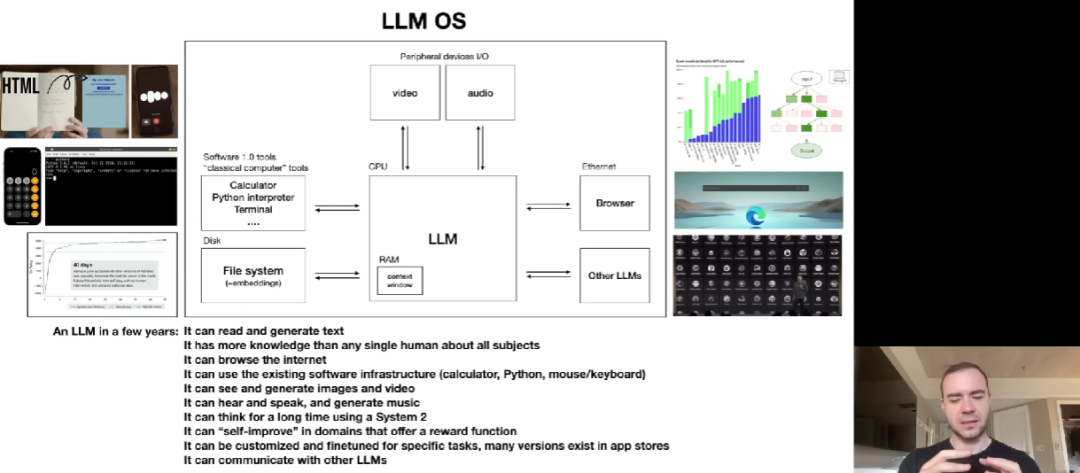

至于 LLM 操作系统,与当前的传统操作系统有很多相似之处。在未来几年,LLM 可以阅读和生成文本,拥有比任何个人都丰富的知识,浏览互联网,使用现有软件基础架构,具备查看和生成图像、视频的能力,听到、发出并创作音乐,利用 System 2 进行深入思考,能够自我改进,针对特有任务微调和定制,等等。

第三部分是 LLM 安全性。Karpathy 讲了越狱(Jailbreak)、提示注入(Prompt injection)、数据投毒或后门攻击(Data poisoning or Backdoor atteck)等三种攻击方式。