如果说过去几年 OpenAI 是靠 GPT 模型打天下,那么现在,它的野心已经远远不止做一家模型公司。

《金融时报》最新消息,OpenAI 正在和博通合作,自研一颗代号 “XPU” 的 AI 推理芯片,预计会在 2026 年量产,由台积电代工。不同于英伟达 的 GPU,这款芯片不会对外销售,而是专门满足 OpenAI 内部的训练与推理需求,用来支撑即将上线的 GPT-5 等更庞大的模型。

为什么要自己造?原因其实很直接。

首先,Nvidia 芯片不仅贵,而且还不好抢,OpenAI 每次训练新模型都要消耗成千上万张 GPU。自研芯片可以降低成本、提升效率,更关键的是,它能把命脉握在自己手里。

当然,这一举动也被外界解读为 OpenAI 从买算力走向造算力的关键一步。

据报道,博通 CEO Hock Tan 在财报中提及,公司新增一笔规模高达 100 亿美元的定制芯片订单,并将在 2026 年进入“强劲发货期”。

虽然未点名客户,但业内普遍将矛头指向 OpenAI,此举将不仅让 OpenAI 成为继谷歌 TPU、亚马逊 Trainium、Meta Artemis 之后,又一家押注自研 AI 芯片的大厂,也让博通的 AI 定制芯片业务再添一名重量级客户。

OpenAI 在多线出击

这并不是 OpenAI 最近唯一的大动作,它的野心远不止在芯片上落子。今年以来 OpenAI 在硬件、应用和算力基建三条战线上几乎是在同时提速。

先说硬件。 今年 5 月,OpenAI 花了 65 亿美元收购了由苹果前设计大师 Jony Ive 创办的 AI 硬件公司 io。值得一提的是,这个硬件公司的团队成员正是当年设计 iPhone 的那群人,履历相当豪华,现在他们加入 OpenAI,意味着公司不再满足于软件服务,而是真的要把 AI 做成人人手里的消费级设备。

再看应用。 就在前几天,OpenAI 又出手收购了一家做产品测试和实验平台的公司 Statsig,交易金额在 11 亿美元左右,是 OpenAI 迄今最大规模的收购之一。而 Statsig 的强项是做 A/B 测试和功能实验,能帮助工程团队快速迭代产品。

收购之后,创始人 Vijaye Raji 直接加入 OpenAI,当上了“应用 CTO”,负责 ChatGPT、Codex 等核心产品的工程和架构。与此同时,OpenAI 的管理层也在调整:前 Instacart CEO Fidji Simo 负责应用业务,Kevin Weil 转去研究,Srinivas Narayanan 接管 B2B 应用。

从这里能看出,OpenAI 正在刻意把研究和应用两条线拆开,并且分别配上重量级操盘手。这种组织架构,已经更接近一家成熟大厂,而不只是单纯的研究机构了。

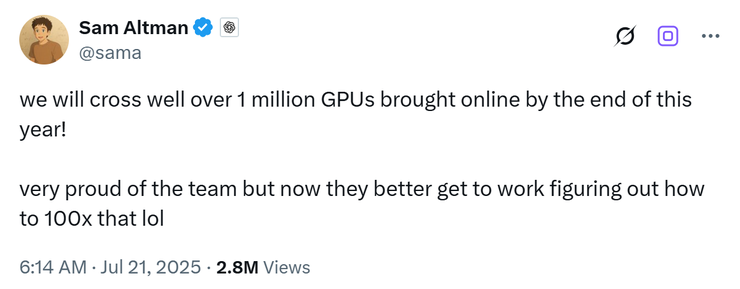

在算力基建上,OpenAI 也在加码。它正在推进代号 “Stargate” 的超级数据中心项目,投入规模据说可能高达数百亿美元。奥特曼甚至放话,到 2025 年底,OpenAI 拥有的 GPU 数量将突破 100 万台。

与此同时,OpenAI 还在分散风险,一边租 Google 的 TPU,一边和 AMD 合作,避免完全受制于英伟达。

一条最难走的路

放在行业背景里看,这一步也让 OpenAI 成为继谷歌、亚马逊、Meta 之后,又一家把自研芯片提上日程的 AI 巨头。谷歌有 TPU,亚马逊有 Trainium,Meta 有 Artemis,如今 OpenAI 补上了 XPU。

目前外界披露的情况是:OpenAI 研发的芯片是专门面向推理场景的,由前谷歌 TPU 工程师 Richard Ho 带领大约 40 人的团队负责,博通提供关键设计与 IP,台积电则计划用 3nm 工艺代工。

从 AI infra 的角度去看,OpenAI 确实迈出了非常勇敢的一步。

毕竟过去的几年中,行业的优化几乎都围绕着如何让 GPU 的利用率更高,如何让每一张卡都物尽其用的节奏去走。而这次 OpenAI 选择先做推理芯片,其实也是这个逻辑。

而且推理芯片的设计门槛相对低一些,它可以在现有的 GPU 体系之外起到补位的作用。换句话说,XPU 不是要立刻取代英伟达芯片,而是要先把推理这一环牢牢掌握在自己手里。

这也足以说明 OpenAI 的野心:它已经不满足于依赖现成 GPU,而是开始尝试从底层重塑算力体系。

但问题是,这条路的好处和弊端都同样明显。

自研的好处十分直观。首先,它可以完全针对大模型的计算模式进行定制,不必像英伟达 GPU 那样兼顾各种任务。这样一来,推理效率更高、能耗更低,还能在内存带宽和互联架构等瓶颈上做专门优化。

其次,成本压力也是核心驱动力。英伟达 GPU 的价格居高不下,大模型的训练和推理往往要消耗成千上万张卡。如果自研芯片能带来哪怕 20% 的能效提升,长期节省下来的电费和算力时间,就足以抵消掉巨额的研发投入。

更重要的是,自研还能摆脱对单一供应商的依赖,把模型、软件和硬件深度绑定,形成更坚固的护城河。

但问题同样很现实。首先是资金和周期,先进制程芯片的设计与流片成本动辄数亿美元,整个周期至少要三到五年。而在这段时间里,英伟达的 GPU 还在不断迭代,等 XPU 真正上线时能否保持竞争力,还是个未知数。

其次是人才瓶颈,能设计超大规模 AI 加速器的架构师凤毛麟角,团队搭建本身就是一道难关。软件生态问题更为棘手,英伟达最大的优势不是硬件,而是 CUDA 生态,已经成为行业事实标准。

这也意味着,OpenAI 不仅要造出芯片,还要重新搭建编译器、驱动、工具链,并说服自家工程师愿意迁移,这一点比造出硬件本身还要更难。

属于 OpenAI 的下一个十年

越激进,风险越大,故事也越精彩。

芯片研发的失败率从来不低,消费级 AI 设备的市场需求依旧模糊,超级数据中心的投入更是前所未有。OpenAI 所走的,可能是整条产业链中最昂贵、最复杂、也最容易摔跤的一条路。

正因如此,它的故事才更值得关注。OpenAI 今天的选择,不只是为了应对 GPT-5 的算力问题,而是在为未来十年乃至二十年的竞争埋下伏笔。它想要的是,在下一个时代里,像苹果之于智能手机、微软之于 PC 操作系统一样,占据一个不可撼动的核心位置。

所以,当我们谈论 OpenAI 的下一个十年,真正的问题不再是“它还能不能造出更强的 GPT”,而是 它能不能用芯片、硬件、算力和应用,一起构筑出属于 AI 时代的基础设施。