如何让一个并不巨大的开源大模型,在面对需要多步检索与复杂逻辑整合的问题时,依然像 “冷静的研究员” 那样先拆解、再查证、后归纳,最后给出可核实的结论?

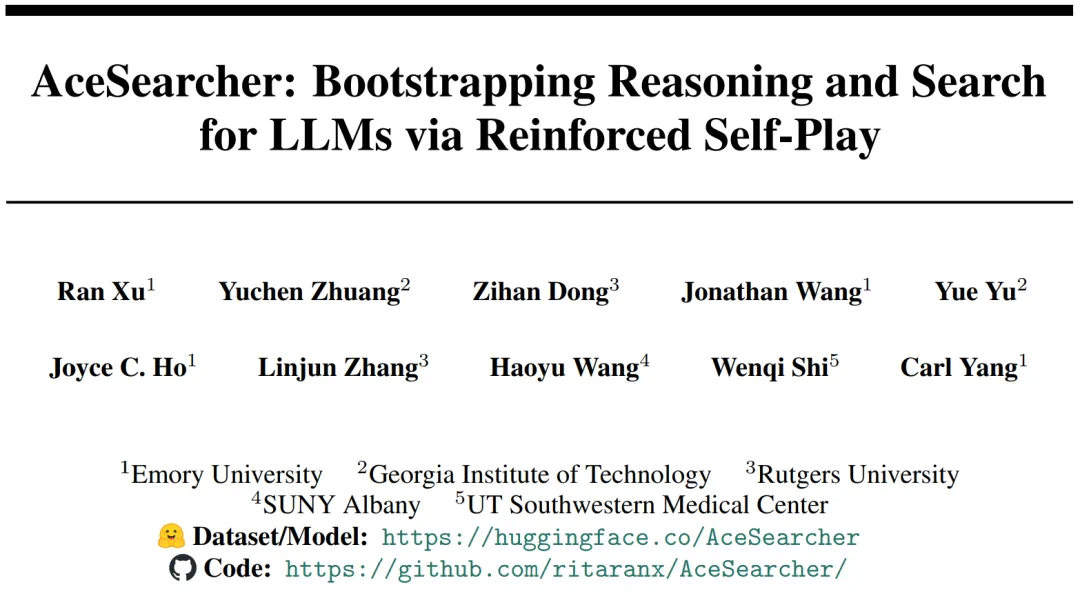

近期,来自埃默里大学,佐治亚理工大学,罗格斯大学,纽约州立大学奥尔巴尼分校,得克萨斯大学西南医学中心的研究团队发布 AceSearcher 模型,一个让同一语言模型在推理时兼任 “问题分解者(Decomposer)” 与 “答案求解者(Solver)” 的合作式自博弈框架:它以两阶段训练(SFT→RFT)为骨架,把 “会拆题、会找料、会整合” 的完整能力链拧成了一根绳。更重要的是,这不是单纯的 “又一个新模型”,而是一个更优的框架:它把公开的推理数据集引入到检索增强的训练流程中,让模型真正学会如何把推理与检索结合起来,显著提升了复杂检索任务的效果。

在三大类推理密集任务、十个数据集上,它拿到了平均 EM +7.6% 的优势;32B 版本在文档级金融推理上,表现可对标 685B 的 DeepSeek-V3,但参数量却不到 5%。

论文题目:AceSearcher: Bootstrapping Reasoning and Search for LLMs via Reinforced Self-Play

接收会议:NeurIPS 2025 Spotlight

论文地址:https://arxiv.org/pdf/2509.24193

模型 / 数据集地址:https://huggingface.co/AceSearcher

代码地址:https://github.com/ritaranx/AceSearcher/

把人类的 “拆解 — 检索 — 整合” 过程,规约成一个统一策略

现实世界的问题,常常不是 “一问一答” 能解决:线索散落在不同文档,需要多跳检索把证据拼齐,还要在此基础上进行跨段落乃至跨文档的整合推理。传统 RAG 在这里容易 “卡壳”—— 单步检索召回不足、推理链整合不稳、推理时扩展又容易带来延迟和资源开销。

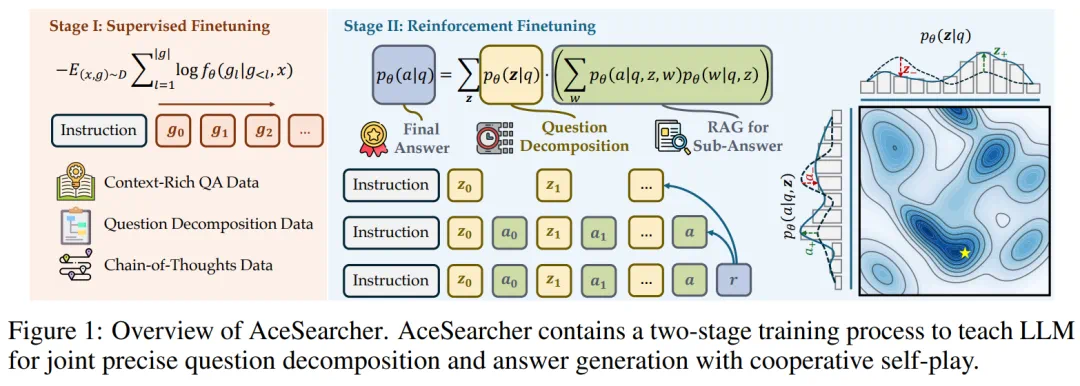

AceSearcher 的关键,是把这一流程变成一个单模型、双角色的闭环:

分解者

:把原始问题

:把原始问题  拆成子问题序列

拆成子问题序列  ,以子问题为查询锚点,逐跳拉起相关证据;

,以子问题为查询锚点,逐跳拉起相关证据;求解者

:在每一跳证据

:在每一跳证据 上产出中间答案

上产出中间答案 ,最终基于

,最终基于 汇总出答案

汇总出答案 。

。

直观来说:分解更好 → 检索更准 → 整合更稳 → 答案更对。AceSearcher 就是沿着这条因果链,推动  与

与  在一个模型体内彼此成就。

在一个模型体内彼此成就。

AceSearcher 到底 “练” 了什么?

一、Stage I:监督微调(SFT)——“打底三件套”:会搜、会拆、会想

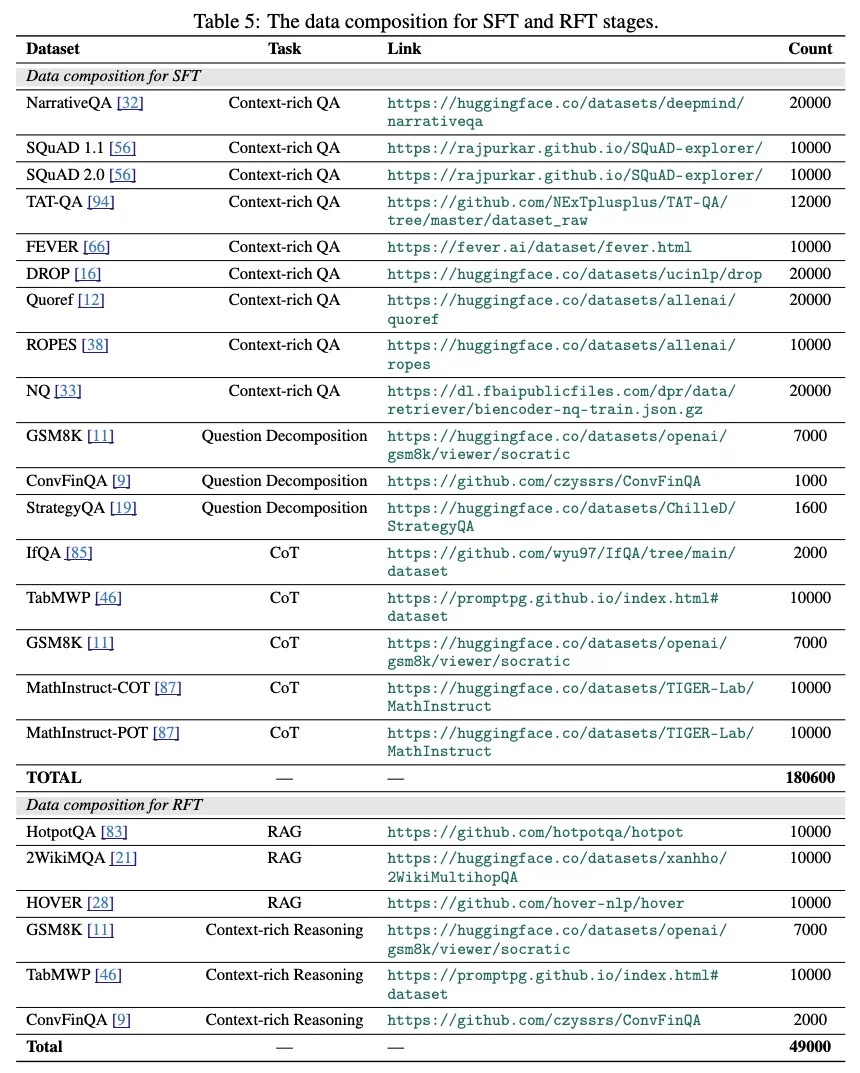

SFT 阶段的训练集是一个覆盖面很广的混合拼盘(约 18 万样本),包括:

1. 上下文丰富的 QA(NQ、SQuAD、DROP、NarrativeQA、Quoref、ROPES、FEVER、TAT-QA),让模型学会在证据上作答;

2. 问题分解数据(GSM8K、ConvFinQA、StrategyQA),让模型学会把复杂问题拆成子目标;

3. 链式推理数据(GSM8K、TabMWP、IfQA、MathInstruct 等 CoT/PoT),让模型形成多步推理的 “肌肉记忆”。

这一步的关键是:AceSearcher 首次系统地把这些公开的推理数据集,与检索增强任务结合起来。我们希望模型不仅学会了 “如何在上下文中找答案”,更学会了 “如何通过推理去驱动检索、再通过检索去支撑推理”。这是它与以往 RAG 方法最大的差别之一。

二、Stage II:偏好强化微调(RFT)—— 只看 “最终答案”,也能学会 “更好的过程”

现实里很难拿到 “中间推理步骤” 的标注。AceSearcher 的 RFT 阶段因此选择只用最终答案来给奖励:

在 RAG 环境(HotpotQA、2WikiMHQA、HOVER 等)下,

先采样 m 条分解路径,每条分解上

先采样 m 条分解路径,每条分解上  再采样

再采样  条完整解答轨迹;

条完整解答轨迹;在上下文推理环境(GSM8K、TabMWP、ConvFinQA 等)下,

仍负责拆题,

仍负责拆题, 在表格 / 文本等上下文上生成中间答案与最终解;

在表格 / 文本等上下文上生成中间答案与最终解;奖励基于 EM(Exact Match) 与格式校验,对整条轨迹

评分;

评分;把 “最好 vs 最差” 的分解、子问答、最终回答构造成偏好对,合并成

,用 DPO(Direct Preference Optimization) 类目标训练;并采用在线多轮迭代(第 t 轮用当前策略采样偏好,再更新到 t+1 轮)。

,用 DPO(Direct Preference Optimization) 类目标训练;并采用在线多轮迭代(第 t 轮用当前策略采样偏好,再更新到 t+1 轮)。

实现上还有两个细节很 “工程”:

控制长度与成本:中间子问题阶段只产出短答案,仅在最终回答处生成较完整的推理;

检索预算分配:总检索配额 N=15,如果分解出 n 个子问题,则每个子问题最多分到

个文档,以免某一步 “吃太多”。

个文档,以免某一步 “吃太多”。

在这里,利用推理数据集预训练出来的 “分解与推理能力”,在 RFT 阶段通过最终答案奖励被进一步固化和迁移到复杂检索任务,形成了推理与检索的真正耦合。

评测设置:任务谱系、检索器与指标

论文的评测覆盖三个任务大类,共十个公开数据集:

多跳问答:2WikiMHQA、HotpotQA、Bamboogle、MusiQue;

多跳事实验证:HOVER、ExFEVER;

文档级金融 / 数学推理:我们使用 DocMath-Eval 基准,包含 TAT-QA、FinQA、MultiHiertt、TAT-HQA 等任务。

实验结果分析:既要 “能搜会拆”,也要 “合并同类项”

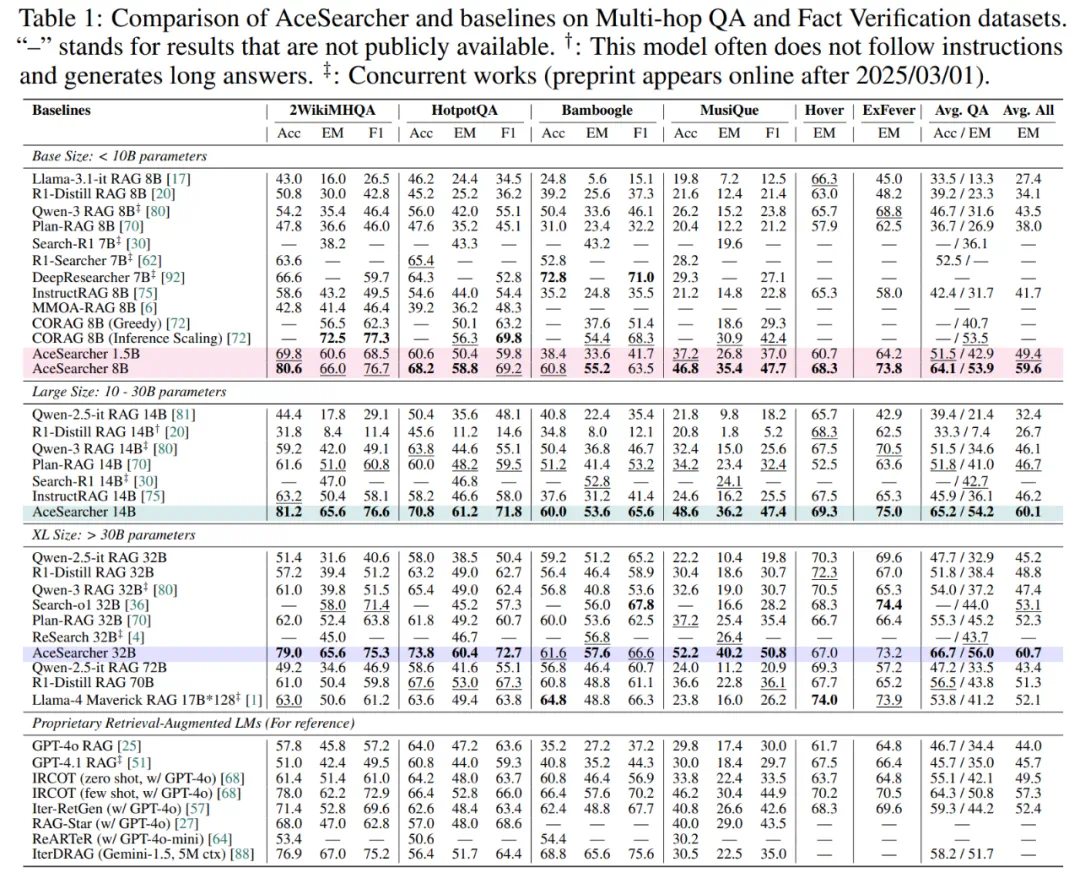

1)多跳 QA / 事实验证:平均提升 7.6%,小中模型亦能 “越级”

在六个数据集的综合评测中(2WikiMHQA、HotpotQA、Bamboogle、MusiQue、HOVER、ExFEVER),AceSearcher 全面优于近期开源 / 闭源基线;其中 32B 版本的综合得分达到 60.7,相对多种强基线的平均 EM 最高可增 7.6%。更具代表性的是 “参数效率”:1.5B 版本已可对标 / 超越 8B 级基线,8B 版本还压过 70B 级模型。

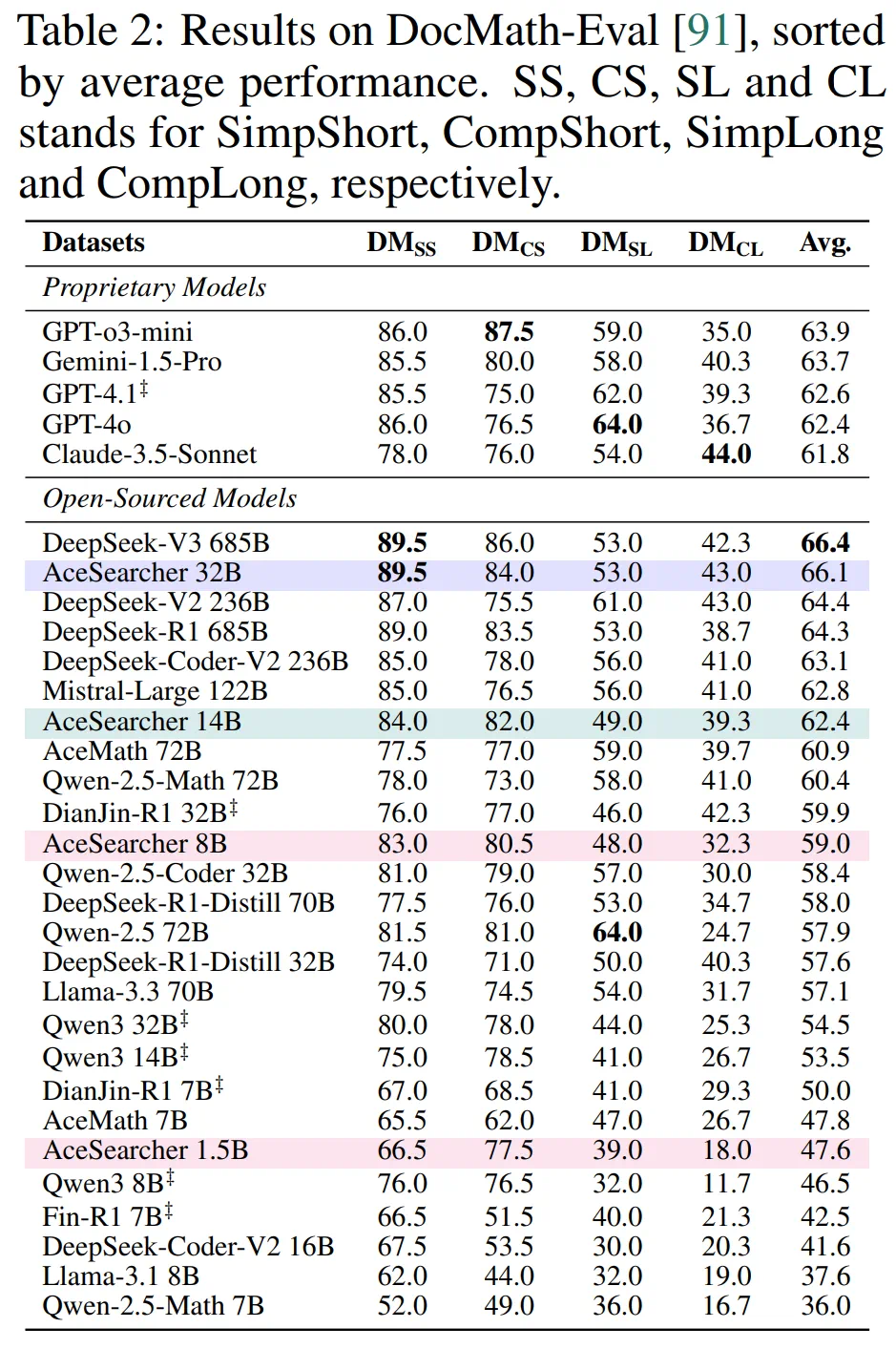

2)文档级推理:32B ≈ DeepSeek-V3@685B(≈1/20 参数)

在 DocMath-Eval 上,AceSearcher-32B 的平均准确率与 DeepSeek-V3(685B) 几乎持平;14B 版本还超过了若干 72B 级模型;8B 相对同量级 / 略大模型亦有明显优势。这表明 “分解→检索→整合” 的统一范式,能在长文档与表格混合的复杂情境里保持稳健的泛化。

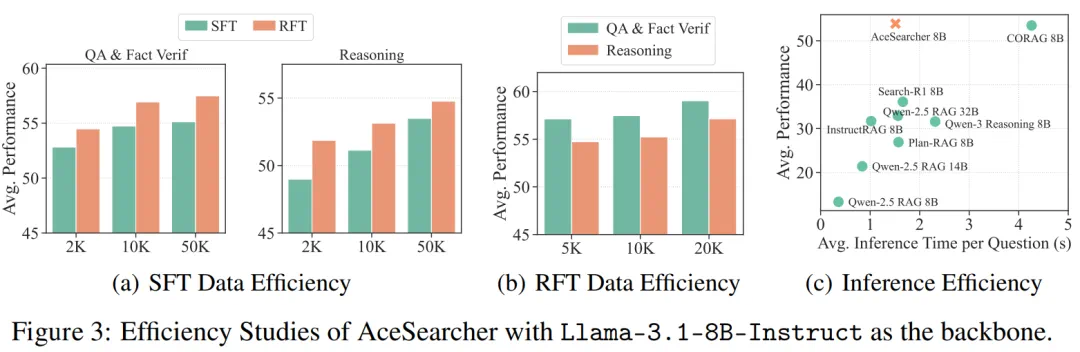

3)效率与可扩展性:少量数据就能 “拉满”,推理 - 时间性价比更优

数据效率:SFT 只取 2K 样本时,性能已可追平如 Search-R1 等强基线;RFT 追加 5K 提示后进一步拉升。

推理效率:虽然比分步 RAG 多了 “分解 + 多跳” 的环节,但相对树搜索 / 思维链扩展等方法,AceSearcher 在相近推理时间下拿到更高分。

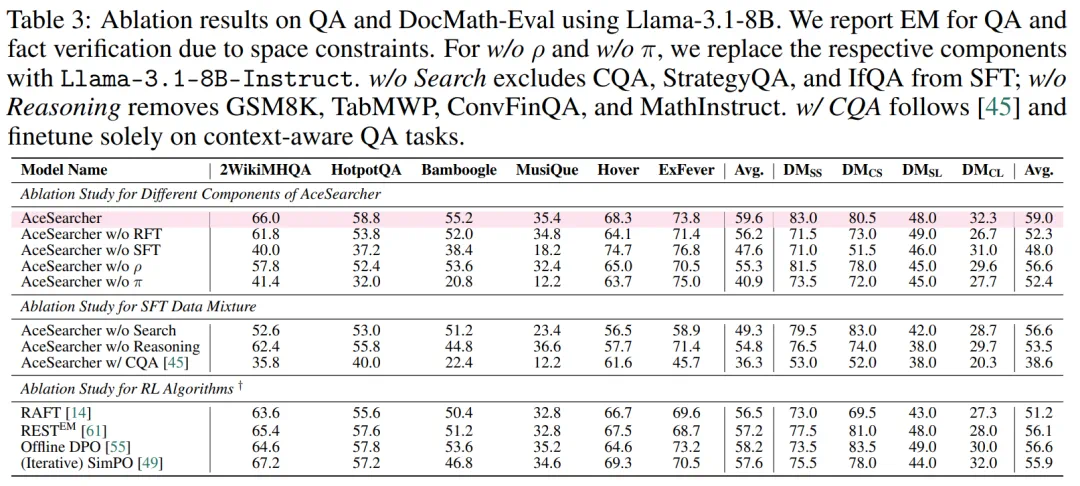

消融:为什么一定要 “分解 + 求解” 都练?

系统消融清晰地回答了这个问题:

缺哪样都不行:去掉 RFT 或 SFT,成绩明显下滑;把

替换成 “冻结” 的通用指令模型,也会失分;

替换成 “冻结” 的通用指令模型,也会失分;只练上下文 QA 远远不够:不加入 “分解 / 推理” 类数据,泛化与鲁棒性都不如 “全配方”;

RL 替代方案不如在线迭代 DPO 稳定:RAFT、REST-EM、离线 DPO、迭代 SimPO 都做了横比,AceSearcher 综合更优。

这背后,其实是  与

与  的正反馈回路:好分解让好检索与好整合更容易发生,而持续的最终答案奖励又把这条路走得更稳。这再次印证:AceSearcher 的贡献不仅是性能超越,更是框架的超越。它证明了推理与检索不该被割裂开来,而应在一个统一框架中通过数据与优化手段协同提升。

的正反馈回路:好分解让好检索与好整合更容易发生,而持续的最终答案奖励又把这条路走得更稳。这再次印证:AceSearcher 的贡献不仅是性能超越,更是框架的超越。它证明了推理与检索不该被割裂开来,而应在一个统一框架中通过数据与优化手段协同提升。

未来:从 “固定检索器” 到 “联合优化”,再到更广的任务谱系

AceSearcher 证明了:聪明的训练范式胜过盲目扩参。接下来有三条有潜力的路:

1. 检索 - 推理联合优化:目前检索器固定,未来可尝试把检索表征、重排与生成策略联学,进一步提高 “证据命中→推理稳定” 的闭环质量;

2. 极端时延场景的工程优化:在保持性能的前提下做缓存、动态步长与早停机制;

3. 更广任务类型:从多跳问答 / 事实验证 / 长文档,扩展到对话式信息采集、实时工具使用、跨模态检索等。